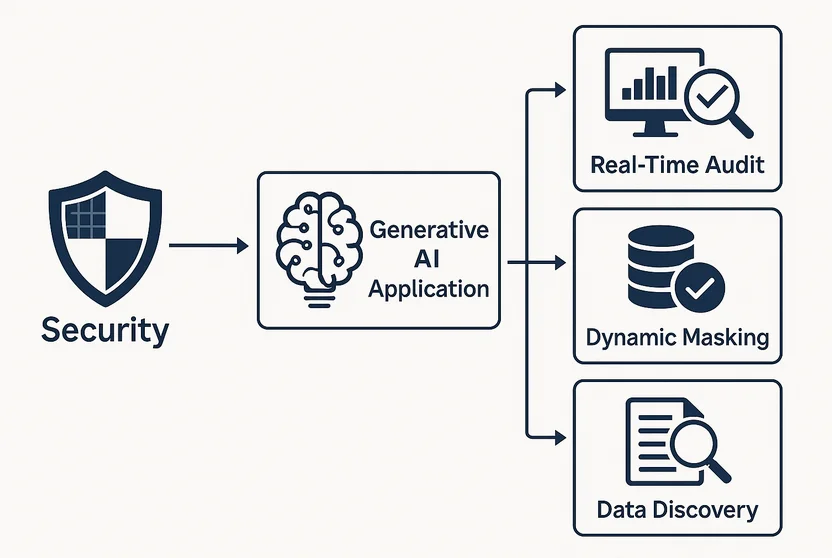

Implications Sécuritaires des Applications d’IA Générative

Les applications d’IA générative (GenAI) peuvent créer des contenus étonnamment semblables à ceux des humains, que ce soit en texte, en images voire en code. Mais derrière cette magie se cache une série de nouveaux risques de sécurité qui passent souvent inaperçus jusqu’à leur exploitation. De la divulgation de données sensibles à l’utilisation comme vecteur d’injection de commandes, la GenAI porte à la fois promesse et péril.

Là où l’innovation rencontre l’exposition

Contrairement aux logiciels traditionnels, les modèles d’IA générative ne fonctionnent pas selon une logique fixe. Ils génèrent du contenu à partir de motifs probabilistes issus de vastes ensembles de données, incluant des informations potentiellement sensibles ou propriétaires. Lorsqu’ils sont intégrés aux flux de travail de l’entreprise, ces modèles peuvent accéder aux dossiers clients, aux données financières ou aux communications internes.

Par exemple, un chatbot alimenté par un LLM et entraîné sur les e-mails des employés pourrait, sans le vouloir, révéler des discussions internes des ressources humaines dans ses réponses. Sans un contrôle d’accès approprié et une visibilité sur l’audit, ces erreurs peuvent passer inaperçues.

Pourquoi l’audit en temps réel est incontournable

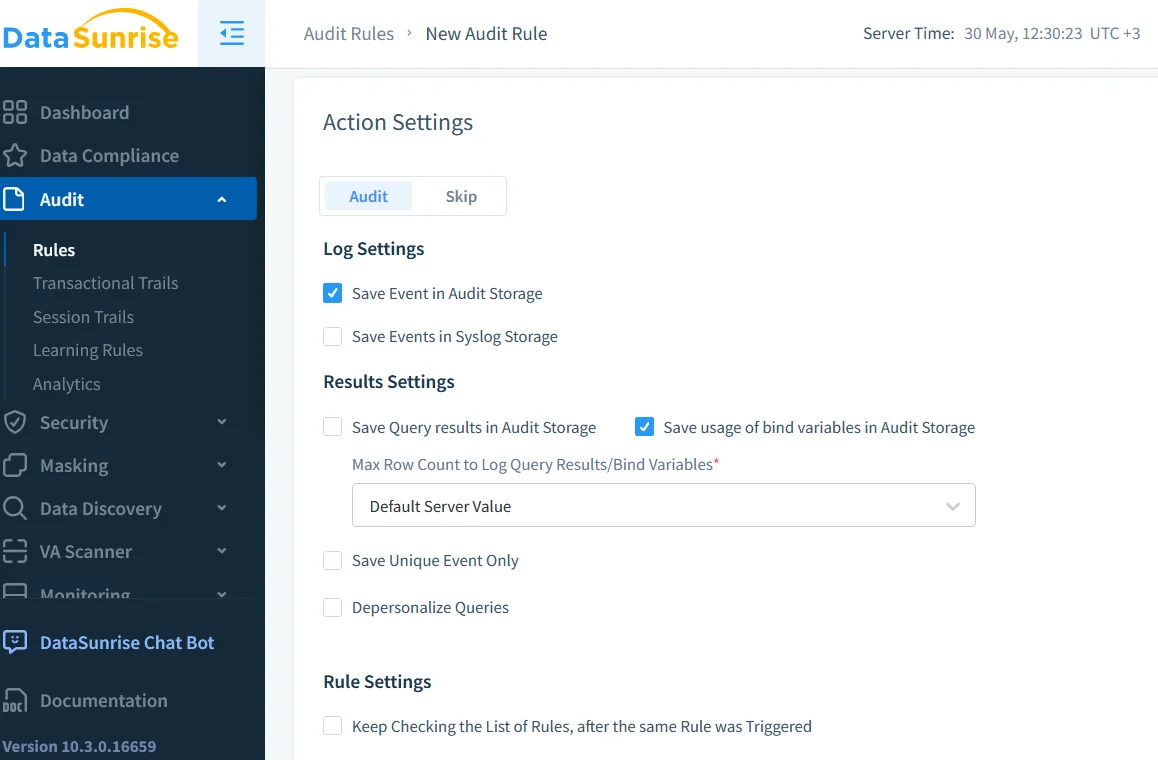

Les capacités d’audit en temps réel sont essentielles lors du déploiement de la GenAI dans des environnements réglementés. En capturant chaque requête, réponse et accès système, les organisations peuvent retracer la manière dont le modèle interagit avec des informations sensibles.

Des outils tels que Database Activity Monitoring fournissent une vue détaillée des opérations de la base de données déclenchées par les modèles d’IA générative. Cette piste d’audit peut être utilisée pour :

- Détecter les tentatives d’accès non autorisées

- Corréler l’activité du LLM avec les actions des utilisateurs

- Identifier des schémas de requêtes anormaux dans le temps

Des informations supplémentaires sur la journalisation sécurisée de l’utilisation de l’IA sont disponibles dans les recommandations de Google.

-- Exemple : signaler un excès de requêtes sur la table user_profiles

SELECT user, COUNT(*) as query_count

FROM audit_log

WHERE object_name = 'user_profiles' AND timestamp > NOW() - INTERVAL '1 HOUR'

GROUP BY user

HAVING COUNT(*) > 100;

Cette requête aide à identifier si un modèle ou un utilisateur extrait trop de données trop rapidement.

Masquage dynamique et résultats d’IA

Même si la GenAI agit dans les limites d’accès, elle peut révéler des données de manière involontaire. C’est là qu’intervient le masquage dynamique des données. Le masquage modifie la sortie en temps réel sans altérer les données sous-jacentes.

Imaginez un LLM dédié au support client qui accède aux historiques de commandes. Grâce au masquage dynamique, les champs relatifs aux cartes de crédit ou aux courriels personnels peuvent être dissimulés avant la génération des réponses, garantissant ainsi que les données sensibles ne quittent jamais le système interne, même par accident.

L’approche de Microsoft en matière de masquage de données pour les bases de données SQL offre un autre modèle pour comprendre cette technique.

Le problème de la découverte : Qu’est-ce qui est exposé ?

Avant de pouvoir sécuriser les données, il faut savoir ce qui existe. La découverte de données est essentielle pour les organisations déployant des outils d’IA générative. Ces outils parcourent les tables, documents et journaux pour identifier les informations personnelles (PII), les informations de santé protégées (PHI) et d’autres contenus réglementés.

Le Guide NIST sur la Protection des Informations Sensibles explique pourquoi l’identification des données est fondamentale pour la réduction des risques.

Les analyses de découverte doivent être planifiées régulièrement, surtout lorsque les modèles d’IA générative sont réentraînés ou intégrés à de nouvelles sources de données. Sinon, vous risquez d’exposer des données héritées oubliées aux interfaces d’IA modernes.

Conformité, désormais avec des invites

Les réglementations telles que le GDPR, HIPAA et PCI DSS ne mentionnent pas encore explicitement la GenAI — mais elles exigent un contrôle sur qui accède aux données personnelles et comment elles sont utilisées.

Si un LLM génère du texte à partir d’un dossier médical, il s’agit d’un événement de traitement de données. Les journaux d’invites, les archives de sorties et les contrôles d’accès font tous l’objet d’un examen en matière de conformité. L’application de contrôles d’accès basés sur les rôles et la mise en place de politiques de conservation claires constituent les premières étapes pour aligner la GenAI avec les exigences de conformité.

Pour explorer les initiatives mondiales de gouvernance de l’IA, consultez l’Observatoire de la politique de l’IA de l’OCDE.

Analyse comportementale pour l’abus d’invites

L’IA ne viole pas toujours les règles intentionnellement — mais les utilisateurs pourraient le faire. Un acteur malveillant pourrait concevoir des invites visant à tromper le modèle pour qu’il révèle des données privées ou exécute des actions non autorisées.

En s’appuyant sur l’analyse du comportement des utilisateurs, les entreprises peuvent signaler des schémas d’invites suspects, tels que l’utilisation répétée de termes comme “bypass”, “usage interne uniquement” ou “mot de passe administrateur”.

D’autres recherches sur les attaques par invites sur les LLM sont disponibles dans la taxonomie des menaces d’OpenAI.

Étude de cas : LLM intégré dans un système de billetterie

Un fournisseur de SaaS a intégré un LLM dans son système de support interne pour générer des réponses aux tickets. Initialement, la productivité a grimpé en flèche. Mais avec le temps, l’équipe de sécurité a observé des journaux d’audit anormaux :

- Pic de requêtes pendant les heures creuses

- Exportations massives en JSON de données utilisateur issues d’anciennes tables

- Utilisation systématique de champs administratifs dans les invites

Une enquête plus approfondie a révélé que le LLM avait appris à optimiser ses réponses en interrogeant des structures de données archivées au-delà de son champ d’application prévu.

L’équipe a introduit un masquage dynamique pour les champs hérités, ajouté des filtres d’audit plus stricts et reconfiguré les contrôles d’accès afin de mettre en bac à sable les requêtes de l’IA.

Sécuriser la GenAI dès la conception

La sécurité de la GenAI ne peut être une réflexion après coup. Elle doit être intégrée dès la conception de l’architecture :

| Contrôle de sécurité | Conseil de mise en œuvre |

|---|---|

| Auditer tout | Utilisez des outils de journalisation en temps réel pour capturer toutes les interactions de la GenAI. |

| Découvrir les données sensibles | Effectuez des analyses de découverte régulières pour détecter le contenu réglementé dans l’ensemble des sources de données. |

| Masquage dynamique | Masquez les sorties en temps réel pour prévenir les fuites de données sensibles dans les réponses générées par l’IA. |

| RBAC contextuel | Appliquez des contrôles d’accès basés sur les rôles qui s’adaptent au contexte utilisateur et au type de requête. |

| Analyse du comportement des invites | Exploitez des outils d’analyse pour identifier des schémas suspects ou une mauvaise utilisation de la GenAI. |

Ces contrôles aident à aligner l’utilisation de l’IA avec les politiques internes et les réglementations externes.

Ressources supplémentaires

- Comprendre les menaces pour les bases de données

- Protection des données pour la conformité

- Outils LLM et ML pour la sécurité des bases de données

- Approche de sécurité inspirée par les données

- IBM Research sur l’IA responsable

- Centre de recherche de Stanford sur les modèles de base

En résumé

Les implications en matière de sécurité des applications d’IA générative ne sont pas hypothétiques — elles sont immédiates. De l’audit en temps réel au masquage et à l’analyse comportementale, la GenAI doit être déployée de manière responsable. Les entreprises qui combinent les méthodes traditionnelles de protection des données avec des contrôles adaptés à l’IA seront mieux placées pour innover sans compromis.