Gestion des risques de l’IA dans les systèmes LLM

Alors que l’intelligence artificielle transforme les opérations des entreprises, 78% des organisations mettent en œuvre des systèmes de modèles de langage (LLM) dans des flux de travail critiques. Bien que les LLM offrent des capacités sans précédent, ils introduisent des défis sophistiqués en matière de gestion des risques que les cadres traditionnels ne peuvent pas adresser de manière adéquate.

Ce guide examine les exigences de gestion des risques de l’IA pour les systèmes LLM, en explorant des stratégies complètes permettant aux organisations de tirer parti du potentiel des LLM tout en maintenant des contrôles de risques robustes.

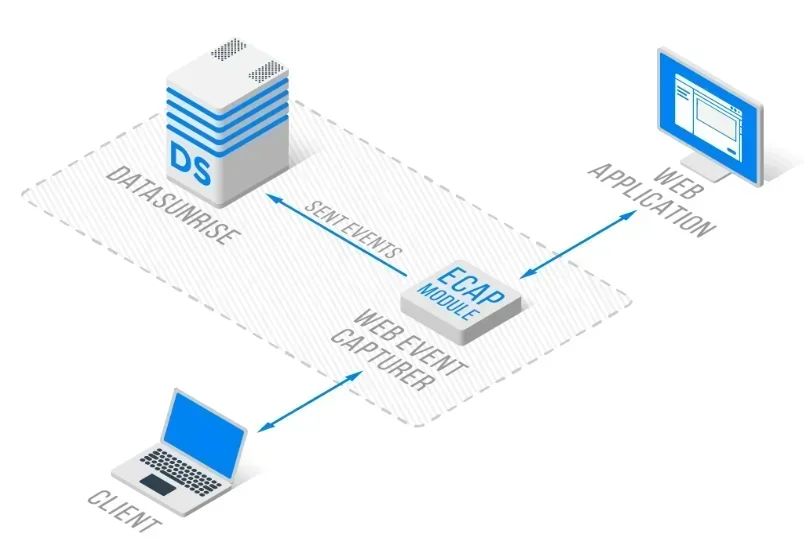

La plateforme avancée de gestion des risques de l’IA de DataSunrise offre une orchestration des risques sans intervention humaine avec une détection autonome des menaces sur toutes les principales plateformes LLM. Notre cadre centralisé de gestion des risques de l’IA intègre de manière transparente la gestion des risques avec des contrôles techniques, offrant une supervision des risques d’une précision chirurgicale pour une protection complète des LLM.

Comprendre l’environnement des risques des LLM

Les modèles de langage de grande taille fonctionnent grâce à des réseaux neuronaux complexes qui traitent d’énormes quantités de données non structurées, prennent des décisions autonomes et génèrent un contenu dynamique. Cela crée des vulnérabilités de sécurité sans précédent nécessitant des approches complètes de gestion des risques et des capacités de détection des menaces.

La gestion des risques des LLM englobe l’identification des menaces, l’évaluation des vulnérabilités et les stratégies d’atténuation sur l’ensemble du cycle de vie de l’IA. Contrairement aux systèmes traditionnels, les LLM présentent des profils de risques évolutifs nécessitant une surveillance continue et des mesures de protection des données adaptatives avec la mise en œuvre de règles de sécurité.

Catégories critiques de risques LLM

Risques liés à la sécurité des modèles

Les systèmes LLM font face à des attaques sophistiquées, notamment des invites adverses conçues pour manipuler le comportement du modèle, l’empoisonnement des données d’entraînement qui influence les sorties, et des tentatives d’extraction du modèle visant à voler la propriété intellectuelle à l’aide de techniques de contournement du pare-feu de base de données et d’injections SQL.

Risques relatifs à la confidentialité des données et à la conformité

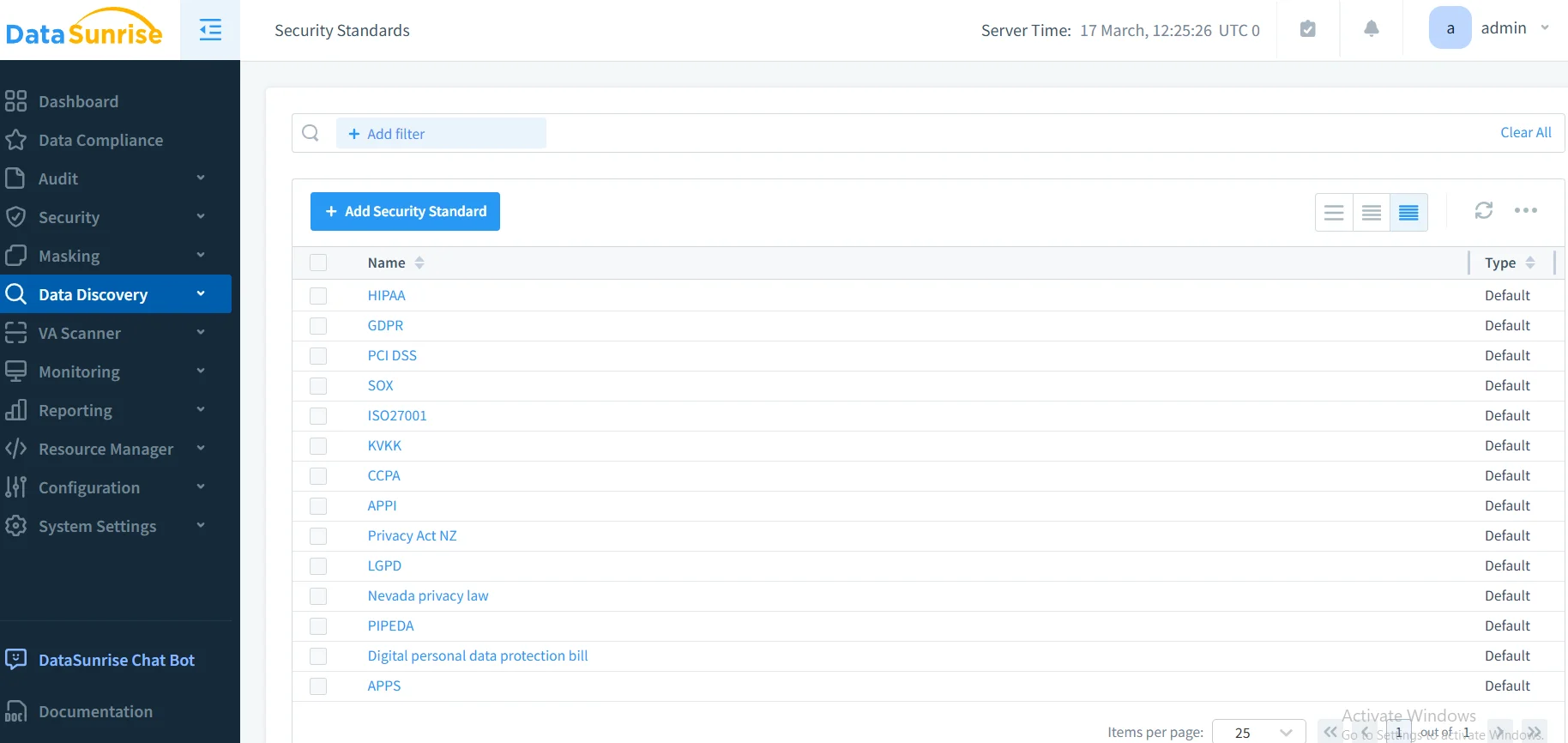

Les LLM traitant des informations sensibles créent des risques importants de violation de données par la divulgation involontaire d’informations personnelles identifiables (PII), des fuites d’informations entre conversations, ainsi qu’une non-conformité réglementaire aux cadres tels que le GDPR, le HIPAA et le PCI DSS, nécessitant le respect des réglementations en matière de conformité.

Risques opérationnels et éthiques

Le déploiement des LLM engendre des défis opérationnels, y compris la dérive du modèle affectant les performances, des problèmes d’évolutivité et des préoccupations éthiques liés à des résultats biaisés, nécessitant l’analyse comportementale pour leur détection et leur atténuation.

Mise en œuvre de l’évaluation des risques

Une gestion efficace des risques des LLM requiert des approches systématiques d’évaluation :

import re

from datetime import datetime

class LLMRiskAssessment:

def assess_interaction(self, prompt: str, response: str):

"""Évaluation des risques pour les interactions LLM"""

pii_risk = self._detect_pii(prompt + response)

injection_risk = self._detect_injection(prompt)

overall_risk = max(pii_risk, injection_risk)

return {

'risk_level': 'HIGH' if overall_risk > 0.7 else 'MEDIUM' if overall_risk > 0.4 else 'LOW',

'mitigation_required': overall_risk > 0.6

}

def _detect_pii(self, text: str) -> float:

"""Détecter les modèles de PII"""

patterns = [r'\b[\w._%+-]+@[\w.-]+\.[A-Z|a-z]{2,}\b', r'\b\d{3}-\d{2}-\d{4}\b']

detected = sum(1 for p in patterns if re.search(p, text))

return min(detected / len(patterns), 1.0)

Bonnes pratiques de mise en œuvre

Pour les organisations :

- Établir une gouvernance des risques : Créer des comités de risques en IA avec une responsabilité claire et des politiques de sécurité des données ainsi que des règles d’apprentissage et des procédures d’audit

- Déployer une surveillance continue : Mettre en place une surveillance en temps réel de l’activité de la base de données pour toutes les interactions LLM

- Maintenir une documentation des risques : Documenter les risques, les stratégies d’atténuation et les pistes d’audit avec une optimisation du stockage des audits

Pour les équipes techniques :

- Sécurité à plusieurs niveaux : Mettre en œuvre des contrôles d’accès et du masquage dynamique des données

- Réponse automatisée : Configurer des notifications en temps réel et une réponse aux incidents

- Surveillance des performances : Veiller à ce que les contrôles de risques n’impactent pas les performances des LLM

DataSunrise : Solution complète de gestion des risques pour LLM

DataSunrise fournit une gestion des risques de niveau entreprise conçue spécifiquement pour les environnements LLM. Notre solution offre une orchestration autonome des risques avec une détection des menaces en temps réel sur ChatGPT, Amazon Bedrock, Azure OpenAI, Qdrant et des déploiements de LLM personnalisés.

Caractéristiques clés :

- Évaluation des risques en temps réel : Détection des menaces pilotée par ML avec une protection contextuelle

- Surveillance complète : Surveillance de l’IA sans intervention avec des journaux d’audit détaillés

- Protection avancée des données : Masquage des données d’une précision chirurgicale avec détection de PII

- Couverture multiplateforme : Gestion unifiée des risques sur plus de 50 plateformes supportées

- Intégration de la conformité : Rapports de conformité automatisés pour les principaux cadres réglementaires

Les modes de déploiement flexibles de DataSunrise supportent les environnements sur site, cloud et hybrides avec une mise en œuvre sans intervention humaine. Les organisations réalisent une réduction de 85% des incidents de sécurité en IA et améliorent leur posture de conformité grâce à l’automatisation des rapports réglementaires.

Conclusion : Gestion proactive des risques LLM

Une gestion efficace des risques en IA dans les systèmes LLM requiert des stratégies complètes abordant les dimensions techniques, opérationnelles et réglementaires. Les organisations qui mettent en œuvre des cadres de gestion des risques robustes se positionnent pour tirer parti des capacités des LLM tout en maintenant la confiance des parties prenantes et une résilience opérationnelle.

À mesure que l’adoption des LLM s’accélère, la gestion des risques passe d’une surveillance optionnelle à une capacité commerciale essentielle. En déployant des cadres éprouvés et des solutions de surveillance continue, les organisations peuvent poursuivre avec confiance les innovations LLM tout en protégeant leurs actifs.

DataSunrise : Votre partenaire en gestion des risques LLM

DataSunrise est le leader des solutions de gestion des risques LLM, offrant une protection complète de l’IA avec des analyses avancées des risques. Notre plateforme économique et évolutive sert des organisations allant des startups aux entreprises Fortune 500.

Découvrez notre orchestration de sécurité autonome et voyez comment DataSunrise offre une réduction quantifiable des risques. Planifiez votre démo pour explorer nos capacités de gestion des risques LLM.

Suivant