Confidentialité des données dans les systèmes d’IA générative

L’IA générative est passée d’une nouveauté expérimentale à une infrastructure cruciale pour l’entreprise, alimentant tout, des chatbots de service client aux chaînes de découverte de médicaments. Mais à mesure que ces systèmes ingèrent et génèrent des données de plus en plus sensibles, la confidentialité et la sécurité deviennent des préoccupations existentielles. Avec 89 % des entreprises déployant désormais des modèles de langage de grande taille (LLM) dans des environnements de production, comprendre et atténuer les risques liés à la confidentialité n’est pas facultatif : c’est fondamental pour survivre à l’ère de l’IA.

La crise de la confidentialité dans l’IA générative : quatre défis majeurs

Mémorisation involontaire de données

Les LLM ne se contentent pas de traiter les données, ils les internalisent. Des études montrent que les modèles peuvent reproduire textuellement des Informations Personnelles Identifiables (IPI) issues des ensembles d’entraînement. Un LLM dans le secteur de la santé pourrait accidentellement révéler des dossiers de patients, tandis qu’un assistant de codage pourrait exposer des algorithmes propriétaires.Attaques par injection de commande

Les attaquants manipulent les entrées pour contourner les mesures de sécurité éthiques. Ces attaques exploitent la compréhension contextuelle du modèle pour extraire des informations confidentielles, nécessitant des règles de sécurité robustes contre les techniques d’injection.Fuite de données au niveau de l’inférence

Les données sensibles fuient à travers des sorties apparemment innocentes. Même une exposition partielle de données viole des réglementations telles que PCI-DSS et GDPR.Cauchemars de conformité

L’IA générative croise plusieurs cadres réglementaires :

- Conformité au RGPD : Exige le droit à l’oubli

- Conformité à la HIPAA : Implique une protection stricte des informations de santé protégées (PHI)

- Conformité à la PCI DSS : Implique l’isolement des données de paiement

Mesures techniques de protection : Stratégies de sécurisation par le code

1. Assainissement dynamique des entrées

Masquez les données sensibles avant traitement en utilisant des techniques telles que le masquage dynamique :

import re

def sanitize_input(prompt: str) -> str:

# Masquer les emails

prompt = re.sub(r'\b[A-Za-z0-9._%+-]+@[A-Za-z0-9.-]+\.[A-Z|a-z]{2,}\b', '[EMAIL]', prompt)

# Masquer les cartes de crédit (conformité PCI DSS)

prompt = re.sub(r'\b(?:\d[ -]*?){13,16}\b', '[CARD]', prompt)

# Masquer les identifiants médicaux (conformité HIPAA)

prompt = re.sub(r'\b\d{3}-\d{2}-\d{4}\b', '[MED_ID]', prompt)

return prompt

2. Validation en temps réel des sorties

Bloquez les fuites d’IPI dans les réponses grâce à une détection continue des menaces :

PII_PATTERNS = [

r'\b\d{3}-\d{2}-\d{4}\b', # Numéro de sécurité sociale

r'\b(?:\d[ -]*?){13,16}\b', # Cartes de crédit

r'\b[A-Za-z0-9._%+-]+@[A-Za-z0-9.-]+\.[A-Z|a-z]{2,}\b' # Emails

]

def validate_output(response: str) -> bool:

for pattern in PII_PATTERNS:

if re.search(pattern, response):

block_response() # Empêcher la fuite

log_incident() # Alerte de sécurité

return False

return True

3. Pistes d’audit immuables

Suivez chaque interaction avec l’IA grâce à des pistes d’audit inviolables :

from datetime import datetime

import hashlib

def log_audit_trail(user_id, prompt, response):

timestamp = datetime.utcnow().isoformat()

audit_entry = {

"timestamp": timestamp,

"user": user_id,

"prompt_hash": hashlib.sha256(prompt.encode()).hexdigest(),

"response_hash": hashlib.sha256(response.encode()).hexdigest()

}

# Écrire dans un stockage inviolable

with SecureAuditDB() as db:

db.insert(audit_entry)

Stratégies de défense organisationnelle

| Stratégie | Mise en œuvre | Risque atténué |

|---|---|---|

| Architecture Zero-Trust | Contrôles d’accès basés sur les rôles | Accès non autorisé aux données |

| Tests adversariaux | Simulations régulières d’injection de commandes | Tentatives de contournement de la sécurité |

| Cartographie de la conformité | Aligner les flux de travail de l’IA avec les cadres réglementaires | Violations réglementaires |

| Minimisation des données | Politiques strictes de gouvernance des données | Fuite d’IPI |

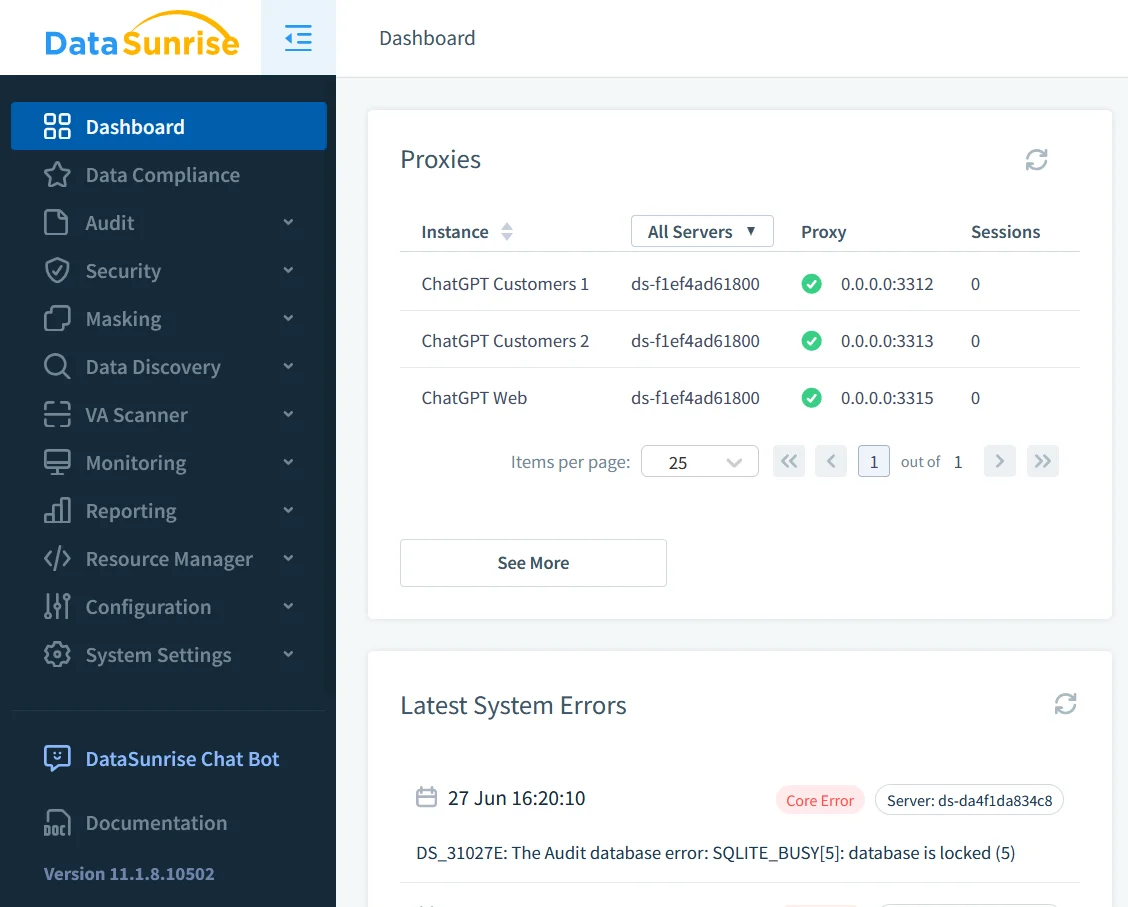

DataSunrise : la couche de sécurité unifiée pour les systèmes d’IA

DataSunrise fournit une infrastructure de sécurité critique grâce à :

Découverte de données sensibles à l’IA Data Discovery

- Analyse les bases de données et les ensembles d’entraînement à la recherche d’IPI/PHI

- Identifie plus de 50 types de données sensibles

Suite de protection dynamique

- Masquage en temps réel : Anonymise les données pendant l’inférence

- Masquage statique : Dé-identifie les ensembles d’entraînement

- Protection contre l’injection SQL : Bloque les requêtes malveillantes

Journaux d’audit unifiés Audit Logs

- Journalisation centralisée sur les modèles d’IA

- Rapports de conformité automatisés

- Alertes en temps réel

Automatisation de la conformité

- Modèles réglementaires préétablis

- Application des politiques

- Génération de documentation

Le schéma de la défense en profondeur

Sécuriser l’IA générative nécessite une protection en couches :

Pré-traitement

- Découverte et classification des données

- Assainissement des entrées

- Contrôles d’accès

Protection en temps réel

- Surveillance en temps réel de l’ activité de la base de données

- Détection des injections de commandes

- Validation des sorties

Post-traitement

- Analyse des pistes d’audit

- Vérification de la conformité

- Amélioration du modèle

Conclusion : La confidentialité comme avantage concurrentiel

Alors que l’IA générative s’intègre de plus en plus aux opérations commerciales, la protection de la vie privée se transforme d’une nécessité technique en un facteur différenciateur stratégique. Les organisations qui mettent en œuvre des cadres solides :

- Réduisent les amendes réglementaires de 83 % (Gartner 2025)

- Augmentent les scores de confiance des clients de 40 %

- Accélèrent l’adoption de l’IA en éliminant les goulets d’étranglement en matière de sécurité

Des outils tels que DataSunrise fournissent l’infrastructure critique nécessaire pour équilibrer l’innovation et la responsabilité grâce aux politiques de sécurité et aux capacités de protection des données. L’avenir appartient aux organisations qui reconnaissent : Dans l’ère de l’intelligence artificielle, la confiance est la devise ultime.

Protégez vos données avec DataSunrise

Sécurisez vos données à chaque niveau avec DataSunrise. Détectez les menaces en temps réel grâce à la surveillance des activités, au masquage des données et au pare-feu de base de données. Appliquez la conformité des données, découvrez les données sensibles et protégez les charges de travail via plus de 50 intégrations supportées pour le cloud, sur site et les systèmes de données basés sur l'IA.

Commencez à protéger vos données critiques dès aujourd’hui

Demander une démo Télécharger maintenant