Risques de sécurité dans les charges de travail d’IA générative

Les charges de travail d’IA générative (GenAI) ont redéfini la manière dont les entreprises interagissent avec les données. De la création de contenu à la prise de décision automatisée, ces modèles génèrent une valeur considérable, mais introduisent également des risques de sécurité uniques. Avec l’adoption croissante de l’IA générative dans divers secteurs, il devient essentiel de comprendre comment sécuriser ces charges de travail. Pour un aperçu des menaces émergentes liées à l’IA générative, reportez-vous au cadre de sécurité de l’IA générative de MITRE.

Pourquoi les charges de travail d’IA générative sont intrinsèquement à haut risque

Contrairement aux modèles d’IA traditionnels qui fonctionnent sur des entrées statiques, les modèles d’IA générative interagissent avec des données dynamiques, souvent sensibles. Ces modèles peuvent mémoriser les données d’entraînement, répondre à des invites en langage naturel et générer des résultats synthétiques qui pourraient involontairement exposer des informations réglementées ou propriétaires.

Les risques inhérents comprennent :

| Catégorie de risque | Description |

|---|---|

| Fuite de données sensibles | Les modèles d’IA générative peuvent mémoriser et reproduire des données d’entraînement confidentielles. |

| Exposition de données personnelles | Les informations personnelles identifiables pourraient apparaître dans les résultats des modèles. |

| Injection de commandes | Des utilisateurs malveillants pourraient formuler des invites pour contourner les consignes de sécurité du modèle. |

| Exploitation par le biais des sorties du modèle | Les attaquants peuvent tromper le modèle pour qu’il révèle des données internes ou protégées. |

Ces vecteurs exigent des mesures de protection avancées dépassant la simple protection API. La complexité augmente encore lorsque les grands modèles de langage (LLM) sont déployés sur des interfaces destinées aux clients ou reliés à des systèmes internes avec un accès aux données en temps réel.

Audit en temps réel des interactions avec le modèle

Pour détecter les usages abusifs ou les anomalies dans les interactions avec l’IA générative, un audit en temps réel est crucial. Les méthodes de journalisation traditionnelles peuvent enregistrer le « quoi », mais les systèmes d’audit en temps réel capturent le « pourquoi » et le « comment » de la requête. Consultez également les conseils de Google Cloud sur la sécurisation des charges de travail en IA grâce à la journalisation d’audit.

Exemple : Supposons qu’un utilisateur soumette une invite telle que :

SELECT user_id, endpoint, timestamp

FROM api_logs

WHERE endpoint LIKE '%admin%' AND response_code = 200;

Dans un assistant alimenté par l’IA générative lié à votre base de données, cela pourrait dévoiler des comportements opérationnels à moins qu’une journalisation et des alertes basées sur des règles ne soient en place.

Des plateformes telles que les journaux d’audit de DataSunrise offrent des notifications en temps réel et des informations détaillées sur le comportement des utilisateurs, permettant aux équipes de sécurité de retracer les schémas d’accès et de détecter des anomalies avant que des dommages ne soient causés.

Masquage dynamique : des garde-fous pour les interactions en direct

Le masquage dynamique est essentiel lorsque les outils d’IA générative produisent des réponses basées sur des données en direct. En interceptant les requêtes et les réponses, vous pouvez masquer ou obfusquer les champs sensibles avant qu’ils n’atteignent le modèle ou l’utilisateur final.

-- Valeur originale : 1234-5678-9012-3456

-- Sortie masquée : XXXX-XXXX-XXXX-3456

Cela répond non seulement aux exigences de confidentialité, mais empêche également l’IA d’« apprendre » des schémas liés à des identités sensibles.

En savoir plus sur le masquage dynamique des données et son rôle dans la protection des données pour les charges de travail d’IA générative.

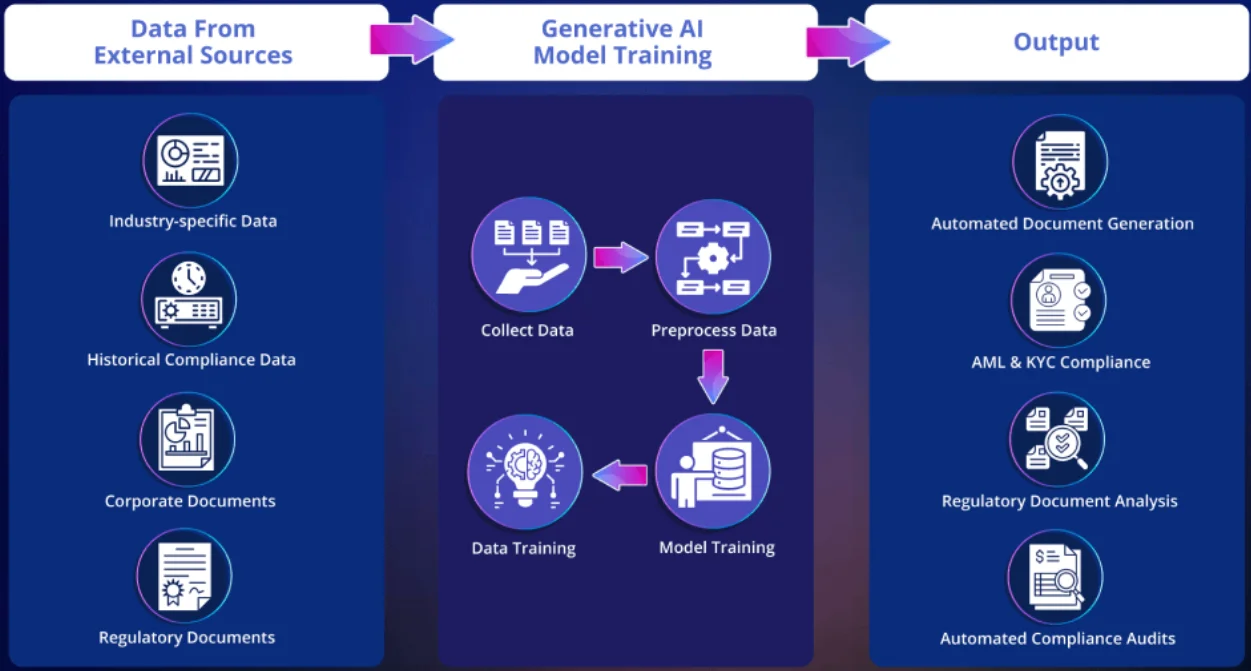

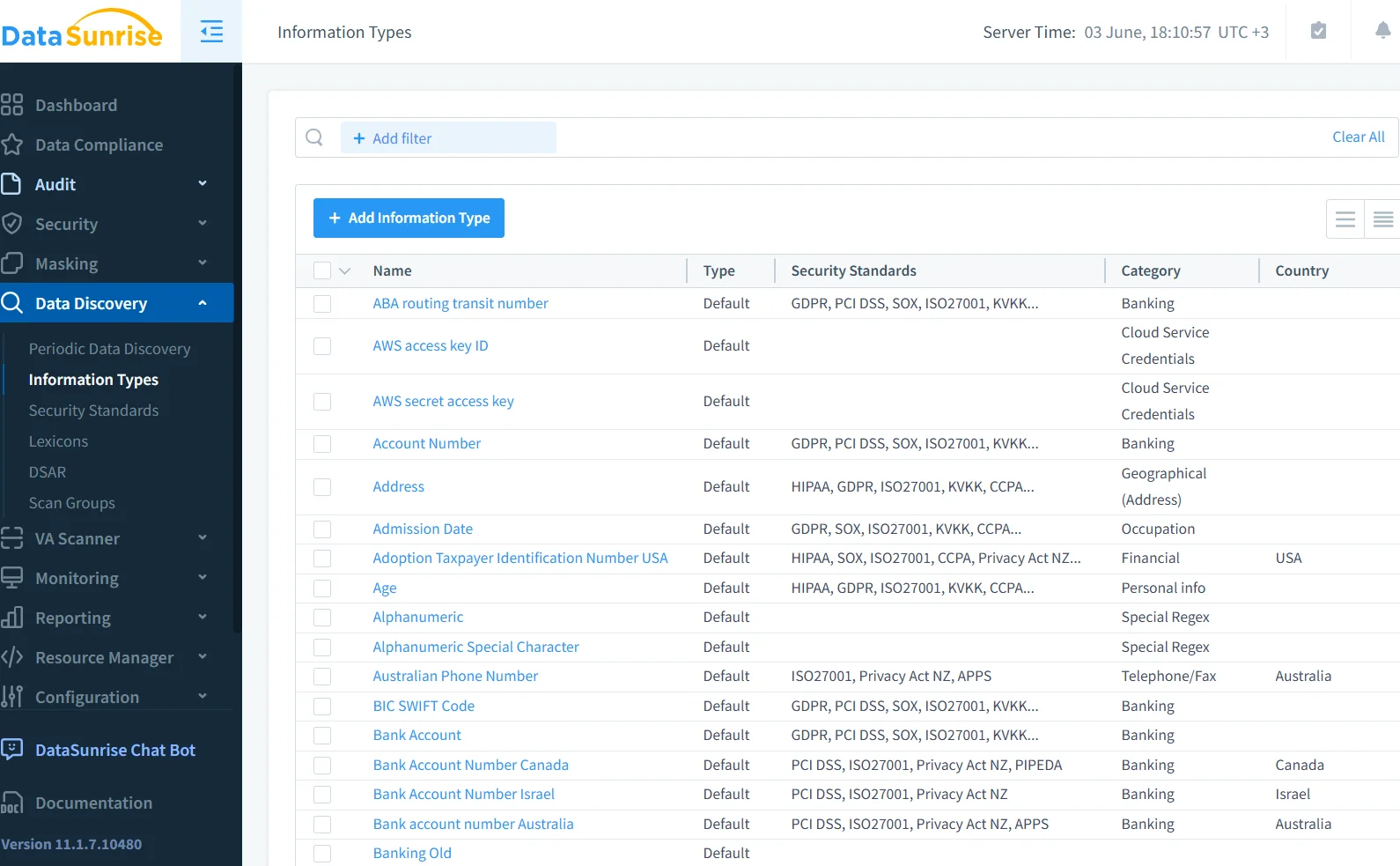

Découverte des données avant le déploiement

Les modèles d’IA générative sont souvent entraînés sur de grands ensembles de données fédérées. Sans connaître leur contenu, vous naviguez à l’aveugle. Grâce à des outils de découverte de données, les équipes de sécurité peuvent scanner les bases de données, les lacs de données et les systèmes de fichiers pour classifier les données réglementées avant qu’elles ne soient exposées aux LLM. Cela est crucial lors de la formation de modèles d’IA générative personnalisés sur des documents d’entreprise ou des historiques clients. Pour plus de contexte, IBM propose un guide sur la classification automatisée et la découverte de données pour l’IA.

-- Règle d'exemple dans le moteur de découverte

IF column_name LIKE '%ssn%' OR column_name LIKE '%dob%' THEN classify AS 'PII'

Ces métadonnées permettent un masquage basé sur des politiques et des alertes en temps réel lorsque les interactions avec l’IA générative accèdent à des types de données signalés.

Conformité et gouvernance : là où l’IA rencontre la réglementation

La sécurité pour l’IA générative ne se limite pas à prévenir les exploits techniques, il s’agit également de maintenir la conformité avec des cadres tels que le RGPD, HIPAA et PCI DSS. Ces cadres exigent :

- Minimisation des données

- Journalisation des accès

- Consentement de l’utilisateur pour le traitement

Le non-implémentation de contrôles peut entraîner une exposition juridique, surtout lorsque les résultats générés par l’IA reproduisent des données protégées.

Le contrôle d’accès basé sur les rôles (RBAC) et les pistes d’audit aident à documenter les efforts de conformité et à démontrer l’intention en cas d’enquête.

Injection de code et piratage d’invites

L’injection d’invites est un vecteur de menace en plein essor dans les systèmes d’IA générative. Les attaquants peuvent intégrer des instructions malveillantes dans des invites apparemment anodines, amenant le modèle à divulguer des données sensibles ou à contourner les sécurités par défaut. La fondation OWASP a publié une liste des 10 principaux risques pour les applications basées sur les LLM, incluant les vecteurs d’injection d’invites.

L’association de règles d’audit avec des pipelines de nettoyage des invites est un moyen efficace de réduire ces attaques.

Un exemple pratique : utilisation de l’audit SQL et du masquage dans des systèmes propulsés par des LLM

Si cela passe par un module de génération SQL, le backend pourrait générer une requête telle que :

-- Audit des soldes en retard

SELECT customer_name, balance_due FROM billing WHERE status = 'overdue';

Sans masquage, les champs financiers pourraient être affichés en clair. Grâce aux politiques de masquage, les montants sensibles sont partiellement expurgés.

Pour retracer qui a accédé à quoi et quand, la surveillance de l’activité de la base de données enregistre l’interaction, la liant à une session utilisateur ou à une clé API.

Intégrer la sécurité dès le début : sécuriser l’IA générative par conception

De nombreuses vulnérabilités de sécurité dans les charges de travail d’IA générative surgissent parce que les équipes se concentrent sur la performance du modèle, et non sur la conception du système. L’intégration précoce de la sécurité — appliquer des contrôles dès le début du cycle de vie — peut aider à intégrer la gouvernance dans chaque composant :

- Ingestion de données : scanner et étiqueter les entrées sensibles

- Ajustement du modèle : limiter l’exposition à des corpus sensibles

- Pile de déploiement : appliquer le masquage en ligne et des contrôles d’accès

- Couche de sortie : nettoyer et auditer les réponses du modèle

Cette approche s’aligne sur les pratiques modernes de DevSecOps et la sécurité inspirée des données, renforçant à la fois la transparence et la protection.

Conclusion : un nouveau paradigme de sécurité pour l’IA

L’essor de l’IA générative introduit une toute nouvelle catégorie de risques que les modèles de sécurité traditionnels ne sont pas conçus pour gérer. Mais en combinant audit en temps réel, masquage dynamique, découverte de données et gouvernance pilotée par des politiques, il est possible de construire des systèmes d’IA générative sécurisés et conformes sans sacrifier l’innovation. Découvrez comment le NIST aborde la gestion des risques liés à l’IA dans leur AI RMF 1.0.

Pour approfondir la manière dont des outils comme DataSunrise peuvent aider dans cette transformation, consultez leurs guides sur l’audit, le masquage des données et les capacités du pare-feu de base de données.