Sécurité vs Sûreté des LLM

Les grands modèles de langage (LLM) sont en train de transformer le développement logiciel, l’éducation et l’analyse. Pourtant, la précipitation à les déployer a déclenché un débat croissant : sécurité des LLM vs sûreté — et laquelle des deux est la plus importante.

Ces deux concepts se chevauchent souvent, mais représentent des défis très différents dans le déploiement responsable de l’IA.

Sécurité vs Sûreté des LLM : Comprendre la Différence

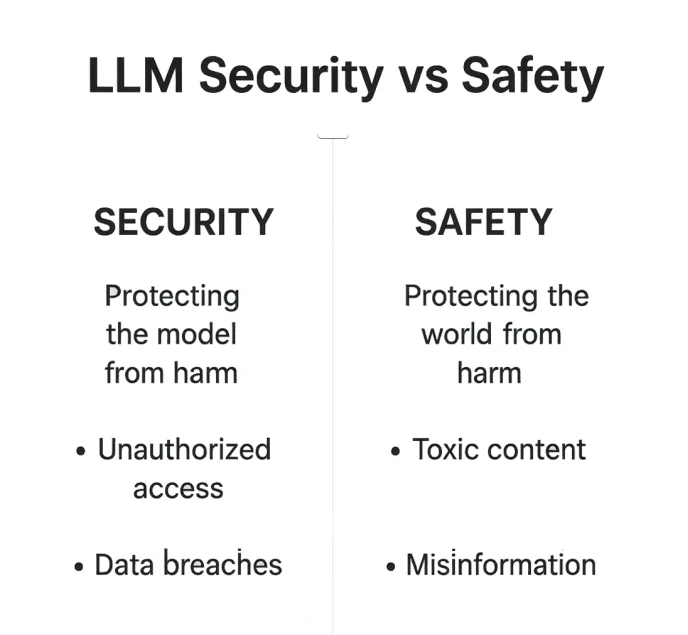

Quand on parle de sécuriser les grands modèles de langage, les termes sécurité et sûreté sont souvent utilisés indifféremment — mais ils opèrent sur des niveaux très différents de l’écosystème de l’IA.

La sécurité des LLM consiste à renforcer l’environnement du modèle : protéger les bases de données, les points d’accès et les API contre les exploitations malveillantes. Pendant ce temps, la sûreté des LLM se concentre sur ce que dit le modèle — s’assurer que ses réponses restent éthiques, factuelles et dans des limites acceptables.

La sécurité est une lutte contre la manipulation externe. La sûreté est une protection contre la désalignement interne. En pratique, les deux se recoupent. Un modèle compromis peut produire des résultats dangereux, et un modèle dangereux peut devenir un risque de sécurité par ingénierie sociale ou fuite de données. Comprendre les nuances entre ces deux dimensions est essentiel pour construire des systèmes d’IA fiables et résilients.

| Aspect | Sécurité des LLM | Sûreté des LLM |

|---|---|---|

| Focalisation | Protéger l’infrastructure, les données et les modèles contre les accès non autorisés | Prévenir les sorties nuisibles, biaisées ou contraires à l’éthique |

| Menaces | Attaques par injection, accès non autorisés, fuites de données | Contenu toxique, désinformation, violations éthiques |

| Objectif | Maintenir le modèle et les données sécurisés | Maintenir les sorties sûres et alignées |

| Exemple | Prévention des injections SQL | Filtrage du contenu par RLHF |

Les deux forment ensemble la pierre angulaire d’un déploiement responsable de l’IA — où la protection technique assure la confiance, et l’alignement éthique garantit la responsabilité.

1. Ce que signifie la Sécurité pour les LLM

La sécurité des LLM se concentre sur la protection de l’infrastructure, des modèles et des pipelines de données contre tout accès ou manipulation non autorisés.

C’est le bouclier technique qui protège les données confidentielles, la propriété intellectuelle et l’intégrité du système — la barrière silencieuse entre un fonctionnement sûr et une catastrophe des données.

Risques courants de sécurité

Les attaquants sondent constamment les systèmes LLM à la recherche de points faibles : injection d’instructions cachées, exploitation de prompts non filtrés, ou collecte de jetons depuis des journaux non sécurisés.

Même le modèle le plus avancé peut être compromis s’il repose sur un pipeline de récupération non protégé ou expose des embeddings confidentiels.

Les points faibles typiques comprennent :

- Accès non autorisé aux données via injection de prompt ou API mal configurées

- Exposition de champs sensibles ou de jetons dans les journaux

- Absence de chiffrement dans les pipelines de récupération ou d’affinage

Ces menaces transforment des modèles intelligents en vecteurs de responsabilités — à moins que de solides couches de défense ne soient mises en place.

Mesures d’atténuation

La sécurité des LLM n’est pas un simple mur — c’est un système de défenses en couches :

- Pare-feu de base de données pour la protection périmétrique

- Protection des données et chiffrement pour les données stockées et transmises

- Surveillance de l’activité de la base de données pour identifier les comportements anormaux avant leur propagation

2. Ce que signifie la Sûreté pour les LLM

La sûreté traite de la manière dont un LLM se comporte — ses limites éthiques, sa fiabilité factuelle et sa capacité à éviter de causer des dommages.

Si la sécurité est le coffre-fort entourant le modèle, la sûreté est la conscience qui y réside.

La sûreté concerne moins la lutte contre les hackers et davantage la prévention des dommages sociaux, réputationnels ou moraux pouvant résulter de sorties non contrôlées.

Un modèle non sûr peut diffuser de la désinformation aussi facilement qu’un modèle compromis peut divulguer des identifiants.

Risques de sûreté

Les modèles mal réglés peuvent produire :

- Contenu toxique, biaisé ou offensant

- Informations hallucinées ou trompeuses

- Contournement des filtres de modération via jailbreaks de prompt

Chacune de ces défaillances mine la confiance des utilisateurs — et dans les secteurs réglementés, peut entraîner de graves conséquences en matière de conformité.

Mesures de sûreté

Les développeurs contrent ces risques en combinant stratégies d’entraînement et contrôles de données :

- Apprentissage par renforcement à partir de retours humains (RLHF)

- Découverte de données et détection des informations personnelles identifiables (PII) pour identifier les informations sensibles

- Masquage statique des données avant l’entraînement pour éviter l’exposition

# Exemple simple de garde-fou pour les sorties

def safe_response(output: str) -> str:

banned = ["password", "SSN", "card number"]

return "[REDACTED]" if any(b in output.lower() for b in banned) else output

3. Où la Sécurité et la Sûreté des LLM se Recoupent

La frontière s’estompe à l’interface du modèle — où prompts, récupération et génération se rencontrent.

C’est la zone grise où un système sécurisé peut néanmoins produire des sorties non sûres, et un modèle « sûr » peut involontairement exposer des données internes.

Un système peut être sécurisé mais non sûr (fuit des données privées pourtant stockées de manière responsable) ou sûr mais non sécurisé (censuré mais facilement piratable). Les cadres les plus robustes abordent les deux aspects simultanément.

Contrôles communs

Dans cette zone de convergence, certains mécanismes protègent à la fois l’infrastructure et la qualité des sorties :

- Contrôle d’accès basé sur les rôles (RBAC)

- Détection d’injection SQL

- Gestion des prompts sous garde-fou et filtres de modération de contenu

| Zone de recoupement | Contrôle d’exemple | But |

|---|---|---|

| Validation des entrées | Assainissement des prompts | Empêcher l’injection ou la fuite d’informations sensibles |

| Contrôle d’accès | RBAC / reverse proxy | Restreindre les outils et plugins du modèle |

| Revue des sorties | Filtre post-génération | Supprimer les données non éthiques ou privées |

Le chevauchement entre sûreté et sécurité n’est pas théorique — il est opérationnel. Les environnements LLM les plus résilients combinent gestion des accès, analyse des prompts et modération éthique dans un processus continu.

4. La Sécurité des LLM en Pratique

En production, la sécurité des LLM signifie une protection en couches — pas seulement chiffrer les données, mais contrôler la manière dont elles circulent.

Chaque appel API, recherche vectorielle ou consultation d’embedding doit être considéré comme un vecteur d’attaque potentiel.

Pratiques clés

- Protection continue des données tout au long du cycle de vie du modèle

- Journaux d’audit pour une traçabilité transparente

- Validation automatisée de la conformité intégrée à la surveillance des activités

L’architecture au niveau du proxy de DataSunrise filtre et anonymise les charges utiles avant qu’elles n’atteignent les points de terminaison des modèles, garantissant que même les workflows complexes de RAG ou d’affinage restent conformes et protégés.

5. La Sûreté des LLM en Pratique

La sûreté, contrairement à la sécurité, est souvent évaluée a posteriori. Mais des mécanismes proactifs peuvent empêcher la plupart des incidents éthiques ou réputationnels avant qu’ils ne se produisent.

Techniques

- Apprentissage par renforcement (RLHF) pour une adaptation éthique

- Filtres de modération contextuelle pour le contrôle des sorties

- Alignement réglementaire entre juridictions

- Masquage statique des données pour éviter une exposition nuisible lors de la formation

Exemple : logique de filtrage des sorties

def moderation_layer(text):

if "discours de haine" in text.lower():

return "Contenu bloqué pour raison de sûreté"

return text

Grâce à une modération en couches, les organisations peuvent aligner le comportement de l’IA sur les normes sociales, culturelles et légales — non pas en guise de simple mesure corrective, mais comme partie intégrante du pipeline de formation et de déploiement.

6. Vers un Cadre Unifié

Sécurité et sûreté devraient se renforcer mutuellement, non se concurrencer.

Une stratégie de gouvernance mature de l’IA les tisse ensemble en un seul fil opérationnel — garantissant que le modèle soit à la fois techniquement robuste et socialement responsable.

Approche unifiée

- Analyse comportementale pour la détection d’anomalies et de biais

- Pistes d’audit pour la transparence et la traçabilité

- Classification des données pour la gestion contextuelle des risques

| Couche | Objectif Sécurité | Objectif Sûreté |

|---|---|---|

| Données | Chiffrement & Masquage | Données d’entraînement éthiques |

| Modèle | Isolation & Contrôle d’accès | Alignement & Garde-fous |

| Sortie | Journalisation & Validation | Filtres de toxicité & Transparence |

En unissant les contrôles de sécurité et les politiques éthiques, les entreprises créent des systèmes d’IA qui non seulement résistent à la pression externe mais respectent aussi les valeurs humaines en interne.

Conclusion

La sécurité maintient le modèle protégé du monde.

La sûreté maintient le monde protégé du modèle.

Ces deux dimensions définissent la crédibilité de tout système d’IA.

Ce n’est que lorsqu’elles coexistent — harmonisées par la politique, la surveillance et l’automatisation de la conformité — que les entreprises peuvent exploiter pleinement le potentiel des LLM sans compromettre la confidentialité, l’intégrité ou la confiance.

Protégez vos données avec DataSunrise

Sécurisez vos données à chaque niveau avec DataSunrise. Détectez les menaces en temps réel grâce à la surveillance des activités, au masquage des données et au pare-feu de base de données. Appliquez la conformité des données, découvrez les données sensibles et protégez les charges de travail via plus de 50 intégrations supportées pour le cloud, sur site et les systèmes de données basés sur l'IA.

Commencez à protéger vos données critiques dès aujourd’hui

Demander une démo

Télécharger maintenant

Protégez vos données avec DataSunrise

Sécurisez vos données à chaque niveau avec DataSunrise. Détectez les menaces en temps réel grâce à la surveillance des activités, au masquage des données et au pare-feu de base de données. Appliquez la conformité des données, découvrez les données sensibles et protégez les charges de travail via plus de 50 intégrations supportées pour le cloud, sur site et les systèmes de données basés sur l'IA.

Commencez à protéger vos données critiques dès aujourd’hui

Demander une démo Télécharger maintenant