Vie privée des données en IA expliquée

Introduction

Les systèmes d’IA générative tels que ChatGPT, Azure OpenAI et Qdrant transforment les industries — de l’automatisation du service client à l’accélération des processus créatifs. Mais avec un grand pouvoir vient une grande responsabilité : comment les entreprises peuvent-elles garantir que des données sensibles ne fuient pas via ces systèmes ? Dans ce guide, nous expliquons les risques, les solutions et les outils pour protéger vos données à l’ère de l’IA.

Les risques cachés de l’IA générative

Les modèles d’IA générative traitent d’énormes quantités de données, y compris des informations sensibles. Voici où les problèmes peuvent survenir :

1. Fuites aléatoires de données

Les modèles d’IA peuvent involontairement « se souvenir » et régurgiter des données sensibles extraites de leurs ensembles d’entraînement. Par exemple :

- Un chatbot médical pourrait révéler des dossiers de patients.

- Un assistant de programmation pourrait exposer des algorithmes propriétaires.

Ce risque s’intensifie lorsque les modèles sont ajustés sur des jeux de données internes. Sans mesures de sécurité adéquates, même des requêtes anodines pourraient déclencher des divulgations non intentionnelles.

2. Abus de modèle et injection de requêtes

Les attaquants peuvent manipuler les systèmes d’IA pour obtenir des informations confidentielles :

- Attaques « DAN » (Do Anything Now) : Contourner les garde-fous éthiques afin d’extraire des données confidentielles.

- Atteinte aux droits d’auteur : Générer du code propriétaire ou des textes protégés par le droit d’auteur.

- Extraction de données : Tromper les modèles pour qu’ils divulguent des fragments de leurs données d’entraînement.

3. Résultats préjudiciables dus à un mauvais réglage

Les modèles ajustés sans contrôles de sécurité adéquats peuvent produire des résultats biaisés, contraires à l’éthique ou non conformes. Par exemple :

- Générer des recommandations d’embauche discriminatoires.

- Divulguer des informations personnelles identifiables (PII).

Comment les bases de données interagissent avec les risques de confidentialité de l’IA

L’IA générative ne fonctionne pas en isolement — elle s’appuie sur des bases de données pour les données d’entraînement, les requêtes en temps réel, et le stockage des sorties. Les vulnérabilités courantes incluent :

| Risque lié à la base de données | Impact sur l’IA |

|---|---|

| Informations personnelles identifiables non masquées dans les données d’entraînement | Les modèles d’IA apprennent et reproduisent des informations sensibles |

| Mauvais contrôles d’accès | Les utilisateurs non autorisés exploitent les API de l’IA |

| Transactions non auditées | Aucune visibilité sur le contenu généré par l’IA |

Par exemple, si une IA de service client extrait des données d’une base SQL faiblement sécurisée, des attaquants pourraient s’en servir comme porte dérobée pour extraire des dossiers sensibles.

Atténuer les risques de confidentialité de l’IA : Un cadre en 3 étapes

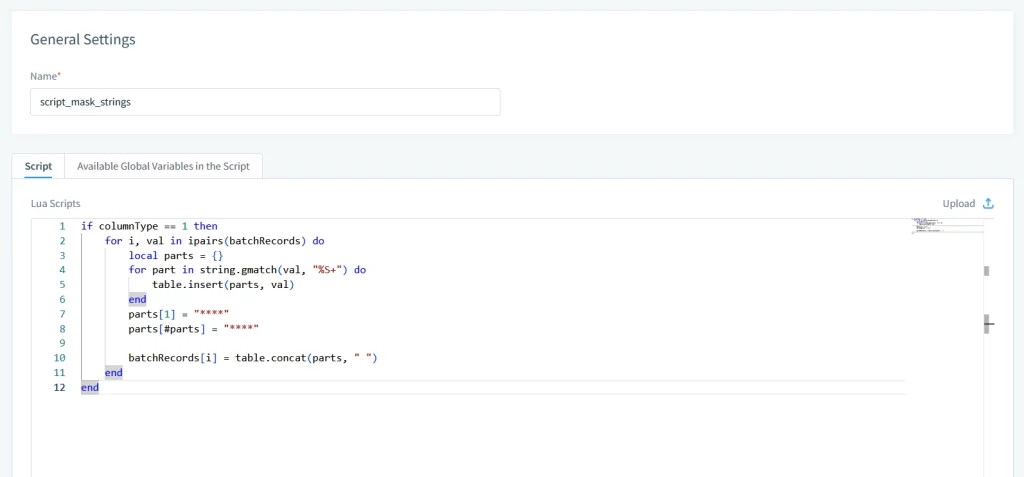

1. Assainissement des entrées et masquage des données

Avant que les données n’atteignent les modèles d’IA, il est essentiel d’assainir les entrées en utilisant :

- Masquage statique et dynamique : Remplacer les valeurs sensibles par des données réalistes mais fictives.

- Contrôles d’accès basés sur les rôles (RBAC) : Restreindre les champs de données auxquels les systèmes d’IA peuvent accéder.

2. Validation des sorties et pistes d’audit

Surveillez et enregistrez chaque interaction avec l’IA :

- Filtres Regex : Bloquer les sorties contenant des numéros de carte de crédit ou des emails.

- Journaux d’audit : Suivre qui a utilisé l’IA, ce qu’ils ont demandé et ce qui a été généré.

3. Réglage fin avec garde-fous

Lors de la personnalisation des modèles, intégrez des vérifications de sécurité :

- Détection de biais : Repérer un langage discriminatoire.

- Conformité réglementaire : S’assurer que les résultats respectent le RGPD ou la HIPAA.

DataSunrise : Sécuriser l’IA générative à tous les niveaux

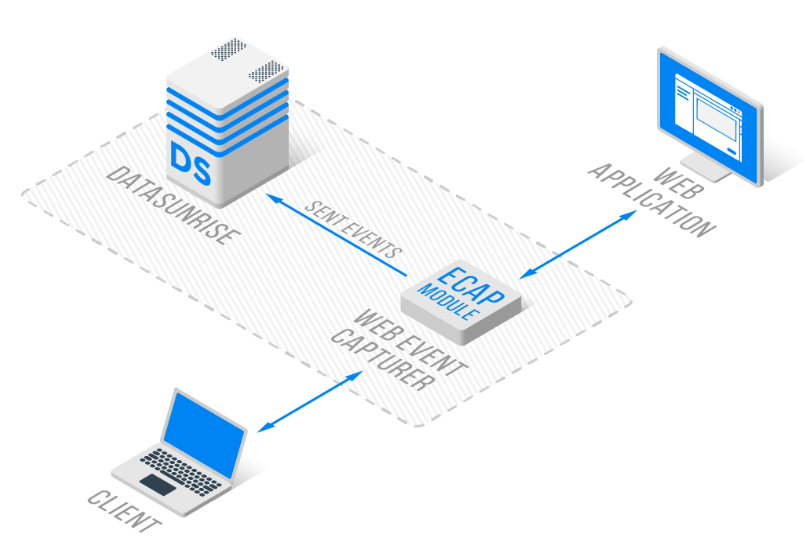

Notre plate-forme offre une sécurité unifiée pour les bases de données traditionnelles et les systèmes d’IA modernes. Voici comment nous protégeons vos données :

1. Audit et surveillance spécifiques à l’IA

- Pistes transactionnelles : Enregistrer chaque interaction avec ChatGPT ou Azure OpenAI dans des journaux standardisés.

- Alertes en temps réel : Recevoir une notification en cas de requêtes suspectes ou de fuites de PII grâce à la surveillance de l’activité des bases de données.

2. Masquage des données pour l’entraînement de l’IA

- Masquage en place : Anonymiser les ensembles de données d’entraînement sans les déplacer.

- Redaction dynamique : Éliminer les données sensibles des requêtes d’IA en direct.

3. Automatisation de la conformité

- Modèles préconstruits pour le RGPD, la HIPAA et la PCI DSS.

- Rapport de conformité automatisé via le gestionnaire de conformité DataSunrise.

4. Support multi-plateforme

- Bases de données : MySQL, PostgreSQL, Neo4j, Cassandra et plus de 40 autres.

- IA générative : ChatGPT, Qdrant et Azure OpenAI.

Pourquoi les outils de sécurité traditionnels ne suffisent pas

Les outils de bases de données hérités manquent de fonctionnalités spécifiques à l’IA :

| Capacité | Outils traditionnels | DataSunrise |

|---|---|---|

| Audit des requêtes IA | ❌ Non | ✅ Oui |

| Masquage dynamique des données | Basique | Avancé (regex + NLP) |

| Couverture multi-plateforme | Limitée | 40+ bases de données + systèmes d’IA |

Pour débuter avec la vie privée des données en IA

- Effectuer une évaluation des risques

Identifiez où l’IA interagit avec des données sensibles en utilisant la découverte de données. - Mettre en place des garde-fous

Mettez en œuvre des règles de sécurité pour les API IA et les bases de données. - Former votre équipe

Sensibilisez les employés aux politiques de sécurité

Conclusion : Allier innovation et sécurité

L’IA générative libère une valeur considérable — mais seulement si les entreprises accordent la priorité à la vie privée des données. En intégrant des pratiques de sécurité robustes et des outils tels que DataSunrise, les organisations peuvent atténuer les risques tout en favorisant l’innovation.

Découvrez comment notre plate-forme sécurise vos flux de travail en IA :