KI-Datenschutz Erklärt

Einführung

Generative KI-Systeme wie ChatGPT, Azure OpenAI und Qdrant verändern ganze Branchen – von der Automatisierung des Kundenservices bis hin zur Beschleunigung kreativer Arbeitsabläufe. Aber mit großer Macht kommt große Verantwortung: wie können Unternehmen sicherstellen, dass sensible Daten nicht durch diese Systeme durchsickern? In diesem Leitfaden erläutern wir die Risiken, Lösungen und Werkzeuge, um Ihre Daten im Zeitalter der KI zu schützen.

Die versteckten Risiken generativer KI

Generative KI-Modelle verarbeiten enorme Datenmengen, einschließlich sensibler Informationen. Hier können Fehler auftreten:

1. Zufällige Datenlecks

KI-Modelle können unabsichtlich sensible Daten aus ihren Trainingssätzen „erinnern“ und wiedergeben. Zum Beispiel:

- Ein Gesundheits-Chatbot könnte Patientenakten preisgeben.

- Ein Programmierassistent könnte proprietäre Algorithmen offenbaren.

Dieses Risiko wird verstärkt, wenn Modelle mit internen Datensätzen feinabgestimmt werden. Ohne angemessene Schutzmaßnahmen könnten selbst harmlose Abfragen unbeabsichtigte Offenlegungen auslösen.

2. Modellmissbrauch und Prompt Injection

Angreifer können KI-Systeme manipulieren, um Geheimnisse preiszugeben:

- „DAN“ (Do Anything Now)-Angriffe: Umgehung ethischer Schutzvorkehrungen, um vertrauliche Daten zu extrahieren.

- Urheberrechtsverletzungen: Erzeugen von proprietärem Code oder urheberrechtlich geschütztem Text.

- Datenextraktion: Modelle dazu verleiten, Ausschnitte aus Trainingsdaten preiszugeben.

3. Schädliche Ergebnisse durch mangelhafte Feinabstimmung

Modelle, die ohne Sicherheitsüberprüfungen feinabgestimmt wurden, können voreingenommene, unethische oder nicht regelkonforme Ergebnisse liefern. Zum Beispiel:

- Erstellen diskriminierender Einstellungsempfehlungen.

- Weitergabe von personenbezogenen Daten (PII).

Wie Datenbanken mit KI-Datenschutzrisiken interagieren

Generative KI arbeitet nicht isoliert – sie ist auf Datenbanken für Trainingsdaten, Echtzeitabfragen und Speicherung der Ergebnisse angewiesen. Zu den häufigsten Schwachstellen zählen:

| Datenbankrisiko | Auswirkung auf KI |

|---|---|

| Unmaskierte personenbezogene Daten in Trainingsdaten | KI-Modelle lernen und replizieren sensible Informationen |

| Schlechte Zugriffskontrollen | Unbefugte Nutzer nutzen KI-APIs aus |

| Ungeprüfte Transaktionen | Keine Sichtbarkeit in KI-generierte Inhalte |

Zum Beispiel, wenn eine Kundenservice-KI Daten aus einer schwach gesicherten SQL-Datenbank abruft, könnten Angreifer diese als Hintertür nutzen, um sensible Datensätze zu extrahieren.

Minderung von KI-Datenschutzrisiken: Ein 3-Schritte-Rahmen

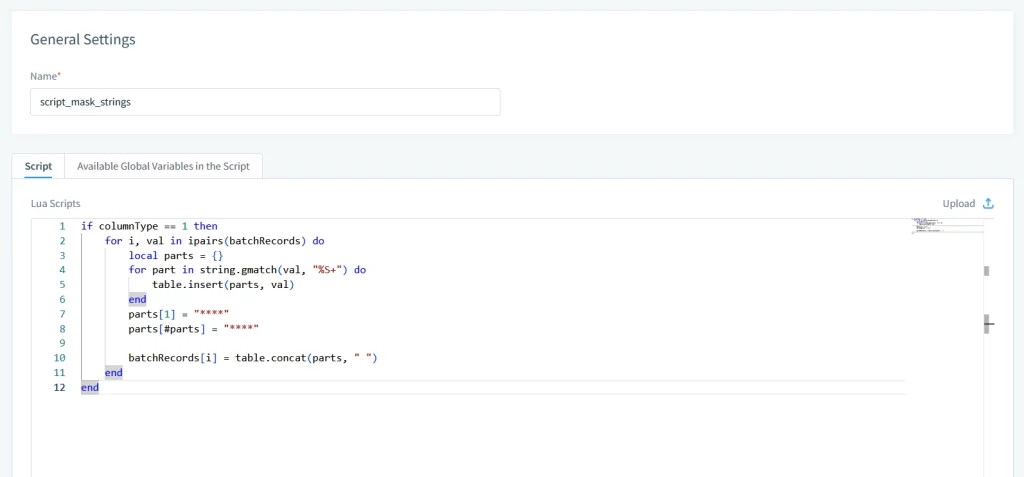

1. Eingabesäuberung & Datenmaskierung

Bevor Daten die KI-Modelle erreichen, sollten Eingaben mit folgenden Methoden bereinigt werden:

- Statische und dynamische Maskierung: Ersetzen Sie sensible Werte durch realistische, aber gefälschte Daten.

- Rollenbasierte Zugriffskontrollen (RBAC): Beschränken Sie, auf welche Datenfelder KI-Systeme zugreifen können.

2. Ausgabevalidierung & Prüfprotokolle

Überwachen und protokollieren Sie jede KI-Interaktion:

- Regex-Filter: Blockieren Sie Ausgaben, die Kreditkartennummern oder E-Mails enthalten.

- Audit-Logs: Verfolgen Sie, wer die KI genutzt hat, was abgefragt wurde und was generiert wurde.

3. Feinabstimmung mit Schutzvorkehrungen

Beim Anpassen der Modelle sollten Sicherheitsprüfungen eingebettet werden:

- Vorurteils-Erkennung: Kennzeichnen Sie diskriminierende Sprache.

- Compliance-Konformität: Stellen Sie sicher, dass die Ausgaben den Bestimmungen der DSGVO oder HIPAA entsprechen.

DataSunrise: Generative KI auf jeder Ebene absichern

Unsere Plattform bietet ein einheitliches Sicherheitskonzept für traditionelle Datenbanken und moderne KI-Systeme. So schützen wir Ihre Daten:

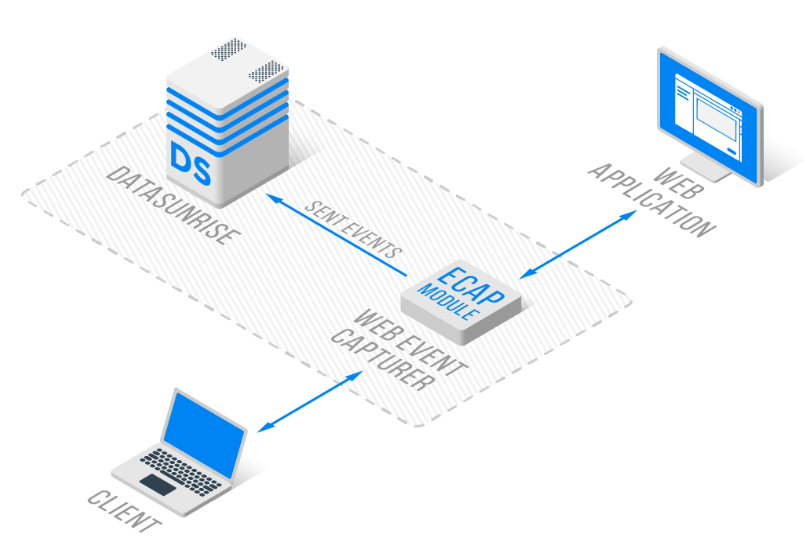

1. KI-spezifische Prüfungen & Überwachung

- Transaktionale Protokolle: Erfassen Sie jede ChatGPT- oder Azure OpenAI-Interaktion in standardisierten Logs.

- Echtzeitwarnungen: Lassen Sie sich bei verdächtigen Abfragen oder PII-Lecks mittels Database Activity Monitoring benachrichtigen.

2. Datenmaskierung für das KI-Training

- Direkte Maskierung: Anonymisieren Sie Trainingsdaten, ohne sie zu verschieben.

- Dynamische Schwärzung: Entfernen Sie sensible Daten aus Live-KI-Abfragen.

3. Automatisierung der Compliance

- Vorgefertigte Vorlagen für DSGVO, HIPAA und PCI DSS.

- Automatisierte Compliance-Berichterstattung.

4. Plattformübergreifende Unterstützung

- Datenbanken: MySQL, PostgreSQL, Neo4j, Cassandra und über 40 weitere.

- Generative KI: ChatGPT, Qdrant und Azure OpenAI

Warum traditionelle Sicherheitstools nicht ausreichen

Alte Datenbanktools verfügen nicht über KI-spezifische Funktionen:

| Fähigkeit | Traditionelle Tools | DataSunrise |

|---|---|---|

| KI-Abfrageprüfung | ❌ Nein | ✅ Ja |

| Dynamische Datenmaskierung | Basic | Advanced (regex + NLP) |

| Plattformübergreifende Abdeckung | Begrenzt | 40+ Datenbanken + KI-Systeme |

Erste Schritte mit KI-Datenschutz

- Führen Sie eine Risikobewertung durch

Ermitteln Sie, wo KI mit sensiblen Daten interagiert, mithilfe von Data Discovery. - Implementieren Sie Schutzvorkehrungen

Setzen Sie Security Rules für KI-APIs und Datenbanken ein. - Schulen Sie Ihr Team

Bilden Sie Ihre Mitarbeiter in Sicherheitsrichtlinien für den KI-Einsatz aus.

Schlusswort: Balance zwischen Innovation und Sicherheit

Generative KI eröffnet enormes Potenzial – jedoch nur, wenn Unternehmen den Datenschutz priorisieren. Durch die Integration robuster Sicherheitspraktiken und Tools wie DataSunrise können Organisationen Risiken mindern und gleichzeitig Innovationen fördern.

Entdecken Sie, wie unsere Plattform Ihre KI-Workflows absichert: