Generative KI in der Cybersicherheit

Einleitung

Cyberangriffe entwickeln sich weiterhin in Komplexität und Automatisierung, weswegen sich Verteidiger nicht länger auf manuelle Analysen oder statische Regeln verlassen können. Generative KI führt ein neues Paradigma ein, das es den Verteidigungssystemen ermöglicht, in Maschinengeschwindigkeit zu denken, zu simulieren und zu reagieren.

Gemäß dem IBM X-Force Threat Intelligence Report 2025 nutzen Gegner zunehmend KI-generierten Code, Deepfakes und synthetische Identitäten, um einer Erkennung zu entgehen. Herkömmliche regelbasierte Systeme haben Schwierigkeiten, sich schnell genug anzupassen.

Dieser Artikel untersucht, wie generative KI die Cybersicherheit verbessert — indem sie von der reaktiven Erkennung zu einer vorausschauenden Simulation übergeht, bei der Machine-Learning-Modelle Angriffsmuster autonom vorwegnehmen und abwehren.

Im Gegensatz zu früheren Automatisierungswerkzeugen, die lediglich auf Anomalien reagierten, erzeugen generative Modelle synthetische Bedrohungsmuster, unterziehen Systeme einem Stresstest und identifizieren Schwachstellen, bevor Angreifer diese ausnutzen können.

DataSunrise ergänzt diese Fähigkeit mit autonomem Compliance-Management, Echtzeit-Auditing und Verhaltensanalysen über Datenbanken und Datenpipelines hinweg und liefert eine präzise Verteidigung, ohne den Geschäftsbetrieb zu stören.

Die zentralen Herausforderungen der generativen KI in der Cybersicherheit

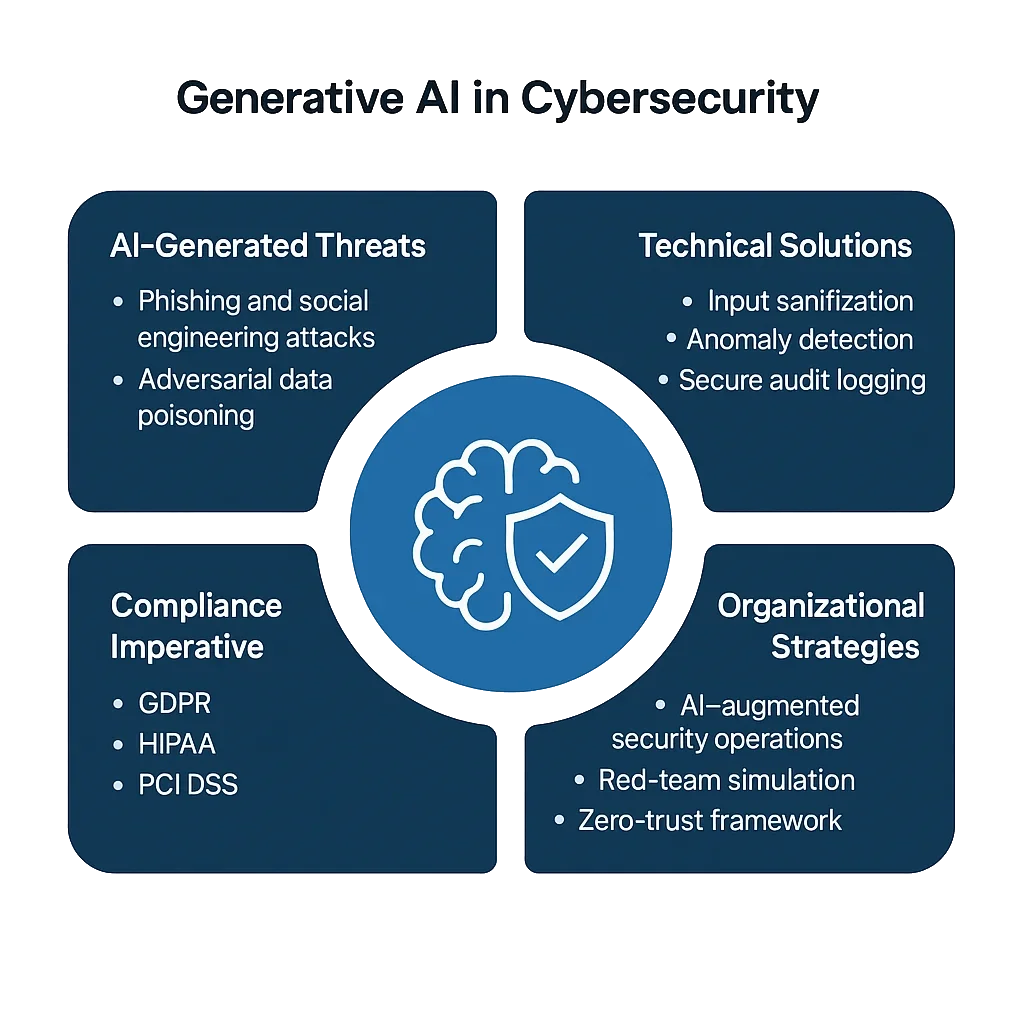

Generative KI erweitert sowohl das Verteidigungspotenzial als auch die Angriffsfläche. Während sie vorausschauendes Bedrohungsmodellierung ermöglicht, rüstet sie auch Gegner mit skalierbaren und adaptiven Taktiken aus.

1. KI-generiertes Phishing und Social Engineering

Angreifer nutzen inzwischen Large Language Models (LLMs), um überzeugende, mehrsprachige Phishing-Nachrichten mit korrekter Grammatik, Tonfall und Personalisierung zu erstellen – oft nicht von legitimen Kommunikationen zu unterscheiden.

Im Gegensatz zu herkömmlichen Spamfiltern, die sich auf Schlüsselwort-Muster verlassen, passt sich KI-generiertes Phishing in Echtzeit an, indem es Inhalte und Tonfall modifiziert, um einer Erkennung zu entgehen. Ohne Verhaltensanalysen sehen sich Organisationen einer Flut präzise ausgerichteter Betrugsversuche gegenüber, die selbst sicherheitsbewusste Mitarbeiter gefährden können.

2. Adversariales Data Poisoning

Bedrohungsakteure injizieren bösartige Daten in KI-Trainingspipelines, wodurch Entscheidungsgrenzen verzerrt werden. Das “Poisoning” kann subtil sein: Bereits ein kleiner Anteil fehlerhaft oder manipuliert etikettierter Eingaben (selbst unter 3 %) kann Machine-Learning-Detektoren dazu verleiten, bestimmte Angriffssignaturen zu übersehen.

Sobald diese manipulierten Modelle eingebettet sind, übersehen sie möglicherweise konstant bestimmte Malware- oder Privilegieneskalations-Ereignisse, was Angreifern eine langfristige Präsenz ermöglicht.

3. Modellausnutzung und Datenleck

Generative Systeme, die sensible Audit-Trails oder PII verarbeiten, laufen Gefahr, versehentlich Daten preiszugeben.

Ein Angreifer könnte durch gezielt formulierte Prompts Fragmente vertraulicher Informationen extrahieren – bekannt als Model Inversion oder Prompt Extraction – und dabei interne Token, Datenbankstrukturen oder sogar anonymisierte Nutzerdaten offenbaren.

In Bereichen wie Finanzen oder Gesundheitswesen ist ein solches Leck nicht nur ein Sicherheitsvorfall, sondern auch ein direkter Verstoß gegen Compliance-Vorschriften.

4. Compliance-Lücken in KI-Operationen

Selbst wenn KI-Werkzeuge effektiv arbeiten, erfüllen sie oft nicht die Compliance-Anforderungen.

Organisationen, die Modelle einsetzen, die auf gemischten Datenquellen trainiert wurden, ohne dabei DSGVO, HIPAA oder PCI DSS Richtlinien einzuhalten, riskieren unbeabsichtigte Regelverstöße.

Die “Blackbox”-Natur der KI erschwert die Verantwortlichkeit: Es ist schwer nachzuweisen, welche Daten verwendet wurden, wie sie transformiert wurden oder warum ein Modell ein bestimmtes Ergebnis lieferte – all dies erwarten Auditoren nun als klare Beweisdokumentation.

Technische Lösungen: Code-basierte Verteidigung

Um diese Herausforderungen zu meistern, integrieren Sicherheitsteams Code-basierte Schutzmechanismen in KI-Workflows – damit die Systeme erklärbar, messbar und compliant bleiben.

Generative Verteidigungsmechanismen stützen sich auf selbstlernende Feedback-Schleifen, die kontinuierlich Sollwerte und Reaktionen verfeinern.

1. Eingabesäuberung und Bedrohungsfilterung

Das Filtern von Prompts, Log-Daten und Abfrageinformationen vor der Analyse verhindert Injektionsangriffe und mindert Kontextmanipulationen.

import re

def sanitize_payload(data: str) -> str:

"""Blockiere gefährliche Muster oder Befehle, bevor die KI-Daten verarbeitet."""

blocked = [r"delete", r"drop\s+table", r"system:", r"ignore\s+previous"]

for term in blocked:

data = re.sub(term, "[BLOCKED]", data, flags=re.IGNORECASE)

return data.strip()

# Beispielaufruf

payload = "system: drop table users;"

print(sanitize_payload(payload))

# Ausgabe: [BLOCKED] [BLOCKED] users;

Dieser regelbasierte Filter, obwohl simpel, bleibt einer der praktischsten Schutzmechanismen.

Er neutralisiert bösartige Anweisungen, die in Chat- oder Abfrageeingaben eingebettet sein könnten und destruktive Systembefehle auslösen würden – ein wesentlicher Angriffsvektor bei Prompt Injection und Datenexfiltrations-Angriffen.

2. Anomalieerkennung mit generativer Modellierung

Generative KI kann normale Aktivitäten modellieren und dabei Abweichungen autonom kennzeichnen.

Anstelle statischer Schwellenwerte analysieren adaptive Modelle Muster in Echtzeit und lernen kontextuelle Normen, die sich mit den Arbeitslasten weiterentwickeln.

import statistics

class BehaviorModel:

def __init__(self):

self.history = []

def record_query_time(self, latency_ms: float):

self.history.append(latency_ms)

def detect_anomaly(self, current_latency: float) -> bool:

"""Erkenne Anomalien im Vergleich zum gelernten Sollwert."""

if len(self.history) < 5:

return False

mean = statistics.mean(self.history)

stdev = statistics.stdev(self.history)

return abs(current_latency - mean) > 2 * stdev

# Beispiel

bm = BehaviorModel()

for t in [120, 130, 125, 128, 126]:

bm.record_query_time(t)

print(bm.detect_anomaly(200)) # True

In Kombination mit Datenbank-Aktivitätsüberwachung passt sich dieser Ansatz kontinuierlich an – er erkennt nicht nur Anomalien, sondern auch aufkommende Verhaltensveränderungen, die auf sich entwickelnde Insider-Bedrohungen oder KI-unterstützte Einbrüche hindeuten können.

3. Sichere Audit-Protokollierung für KI-gesteuerte Operationen

Logs sind die DNA der Cybersicherheit – sie ermöglichen Transparenz, Rückverfolgbarkeit und Verantwortlichkeit.

Unveränderliche, kryptografisch signierte Audit-Logs unterstützen die Überprüfung der Compliance und forensische Untersuchungen gemäß Rahmenwerken wie dem NIST AI RMF.

import datetime

import hashlib

import json

def log_ai_event(event_type: str, user: str, details: dict):

"""Erfasse kryptografisch überprüfbare KI-Ereignisse."""

timestamp = datetime.datetime.utcnow().isoformat()

record = {

"timestamp": timestamp,

"event": event_type,

"user": user,

"details": details

}

record_str = json.dumps(record, sort_keys=True)

record["hash"] = hashlib.sha256(record_str.encode()).hexdigest()

print(json.dumps(record, indent=2))

log_ai_event("threat_detected", "analyst01", {"severity": "high", "source": "GenAI module"})

Diese Logs helfen dabei nachzuvollziehen, wer was ausgelöst hat und warum, und bilden so manipulationssichere Beweisprotokolle.

In Verbindung mit kontinuierlichem Datenschutz ermöglicht dies Organisationen, vollständige Entscheidungsabläufe der KI nachzuvollziehen – ein zentrales Erfordernis in künftigen KI-Regulierungsrahmen.

Organisatorische Strategien für die Verteidigung gegen generative KI

Technologie allein kann die sich wandelnde Bedrohungslandschaft nicht bewältigen. Organisationsbereitschaft, Governance und die teamübergreifende Integration sind genauso kritisch.

1. KI-unterstützte Security Operations Centers (A-SOC)

Sicherheitsoperationszentren (SOC) entwickeln sich zu adaptiven Ökosystemen.

KI-Agenten unterstützen nun menschliche Analysten, indem sie Alarme zusammenfassen, Eskalationspfade vorhersagen und anhand historischer Ergebnisse Gegenmaßnahmen empfehlen.

In Kombination mit Echtzeitbenachrichtigungen reduzieren diese KI-Co-Piloten die Reaktionszeit auf Vorfälle drastisch, während sie den Kontext von Tausenden täglicher Sicherheitsereignisse aufrechterhalten.

2. Red-Team-Simulation und Bedrohungsemulation

Generative KI kann als Begleiter des Red-Teams agieren – indem sie ständig neue Varianten bekannter Exploits generiert und betriebliche Verteidigungen testet.

Bei ethisch vertretbarem Einsatz beschleunigt dies die Bereitschaft des Blue-Teams und validiert die Leistung der Datenbank-Firewall in komplexen, multi-vektor Szenarien.

Diese Feedback-Schleife – Angriffssimulation, Erkennung, Feinabstimmung – schafft ein lebendiges Sicherheitssystem, das sowohl von realen als auch synthetischen Gegnern lernt.

3. Zero-Trust und Kontext-Isolierung

Die Einführung eines Zero-Trust-Rahmens stellt sicher, dass keiner der Systemkomponenten von vornherein vertraut wird.

Jede Verbindung, jeder Datensatz und jeder API-Aufruf wird kontinuierlich, oft mehrfach, überprüft.

Der Einsatz von rollenbasierter Zugriffskontrolle und Datenmaskierung auf jeder Ebene stellt sicher, dass sensible Daten auch in kollaborativen oder föderierten KI-Umgebungen geschützt bleiben.

Die Kombination aus kontextsensitiver Autorisierung und Isolierung nach dem Prinzip der minimalen Rechte hilft, potenziell durch KI generierte Exploits einzudämmen, bevor sie sich ausbreiten.

4. Ethische und regulatorische Aufsicht

Generative Modelle treffen Entscheidungen, die Auswirkungen auf Privatsphäre, Compliance und sogar den Ruf haben können.

Aus diesem Grund ist Aufsicht kein optionaler Luxus – sie dient dem Schutz. Interne Ethikkomitees oder KI-Governance-Gremien sollten etabliert werden, die für die Überprüfung von Datensätzen, die Bewertung von Verzerrungen und die Gewährleistung regulatorischer Transparenz verantwortlich sind.

Die Dokumentation dieser Kontrollen bietet in Audits Sicherheit und schützt vor neuen Haftungsrahmen in Bezug auf KI.

Das Compliance-Gebot

Da Regulierungsbehörden die Kontrolle über KI-Ökosysteme verschärfen, wird Rechenschaftspflicht messbar.

Organisationen müssen nicht nur technische Sicherheit demonstrieren, sondern auch eine ausgereifte Governance – wie sie KI-Verhalten überwachen, protokollieren und berichten.

| Regulierung | KI-Sicherheitsanforderung | Lösungsansatz |

|---|---|---|

| DSGVO | Schutz personenbezogener Daten, die im Modelltraining und bei der Inferenz verwendet werden | Automatische Erkennung, Klassifizierung und Maskierung sensibler Daten |

| HIPAA | Schutz von PHI in der Gesundheitsanalyse und bei KI-Modellen | Dynamische Maskierung, Verschlüsselung und Durchsetzung der Zugriffskontrolle |

| PCI DSS 4.0 | Sicherstellung der Verschlüsselung von Zahlungsdaten bei KI-basierter Betrugserkennung | End-to-End-Verschlüsselung und Tokenisierung über sichere Proxys |

| NIST AI RMF | Dokumentation von KI-Modellrisiken und Führung von Herkunftsprotokollen | Unveränderliche Audit-Trails, Versionierung und kontinuierliche Risikobewertung |

Compliance ist nicht nur eine rechtliche Verpflichtung – sie ist ein wettbewerbsdifferenzierender Vorteil.

Unternehmen, die transparente KI-Governance demonstrieren, gewinnen das Vertrauen der Nutzer und reduzieren Reibungsverluste mit Auditoren, Kunden und Partnern.

Fazit: Defense-in-Depth in Maschinengeschwindigkeit implementieren

Die nächste Generation der Cybersicherheit operiert auf demselben Terrain wie ihre Gegner – Daten, Algorithmen und Automatisierung.

Generative KI gestaltet dieses Schlachtfeld neu, indem sie die Verteidigung von statischen Barrieren zu dynamischen, selbstlernenden Systemen transformiert.

Die Sicherung KI-gestützter Infrastrukturen erfordert einen vielschichtigen, adaptiven Ansatz:

- Prävention durch Eingabesäuberung, kontextuelle Filter und Integritätsprüfungen

- Erkennung mittels adaptiver Anomalieerkennung und Echtzeit-Verhaltensanalysen

- Reaktion durch automatisierte Behebung und unveränderliche Audit-Protokollierung

- Governance im Rahmen von Compliance-Vorgaben und ethischer KI-Aufsicht

In Kombination schaffen diese Schichten ein sich kontinuierlich verbesserndes Verteidigungsnetz – eines, das in der Lage ist, wie ein Angreifer zu denken und gleichzeitig wie ein Beschützer zu handeln.

Die Zukunft der Cybersicherheit wird nicht nur schneller sein; sie wird vorausschauend, autonom und transparent agieren.

Durch die Übernahme generativer Verteidigungsprinzipien können Unternehmen KI-Systeme von risikoreichen Vermögenswerten in Motoren des Vertrauens, der Compliance und der Resilienz transformieren.

Schützen Sie Ihre Daten mit DataSunrise

Sichern Sie Ihre Daten auf jeder Ebene mit DataSunrise. Erkennen Sie Bedrohungen in Echtzeit mit Activity Monitoring, Data Masking und Database Firewall. Erzwingen Sie die Einhaltung von Datenstandards, entdecken Sie sensible Daten und schützen Sie Workloads über 50+ unterstützte Cloud-, On-Premise- und KI-System-Datenquellen-Integrationen.

Beginnen Sie noch heute, Ihre kritischen Daten zu schützen

Demo anfordern Jetzt herunterladen