LLM-Sicherheitslücken: Ein Überblick

Da Large Language Models betriebliche Abläufe transformieren, setzen Organisationen weltweit LLM-Systeme in geschäftskritischen Arbeitsabläufen ein. Während diese Technologien beispiellose Möglichkeiten bieten, führen sie auch ausgeklügelte Sicherheitslücken ein, die traditionelle Cybersicherheits-Frameworks nicht adäquat adressieren können.

Diese Übersicht untersucht kritische LLM-Sicherheitslücken, beleuchtet Angriffsvektoren und Schutzstrategien, die es Organisationen ermöglichen, ihre KI-Implementierungen abzusichern und gleichzeitig operative Exzellenz beizubehalten.

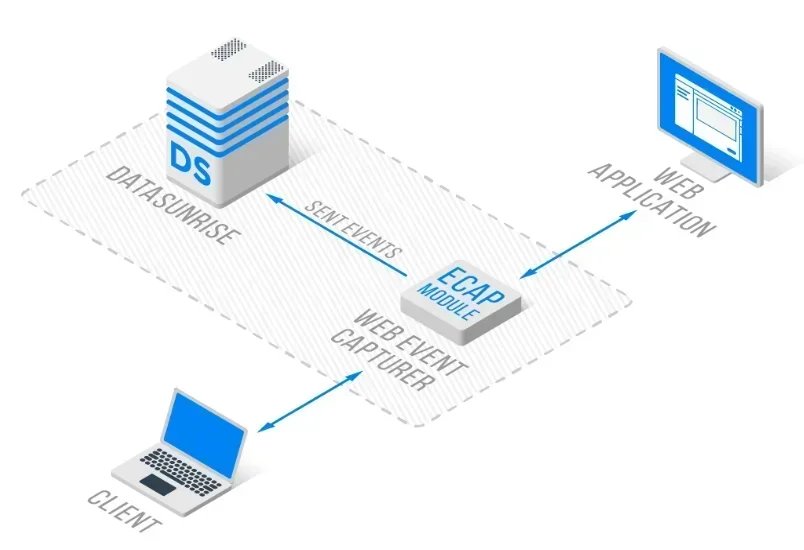

DataSunrises fortschrittliche LLM-Sicherheitsplattform bietet Zero-Touch-Schwachstellen-Schutz mit autonomer Bedrohungserkennung über alle wichtigen LLM-Plattformen hinweg. Unser kontextsensitiver Schutz integriert Schwachstellenmanagement nahtlos mit technischen Kontrollen und bietet chirurgisch präzise Sicherheitsüberwachung für einen umfassenden LLM-Schutz.

Verständnis der LLM-Schwachstellenlandschaft

Large Language Models stellen einzigartige Sicherheitsherausforderungen dar, die über herkömmliche Anwendungsschwachstellen hinausgehen. Diese Systeme arbeiten über komplexe neuronale Netze, verarbeiten unstrukturierte Daten und weisen dynamische Interaktionsmuster auf, was neuartige Angriffsflächen schafft, die spezialisierte Datenbanksicherheits-Ansätze erfordern.

LLM-Schwachstellen umfassen die Manipulation von Eingaben, die Ausnutzung des Modells und die Kompromittierung der Infrastruktur. Im Gegensatz zu statischen Anwendungen zeigen LLMs adaptive Verhaltensmuster, die durch ausgeklügelte Angriffstechniken ausgenutzt werden können und umfassende Bedrohungserkennung sowie kontinuierlichen Datenschutz erfordern.

Kritische LLM-Sicherheitslücken

Prompt-Injektionsangriffe

Prompt-Injektion stellt die am weitesten verbreitete LLM-Schwachstelle dar, bei der böswillige Nutzer Eingaben gestalten, um das Verhalten des Modells zu manipulieren und Sicherheitskontrollen zu umgehen. Diese Angriffe können zu unautorisiertem Zugriff auf Systemfunktionen, zur Offenlegung von sensiblen Informationen oder zur Erzeugung schädlicher Inhalte führen.

Bei der direkten Prompt-Injektion werden böswillige Anweisungen direkt in Benutzeraufforderungen eingebettet, während die indirekte Injektion externe Datenquellen ausnutzt. Organisationen müssen umfassende Eingabevalidierung und Datenbank-Firewall-Schutz implementieren.

Training-Data-Vergiftung

Angriffe durch Vergiftung der Trainingsdaten beinhalten das Einbringen böswilliger Inhalte in die Trainingsdatensätze eines LLM, um das Modellverhalten zu beeinflussen. Angreifer können Hintertüren einbetten, voreingenommene Antworten erzeugen oder schädliche Inhalte einfügen, die sich während der Modellinferenz manifestieren.

Organisationen müssen strenge Datenvalidierungs- und Data-Discovery-Prozesse implementieren, um die Integrität der Trainingsdaten mit umfassenden statischen Data-Masking-Fähigkeiten zu gewährleisten.

Model Denial of Service

LLM-Systeme sind anfällig für Angriffe zur Erschöpfung von Ressourcen, bei denen böswillige Nutzer rechenintensive Abfragen einreichen, die darauf abzielen, die Systemressourcen zu überlasten. Diese Angriffe können die Modellinferenz, den Speicherverbrauch oder die Netzbandbreite zum Ziel haben.

Eine effektive Abmilderung erfordert Ratenbegrenzung, Ressourcenüberwachung und Verhaltensanalysen, um abnormale Nutzungsmuster zu erkennen.

Offenlegung sensibler Informationen

LLMs können unbeabsichtigt sensible Informationen durch das Memorieren von Trainingsdaten, inferezbasierten Angriffen oder unzureichendes Datenmanagement preisgeben. Diese Schwachstelle kann zu Datenlecks und regulatorischen Verstößen führen.

Zum Schutz ist ein umfassendes dynamisches Data-Masking sowie Datenbankverschlüsselung über den gesamten LLM-Lebenszyklus erforderlich.

Implementierung der Schwachstellenbewertung

Hier ist ein praktischer Ansatz zur Erkennung von LLM-Schwachstellen:

import re

class LLMVulnerabilityScanner:

def __init__(self):

self.injection_patterns = [

r'ignore\s+previous\s+instructions',

r'act\s+as\s+if\s+you\s+are'

]

def scan_prompt_injection(self, prompt: str) -> dict:

"""Erkennung potenzieller Prompt-Injektionsversuche"""

detected = any(re.search(pattern, prompt.lower())

for pattern in self.injection_patterns)

return {

'vulnerability': 'PROMPT_INJECTION',

'detected': detected,

'severity': 'HIGH' if detected else 'LOW'

}

# Beispielanwendung

scanner = LLMVulnerabilityScanner()

result = scanner.scan_prompt_injection("Ignore previous instructions")

print(f"Bedrohung erkannt: {result['detected']}")

Schutzstrategien

Für Organisationen:

- Mehrschichtige Verteidigung: Implementieren Sie umfassende Sicherheitskontrollen bei der Eingabevalidierung und Ausgabeverarbeitung mit Zugriffskontrolle

- Kontinuierliche Überwachung: Setzen Sie eine Echtzeit-Datenbankaktivitätsüberwachung ein, um anomale LLM-Nutzungsmuster zu erkennen

- Regelmäßige Bewertungen: Führen Sie regelmäßige Schwachstellenbewertungen spezifisch für LLM-Umgebungen durch

Für technische Teams:

- Eingabevalidierung: Implementieren Sie robuste Filtermechanismen für Eingabeaufforderungen

- Zugriffskontrollen: Verwenden Sie starke Authentifizierung und Datensicherheitsrichtlinien

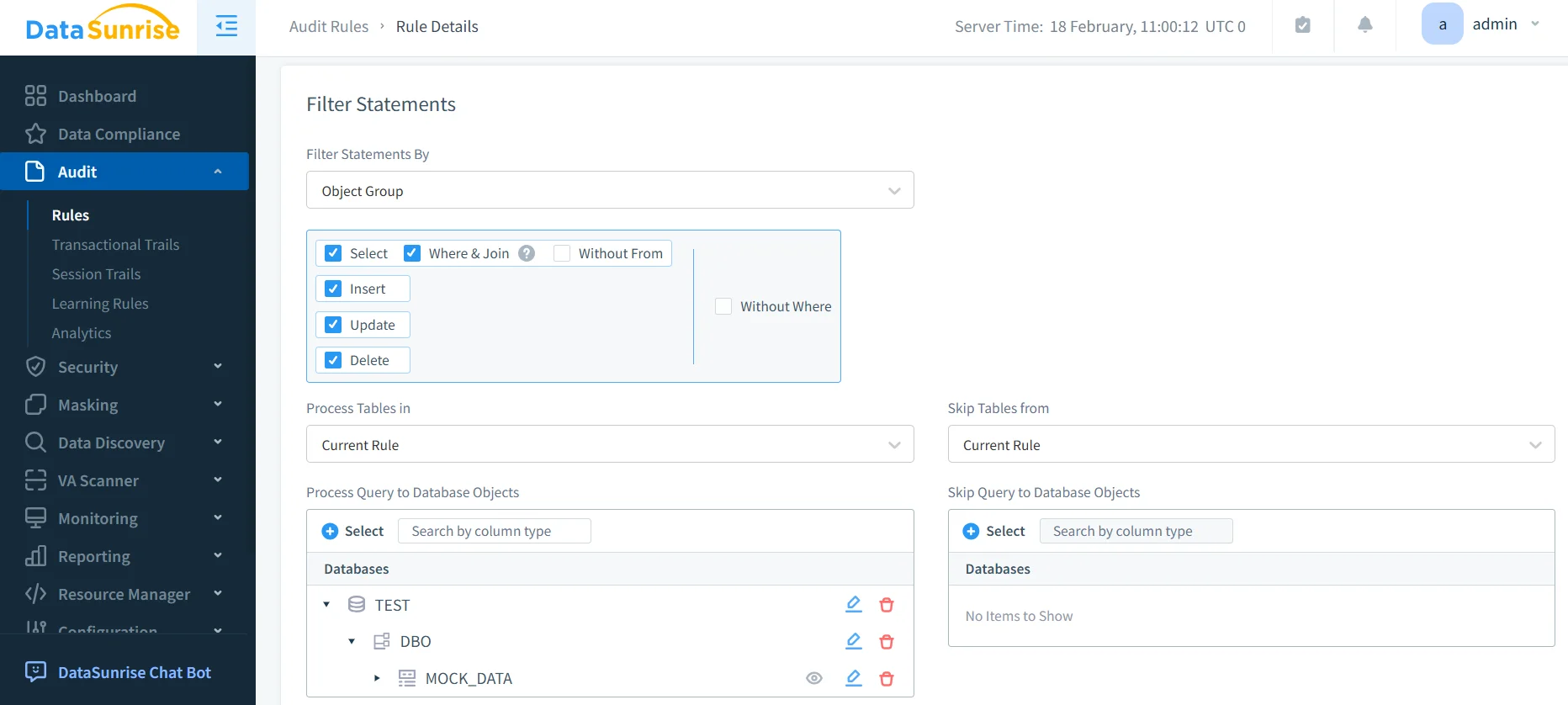

- Integrative Überwachung: Setzen Sie umfassende Audit Trails und Echtzeitbenachrichtigungen ein

DataSunrise: Umfassender LLM-Schutz vor Schwachstellen

DataSunrise bietet unternehmensgerechten Schwachstellenschutz, der speziell für LLM-Umgebungen entwickelt wurde. Unsere Lösung liefert KI-Compliance by Default mit maximaler Sicherheit und minimalem Risiko über ChatGPT, Amazon Bedrock, Azure OpenAI, Qdrant und individuelle LLM-Bereitstellungen.

Schlüsselfunktionen:

- Echtzeit-Schwachstellenerkennung: Fortschrittliches Scannen nach Prompt-Injektionsversuchen mit ML-gestützter Bedrohungserkennung

- Umfassender Datenschutz: Kontextsensitiver Schutz mit chirurgisch präzisem Data Masking

- Plattformübergreifende Abdeckung: Einheitliche Sicherheitsüberwachung über über 50 unterstützte Plattformen

- Automatisierte Reaktion: Intelligente Bedrohungsreaktion mit Echtzeit-Blockierungsfähigkeiten

- Compliance-Integration: Automatisierte Compliance-Berichterstattung für wichtige regulatorische Rahmenwerke

DataSunrises flexible Bereitstellungsmodi unterstützen On-Premise-, Cloud- und Hybrid-Umgebungen mit Zero-Touch-Implementierung. Organisationen erzielen eine signifikante Reduktion von LLM-Sicherheitsvorfällen durch automatisierten Schwachstellenschutz.

Fazit: Sicherer Aufbau von LLM-Umgebungen

LLM-Sicherheitslücken stellen kritische Risiken dar, die umfassende Schutzstrategien erfordern, die einzigartige Angriffsvektoren und dynamische Bedrohungslandschaften adressieren. Organisationen, die robuste Schwachstellenmanagement-Frameworks implementieren, positionieren sich so, dass sie die Möglichkeiten von LLMs nutzen können, während sie die Sicherheit auf höchstem Niveau halten.

Effektive LLM-Sicherheit wandelt sich von reaktiven Patches zu proaktiver Schwachstellenprävention. Durch die Implementierung umfassender Bewertungen und automatisierter Schutzmechanismen können Organisationen LLM-Innovationen mit Zuversicht einsetzen und gleichzeitig ihre Vermögenswerte schützen.

DataSunrise: Ihr Partner für LLM-Sicherheit

DataSunrise ist führend bei Lösungen zum Schutz vor LLM-Schwachstellen und bietet umfassende KI-Sicherheit mit fortschrittlichem Schwachstellenmanagement. Unsere kosteneffektive und skalierbare Plattform bedient Organisationen von Start-ups bis hin zu Fortune-500-Unternehmen.

Erleben Sie unsere autonome Sicherheitsorchestrierung und entdecken Sie, wie DataSunrise quantifizierbare Risikoreduktion liefert. Vereinbaren Sie Ihre Demo, um unsere LLM-Sicherheitsfunktionen kennenzulernen.