Sicherheitsanalysen aus ML-Anwendungen

Da maschinelles Lernen die Geschäftsabläufe in Unternehmen transformiert, setzen die meisten Organisationen ML-Anwendungen in geschäftskritischen Prozessen ein. Während ML transformativen Nutzen bietet, bringt es auch ausgeklügelte Sicherheitsherausforderungen mit sich, die herkömmliche Schutzkonzepte nicht adäquat bewältigen können.

Dieser Leitfaden untersucht Sicherheitsanalysen aus ML-Anwendungen und beleuchtet Umsetzungsstrategien, die es Organisationen ermöglichen, sichere und widerstandsfähige ML-Infrastrukturen aufzubauen, ohne dabei die operative Exzellenz zu beeinträchtigen.

Die hochmoderne ML-Sicherheitsplattform von DataSunrise bietet Zero-Touch Security Orchestration mit autonomem ML-Schutz über alle wichtigen Plattformen für maschinelles Lernen hinweg. Unser kontextsensitiver Schutz integriert nahtlos ML-Sicherheit in technische Kontrollen und ermöglicht eine präzise Sicherheitsverwaltung für einen umfassenden Schutz von ML-Anwendungen mit AI Compliance by Default.

Grundlagen der Sicherheit von ML-Anwendungen verstehen

ML-Anwendungen operieren mittels komplexer Algorithmen, die riesige Datensätze verarbeiten, autonome Vorhersagen treffen und sich kontinuierlich über Lernmechanismen anpassen. Im Gegensatz zu herkömmlichen Anwendungen schaffen ML-Systeme dynamische Angriffsflächen, bei denen Modellverhalten, Trainingsdaten und Inferenzprozesse jeweils einzigartige Sicherheitslücken aufweisen, die spezialisierte Schutzansätze erfordern.

Effektive ML-Sicherheit umfasst den Schutz von Datenpipelines, die Verifizierung der Modellintegrität, die Überwachung von Inferenzvorgängen und umfassende Audit-Funktionen, die speziell für Umgebungen des maschinellen Lernens entwickelt wurden.

Kritische Bedrohungsvektoren in der ML-Sicherheit

ML-Anwendungen stehen vor einzigartigen Sicherheitsherausforderungen, die spezialisierte Schutzstrategien erfordern:

- Vergiftung der Trainingsdaten: Böswilliges Einbringen von manipulierten Beispielen in Trainingsdatensätze, um das Modellverhalten zu beeinflussen und die Datenintegrität zu gefährden

- Modellentnahme-Angriffe: API-basierte Versuche, proprietäre Modelle zu rekonstruieren und geistiges Eigentum durch unbefugten Zugriff zu stehlen

- Adversarial Inference: Sorgfältig gestaltete Eingaben, die darauf abzielen, Vorhersagesysteme zu täuschen und sensible Informationen zu extrahieren

- Datenleck: Modellinversions- und Mitgliedschaftsinferenz-Angriffe, die Trainingsdaten durch Datenpannen offenlegen und Data-Discovery-Protokolle erfordern

Rahmenwerk für Sicherheitsimplementierung

Effektive ML-Sicherheit erfordert praxisnahe Validierungsansätze für Trainings- und Inferenzphasen:

Validierung der Sicherheit von Trainingsdaten

Die folgende Implementierung zeigt, wie die Integrität von Trainingsdaten validiert und statistische Anomalien erkannt werden, die auf Vergiftungsversuche hinweisen könnten. Dieser Validator vergleicht Daten-Hashes mit Basiswerten und überwacht ungewöhnliche statistische Eigenschaften, die auf böswillige Manipulationen hindeuten könnten.

import hashlib

import numpy as np

from datetime import datetime

class MLDataSecurityValidator:

def __init__(self):

self.anomaly_threshold = 2.0

self.integrity_baseline = {}

def validate_training_data(self, dataset, dataset_id):

"""Umfassende Sicherheitsüberprüfung für ML-Trainingsdaten"""

validation_result = {

'timestamp': datetime.utcnow().isoformat(),

'dataset_id': dataset_id,

'security_score': 100,

'threats_detected': [],

'recommendations': []

}

# Überprüfung der Datenintegrität

current_hash = hashlib.sha256(str(dataset).encode()).hexdigest()

baseline_hash = self.integrity_baseline.get(dataset_id)

if baseline_hash and current_hash != baseline_hash:

validation_result['threats_detected'].append({

'type': 'DATENMANIPULATION',

'severity': 'HIGH',

'description': 'Integrität des Datensatzes wurde beeinträchtigt'

})

validation_result['security_score'] -= 30

# Basiswert für zukünftige Vergleiche speichern

if not baseline_hash:

self.integrity_baseline[dataset_id] = current_hash

return validation_result

Sicherheitsmonitor für ML-Inferenz

Dieser Sicherheitsmonitor demonstriert den Echtzeitschutz für ML-Inferenzendpunkte. Er verfolgt die Anfragereihenfolge, um potenzielle Versuche der Modellentnahme zu erkennen, und identifiziert verdächtige Eingabemuster, die auf adversariale Angriffe hindeuten könnten.

class MLInferenceSecurityMonitor:

def __init__(self, model_name):

self.model_name = model_name

self.request_history = []

self.rate_limit_threshold = 100 # Anfragen pro Minute

def monitor_inference_request(self, user_id, input_data, prediction):

"""Echtzeit-Sicherheitsüberwachung für ML-Inferenzanfragen"""

security_assessment = {

'timestamp': datetime.utcnow().isoformat(),

'user_id': user_id,

'model_name': self.model_name,

'risk_level': 'LOW',

'security_flags': []

}

# Erkennung durch Ratenbegrenzung

recent_requests = len([r for r in self.request_history

if r['user_id'] == user_id and

(datetime.utcnow() - datetime.fromisoformat(r['timestamp'])).seconds < 60])

if recent_requests > self.rate_limit_threshold:

security_assessment['security_flags'].append({

'type': 'RATENLIMIT_ÜBERSCHRITTEN',

'severity': 'HIGH',

'description': 'Möglicher Versuch der Modellentnahme'

})

security_assessment['risk_level'] = 'HIGH'

return security_assessment

Best Practices für die Implementierung

Für Organisationen:

- Einführung einer ML-Sicherheitsgovernance: Aufbau spezialisierter ML-Sicherheitsteams mit umfassenden Sicherheitspolitiken und Abstimmung auf Compliance-Vorgaben

- Echtzeitüberwachung einsetzen: Implementierung von Datenbankaktivitätsüberwachung in ML-Pipelines in Kombination mit Nutzerverhaltensanalysen

- Sicherheitsdokumentation pflegen: Erstellung umfassender Audit-Trails mit optimierter Audit-Speicherung

- Regelmäßige Sicherheitsbewertungen: Durchführung periodischer Schwachstellenbewertungen und Sicherheitstests

Für technische Teams:

- Sicherung von ML-Pipelines: Implementierung von Datenbankverschlüsselung für Trainingsdaten unter Einsatz von Testdatenmanagement-Protokollen

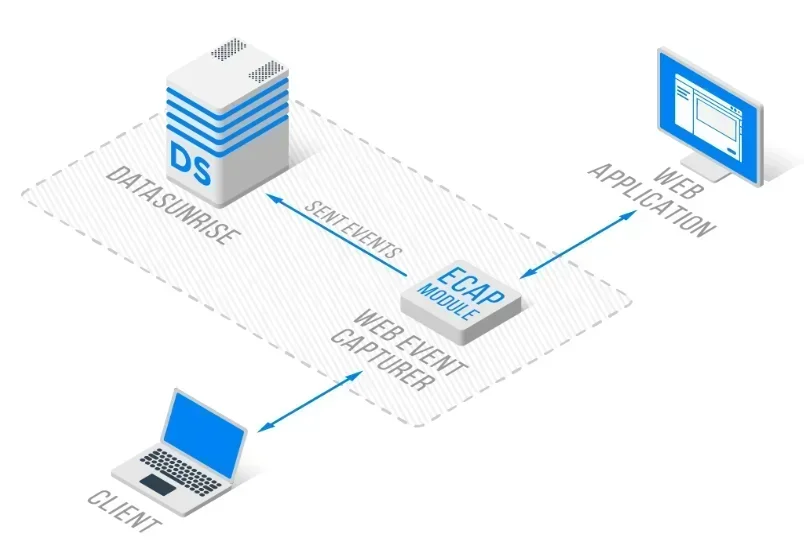

- Modellschutz: Einsatz von Zugriffskontrollen und Schutz des geistigen Eigentums mithilfe einer Reverse-Proxy-Architektur

- Echtzeit-Erkennung: Konfiguration automatisierter Bedrohungserkennung mit Datenbank-Firewall-Funktionalitäten

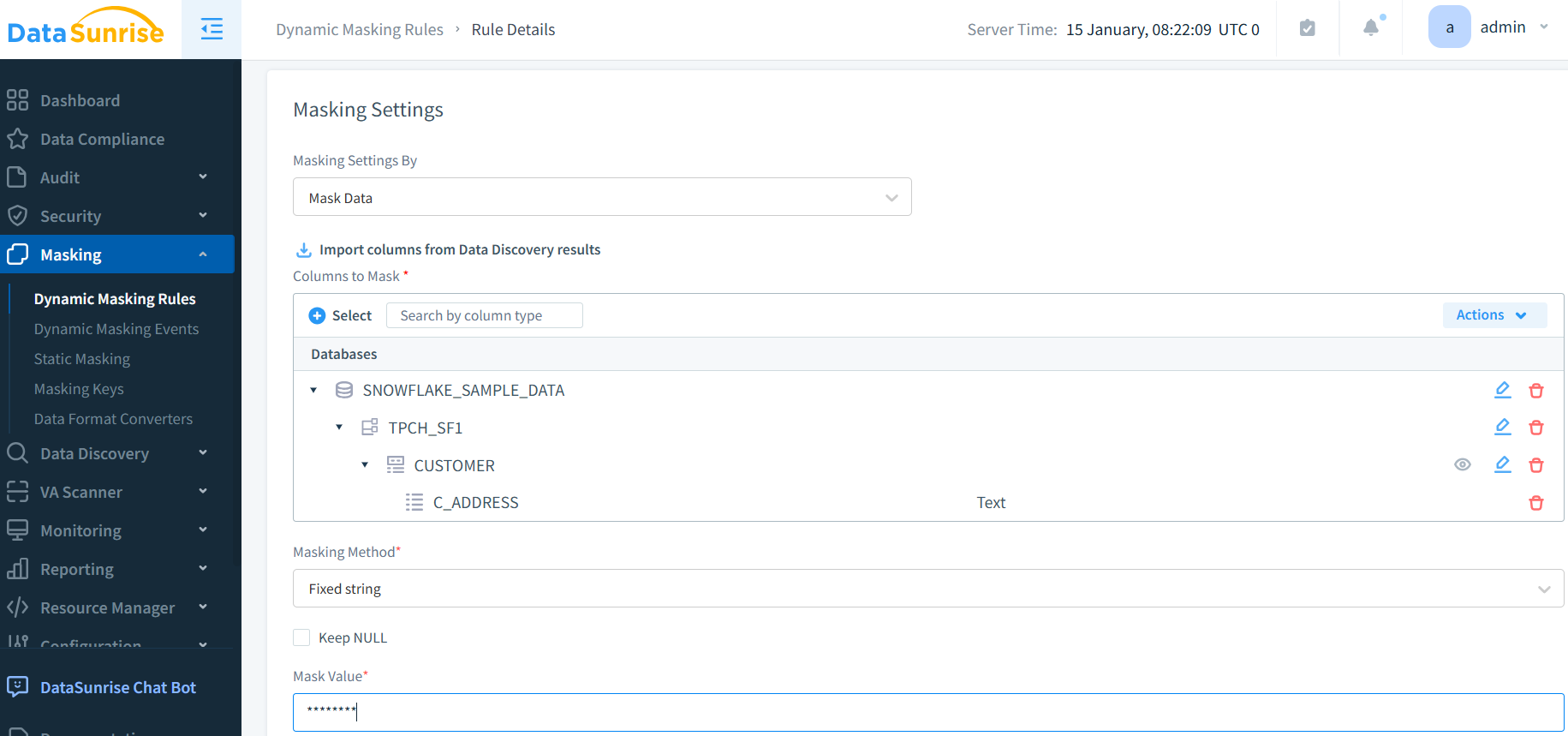

- Datenschutzmaßnahmen: Implementierung umfassender Datenmaskierung und synthetischer Datengenerierung

DataSunrise: Umfassende ML-Sicherheitslösung

DataSunrise bietet Sicherheitslösungen in Unternehmensqualität, die speziell für ML-Anwendungen entwickelt wurden. Unsere Plattform liefert maximale Sicherheit bei minimalem Risiko mit Echtzeit-ML-Schutz über alle wichtigen ML-Plattformen hinweg, einschließlich TensorFlow, PyTorch und cloudbasierter ML-Dienste.

Hauptmerkmale:

- Echtzeit-Überwachung der ML-Aktivitäten: Umfassende Nachverfolgung mit Audit-Logs für alle ML-Interaktionen

- Fortschrittliche Bedrohungserkennung: ML-gestützte Erkennung verdächtigen Verhaltens mit kontextsensitivem Schutz

- Dynamischer Datenschutz: Präzise Datenmaskierung zum Schutz personenbezogener Informationen in Trainingsdatensätzen

- Plattformübergreifende Abdeckung: Einheitliche Sicherheit über über 50 unterstützten Plattformen

- Automatisierung der Compliance: Automatisiertes Compliance-Reporting für bedeutende regulatorische Rahmenwerke

Die flexiblen Bereitstellungsmodi von DataSunrise unterstützen On-Premise-, Cloud- und hybride ML-Umgebungen mit Zero-Touch-Implementierung. Organisationen erzielen durch automatisierte Überwachung eine signifikante Reduktion von Sicherheitsvorfällen und einen verbesserten Modellschutz.

Fazit: Sichere Grundlagen für ML aufbauen

Sicherheitsanalysen aus ML-Anwendungen verdeutlichen die kritische Bedeutung umfassender Schutzkonzepte, die den einzigartigen Bedrohungen des maschinellen Lernens gerecht werden. Organisationen, die robuste ML-Sicherheitsstrategien implementieren, positionieren sich so, dass sie das transformationelle Potenzial von ML nutzen und gleichzeitig das Vertrauen der Stakeholder sowie die operative Widerstandsfähigkeit bewahren.

Da ML-Anwendungen zunehmend zum zentralen Bestandteil der Geschäftsabläufe werden, entwickelt sich die Sicherheit von einer optionalen Erweiterung zu einer essentiellen Geschäftsfähigkeit. Durch die Implementierung fortschrittlicher Sicherheitskonzepte mit automatisierter Überwachung können Organisationen ML-Innovationen selbstbewusst einsetzen und gleichzeitig ihre wertvollen Datenbestände schützen.

Schützen Sie Ihre Daten mit DataSunrise

Sichern Sie Ihre Daten auf jeder Ebene mit DataSunrise. Erkennen Sie Bedrohungen in Echtzeit mit Activity Monitoring, Data Masking und Database Firewall. Erzwingen Sie die Einhaltung von Datenstandards, entdecken Sie sensible Daten und schützen Sie Workloads über 50+ unterstützte Cloud-, On-Premise- und KI-System-Datenquellen-Integrationen.

Beginnen Sie noch heute, Ihre kritischen Daten zu schützen

Demo anfordern Jetzt herunterladen