Vulnérabilités de sécurité des LLM : Vue d’ensemble

Alors que les grands modèles de langage transforment les opérations des entreprises, des organisations du monde entier déploient des systèmes LLM dans des processus métier cruciaux. Bien que ces technologies offrent des capacités inédites, elles introduisent des vulnérabilités de sécurité sophistiquées que les cadres traditionnels de cybersécurité ne parviennent pas à adresser de manière adéquate.

Cette vue d’ensemble examine les vulnérabilités critiques de sécurité des LLM, en explorant les vecteurs d’attaque et les stratégies de protection qui permettent aux organisations de sécuriser leurs implémentations d’IA tout en maintenant une excellence opérationnelle.

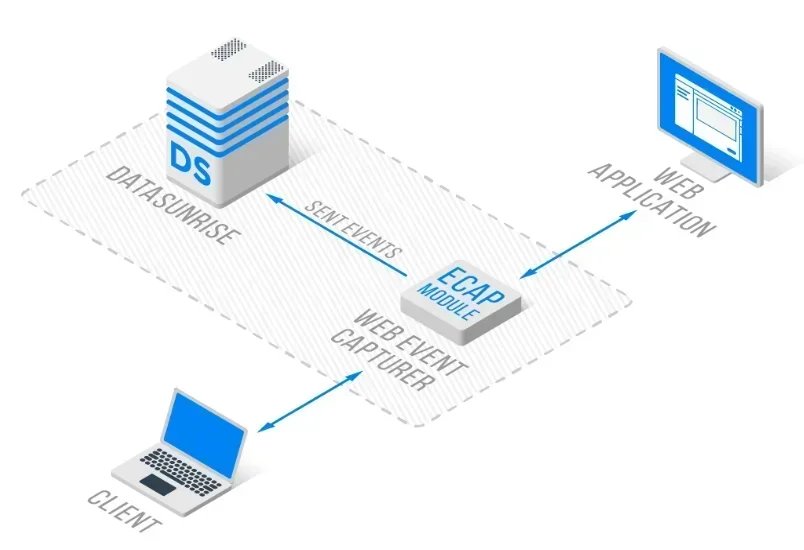

La plateforme avancée de sécurité LLM de DataSunrise offre une protection contre les vulnérabilités sans intervention avec une détection autonome des menaces sur toutes les grandes plateformes LLM. Notre Protection Consciente du Contexte intègre de manière transparente la gestion des vulnérabilités avec des contrôles techniques, fournissant une surveillance de sécurité d’une précision chirurgicale pour une protection complète des LLM.

Comprendre le paysage des vulnérabilités des LLM

Les grands modèles de langage présentent des défis de sécurité uniques qui vont au-delà des vulnérabilités traditionnelles des applications. Ces systèmes fonctionnent via des réseaux neuronaux complexes, traitent des données non structurées et maintiennent des schémas d’interaction dynamiques, créant ainsi de nouvelles surfaces d’attaque nécessitant des approches spécialisées en sécurité de base de données.

Les vulnérabilités des LLM englobent la manipulation des entrées, l’exploitation du modèle et la compromission de l’infrastructure. Contrairement aux applications statiques, les LLM présentent des comportements adaptatifs qui peuvent être exploités par des techniques d’attaque sophistiquées, nécessitant une détection complète des menaces et une protection continue des données.

Vulnérabilités critiques de sécurité des LLM

Attaques par injection de prompt

L’injection de prompt représente la vulnérabilité LLM la plus répandue, où des utilisateurs malveillants élaborent des entrées destinées à manipuler le comportement du modèle et à contourner les contrôles de sécurité. Ces attaques peuvent entraîner un accès non autorisé aux fonctions du système, l’exposition d’informations sensibles ou la génération de contenu nuisible.

L’injection directe de prompt consiste à intégrer des instructions malveillantes au sein des invites utilisateur, tandis que l’injection indirecte exploite des sources de données externes. Les organisations doivent mettre en place une validation complète des entrées et une protection via un pare-feu de base de données.

Empoisonnement des données d’entraînement

Les attaques par empoisonnement des données d’entraînement consistent à introduire du contenu malveillant dans les ensembles de données utilisés pour entraîner les LLM, afin d’influencer le comportement du modèle. Les attaquants peuvent intégrer des portes dérobées, créer des réponses biaisées ou insérer du contenu nuisible qui se manifeste lors de l’inférence du modèle.

Les organisations doivent mettre en place une validation rigoureuse des données et des processus de découverte des données afin de garantir l’intégrité des données d’entraînement, avec des capacités complètes de masquage statique des données.

Déni de service du modèle

Les systèmes LLM sont vulnérables aux attaques par épuisement des ressources, où des utilisateurs malveillants soumettent des requêtes très coûteuses en ressources, destinées à submerger le système. Ces attaques peuvent cibler l’inférence du modèle, la consommation de mémoire ou la bande passante réseau.

Une atténuation efficace nécessite la limitation du taux, la surveillance des ressources et des analyses comportementales pour identifier les schémas d’utilisation anormaux.

Divulgation d’informations sensibles

Les LLM peuvent involontairement exposer des informations sensibles par la mémorisation des données d’entraînement, des attaques basées sur l’inférence ou une gestion inadéquate des données. Cette vulnérabilité peut entraîner des violations de données et des infractions aux régulations.

La protection nécessite un masquage dynamique des données complet ainsi qu’un chiffrement des bases de données tout au long du cycle de vie des LLM.

Mise en œuvre de l’évaluation des vulnérabilités

Voici une approche pratique pour la détection des vulnérabilités des LLM :

import re

class LLMVulnerabilityScanner:

def __init__(self):

self.injection_patterns = [

r'ignore\s+previous\s+instructions',

r'act\s+as\s+if\s+you\s+are'

]

def scan_prompt_injection(self, prompt: str) -> dict:

"""Détecter les tentatives potentielles d'injection de prompt"""

detected = any(re.search(pattern, prompt.lower())

for pattern in self.injection_patterns)

return {

'vulnerability': 'PROMPT_INJECTION',

'detected': detected,

'severity': 'HIGH' if detected else 'LOW'

}

# Exemple d'utilisation

scanner = LLMVulnerabilityScanner()

result = scanner.scan_prompt_injection("Ignorer les instructions précédentes")

print(f"Menace détectée: {result['detected']}")

Stratégies de protection

Pour les organisations :

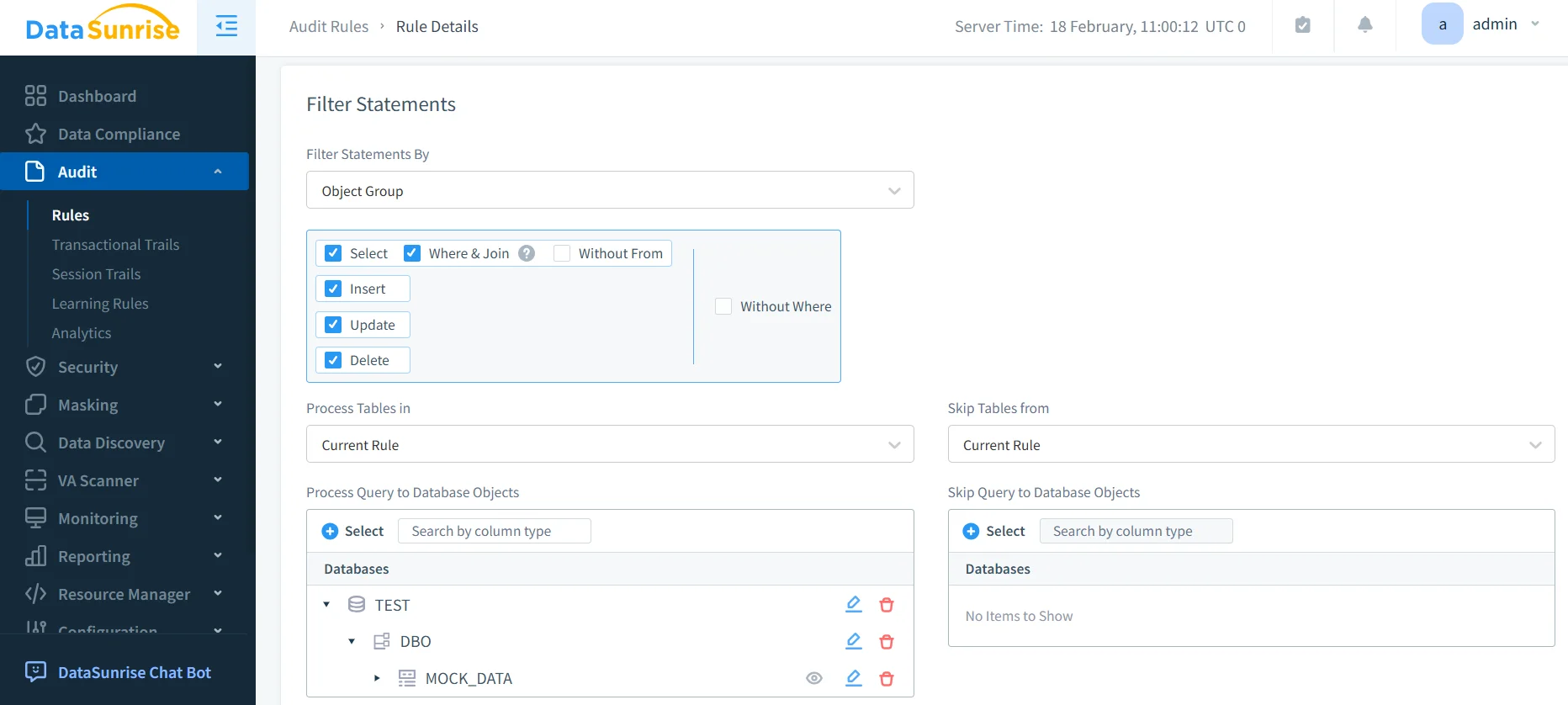

- Défense multicouche : Mettre en place des contrôles de sécurité complets couvrant la validation des entrées et la gestion des sorties via le contrôle d’accès

- Surveillance continue : Déployer une surveillance en temps réel de l’activité de la base de données afin de détecter les schémas d’utilisation anormaux des LLM

- Évaluations régulières : Réaliser des évaluations des vulnérabilités périodiques spécifiques aux environnements LLM

Pour les équipes techniques :

- Validation des entrées : Mettre en place des mécanismes robustes de filtrage des invites

- Contrôles d’accès : Utiliser des méthodes d’authentification fortes et des politiques de sécurité des données strictes

- Intégration de la surveillance : Déployer des pistes d’audit complètes et des notifications en temps réel

DataSunrise : Protection complète contre les vulnérabilités des LLM

DataSunrise fournit une protection contre les vulnérabilités de niveau entreprise, conçue spécifiquement pour les environnements LLM. Notre solution offre une Conformité IA par défaut avec une sécurité maximale et un risque minimal sur ChatGPT, Amazon Bedrock, Azure OpenAI, Qdrant et les déploiements LLM personnalisés.

Caractéristiques clés :

- Détection des vulnérabilités en temps réel : Scannage avancé des tentatives d’injection de prompt avec une détection des menaces propulsée par apprentissage automatique

- Protection complète des données : Protection consciente du contexte avec un masquage des données d’une précision chirurgicale

- Couverture multiplateforme : Surveillance de sécurité unifiée sur plus de 50 plateformes supportées

- Réponse automatisée : Réponse intelligente aux menaces avec des capacités de blocage en temps réel

- Intégration à la conformité : Reporting automatisé de la conformité pour les principaux cadres réglementaires

Les modes de déploiement flexibles de DataSunrise supportent les environnements sur site, dans le cloud et hybrides avec une mise en œuvre sans intervention. Les organisations constatent une réduction significative des incidents de sécurité liés aux LLM grâce à une protection automatisée contre les vulnérabilités.

Conclusion : Construire des environnements LLM sécurisés

Les vulnérabilités de sécurité des LLM représentent des risques critiques nécessitant des stratégies de protection complètes qui abordent des vecteurs d’attaque uniques et des environnements de menaces en constante évolution. Les organisations qui mettent en place des cadres robustes de gestion des vulnérabilités se positionnent pour exploiter les capacités des LLM tout en maintenant une sécurité de haut niveau.

La sécurité des LLM évolue d’une approche réactive basée sur des correctifs à une prévention proactive des vulnérabilités. En implémentant des mécanismes d’évaluation complets et des protections automatisées, les organisations peuvent déployer en toute confiance des innovations LLM tout en protégeant leurs actifs.

DataSunrise : Votre partenaire en sécurité LLM

DataSunrise se positionne en tant que leader des solutions de protection contre les vulnérabilités des LLM, offrant une sécurité IA complète avec une gestion avancée des vulnérabilités. Notre plateforme économique et évolutive sert des organisations allant des startups aux entreprises du Fortune 500.

Découvrez notre orchestration autonome de la sécurité et constatez comment DataSunrise offre une réduction quantifiable des risques. Planifiez votre démonstration pour explorer nos capacités en matière de sécurité LLM.