Considérations de sécurité des LLM

Alors que les grands modèles de langage révolutionnent les opérations commerciales, 78 % des organisations mettent en œuvre des solutions LLM dans des flux de travail critiques. Bien que ces systèmes offrent des capacités inédites, ils introduisent des défis de sécurité complexes que les cadres traditionnels de cybersécurité ne peuvent pas traiter de manière adéquate.

Ce guide examine les considérations essentielles de sécurité des LLM, explorant des vecteurs de menace uniques et des stratégies de mise en œuvre pour une protection complète contre l’évolution des risques cybernétiques.

La plateforme avancée de sécurité LLM de DataSunrise offre une sécurité IA sans intervention avec détection autonome des menaces sur toutes les grandes plateformes LLM. Notre protection contextuelle s’intègre parfaitement à l’infrastructure existante, fournissant une gestion de la sécurité d’une précision chirurgicale pour une protection complète des LLM.

Menaces critiques pour la sécurité des LLM

Les grands modèles de langage font face à des menaces de sécurité uniques qui nécessitent des approches de protection spécialisées :

Attaques par injection de commandes

Des utilisateurs malveillants élaborent des entrées conçues pour manipuler le comportement des LLM, pouvant entraîner un accès non autorisé aux fonctions du système, l’exposition d’informations sensibles ou la génération de contenu nuisible.

Empoisonnement des données d’entraînement

Les attaquants compromettent les ensembles de données d’entraînement pour influencer le comportement du modèle par l’insertion de contenu biaisé, la création de déclencheurs de porte dérobée ou l’introduction de vulnérabilités de sécurité.

Tentatives d’extraction de modèle

Des attaques sophistiquées tentent de reconstituer des modèles propriétaires par le biais de sondages via API, d’analyse de requêtes et de vol de propriété intellectuelle par réplication du modèle.

Risques de fuite de données

Les LLM peuvent involontairement exposer des informations sensibles par mémorisation des données d’entraînement, la superposition d’informations entre conversations ou la divulgation involontaire de données personnelles.

Cadre de mise en œuvre de la sécurité des LLM

Une sécurité efficace des LLM nécessite une protection multi-couches abordant la validation des entrées, la sécurité du traitement et le filtrage des sorties :

import re

from datetime import datetime

class LLMSecurityValidator:

def validate_prompt(self, prompt: str, user_id: str):

"""Valider la commande LLM pour détecter les menaces de sécurité"""

security_check = {

'user_id': user_id,

'threat_detected': False,

'risk_level': 'low'

}

# Détecter les tentatives d'injection

injection_keywords = ['ignore previous', 'forget instructions', 'act as']

if any(keyword in prompt.lower() for keyword in injection_keywords):

security_check['threat_detected'] = True

security_check['risk_level'] = 'high'

# Masquer les informations personnelles identifiables (PII) si détectées

if re.search(r'\b[A-Za-z0-9._%+-]+@[A-Za-z0-9.-]+\.[A-Z|a-z]{2,}\b', prompt):

prompt = re.sub(r'\b[A-Za-z0-9._%+-]+@[A-Za-z0-9.-]+\.[A-Z|a-z]{2,}\b',

'[EMAIL_MASKED]', prompt)

security_check['pii_detected'] = True

return security_check, prompt

Meilleures pratiques de sécurité

Pour les organisations :

- Défense multi-couches : Mettre en place des contrôles de sécurité complets aux niveaux de l’entrée, du traitement et de la sortie

- Architecture Zero Trust : Appliquer des contrôles d’accès et une authentification pour toutes les interactions avec les LLM

- Surveillance continue : Déployer une détection des menaces en temps réel et une analyse comportementale

- Gouvernance des données : Établir des politiques de sécurité des données claires pour la gestion des données sensibles, cliquez ici

Pour la mise en œuvre :

- Validation des entrées : Assainir et valider toutes les commandes avant le traitement

- Filtrage des sorties : Surveiller les réponses des LLM pour détecter les risques de fuite de données et l’exposition d’informations sensibles

- Limitation de la fréquence : Prévenir l’épuisement des ressources et les tentatives d’abus

- Journalisation des audits : Maintenir des journaux d’audit complets pour toutes les interactions

DataSunrise : Solution globale de sécurité des LLM

DataSunrise propose une sécurité LLM de niveau entreprise conçue spécifiquement pour les environnements de grands modèles de langage. Notre solution offre une orchestration de sécurité autonome avec détection des menaces en temps réel sur ChatGPT, Amazon Bedrock, Azure OpenAI et des déploiements LLM personnalisés.

Caractéristiques clés de sécurité :

- Détection avancée des menaces : Détection des comportements suspects alimentée par l’apprentissage automatique avec des capacités de réponse automatisée

- Masquage dynamique des données : Masquage chirurgical des données pour la protection des informations personnelles dans les commandes et les réponses

- Surveillance complète : Surveillance IA sans intervention avec suivi détaillé de l’activité

- Couverture multiplateforme : Protection par pare-feu de base de données sur plus de 50 plateformes supportées

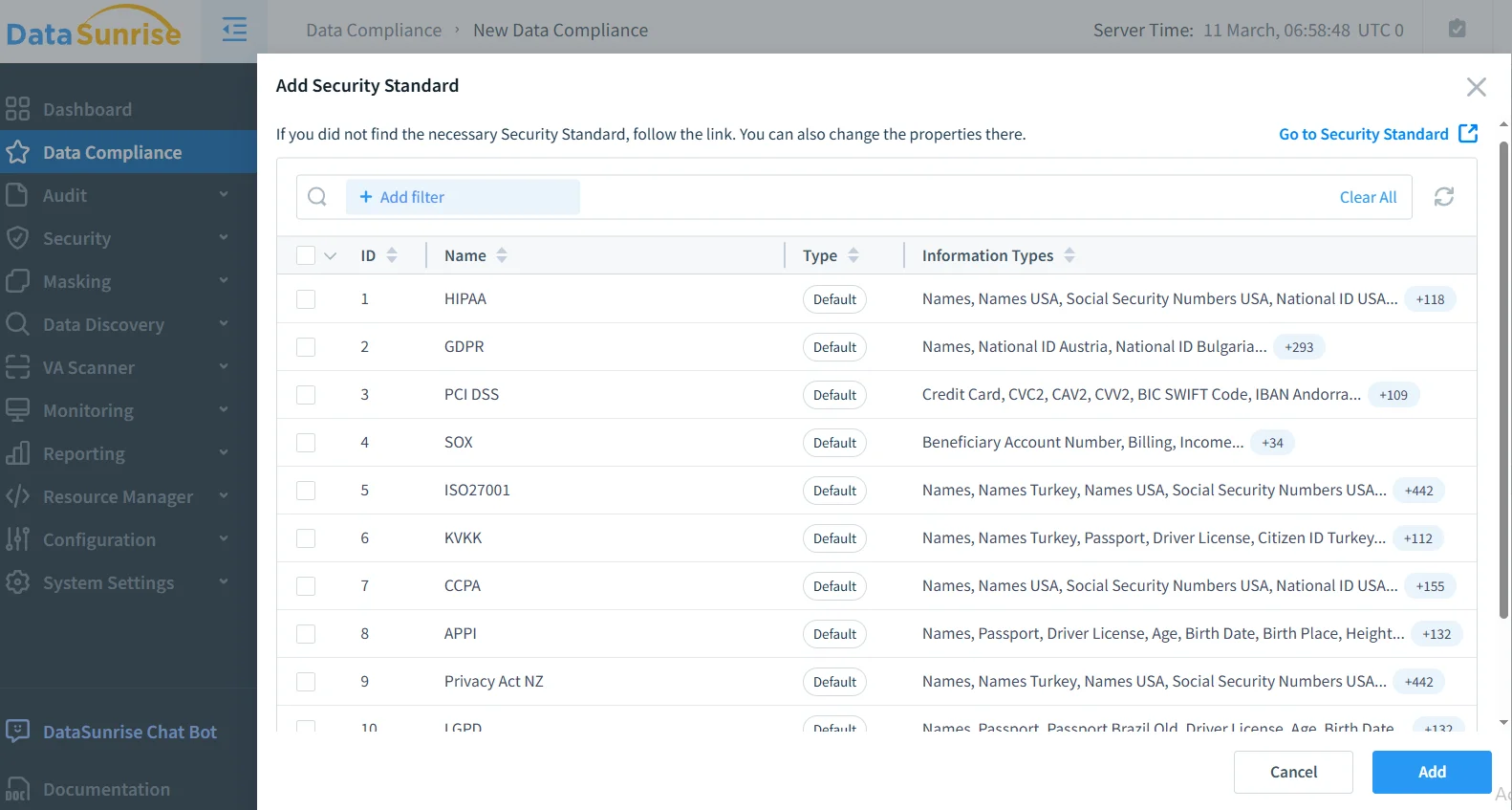

- Automatisation de la conformité : Reporting de conformité automatisé pour répondre aux exigences du GDPR, HIPAA, PCI DSS et SOX, en savoir plus

Les modes de déploiement flexibles de DataSunrise supportent les environnements sur site, cloud et hybrides sans complexité de configuration. Nos contrôles d’accès basés sur les rôles permettent un déploiement rapide avec une sécurité renforcée dès le premier jour.

Les organisations qui mettent en œuvre DataSunrise constatent une réduction de 85 % des incidents de sécurité, une meilleure visibilité sur les menaces et une amélioration de leur conformité grâce aux capacités de journalisation automatisée des audits.

Conformité réglementaire pour la sécurité des LLM

La sécurité des LLM doit répondre aux exigences réglementaires en constante évolution dans les principaux cadres :

- Conformité au RGPD : Garantir les droits des personnes concernées et la protection de la vie privée dans le traitement des LLM

- Exigences HIPAA : Protéger les informations de santé dans les applications LLM du secteur de la santé

- Normes PCI DSS : Sécuriser les données de paiement dans les systèmes financiers LLM

- Conformité SOX : Maintenir des contrôles internes pour les applications financières LLM

Conclusion : Sécuriser l’innovation des LLM

La sécurité des grands modèles de langage nécessite des approches complètes qui traitent des vecteurs de menaces uniques tout en permettant l’innovation. Les organisations qui mettent en œuvre des cadres de sécurité robustes pour les LLM se positionnent pour tirer parti du potentiel transformateur de l’IA tout en maintenant la confiance des parties prenantes et la conformité réglementaire.

Une sécurité efficace des LLM combine des contrôles techniques avec une gouvernance organisationnelle, créant des systèmes résilients capables de s’adapter aux menaces en constante évolution tout en apportant une valeur ajoutée à l’entreprise. À mesure que l’adoption des LLM s’accélère, la sécurité devient non seulement une exigence de conformité, mais aussi un avantage concurrentiel.

DataSunrise : Votre partenaire en sécurité des LLM

DataSunrise est un leader des solutions de sécurité pour les LLM, offrant une protection IA globale avec une détection avancée des menaces conçue pour les environnements LLM complexes. Notre plateforme économique et évolutive sert des organisations allant des startups aux entreprises du Fortune 500.

Découvrez notre orchestration de sécurité autonome et voyez comment DataSunrise offre une réduction quantifiable des risques pour les déploiements LLM. Planifiez votre démonstration pour explorer nos capacités en matière de sécurité des LLM.