Évaluation de la sécurité des modèles d’IA générative

L’IA générative est passée d’une curiosité de recherche à un outil essentiel pour l’entreprise. Qu’il s’agisse de créer du contenu marketing, d’alimenter des assistants virtuels ou de résumer des tickets clients, ces modèles ingèrent et traitent de grands volumes d’informations sensibles. Ce niveau d’accès nécessite une stratégie d’évaluation de la sécurité robuste, adaptée au comportement unique des systèmes d’IA générative.

Une évaluation de la sécurité appropriée pour les modèles d’IA générative ne se résume pas à sécuriser l’infrastructure. Il s’agit de surveiller la façon dont ces modèles interagissent avec les données, de garantir la conformité et d’adapter les contrôles afin de prévenir toute fuite accidentelle ou mauvaise utilisation d’informations sensibles.

Pourquoi les évaluations de sécurité pour l’IA générative sont importantes

Les systèmes d’IA générative peuvent mémoriser les données d’entraînement, produire des réponses inattendues et interagir avec les utilisateurs via le langage naturel, autant de défis de sécurité auxquels les systèmes traditionnels ne sont pas confrontés. Une seule requête pourrait extraire des informations propriétaires ou des données à caractère personnel, sauf si de solides mesures de protection des données sont en place.

Ils introduisent également des défis en matière de conformité. Si le modèle accède à des données réglementées (comme les informations de santé protégées ou des champs soumis aux normes PCI-DSS), cette interaction doit être suivie, masquée et auditée conformément à des cadres tels que les directives de conformité HIPAA ou le cadre RGPD. Pour une vue d’ensemble plus large sur les pratiques d’IA responsable, consultez le guide de Microsoft sur l’IA responsable.

Audit en temps réel des requêtes et réponses de l’IA générative

Les capacités d’audit en temps réel sont essentielles pour s’assurer que les systèmes d’IA générative ne fonctionnent pas comme des boîtes noires. Chaque requête et réponse générée doit être enregistrée avec des métadonnées contextuelles telles que le rôle de l’utilisateur, l’horodatage, l’adresse IP et le modèle utilisé. Ces journaux doivent être stockés de manière sécurisée et rendus interrogeables pour les contrôles de conformité et les analyses forensiques en cas de menace.

Voici un exemple simple de style SQL illustrant comment un audit des sorties d’une IA générative pourrait être structuré :

Pour en savoir plus, consultez cette référence sur la journalisation de DataSunrise.

Masquage dynamique dans les sorties de l’IA

Les modèles génératifs peuvent exposer involontairement des données sensibles via des complétions ou des réponses augmentées par la recherche. Pour atténuer ce risque, un masquage dynamique des données doit être appliqué à deux niveaux :

- Masquage pré-inférence, où l’entrée du modèle linguistique est masquée dynamiquement si elle contient des champs sensibles.

- Masquage post-inférence, où les sorties du modèle sont scannées et expurgées avant d’être transmises à l’utilisateur final.

Le masquage dynamique peut également s’appuyer sur un contrôle d’accès basé sur les rôles, garantissant que seuls les rôles autorisés voient les valeurs brutes. Par exemple, si un modèle récupère les quatre derniers chiffres du numéro de sécurité sociale d’un client :

Un concept complémentaire est l’application du principe du zéro confiance, expliqué dans cette vue d’ensemble de la architecture Zero Trust du NIST.

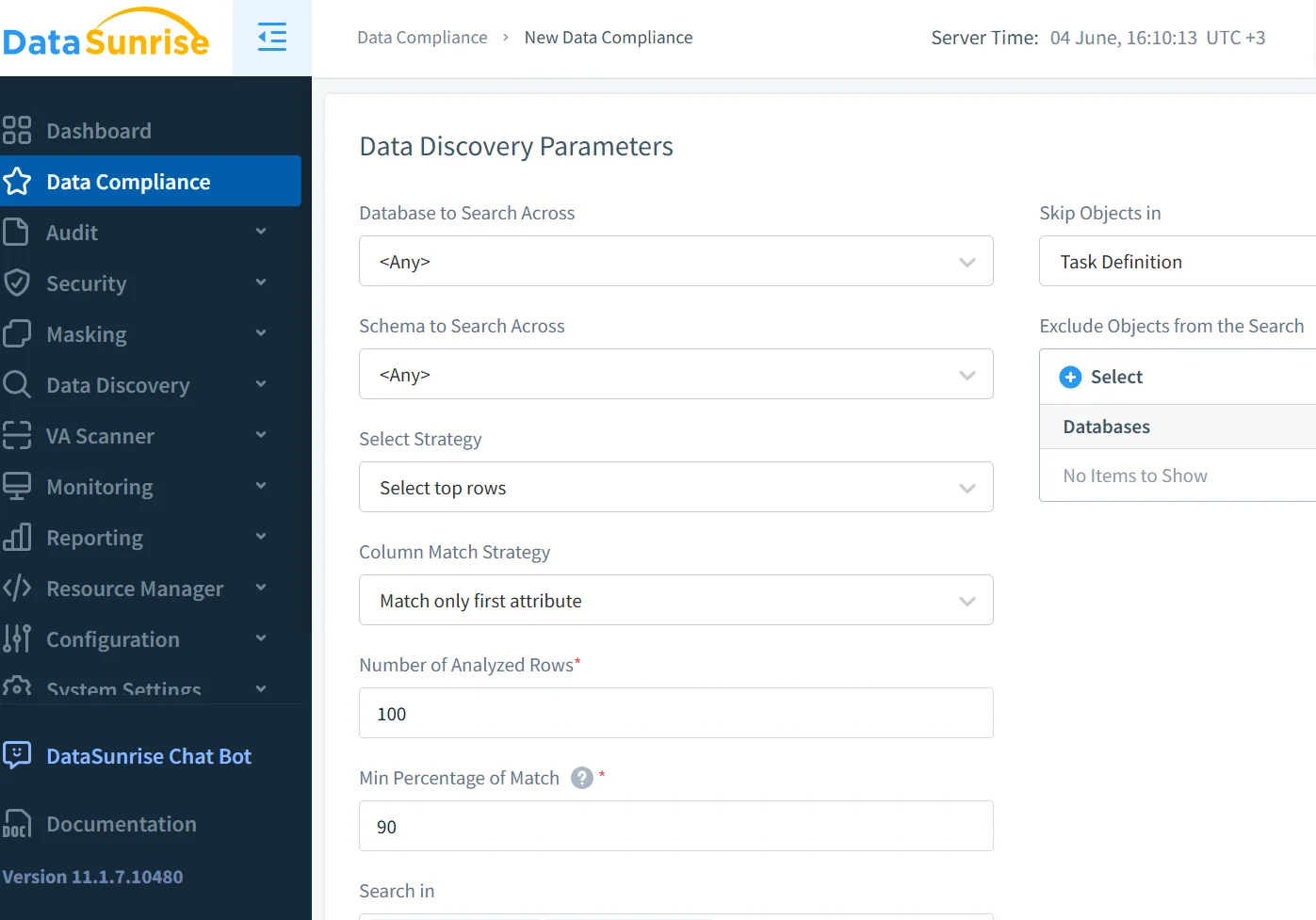

Découverte des données avant l’entraînement du modèle

Avant d’entraîner ou de peaufiner un modèle linguistique sur des jeux de données internes, les entreprises doivent classer et cartographier tous les champs qui pourraient contenir du contenu sensible. Intégrer des outils automatisés de découverte des données garantit une visibilité sur les sources structurées et semi-structurées.

Par exemple, le fait d’identifier les champs comme :

- Informations personnelles (par exemple, nom, e-mail, téléphone)

- Informations de santé (par exemple, antécédents médicaux)

- Informations bancaires (par exemple, numéro de carte)

… peut activer automatiquement des politiques de masquage et d’audit.

Lorsqu’elles sont combinées avec la surveillance de l’activité, ces mesures garantissent que le modèle n’ingère jamais de champs non suivis ou à haut risque.

Vous pouvez trouver des pratiques exemplaires supplémentaires en matière de classification des données dans le guide de gouvernance des données de Google Cloud.

Application des politiques de sécurité et de conformité pour l’IA générative

Pour aligner les déploiements de l’IA générative sur les politiques de l’entreprise, intégrez-les à une plateforme de sécurité des données capable de :

| Capacité de sécurité | Description |

|---|---|

| Surveillance de l’accès aux modèles | Journalisation en temps réel de qui accède à quoi et quand |

| Prévention des injections de requêtes et des abus | Filtres et garde-fous pour détecter ou bloquer les entrées suspectes |

| Rapports pour l’audit et la conformité | Génération de rapports structurés prêts pour la conformité |

| Classification des champs et tokenisation | Identification et protection automatique des champs sensibles |

Des outils tels que le DataSunrise Compliance Manager automatisent une grande partie de cet effort.

Vous pouvez également consulter le document d’IBM sur les principes de gouvernance de l’IA pour obtenir des conseils opérationnels plus larges.

Exemple : Bloquer l’accès de l’IA aux champs financiers

Supposons que votre modèle génératif interroge une base de données PostgreSQL pour obtenir des dossiers financiers. Vous pouvez restreindre les requêtes de l’IA afin qu’elles n’accèdent jamais à des colonnes telles que salary ou card_number en utilisant une politique de masquage :

De tels contrôles sont essentiels pour respecter les exigences internes de conformité des données.

Menaces modernes dans la sécurité de l’IA générative

Les systèmes d’IA font face à de nouvelles classes de menaces :

- Injection de prompt : Les utilisateurs incitent le modèle à révéler des données

- Fuite d’entraînement : Les données sensibles sont mémorisées durant le finetuning

- Accès fantôme : Des requêtes non autorisées exécutées via des wrappers d’IA

La prévention de ces menaces nécessite des analyses comportementales, une limitation du taux de requêtes et des modèles de détection spécialement ajustés pour les contextes de l’IA générative. Des techniques telles que l’analyse du comportement des utilisateurs aident à identifier les anomalies au sein des sessions utilisateurs.

Pour approfondir, reportez-vous au Top 10 OWASP pour les applications de grands modèles de langage et aux recommandations d’OpenAI sur les meilleures pratiques de sécurité.

Réflexions finales

Une évaluation de sécurité moderne pour les modèles d’IA générative doit aller bien au-delà des contrôles statiques. Elle exige une protection dynamique, une observabilité en temps réel et une application contextuelle des politiques. Avec les bons outils – de la découverte des données au masquage en passant par les pistes d’audit – les organisations peuvent développer l’usage de l’IA générative en toute sécurité sans compromettre la confiance ni la conformité.

Découvrez comment les fonctionnalités de sécurité de l’IA générative de DataSunrise soutiennent une adoption de l’IA sécurisée et conforme à grande échelle.