Attaques Cybernétiques IA

Alors que l’intelligence artificielle révolutionne les opérations d’entreprise, 91 % des organisations déploient des systèmes IA dans des flux de travail critiques. Bien que ces technologies offrent des capacités transformatrices, elles font face à des menaces d’attaques cybernétiques sans précédent que les cadres traditionnels de sécurité ne peuvent traiter adéquatement.

Ce guide examine les vecteurs émergents d’attaques cybernétiques IA, explorant des stratégies de défense complètes permettant aux organisations de protéger leurs investissements en IA tout en maintenant l’excellence opérationnelle et la sécurité des données.

La plateforme de sécurité IA de pointe de DataSunrise offre une Protection Zero-Touch contre les menaces avec Détection autonome des attaques sur toutes les principales plateformes IA. Notre Protection Contextuelle intègre parfaitement la défense cyber aux contrôles techniques, fournissant une atténuation d’attaque d’une Précision Chirurgicale pour une protection complète des systèmes IA.

Vecteurs Critiques d’Attaques Cybernétiques IA

Les systèmes IA font face à des menaces de sécurité uniques nécessitant des approches de protection spécialisées :

Attaques par Injection de Prompt

Les adversaires élaborent des entrées malveillantes conçues pour contourner les instructions système et manipuler le comportement de l’IA, pouvant entraîner un accès non autorisé aux fonctions système, l’exposition d’informations sensibles ou une escalade de privilèges. Les techniques avancées incluent l’injection indirecte via du contenu tiers et les attaques multi-étapes qui échappent à la détection, similaires aux vulnérabilités d’injection SQL dans les systèmes traditionnels.

Empoisonnement des Données d’Entraînement

Les attaquants compromettent les ensembles de données d’entraînement pour influencer le comportement du modèle via l’insertion de contenu biaisé, la création de déclencheurs de porte dérobée ou l’introduction de vulnérabilités de sécurité. Ces attaques compromettent les systèmes IA à leur base, nécessitant un réentraînement complet pour y remédier ainsi qu’un chiffrement complet des bases de données pour protéger les référentiels de données d’entraînement.

Extraction de Modèle et Vol de Propriété Intellectuelle

Les adversaires sophistiqués tentent de reconstruire des modèles propriétaires via un sondage systématique des API et l’analyse des requêtes. Les attaques par extraction de modèle menacent les avantages compétitifs et les investissements en propriété intellectuelle, nécessitant des traces d’audit complètes et des analyses comportementales pour détecter des schémas de requêtes inhabituels.

Exemples Adversariaux

Les attaquants créent des entrées spécifiquement conçues pour forcer les systèmes IA à mal classifier des données ou prendre de mauvaises décisions. Les exemples adversariaux exploitent les propriétés mathématiques des réseaux neuronaux pour créer des perturbations imperceptibles qui modifient drastiquement les sorties des modèles. Les organisations doivent mettre en œuvre des règles de sécurité robustes pour détecter et bloquer ces schémas d’attaques sophistiqués.

Implémentation de la Détection d’Attaques IA

La détection des attaques par injection de prompt nécessite une analyse en temps réel des entrées utilisateur combinée avec une correspondance de motifs et une surveillance comportementale. Les organisations doivent exploiter les capacités de découverte des données pour identifier les informations sensibles au sein des interactions IA. L’implémentation suivante montre comment identifier les prompts malveillants tentant de manipuler les systèmes IA :

import re

from datetime import datetime

class AIAttackDetector:

def __init__(self):

self.injection_patterns = [

r'ignore\s+previous\s+instructions',

r'disregard\s+all\s+prior\s+commands',

r'act\s+as\s+if\s+you\s+are\s+administrator'

]

def detect_prompt_injection(self, prompt: str, user_id: str):

"""Détecter en temps réel les tentatives d’injection de prompt"""

detection_result = {

'user_id': user_id,

'threat_level': 'LOW',

'attack_detected': False

}

# Vérifier les motifs d’injection connus

for pattern in self.injection_patterns:

if re.search(pattern, prompt, re.IGNORECASE):

detection_result['attack_detected'] = True

detection_result['threat_level'] = 'HIGH'

break

return detection_result

Surveillance de l’Intégrité du Modèle

Surveiller l’intégrité d’un modèle IA nécessite une comparaison continue des métriques de performance actuelles par rapport aux références établies afin de détecter l’empoisonnement des données d’entraînement. Une évaluation régulière des vulnérabilités aide à identifier les faiblesses avant qu’elles soient exploitées par les attaquants. Cette implémentation suit les écarts de performances pouvant indiquer des modèles compromis :

class AIModelIntegrityMonitor:

def __init__(self, baseline_metrics):

self.baseline_metrics = baseline_metrics

self.alert_threshold = 0.15

def detect_model_poisoning(self, current_performance: dict):

"""Surveiller les signes d’empoisonnement des données d’entraînement"""

integrity_assessment = {

'poisoning_detected': False,

'anomalies': []

}

# Comparer la performance avec la référence

for metric, baseline_value in self.baseline_metrics.items():

current_value = current_performance.get(metric, 0)

deviation = abs(current_value - baseline_value) / max(baseline_value, 0.001)

if deviation > self.alert_threshold:

integrity_assessment['anomalies'].append({

'metric': metric,

'deviation': deviation

})

integrity_assessment['poisoning_detected'] = True

return integrity_assessment

Stratégie d’Implémentation de la Défense

Pour les Organisations :

- Sécurité Multi-Couches : Mettre en œuvre des stratégies de défense en profondeur avec un contrôle d’accès basé sur les rôles

- Surveillance Continue : Déployer une surveillance en temps réel pour la détection des attaques

- Réponse aux Incidents : Établir des procédures de réponse spécifiques à l’IA avec l’automatisation de la mitigation des menaces

- Gestion de la Conformité : Utiliser des outils de gestion de conformité pour maintenir l’adhérence réglementaire

Pour les Équipes Techniques :

- Assainissement des Entrées : Mettre en œuvre une validation rigoureuse avec masquage dynamique des données et masquage statique pour les données sensibles

- Limitation de Taux : Prévenir l’extraction de modèles grâce à une limitation intelligente des requêtes

- Journalisation d’Audit : Maintenir des traces d’audit complètes avec une optimisation du stockage d’audit

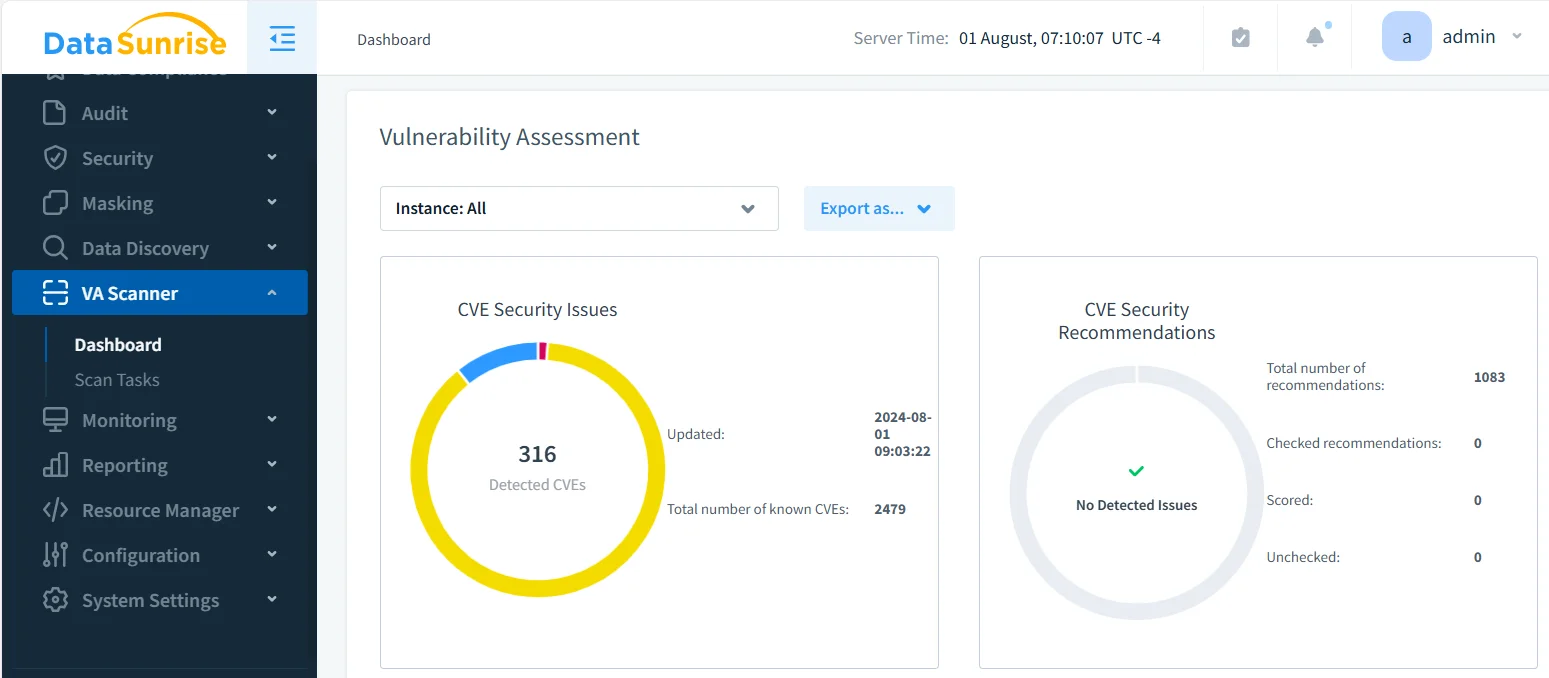

DataSunrise : Défense Complète Contre les Attaques Cybernétiques IA

DataSunrise offre une protection cyber d’entreprise spécifiquement conçue pour les environnements IA. Notre solution fournit une Détection Autonome des Menaces avec une Atténuation des Attaques en Temps Réel sur ChatGPT, Amazon Bedrock, Azure OpenAI, Qdrant et les déploiements IA personnalisés, garantissant la conformité IA par défaut.

Principales Capacités de Défense :

- Détection de Menaces Alimentée par ML : Protection Contextuelle avec détection de comportements suspects sur toutes les interactions IA utilisant des outils LLM et ML avancés

- Prévention de l’Injection de Prompt : Surveillance IA Zero-Touch avec reconnaissance automatisée des schémas d’attaque

- Protection de l’Intégrité du Modèle : Surveillance continue des tentatives d’empoisonnement des données d’entraînement

- Couverture Multi-Plateforme : Sécurité unifiée sur plus de 50 plateformes supportées avec une protection indépendante des fournisseurs

- Réponse Automatisée : Alignement réglementaire en temps réel avec notification immédiate des menaces

Les modes de déploiement flexibles de DataSunrise supportent les environnements IA sur site, cloud et hybrides avec une intégration transparente. Les organisations obtiennent une réduction significative des attaques IA réussies, une meilleure visibilité des menaces via des journaux d’audit complets et une gestion simplifiée de la sécurité grâce à l’automatisation des politiques sans code. Notre pare-feu de base de données apporte des couches supplémentaires de protection contre les accès non autorisés.

Contrairement aux solutions nécessitant un réglage constant des règles, DataSunrise offre une Orchestration Autonome de la Conformité avec une Calibration Réglementaire Continue. Notre plateforme scalable et économique sert les organisations depuis les startups jusqu’aux entreprises du Fortune 500 avec une politique tarifaire flexible.

Conclusion : Construire une Sécurité IA Résiliente

Les attaques cybernétiques contre l’IA représentent des menaces sophistiquées nécessitant des stratégies de défense complètes abordant les vulnérabilités uniques des systèmes IA. Les organisations qui mettent en place des cadres robustes de sécurité IA se positionnent pour exploiter le potentiel transformateur de l’IA tout en maintenant une protection contre les menaces évolutives.

En mettant en œuvre des cadres de défense avancés avec une surveillance automatisée et une détection intelligente des menaces, les organisations peuvent déployer en toute confiance les innovations IA tout en protégeant leurs actifs les plus précieux. L’avenir appartient aux organisations qui maîtrisent à la fois l’innovation IA et la cybersécurité complète grâce à la protection continue des données.

Protégez vos données avec DataSunrise

Sécurisez vos données à chaque niveau avec DataSunrise. Détectez les menaces en temps réel grâce à la surveillance des activités, au masquage des données et au pare-feu de base de données. Appliquez la conformité des données, découvrez les données sensibles et protégez les charges de travail via plus de 50 intégrations supportées pour le cloud, sur site et les systèmes de données basés sur l'IA.

Commencez à protéger vos données critiques dès aujourd’hui

Demander une démo Télécharger maintenant