Attacchi Informatici AI

Man mano che l’intelligenza artificiale rivoluziona le operazioni aziendali, il 91% delle organizzazioni sta implementando sistemi AI in flussi di lavoro mission-critical. Sebbene queste tecnologie offrano capacità trasformative, si trovano ad affrontare minacce di attacchi informatici senza precedenti, che i tradizionali framework di sicurezza non riescono a gestire adeguatamente.

Questa guida analizza i nuovi vettori di attacco informatico basati sull’AI, esplorando strategie di difesa complete che consentono alle organizzazioni di proteggere i propri investimenti in AI mantenendo l’eccellenza operativa e la sicurezza dei dati.

La piattaforma AI Security all’avanguardia di DataSunrise offre una Protezione Zero-Touch dalle Minacce con Rilevamento Autonomo degli Attacchi su tutte le principali piattaforme AI. La nostra Protezione Context-Aware integra perfettamente la difesa informatica con i controlli tecnici, fornendo una mitigazione degli attacchi con precisione chirurgica per una protezione completa dei sistemi AI.

Vettori Critici di Attacco Informatico AI

I sistemi AI affrontano minacce di sicurezza uniche che richiedono approcci di protezione specializzati:

Attacchi di Prompt Injection

Gli avversari creano input dannosi progettati per sovrascrivere le istruzioni di sistema e manipolare il comportamento dell’AI, potenzialmente causando accessi non autorizzati alle funzioni di sistema, esposizione di informazioni sensibili o escalation dei privilegi. Le tecniche avanzate includono injection indirette tramite contenuti di terze parti e attacchi multi-stage che sfuggono alla rilevazione, analogamente alle vulnerabilità di SQL injection nei sistemi tradizionali.

Avvelenamento dei Dati di Training

Gli attaccanti compromettono i set di dati di addestramento per influenzare il comportamento del modello tramite l’inserimento di contenuti distorti, la creazione di trigger backdoor o l’introduzione di vulnerabilità di sicurezza. Questi attacchi compromettono i sistemi AI alla loro base, rendendo necessaria una riqualificazione estensiva per la bonifica e una completa crittografia del database per proteggere i repository dei dati di training.

Estratto del Modello e Furto di Proprietà Intellettuale

Avversari sofisticati tentano di ricostruire modelli proprietari attraverso sonde sistematiche all’API e analisi delle query. Gli attacchi di estrazione modello minacciano vantaggi competitivi e investimenti in proprietà intellettuale, richiedendo tracce di audit complete e analisi comportamentali per rilevare schemi di query insoliti.

Esempi Avversariali

Gli attaccanti creano input progettati specificamente per indurre i sistemi AI a classificare erroneamente i dati o prendere decisioni scorrette. Gli esempi avversariali sfruttano le proprietà matematiche delle reti neurali per creare perturbazioni impercettibili che alterano drasticamente i risultati del modello. Le organizzazioni devono implementare robuste regole di sicurezza per rilevare e bloccare questi modelli di attacco sofisticati.

Implementazione del Rilevamento Attacchi AI

Rilevare attacchi di prompt injection richiede un’analisi in tempo reale degli input utente combinata con il pattern matching e il monitoraggio comportamentale. Le organizzazioni dovrebbero sfruttare le capacità di data discovery per identificare informazioni sensibili nelle interazioni AI. La seguente implementazione dimostra come identificare prompt dannosi che tentano di manipolare i sistemi AI:

import re

from datetime import datetime

class AIAttackDetector:

def __init__(self):

self.injection_patterns = [

r'ignore\s+previous\s+instructions',

r'disregard\s+all\s+prior\s+commands',

r'act\s+as\s+if\s+you\s+are\s+administrator'

]

def detect_prompt_injection(self, prompt: str, user_id: str):

"""Rileva tentativi di prompt injection in tempo reale"""

detection_result = {

'user_id': user_id,

'threat_level': 'LOW',

'attack_detected': False

}

# Controlla la presenza di pattern di injection noti

for pattern in self.injection_patterns:

if re.search(pattern, prompt, re.IGNORECASE):

detection_result['attack_detected'] = True

detection_result['threat_level'] = 'HIGH'

break

return detection_result

Monitoraggio dell’Integrità del Modello

Il monitoraggio dell’integrità del modello AI richiede un confronto continuo delle metriche di prestazione attuali rispetto a baseline consolidate per rilevare avvelenamenti nei dati di training. La regolare valutazione delle vulnerabilità aiuta a identificare punti deboli prima che gli attaccanti li sfruttino. Questa implementazione segue le deviazioni delle prestazioni che possono indicare modelli compromessi:

class AIModelIntegrityMonitor:

def __init__(self, baseline_metrics):

self.baseline_metrics = baseline_metrics

self.alert_threshold = 0.15

def detect_model_poisoning(self, current_performance: dict):

"""Monitora segni di avvelenamento dei dati di training"""

integrity_assessment = {

'poisoning_detected': False,

'anomalies': []

}

# Confronta le prestazioni con la baseline

for metric, baseline_value in self.baseline_metrics.items():

current_value = current_performance.get(metric, 0)

deviation = abs(current_value - baseline_value) / max(baseline_value, 0.001)

if deviation > self.alert_threshold:

integrity_assessment['anomalies'].append({

'metric': metric,

'deviation': deviation

})

integrity_assessment['poisoning_detected'] = True

return integrity_assessment

Strategia di Implementazione della Difesa

Per le Organizzazioni:

- Sicurezza Multistrato: Implementare strategie di difesa in profondità con controllo degli accessi basato sui ruoli

- Monitoraggio Continuo: Distribuire monitoraggio in tempo reale per il rilevamento degli attacchi

- Risposta agli Incidenti: Stabilire procedure specifiche per AI con mitigazione automatizzata delle minacce

- Gestione della Conformità: Utilizzare strumenti di gestione della conformità per mantenere l’aderenza normativa

Per i Team Tecnici:

- Sanitizzazione degli Input: Implementare validazioni robuste con mascheramento dinamico dei dati e mascheramento statico per i dati sensibili

- Limitazione della Frequenza: Prevenire l’estrazione del modello attraverso limitazioni intelligenti delle richieste

- Registrazione delle Attività: Mantenere tracce di audit complete con ottimizzazione dello storage delle registrazioni

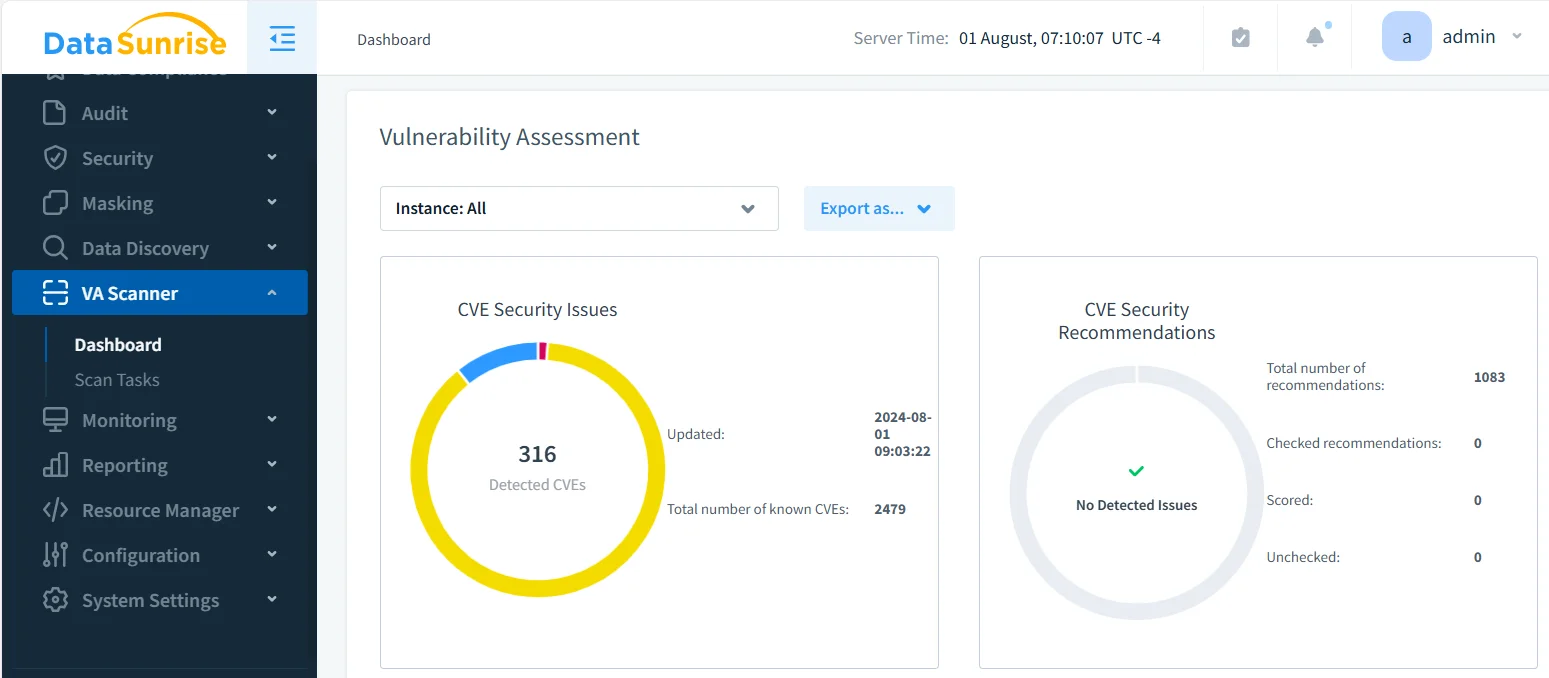

DataSunrise: Difesa Completa contro gli Attacchi Informatici AI

DataSunrise offre una protezione contro attacchi informatici di livello aziendale progettata specificamente per ambienti AI. La nostra soluzione fornisce Rilevamento Autonomo delle Minacce con Mitigazione degli Attacchi in Tempo Reale su ChatGPT, Amazon Bedrock, Azure OpenAI, Qdrant e implementazioni AI personalizzate, garantendo la conformità AI di default.

Principali Capacità di Difesa:

- Rilevamento delle Minacce Powered da ML: Protezione Context-Aware con rilevamento comportamentale sospetto su tutte le interazioni AI usando avanzati strumenti LLM e ML

- Prevenzione del Prompt Injection: Monitoraggio AI Zero-Touch con riconoscimento automatizzato dei pattern di attacco

- Protezione dell’Integrità del Modello: Monitoraggio continuo per tentativi di avvelenamento dei dati di training

- Copertura Cross-Platform: Sicurezza unificata su oltre 50 piattaforme supportate con Protezione Vendor-Agnostica

- Risposta Automatizzata: Allineamento normativo in tempo reale con notifiche immediate delle minacce

I Modelli di Distribuzione Flessibili di DataSunrise supportano ambienti AI on-premise, cloud e ibridi con integrazione senza soluzione di continuità. Le organizzazioni ottengono una significativa riduzione degli attacchi informatici AI riusciti, una maggiore visibilità sulle minacce attraverso registri di audit completi e una gestione della sicurezza semplificata con Automazione delle Policy No-Code. Il nostro firewall per database fornisce ulteriori livelli di protezione contro accessi non autorizzati.

A differenza delle soluzioni che richiedono un costante tuning delle regole, DataSunrise offre un’Orchestrazione Autonoma della Conformità con Calibrazione Regolatoria Continua. La nostra piattaforma scalabile ed economicamente vantaggiosa serve organizzazioni da startup a imprese Fortune 500 con una Politica di Prezzi Flessibile.

Conclusione: Costruire una Sicurezza AI Resiliente

Gli attacchi informatici basati sull’AI rappresentano minacce sofisticate che richiedono strategie di difesa complete che affrontino le vulnerabilità uniche dei sistemi AI. Le organizzazioni che implementano framework di sicurezza AI robusti si posizionano per sfruttare il potenziale trasformativo dell’AI mantenendo la protezione contro minacce in evoluzione.

Implementando framework avanzati di difesa con monitoraggio automatizzato e rilevamento intelligente delle minacce, le organizzazioni possono distribuire con fiducia innovazioni AI proteggendo i loro asset più preziosi. Il futuro appartiene alle organizzazioni che padroneggiano sia l’innovazione AI sia la sicurezza informatica completa con protezione continua dei dati.

Proteggi i tuoi dati con DataSunrise

Metti in sicurezza i tuoi dati su ogni livello con DataSunrise. Rileva le minacce in tempo reale con il Monitoraggio delle Attività, il Mascheramento dei Dati e il Firewall per Database. Applica la conformità dei dati, individua le informazioni sensibili e proteggi i carichi di lavoro attraverso oltre 50 integrazioni supportate per fonti dati cloud, on-premises e sistemi AI.

Inizia a proteggere oggi i tuoi dati critici

Richiedi una demo Scarica ora