Sicurezza vs Sicurezza dei LLM

I Large Language Models (LLM) stanno trasformando lo sviluppo software, l’educazione e l’analisi. Tuttavia, la fretta di implementarli ha scatenato un dibattito crescente: sicurezza vs sicurezza dei LLM — e quale tra le due è più importante.

I due concetti spesso si sovrappongono ma rappresentano sfide molto diverse nell’implementazione responsabile dell’AI.

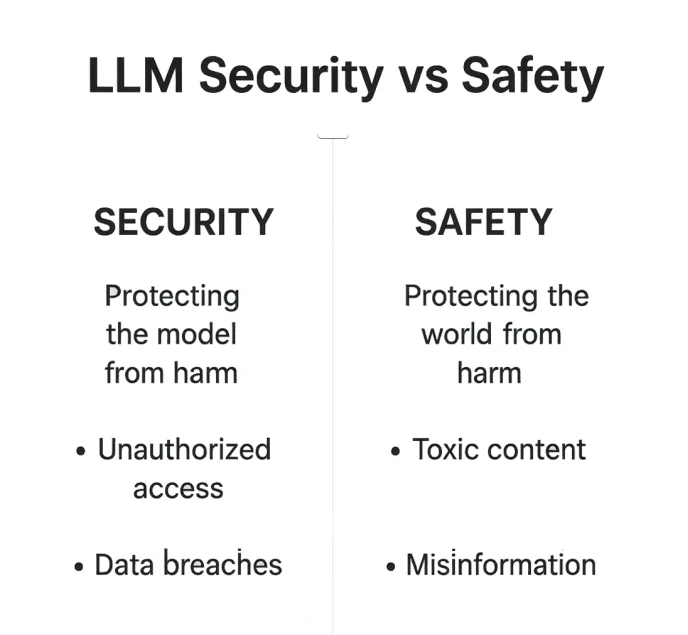

Sicurezza vs Sicurezza dei LLM: Comprendere la Differenza

Quando si parla di proteggere i Large Language Models, spesso si usano sicurezza e sicurezza in modo intercambiabile — ma operano su livelli molto diversi dell’ecosistema AI.

La sicurezza dei LLM riguarda il rafforzamento dell’ambiente del modello: proteggere database, punti di accesso e API da sfruttamenti. Nel frattempo, la sicurezza dei LLM si concentra su cosa dice il modello — assicurandosi che le sue risposte restino etiche, fattuali e entro limiti accettabili.

La sicurezza è una battaglia contro manipolazioni esterne. La sicurezza è una salvaguardia contro disallineamenti interni. In pratica, entrambi si sovrappongono. Un modello compromesso può produrre output non sicuri, e un modello non sicuro può diventare un rischio di sicurezza tramite ingegneria sociale o fughe di dati. Comprendere le sfumature tra queste due dimensioni è fondamentale per costruire sistemi AI affidabili e resilienti.

| Aspetto | Sicurezza dei LLM | Sicurezza dei LLM |

|---|---|---|

| Focus | Proteggere infrastrutture, dati e modelli da accessi non autorizzati | Prevenire output dannosi, distorti o non etici |

| Minacce | Attacchi di injection, accesso non autorizzato, violazioni di dati | Contenuti tossici, disinformazione, violazioni etiche |

| Obiettivo | Mantenere il modello e i dati sicuri | Mantenere gli output sicuri e allineati |

| Esempio | Prevenzione dell’iniezione SQL | Filtraggio contenuti RLHF |

Insieme formano la spina dorsale di un’implementazione responsabile dell’AI — dove la protezione tecnica garantisce fiducia, e l’allineamento etico garantisce responsabilità.

1. Cosa Significa Sicurezza nei LLM

La sicurezza dei LLM si concentra sulla protezione di infrastrutture, modelli e pipeline di dati da accessi o manipolazioni non autorizzate.

È lo scudo tecnico che protegge dati riservati, proprietà intellettuale e integrità del sistema — la barriera silenziosa tra un’operazione sicura e una catastrofe di dati.

Rischi Comuni di Sicurezza

Gli attaccanti sondano costantemente i sistemi LLM alla ricerca di punti deboli: inserendo istruzioni nascoste, sfruttando prompt non filtrati, o estraendo token da log non protetti.

Anche il modello più avanzato può essere compromesso se si basa su una pipeline di recupero non protetta o espone embedding riservati.

Punti deboli tipici includono:

- Accesso non autorizzato ai dati tramite injection di prompt o API mal configurate

- Esposizione di campi sensibili o token nei log

- Mancanza di crittografia nelle pipeline di recupero o fine-tuning

Queste minacce trasformano modelli intelligenti in vettori di responsabilità — a meno che non siano implementati livelli difensivi robusti.

Controlli di Mitigazione

La sicurezza dei LLM non è un muro unico — è un sistema di difese a strati:

- Firewall per database per la protezione perimetrale

- Protezione dei dati e crittografia per dati archiviati e trasmessi

- Monitoraggio dell’attività sul database per identificare comportamenti anomali prima che si diffondano

2. Cosa Significa Sicurezza nei LLM

La sicurezza riguarda il modo in cui un LLM si comporta — i suoi limiti etici, l’affidabilità fattuale e la capacità di evitare danni.

Se la sicurezza è la cassaforte intorno al modello, la sicurezza è la coscienza al suo interno.

La sicurezza è meno orientata a fermare gli hacker e più a prevenire danni sociali, reputazionali o morali che possono derivare da output non controllati.

Un modello non sicuro può diffondere disinformazione tanto quanto un modello compromesso può trapelare credenziali.

Rischi di Sicurezza

I modelli mal tarati potrebbero produrre:

- Contenuti tossici, parziali o offensivi

- Informazioni inventate o fuorvianti

- Jailbreak dei prompt che superano i filtri di moderazione

Ciascuno di questi fallimenti mina la fiducia degli utenti — e in settori regolamentati, può portare a gravi conseguenze per la conformità.

Misure di Sicurezza

Gli sviluppatori contrastano questi rischi combinando strategie di addestramento e controlli sui dati:

- Reinforcement Learning da Feedback Umano (RLHF)

- Scoperta dati e rilevamento PII per identificare informazioni sensibili

- Mascheramento statico dei dati prima dell’addestramento per prevenire esposizioni

# Esempio semplice di filtro per output sicuro

def risposta_sicura(output: str) -> str:

vietati = ["password", "SSN", "numero carta"]

return "[REDACTED]" se any(b in output.lower() for b in vietati) else output

3. Dove Sicurezza e Sicurezza dei LLM si Intersecano

La linea si sfoca all’interfaccia del modello — dove prompt, recupero e generazione si incontrano.

Questa è la zona grigia dove un sistema sicuro può comunque produrre output non sicuri, e un modello “sicuro” potrebbe esporre involontariamente dati interni.

Un sistema può essere sicuro ma non sicuro (trapelando dati privati conservati in modo responsabile) o sicuro ma non sicuro (censurato ma facilmente violabile). I framework più solidi affrontano entrambi gli aspetti simultaneamente.

Controlli Condivisi

In questa zona di convergenza, certi meccanismi proteggono sia l’infrastruttura sia la qualità degli output:

- Controllo accessi basato sui ruoli (RBAC)

- Rilevamento injection SQL

- Gestione prompt con guardrails e filtri di moderazione contenuti

| Area di Sovrapposizione | Esempio di Controllo | Scopo |

|---|---|---|

| Validazione Input | Sanificazione prompt | Prevenire injection o fughe di dati sensibili |

| Controllo Accessi | RBAC / reverse proxy | Limitare strumenti e plugin del modello |

| Revisione Output | Filtro post-generazione | Rimuovere dati non etici o privati |

L’intersezione tra sicurezza e sicurezza non è teorica — è operativa. Gli ambienti LLM più resilienti uniscono gestione degli accessi, analisi dei prompt e moderazione etica in un processo continuo.

4. La Sicurezza dei LLM in Pratica

In produzione, la sicurezza dei LLM significa protezione a strati — non solo criptare i dati ma controllare come fluiscono.

Ogni chiamata API, ricerca vettoriale o lookup di embedding deve essere trattato come un possibile vettore di attacco.

Pratiche Fondamentali

- Protezione continua dei dati durante tutto il ciclo di vita del modello

- Log di audit per tracciabilità trasparente

- Validazione automatizzata della conformità integrata con monitoraggio attività

L’architettura a livello proxy di DataSunrise filtra e anonimizza i payload prima che raggiungano gli endpoint del modello, assicurando che anche workflow complessi come RAG o fine-tuning rimangano conformi e protetti.

5. La Sicurezza dei LLM in Pratica

La sicurezza, a differenza della sicurezza, è spesso valutata a posteriori. Ma i meccanismi proattivi di sicurezza possono fermare la maggior parte degli incidenti etici o reputazionali prima che si verifichino.

Tecniche

- Reinforcement learning (RLHF) per adattamento etico

- Filtri di moderazione contestuale per controllo degli output

- Allineamento normativo tra giurisdizioni

- Mascheramento statico dei dati per prevenire esposizioni dannose durante l’addestramento

Esempio: Logica di filtraggio output

def layer_moderazione(testo):

if "discorsi d’odio" in testo.lower():

return "Contenuto bloccato per sicurezza"

return testo

Attraverso una moderazione stratificata, le organizzazioni possono allineare il comportamento dell’AI a norme sociali, culturali e legali — non come ripensamento, ma come parte integrante della pipeline di addestramento e distribuzione.

6. Verso un Framework Unificato

Sicurezza e sicurezza dovrebbero rafforzarsi a vicenda, non competere.

Una strategia matura di governance AI le intreccia in un unico filo operativo — assicurando che il modello sia contemporaneamente tecnicamente robusto e socialmente responsabile.

Approccio Unificato

- Analisi comportamentale per il rilevamento di anomalie e bias

- Tracce di audit per trasparenza e tracciabilità

- Classificazione dati per la gestione contestuale del rischio

| Livello | Obiettivo Sicurezza | Obiettivo Sicurezza |

|---|---|---|

| Dati | Crittografia & Mascheramento | Dati di addestramento etici |

| Modello | Isolamento & Controllo Accessi | Allineamento & Guardrails |

| Output | Log & Validazione | Filtri di tossicità & Trasparenza |

Unendo controlli di sicurezza e politiche etiche, le imprese creano sistemi AI che non solo resistono alle pressioni esterne, ma sostengono anche i valori umani internamente.

Conclusione

La sicurezza mantiene il modello protetto dal mondo.

La sicurezza mantiene il mondo protetto dal modello.

Entrambe le dimensioni definiscono la credibilità di ogni sistema AI.

Solo quando coesistono — armonizzate da politiche, monitoraggio e automazione della conformità — le imprese possono liberare il pieno potenziale dei LLM senza compromettere privacy, integrità o fiducia.

Proteggi i tuoi dati con DataSunrise

Metti in sicurezza i tuoi dati su ogni livello con DataSunrise. Rileva le minacce in tempo reale con il Monitoraggio delle Attività, il Mascheramento dei Dati e il Firewall per Database. Applica la conformità dei dati, individua le informazioni sensibili e proteggi i carichi di lavoro attraverso oltre 50 integrazioni supportate per fonti dati cloud, on-premises e sistemi AI.

Inizia a proteggere oggi i tuoi dati critici

Richiedi una demo

Scarica ora

Proteggi i tuoi dati con DataSunrise

Metti in sicurezza i tuoi dati su ogni livello con DataSunrise. Rileva le minacce in tempo reale con il Monitoraggio delle Attività, il Mascheramento dei Dati e il Firewall per Database. Applica la conformità dei dati, individua le informazioni sensibili e proteggi i carichi di lavoro attraverso oltre 50 integrazioni supportate per fonti dati cloud, on-premises e sistemi AI.

Inizia a proteggere oggi i tuoi dati critici

Richiedi una demo Scarica ora