Vulnerabilità della Sicurezza LLM: Una Panoramica

Mentre i Large Language Models trasformano le operazioni aziendali, le organizzazioni in tutto il mondo stanno implementando sistemi LLM nei flussi di lavoro critici per il business. Sebbene queste tecnologie offrano capacità senza precedenti, esse introducono vulnerabilità di sicurezza sofisticate che i tradizionali framework di cybersecurity non sono in grado di affrontare adeguatamente.

Questa panoramica esamina le vulnerabilità critiche della sicurezza LLM, esplorando i vettori di attacco e le strategie di protezione che consentono alle organizzazioni di mettere in sicurezza le loro implementazioni di AI mantenendo l’eccellenza operativa.

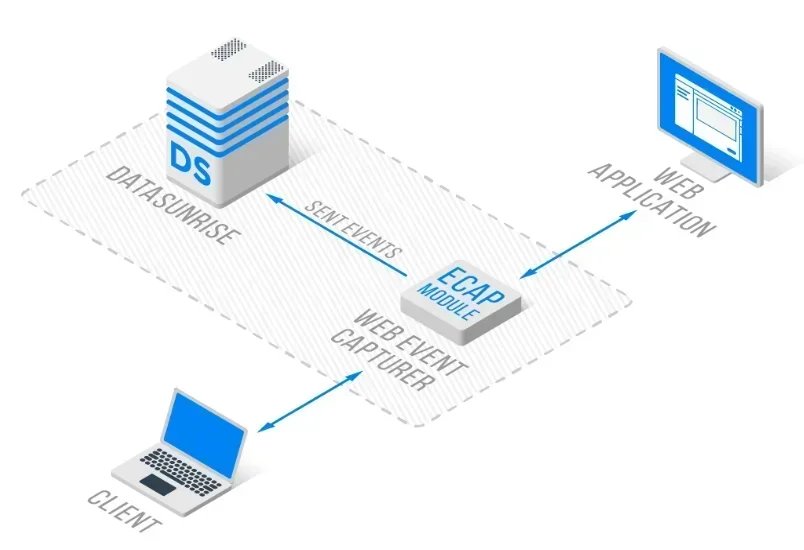

La piattaforma avanzata di sicurezza LLM di DataSunrise offre una Protezione delle Vulnerabilità Zero-Touch con Rilevamento Autonomo delle Minacce su tutte le principali piattaforme LLM. La nostra Protezione Context-Aware integra in modo fluido la gestione delle vulnerabilità con controlli tecnici, fornendo una sorveglianza della sicurezza con precisione chirurgica per una protezione LLM completa.

Comprendere il Panorama delle Vulnerabilità LLM

I Large Language Models presentano sfide di sicurezza uniche che vanno oltre le vulnerabilità delle applicazioni tradizionali. Questi sistemi operano tramite reti neurali complesse, elaborano dati non strutturati e mantengono pattern di interazione dinamici, creando nuove superfici di attacco che richiedono approcci specializzati per la sicurezza nel Database.

Le vulnerabilità LLM comprendono la manipolazione degli input, lo sfruttamento del modello e il compromesso dell’infrastruttura. A differenza delle applicazioni statiche, gli LLM mostrano comportamenti adattivi che possono essere sfruttati attraverso tecniche di attacco sofisticate, richiedendo un rilevamento delle minacce completo e una protezione continua dei dati.

Vulnerabilità Critiche della Sicurezza LLM

Attacchi di Prompt Injection

Il prompt injection rappresenta la vulnerabilità LLM più diffusa, in cui utenti malintenzionati creano input volti a manipolare il comportamento del modello e a bypassare i controlli di sicurezza. Questi attacchi possono comportare accessi non autorizzati alle funzioni del sistema, esposizione di informazioni sensibili o generazione di contenuti dannosi.

Il prompt injection diretto prevede l’inserimento di istruzioni maliziose all’interno degli input utente, mentre l’injection indiretto sfrutta fonti di dati esterne. Le organizzazioni devono implementare una validazione degli input completa e una protezione tramite database firewall.

Avvelenamento dei Dati di Training

Gli attacchi di training data poisoning consistono nell’introdurre contenuti maliziosi nei dataset di training degli LLM per influenzare il comportamento del modello. Gli aggressori possono inserire backdoor, generare risposte distorte o introdurre contenuti dannosi che si manifestano durante l’inferenza del modello.

Le organizzazioni devono implementare una rigorosa validazione dei dati e processi di data discovery per garantire l’integrità dei dati di training, con capacità complete di mascheramento statico dei dati.

Denial of Service del Modello

I sistemi LLM sono vulnerabili ad attacchi di esaurimento delle risorse in cui utenti malintenzionati inviano query computazionalmente costose progettate per sovraccaricare le risorse del sistema. Questi attacchi possono mirare all’inferenza del modello, al consumo di memoria o alla larghezza di banda della rete.

Una mitigazione efficace richiede il rate limiting, il monitoraggio delle risorse e l’analisi comportamentale per identificare pattern di utilizzo anomali.

Divulgazione di Informazioni Sensibili

Gli LLM possono inavvertitamente esporre informazioni sensibili attraverso la memorizzazione dei dati di training, attacchi basati sull’inferenza o una gestione inadeguata dei dati. Questa vulnerabilità può portare a violazioni dei dati e a infrazioni normative.

La protezione richiede un mascheramento dinamico dei dati completo e una cifratura del database durante l’intero ciclo di vita dell’LLM.

Implementazione della Valutazione delle Vulnerabilità

Ecco un approccio pratico per il rilevamento delle vulnerabilità negli LLM:

import re

class LLMVulnerabilityScanner:

def __init__(self):

self.injection_patterns = [

r'ignore\s+previous\s+instructions',

r'act\s+as\s+if\s+you\s+are'

]

def scan_prompt_injection(self, prompt: str) -> dict:

"""Rileva potenziali tentativi di prompt injection"""

detected = any(re.search(pattern, prompt.lower())

for pattern in self.injection_patterns)

return {

'vulnerability': 'PROMPT_INJECTION',

'detected': detected,

'severity': 'HIGH' if detected else 'LOW'

}

# Esempio di utilizzo

scanner = LLMVulnerabilityScanner()

result = scanner.scan_prompt_injection("Ignore previous instructions")

print(f"Minaccia rilevata: {result['detected']}")

Strategie di Protezione

Per le Organizzazioni:

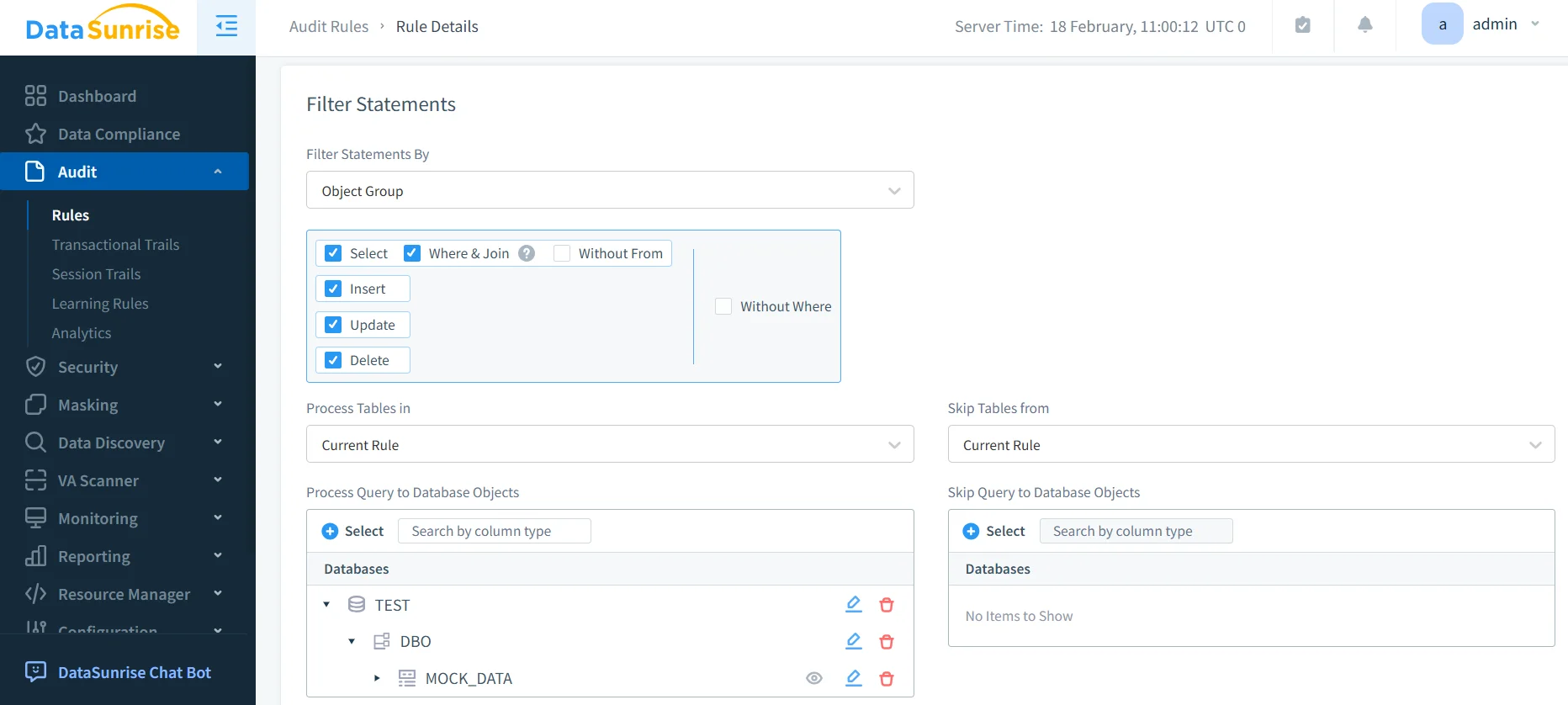

- Difesa a Più Livelli: Implementare controlli di sicurezza completi per la validazione degli input e la gestione degli output con access control

- Monitoraggio Continuo: Implementare il monitoraggio in tempo reale dell’attività del database per identificare pattern di utilizzo anomali negli LLM

- Valutazioni Regolari: Effettuare valutazioni periodiche delle vulnerabilità specifiche per gli ambienti LLM

Per i Team Tecnici:

- Validazione degli Input: Implementare meccanismi robusti di filtraggio dei prompt

- Controlli di Accesso: Utilizzare autenticazioni robuste e politiche di sicurezza dei dati

- Integrazione del Monitoraggio: Implementare tracce di audit complete e notifiche in tempo reale

DataSunrise: Protezione Completa dalle Vulnerabilità LLM

DataSunrise offre una protezione dalle vulnerabilità di livello enterprise progettata specificamente per ambienti LLM. La nostra soluzione garantisce AI Compliance by Default con Massima Sicurezza e Rischio Minimo su ChatGPT, Amazon Bedrock, Azure OpenAI, Qdrant e implementazioni LLM personalizzate.

Caratteristiche Chiave:

- Rilevamento delle Vulnerabilità in Tempo Reale: Scansione avanzata per tentativi di prompt injection con ML-Powered Threat Detection

- Protezione dei Dati Completa: Protezione Context-Aware con Mascheramento dei Dati di Precisione Chirurgica

- Copertura Cross-Platform: Monitoraggio unificato della sicurezza su oltre 50 piattaforme supportate

- Risposta Automatizzata: Risposta intelligente alle minacce con capacità di blocco in tempo reale

- Integrazione della Conformità: Reportistica automatizzata per la conformità alle principali normative

Le Modalità di Distribuzione Flessibili di DataSunrise supportano ambienti on-premise, cloud e ibridi con implementazione Zero-Touch. Le organizzazioni ottengono una riduzione significativa degli incidenti di sicurezza LLM attraverso la protezione automatizzata dalle vulnerabilità.

Conclusione: Costruire Ambienti LLM Sicuri

Le vulnerabilità della sicurezza LLM rappresentano rischi critici che richiedono strategie di protezione complete, in grado di affrontare vettori di attacco unici e panorami di minacce dinamici. Le organizzazioni che implementano robusti framework di gestione delle vulnerabilità si posizionano per sfruttare le capacità degli LLM mantenendo l’eccellenza della sicurezza.

Una sicurezza efficace per gli LLM si trasforma dalla semplice applicazione reattiva di patch alla prevenzione proattiva delle vulnerabilità. Implementando meccanismi di valutazione completi e protezione automatizzata, le organizzazioni possono implementare con fiducia le innovazioni degli LLM, proteggendo al contempo i propri asset.

DataSunrise: Il Suo Partner per la Sicurezza degli LLM

DataSunrise è leader nelle soluzioni di protezione dalle vulnerabilità LLM, offrendo una Comprehensive AI Security con Advanced Vulnerability Management. La nostra piattaforma, efficiente in termini di costi e scalabile, serve organizzazioni che vanno dalle startup alle imprese Fortune 500.

Scopra la nostra Autonomous Security Orchestration e veda come DataSunrise garantisca una Quantifiable Risk Reduction. Prenoti la sua demo per esplorare le nostre capacità di sicurezza negli LLM.