Gestione del Rischio AI nei Sistemi LLM

Mentre l’intelligenza artificiale trasforma le operazioni aziendali, il 78% delle organizzazioni implementa sistemi Large Language Model (LLM) in flussi di lavoro mission-critical. Sebbene gli LLM offrano capacità senza precedenti, essi introducono sfide sofisticate per la gestione del rischio che i framework tradizionali non sono in grado di affrontare adeguatamente.

Questa guida esamina i requisiti per la gestione del rischio AI nei sistemi LLM, esplorando strategie complete che consentono alle organizzazioni di sfruttare il potenziale degli LLM mantenendo controlli sul rischio robusti.

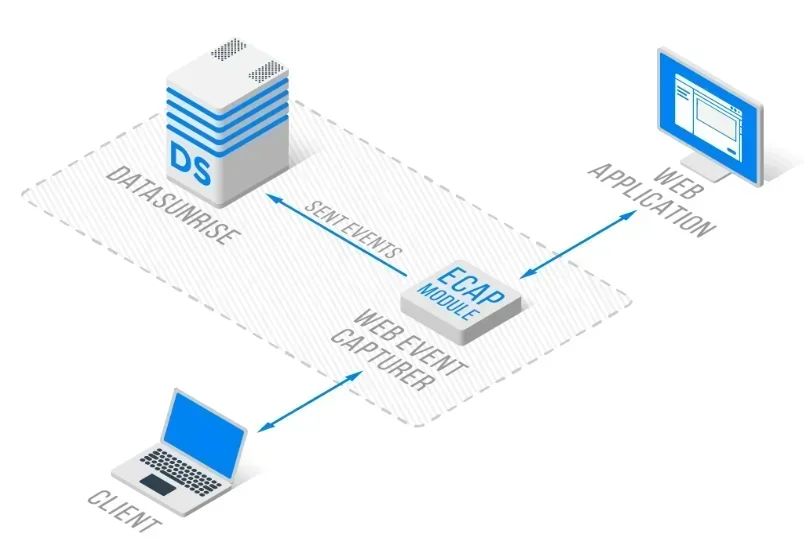

La piattaforma avanzata di gestione del rischio AI di DataSunrise offre Zero-Touch Risk Orchestration con rilevamento autonomo delle minacce su tutte le principali piattaforme LLM. Il nostro Centralized AI Risk Framework integra senza soluzione di continuità la gestione del rischio con controlli tecnici, offrendo una supervisione del rischio a precisione chirurgica per una protezione completa degli LLM.

Comprendere il Panorama dei Rischi negli LLM

I Large Language Models operano attraverso complesse reti neurali che elaborano enormi quantità di dati non strutturati, prendendo decisioni autonome e generando contenuti dinamici. Ciò crea vulnerabilità di sicurezza senza precedenti che richiedono approcci completi di gestione del rischio e capacità di rilevamento delle minacce.

La gestione del rischio negli LLM comprende l’identificazione delle minacce, la valutazione delle vulnerabilità e le strategie di mitigazione lungo l’intero ciclo di vita dell’AI. A differenza dei sistemi tradizionali, gli LLM presentano profili di rischio in continua evoluzione, per cui è necessario un monitoraggio continuo e misure di protezione dei dati adattive con l’implementazione di regole di sicurezza.

Categorie Critiche di Rischio per gli LLM

Rischi per la Sicurezza del Modello

I sistemi LLM sono esposti ad attacchi sofisticati, tra cui prompt avversari progettati per manipolare il comportamento del modello, avvelenamento dei dati di addestramento che influenza le uscite e tentativi di estrazione del modello per sottrarre proprietà intellettuale, attraverso tecniche di bypass del database firewall e tentativi di SQL injection.

Rischi per la Privacy dei Dati e la Conformità

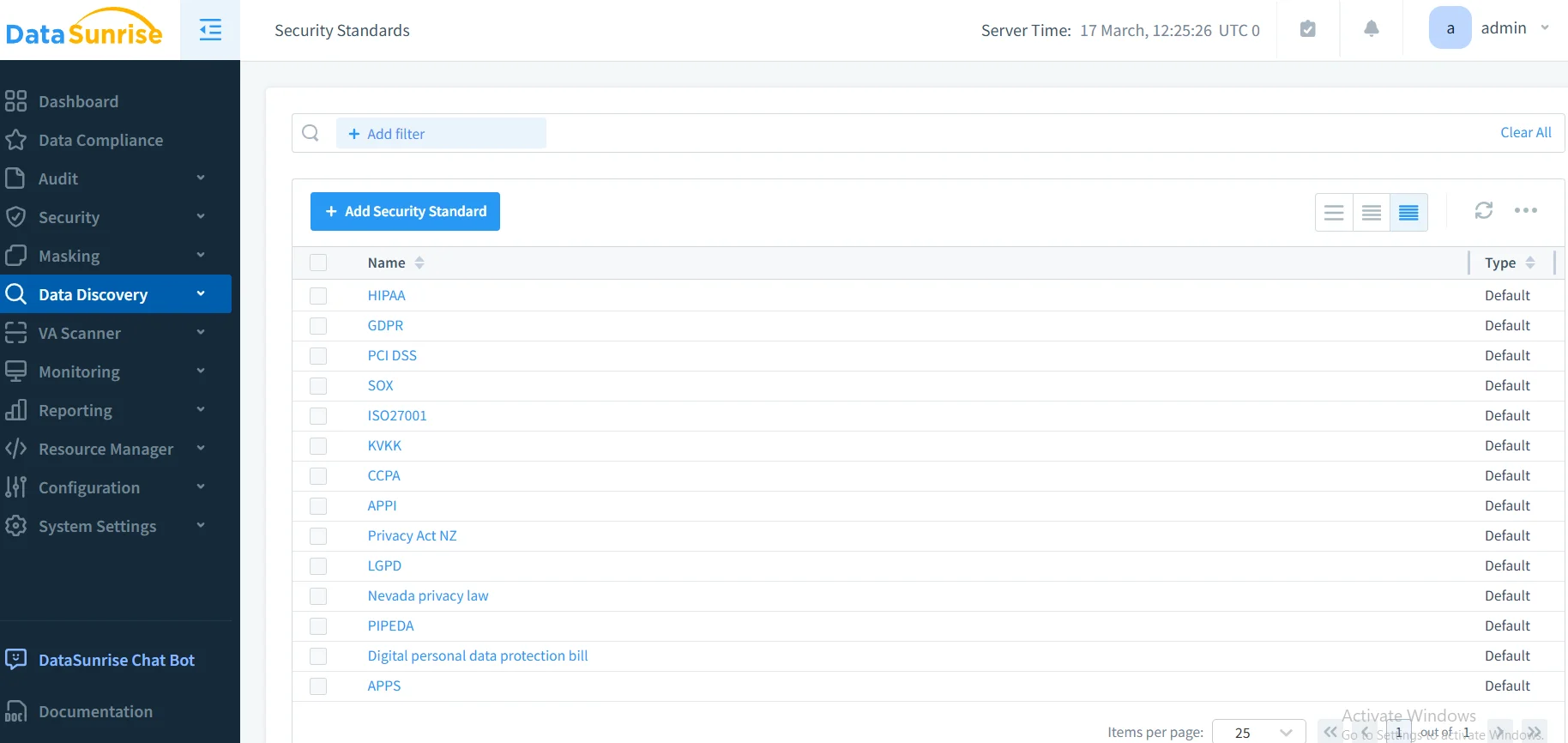

Gli LLM che elaborano informazioni sensibili creano rischi significativi di data breach tramite divulgazioni non intenzionali di PII, fuoriuscite di informazioni tra conversazioni e non conformità alle normative nei framework GDPR, HIPAA e PCI DSS, richiedendo l’adesione alle normative di conformità.

Rischi Operativi ed Etici

Il dispiegamento degli LLM genera sfide operative, tra cui il model drift che incide sulle prestazioni, problemi di scalabilità e problematiche etiche legate a output parziali, richiedendo analisi comportamentali per il rilevamento e la mitigazione.

Implementazione della Valutazione del Rischio

Una gestione efficace del rischio negli LLM richiede approcci di valutazione sistematici:

import re

from datetime import datetime

class LLMRiskAssessment:

def assess_interaction(self, prompt: str, response: str):

"""Valutazione del rischio per le interazioni LLM"""

pii_risk = self._detect_pii(prompt + response)

injection_risk = self._detect_injection(prompt)

overall_risk = max(pii_risk, injection_risk)

return {

'risk_level': 'HIGH' if overall_risk > 0.7 else 'MEDIUM' if overall_risk > 0.4 else 'LOW',

'mitigation_required': overall_risk > 0.6

}

def _detect_pii(self, text: str) -> float:

"""Rilevamento dei pattern PII"""

patterns = [r'\b[\w._%+-]+@[\w.-]+\.[A-Z|a-z]{2,}\b', r'\b\d{3}-\d{2}-\d{4}\b']

detected = sum(1 for p in patterns if re.search(p, text))

return min(detected / len(patterns), 1.0)

Best Practices di Implementazione

Per le Organizzazioni:

- Stabilire la Governance del Rischio: Creare comitati per il rischio AI con responsabilità chiare e politiche di sicurezza dei dati unitamente a regole di learning e procedure di audit.

- Implementare il Monitoraggio Continuo: Implementare il monitoraggio in tempo reale dell’attività del database per tutte le interazioni LLM.

- Mantenere la Documentazione del Rischio: Documentare i rischi, le strategie di mitigazione e le tracce di audit ottimizzando lo storage audit.

Per i Team Tecnici:

- Sicurezza a Più Livelli: Implementare controlli di accesso e Mascheramento Dinamico dei Dati.

- Risposta Automatica: Configurare notifiche in tempo reale e risposte agli incidenti.

- Monitoraggio delle Prestazioni: Assicurarsi che i controlli sul rischio non incidano sulle prestazioni degli LLM.

DataSunrise: Soluzione Completa per la Gestione del Rischio negli LLM

DataSunrise offre una gestione del rischio a livello enterprise progettata specificamente per ambienti LLM. La nostra soluzione offre Autonomous Risk Orchestration con rilevamento delle minacce in tempo reale su ChatGPT, Amazon Bedrock, Azure OpenAI, Qdrant e implementazioni LLM personalizzate.

Caratteristiche Chiave:

- Valutazione del Rischio in Tempo Reale: Rilevamento delle minacce basato su ML con protezione contestuale.

- Monitoraggio Completo: Monitoraggio AI Zero-Touch con audit logs dettagliati.

- Protezione Avanzata dei Dati: Mascheramento dei Dati a precisione chirurgica con rilevamento PII.

- Copertura Cross-Platform: Gestione unificata del rischio su oltre 50 piattaforme supportate.

- Integrazione della Conformità: Reporting di conformità automatizzato per i principali framework regolatori.

Le modalità di distribuzione flessibili di DataSunrise supportano ambienti on-premise, cloud e ibridi con implementazione Zero-Touch. Le organizzazioni raggiungono una riduzione dell’85% negli incidenti di sicurezza AI e un miglioramento della postura di conformità grazie al reporting regolatorio automatizzato.

Conclusione: Gestione Proattiva del Rischio negli LLM

Una gestione efficace del rischio AI nei sistemi LLM richiede strategie complete che affrontino le dimensioni tecniche, operative e regolatorie. Le organizzazioni che implementano framework di rischio robusti si posizionano per sfruttare le capacità degli LLM mantenendo la fiducia degli stakeholder e una resilienza operativa.

Con l’accelerazione dell’adozione degli LLM, la gestione del rischio si trasforma da una supervisione facoltativa a una capacità aziendale essenziale. Implementando framework comprovati e soluzioni di monitoraggio continuo, le organizzazioni possono perseguire con fiducia le innovazioni negli LLM proteggendo al contempo i propri asset.

DataSunrise: Il Suo Partner per la Gestione del Rischio negli LLM

DataSunrise è leader nelle soluzioni per la gestione del rischio negli LLM, offrendo una protezione AI completa con analisi avanzate del rischio. La nostra piattaforma, economica e scalabile, serve organizzazioni da startup fino alle imprese Fortune 500.

Provate la nostra orchestrazione della sicurezza autonoma e scoprite come DataSunrise garantisce una riduzione quantificabile del rischio. Prenotate la vostra demo per esplorare le nostre capacità di gestione del rischio negli LLM.