Approcci di Mascheramento dei Dati nei Flussi di Lavoro AI e LLM

Mentre l’intelligenza artificiale (AI) e i modelli di linguaggio di grandi dimensioni (LLM) trasformano i flussi di lavoro aziendali moderni, proteggere i dati sensibili è diventato più critico che mai. Il mascheramento dei dati aiuta a risolvere questa sfida senza rallentare l’innovazione. In questo articolo, esploriamo approcci pratici di mascheramento dei dati nei flussi di lavoro AI e LLM, con un focus su salvaguardie in tempo reale e l’integrazione della conformità.

Perché il Mascheramento dei Dati è Cruciale nei Flussi di Lavoro AI

I modelli di AI generativa spesso elaborano input sensibili come log interni, email, dati personali e registrazioni finanziarie. Questi sistemi potrebbero archiviare o riprodurre tali dati inavvertitamente. Il mascheramento previene questi rischi nascondendo o modificando le informazioni sensibili prima che raggiungano il modello.

Ad esempio, se un prompt per un LLM raffinato include il nome e il numero di telefono di un cliente reale, il modello potrebbe memorizzarli e riutilizzarli. Uno strato di mascheramento previene ciò sostituendo gli identificatori prima dell’ingestione. La politica di utilizzo dei dati di OpenAI spiega come i LLM possano trattenere inavvertitamente contenuti degli utenti.

Mascheramento Statico e Dinamico nei Contesti LLM

Mascheramento Statico per il Preprocessing

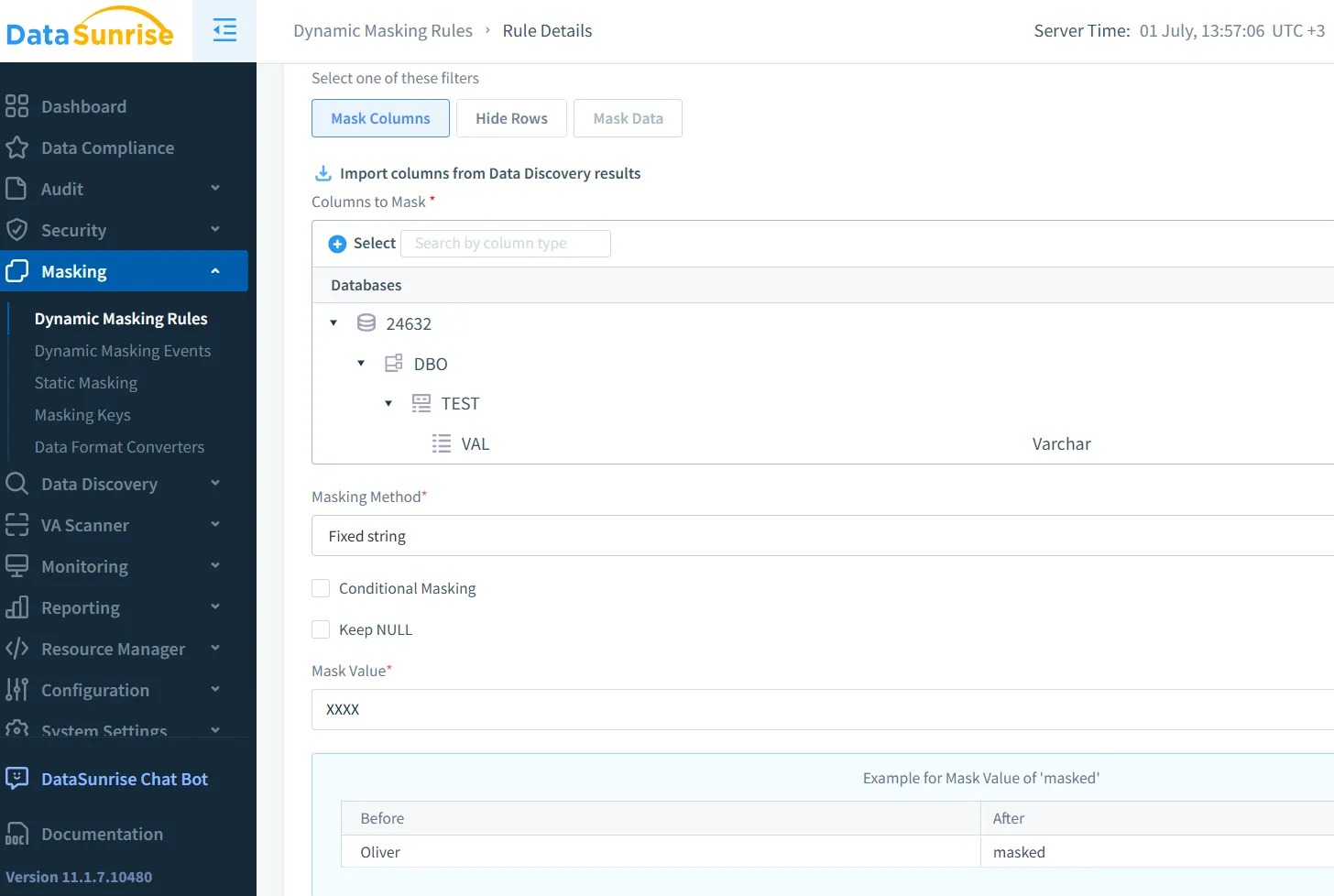

Il mascheramento statico modifica i dati sensibili a riposo ed è spesso utilizzato durante la preparazione dei dataset. Il Mascheramento Statico di DataSunrise trasforma permanentemente gli export preservando la struttura.

Il Google Cloud DLP supporta un simile mascheramento statico, includendo tecniche che preservano il formato per dati strutturati.

Mascheramento Dinamico per l’Uso in Tempo Reale

Il mascheramento dinamico opera sui dati in tempo reale. Ad esempio, quando i LLM elaborano i prompt degli utenti, i motori di mascheramento possono sopprimere numeri di carte di credito o codici fiscali prima che il modello li visualizzi. Il Mascheramento Dinamico di DataSunrise è particolarmente adatto a questo utilizzo in produzione.

Amazon Macie offre un servizio correlato che scansiona e maschera i dati negli ambienti AWS. Per saperne di più, consulta questo post di AWS.

Mascheramento dei Prompt LLM in Pratica

Considera un chatbot per l’assistenza clienti che utilizza un LLM. I messaggi contengono spesso dati privati. Una regola dinamica potrebbe essere la seguente:

CREATE MASKING RULE mask_pii

ON inbound_messages.content

WHEN content LIKE '%SSN%'

REPLACE WITH '***-**-****';

Questa regola impedisce ai modelli di accedere ai numeri di previdenza sociale in forma grezza.

Applicando questa logica allo strato middleware, i team non devono modificare il modello. Gli strumenti per la sicurezza dei LLM e ML di DataSunrise aiutano ad automatizzare questo processo utilizzando una rilevazione contestuale.

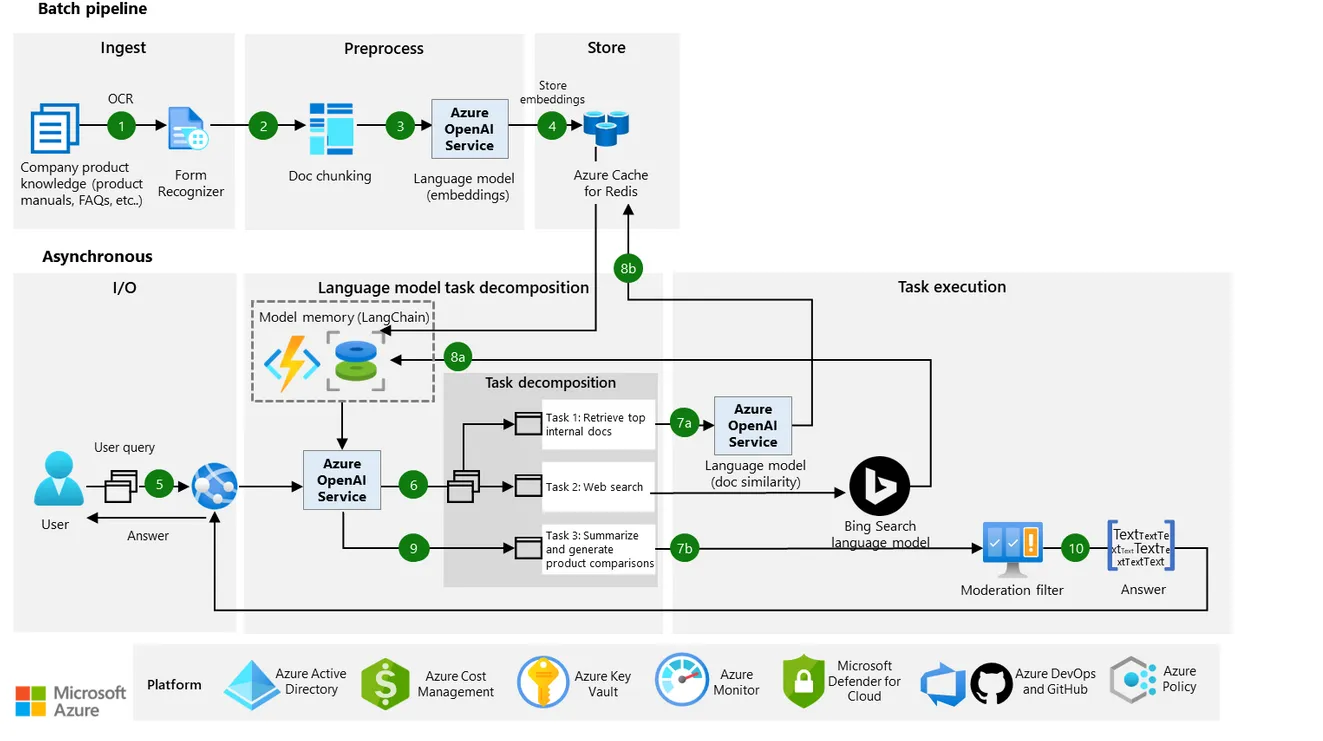

Le linee guida architetturali di Microsoft evidenziano inoltre il mascheramento in tempo reale e l’uso responsabile dei dati nei flussi di lavoro dei LLM.

Dal Mascheramento ai Controlli di Accesso Contestuali

Il mascheramento è più efficace se abbinato a controlli di accesso basati sui ruoli, tracciamenti di audit e analisi comportamentali. Un sviluppatore in ambiente di staging potrebbe visualizzare dati realistici ma falsi, mentre gli input in produzione restano oscurati.

Quando collegati a strumenti di monitoraggio delle attività, i team possono intercettare accessi non mascherati o attivare avvisi. Il mascheramento diventa così uno strato di sicurezza, non solo una soluzione per la privacy.

Questo design si allinea ai principi del Zero Trust NIST, che privilegiano una visibilità ristretta e un’applicazione rigorosa delle politiche.

Dati Sintetici come Alternativa al Mascheramento

Invece di mascherare dati reali, molti team ora generano dati sintetici per addestrare o testare i modelli di AI. Questi dataset preservano lo schema e la logica senza esporre persone reali.

Il UK ICO riconosce i dati sintetici come un metodo per preservare la privacy secondo il GDPR, soprattutto per lo sviluppo di AI e ML.

Fattori di Conformità e Gestione del Rischio AI

Regolamenti come il GDPR, HIPAA e PCI DSS richiedono alle organizzazioni di giustificare, anonimizzare o mascherare i dati sensibili durante il processamento. Il mascheramento supporta questi requisiti attraverso la minimizzazione dei dati e il controllo del rischio.

Si inserisce anche nei modelli di sicurezza ispirati ai dati, dove la governance e la protezione sono integrate in ogni strato.

Modelli di Implementazione nel Mondo Reale

Nei sistemi reali, il mascheramento avviene tipicamente tramite:

- Script di preprocessing per i dati di addestramento

- Motori middleware per il mascheramento in tempo reale

- Mascheramento tramite reverse proxy per gli output

- Audit dei log di inferenza

Utilizzando un reverse proxy, gli sviluppatori possono intercettare e oscurare i dati sensibili prima che raggiungano il modello o i log.

Questo approccio stratificato non solo migliora la protezione, ma costruisce fiducia. Gli utenti sono più propensi a interagire quando sanno che il loro input rimane privato.

Conclusione: Costruire Pipeline LLM Più Sicure

Il mascheramento non è solo una casella di controllo per la conformità. È una decisione progettuale che definisce quanto in modo sicuro operi la tua AI. Sia il mascheramento statico che quello dinamico giocano ruoli critici nella protezione dei dati degli utenti durante l’intero ciclo di vita.

Quando combinati con strumenti di scoperta, politiche di audit e automazione della sicurezza, queste tecniche aiutano a costruire sistemi di AI sicuri per design.

Per i team che scalano la GenAI, la giusta strategia di mascheramento può prevenire violazioni, ridurre la responsabilità e proteggere gli utenti senza ostacolare l’innovazione.

Proteggi i tuoi dati con DataSunrise

Metti in sicurezza i tuoi dati su ogni livello con DataSunrise. Rileva le minacce in tempo reale con il Monitoraggio delle Attività, il Mascheramento dei Dati e il Firewall per Database. Applica la conformità dei dati, individua le informazioni sensibili e proteggi i carichi di lavoro attraverso oltre 50 integrazioni supportate per fonti dati cloud, on-premises e sistemi AI.

Inizia a proteggere oggi i tuoi dati critici

Richiedi una demo Scarica ora