Approfondimenti sulla Sicurezza dalle Applicazioni ML

Mentre il machine learning trasforma le operazioni aziendali, la maggior parte delle organizzazioni sta implementando applicazioni ML in processi aziendali mission-critical. Sebbene il ML offra capacità trasformative, esso introduce sfide di sicurezza sofisticate che i tradizionali framework di protezione non sono in grado di affrontare adeguatamente.

Questa guida esamina gli approfondimenti sulla sicurezza delle applicazioni ML, esplorando strategie di implementazione che consentono alle organizzazioni di costruire infrastrutture ML sicure e resilienti, mantenendo al contempo l’eccellenza operativa.

La piattaforma di sicurezza ML all’avanguardia di DataSunrise offre un’orchestrazione della sicurezza senza intervento con protezione ML autonoma su tutte le principali piattaforme di machine learning. La nostra Protezione Contestuale integra senza soluzione di continuità la sicurezza ML con controlli tecnici, fornendo una gestione della sicurezza a precisione chirurgica per una protezione completa delle applicazioni ML con AI Compliance di Default.

Comprendere le Basi della Sicurezza delle Applicazioni ML

Le applicazioni di machine learning operano attraverso algoritmi complessi che elaborano enormi dataset, effettuano previsioni autonome e si adattano continuamente grazie a meccanismi di apprendimento. A differenza delle applicazioni tradizionali, i sistemi ML creano superfici d’attacco dinamiche dove il comportamento del modello, i dati di addestramento e i processi di inferenza presentano vulnerabilità di sicurezza uniche che richiedono approcci di protezione specializzati.

Una sicurezza efficace per il ML comprende la protezione delle pipeline dei dati, la verifica dell’integrità del modello, il monitoraggio delle inferenze e capacità di audit complete progettate specificamente per ambienti di machine learning.

Vettori Critici delle Minacce per la Sicurezza ML

Le applicazioni ML affrontano sfide di sicurezza uniche che richiedono strategie di protezione specializzate:

- Avvelenamento dei Dati di Addestramento: Iniezione malevola di campioni corrotti nei dataset di addestramento per manipolare il comportamento del modello e compromettere l’integrità dei dati

- Attacchi di Estrazione del Modello: Tentativi basati su API di ricostruire modelli proprietari e sottrarre proprietà intellettuale tramite accesso non autorizzato

- Inferenza Avversariale: Input accuratamente studiati per ingannare i sistemi di previsione ed estrarre informazioni sensibili

- Perdita di Dati: Attacchi di inversione del modello e di inferenza di appartenenza che espongono i dati di addestramento tramite violazioni dei dati, richiedendo protocolli di scoperta dei dati

Framework di Implementazione della Sicurezza

Una sicurezza efficace per il ML richiede approcci pratici di validazione sia per le fasi di addestramento che di inferenza:

Validazione della Sicurezza dei Dati di Addestramento

La seguente implementazione dimostra come validare l’integrità dei dati di addestramento e rilevare anomalie statistiche che potrebbero indicare tentativi di avvelenamento. Questo validatore confronta gli hash dei dati con i baseline e monitora la presenza di proprietà statistiche insolite che potrebbero suggerire manomissioni malevoli.

import hashlib

import numpy as np

from datetime import datetime

class MLDataSecurityValidator:

def __init__(self):

self.anomaly_threshold = 2.0

self.integrity_baseline = {}

def validate_training_data(self, dataset, dataset_id):

"""Validazione completa della sicurezza per i dati di addestramento ML"""

validation_result = {

'timestamp': datetime.utcnow().isoformat(),

'dataset_id': dataset_id,

'security_score': 100,

'threats_detected': [],

'recommendations': []

}

# Verifica dell'integrità dei dati

current_hash = hashlib.sha256(str(dataset).encode()).hexdigest()

baseline_hash = self.integrity_baseline.get(dataset_id)

if baseline_hash and current_hash != baseline_hash:

validation_result['threats_detected'].append({

'type': 'DATA_TAMPERING',

'severity': 'HIGH',

'description': 'Integrità del dataset compromessa'

})

validation_result['security_score'] -= 30

# Salva il baseline per confronti futuri

if not baseline_hash:

self.integrity_baseline[dataset_id] = current_hash

return validation_result

Monitor della Sicurezza delle Inferenze del Modello

Questo monitor di sicurezza dimostra la protezione in tempo reale per gli endpoint di inferenza ML. Esso traccia i modelli di richiesta per rilevare potenziali tentativi di estrazione del modello e identifica pattern di input sospetti che potrebbero indicare attacchi avversariali.

class MLInferenceSecurityMonitor:

def __init__(self, model_name):

self.model_name = model_name

self.request_history = []

self.rate_limit_threshold = 100 # richieste al minuto

def monitor_inference_request(self, user_id, input_data, prediction):

"""Monitoraggio della sicurezza in tempo reale per le richieste di inferenza ML"""

security_assessment = {

'timestamp': datetime.utcnow().isoformat(),

'user_id': user_id,

'model_name': self.model_name,

'risk_level': 'LOW',

'security_flags': []

}

# Rilevamento del superamento del limite di richieste

recent_requests = len([r for r in self.request_history

if r['user_id'] == user_id and

(datetime.utcnow() - datetime.fromisoformat(r['timestamp'])).seconds < 60])

if recent_requests > self.rate_limit_threshold:

security_assessment['security_flags'].append({

'type': 'RATE_LIMIT_EXCEEDED',

'severity': 'HIGH',

'description': 'Potenziale tentativo di estrazione del modello'

})

security_assessment['risk_level'] = 'HIGH'

return security_assessment

Best Practice per l’Implementazione

Per le Organizzazioni:

- Stabilire la Governance della Sicurezza ML: Creare team di sicurezza ML specializzati con politiche di sicurezza complete e in linea con le normative di conformità

- Implementare il Monitoraggio in Tempo Reale: Adottare il monitoraggio dell’attività del database in tutta la pipeline ML, con analisi del comportamento degli utenti

- Mantenere la Documentazione di Sicurezza: Creare tracce di audit complete con un’adeguata ottimizzazione dello stoccaggio degli audit

- Valutazioni di Sicurezza Regolari: Eseguire valutazioni periodiche delle vulnerabilità e test di sicurezza

Per i Team Tecnici:

- Mettere in Sicurezza le Pipeline ML: Implementare la crittografia del database per i dati di addestramento con protocolli di gestione dei dati di test

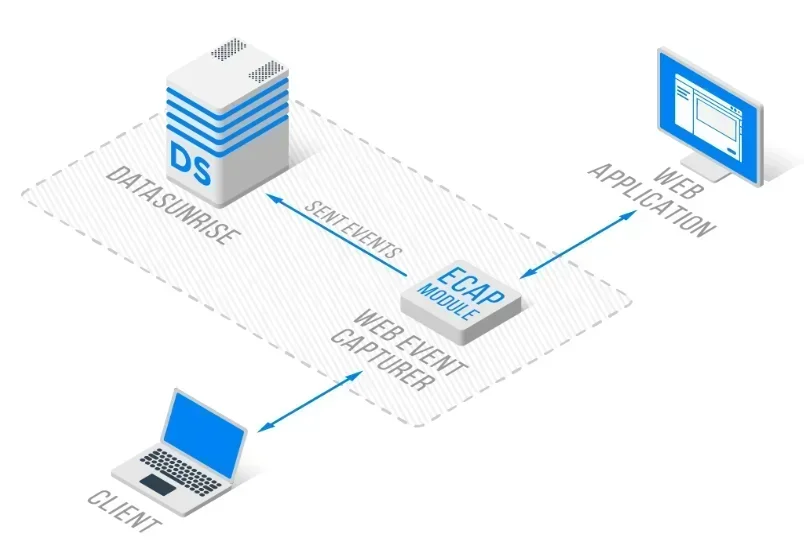

- Protezione del Modello: Adottare controlli di accesso e protezione della proprietà intellettuale utilizzando un’architettura di reverse proxy

- Rilevamento in Tempo Reale: Configurare il rilevamento automatico delle minacce con funzionalità di database firewall

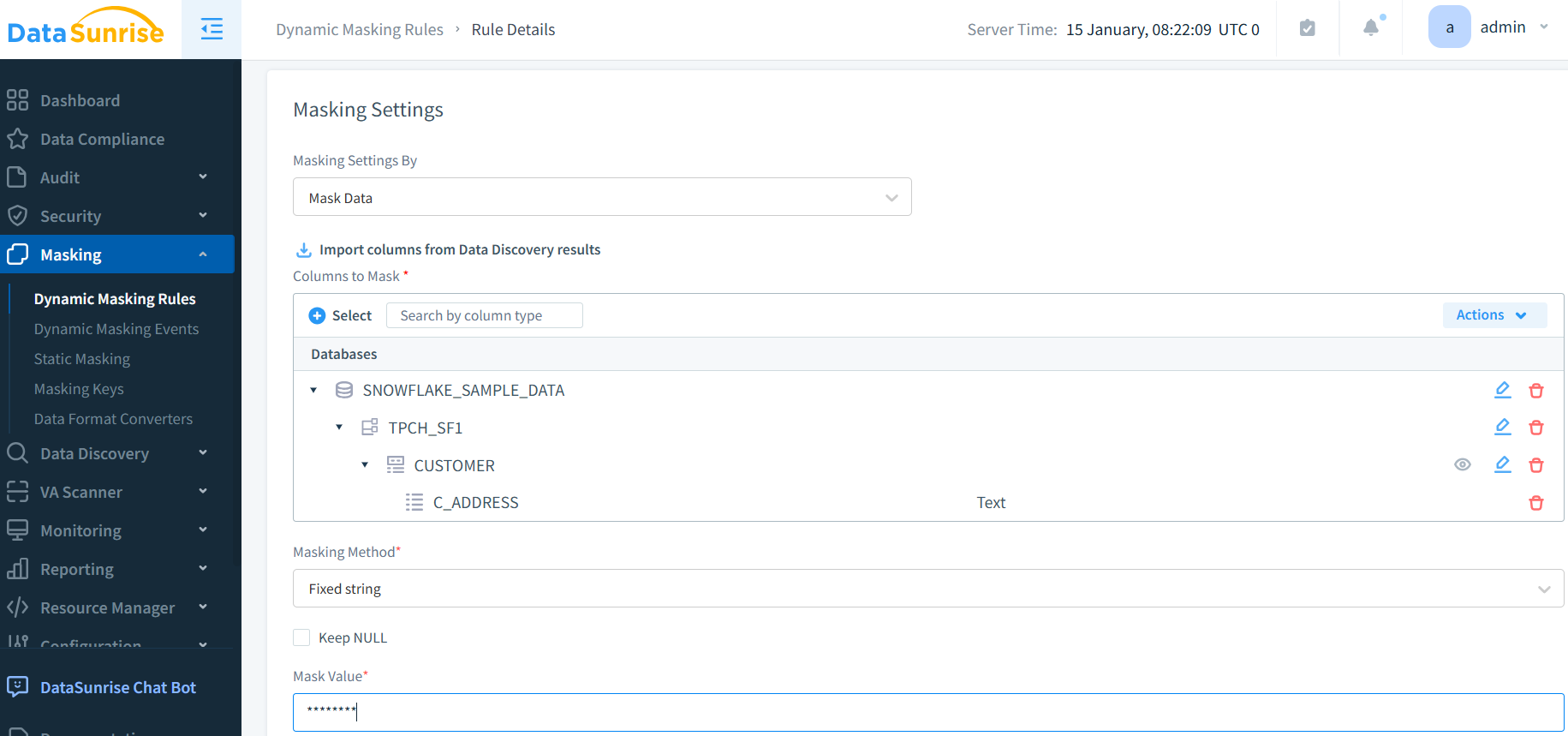

- Controlli di Privacy: Implementare tecniche complete di mascheramento dei dati e generazione di dati sintetici

DataSunrise: Soluzione Completa per la Sicurezza ML

DataSunrise fornisce soluzioni di sicurezza di livello enterprise progettate specificamente per le applicazioni di machine learning. La nostra piattaforma offre la Massima Sicurezza, il Rischio Minimo, con Protezione ML in Tempo Reale su tutte le principali piattaforme ML, inclusi TensorFlow, PyTorch e servizi ML basati sul cloud.

Funzionalità Chiave:

- Monitoraggio in Tempo Reale delle Attività ML: Tracciamento completo con audit logs per tutte le interazioni ML

- Rilevamento Avanzato delle Minacce: Rilevamento di Comportamenti Sospetti basato su ML con Protezione Contestuale

- Protezione Dinamica dei Dati: Mascheramento dei dati a precisione chirurgica per la protezione delle informazioni PII nei dataset di addestramento

- Copertura Cross-Platform: Sicurezza unificata su oltre 50 piattaforme supportate

- Automazione della Conformità: Reporting di conformità automatizzato per i principali framework normativi

Le modalità di distribuzione flessibili di DataSunrise supportano ambienti ML on-premise, cloud e ibridi con implementazione senza intervento. Le organizzazioni ottengono una significativa riduzione degli incidenti di sicurezza e una protezione avanzata del modello grazie al monitoraggio automatizzato.

Conclusione: Costruire Basi ML Sicure

Gli approfondimenti sulla sicurezza delle applicazioni ML evidenziano l’importanza critica di framework di protezione completi in grado di affrontare le minacce uniche del machine learning. Le organizzazioni che implementano strategie robuste di sicurezza ML si posizionano per sfruttare il potenziale trasformativo del ML, mantenendo al contempo la fiducia degli stakeholder e la resilienza operativa.

Man mano che le applicazioni ML diventano sempre più centrali per le operazioni aziendali, la sicurezza evolve da un miglioramento opzionale a una capacità aziendale essenziale. Implementando framework di sicurezza avanzati con monitoraggio automatizzato, le organizzazioni possono adottare con fiducia le innovazioni ML, proteggendo al contempo i loro preziosi asset di dati.

Proteggi i tuoi dati con DataSunrise

Metti in sicurezza i tuoi dati su ogni livello con DataSunrise. Rileva le minacce in tempo reale con il Monitoraggio delle Attività, il Mascheramento dei Dati e il Firewall per Database. Applica la conformità dei dati, individua le informazioni sensibili e proteggi i carichi di lavoro attraverso oltre 50 integrazioni supportate per fonti dati cloud, on-premises e sistemi AI.

Inizia a proteggere oggi i tuoi dati critici

Richiedi una demo Scarica ora