Valutazione della Sicurezza per i Modelli di AI Generativi

L’AI generativa si è trasformata da una novità di ricerca a uno strumento fondamentale per l’impresa. Dalla creazione di contenuti di marketing all’alimentazione di assistenti virtuali e alla sintesi dei ticket dei clienti, questi modelli acquisiscono ed elaborano grandi volumi di informazioni sensibili. Questo livello di accesso richiede una strategia di valutazione della sicurezza robusta, adattata al comportamento unico dei sistemi di AI generativa.

Una corretta valutazione della sicurezza per i modelli di AI generativa non riguarda solo la protezione dell’infrastruttura. Significa monitorare come questi modelli interagiscono con i dati, garantire la conformità e adattare i controlli per prevenire eventuali perdite accidentali o abusi di output sensibili.

Perché le Valutazioni della Sicurezza per GenAI sono Importanti

I sistemi di AI generativa possono memorizzare i dati di addestramento, produrre risposte inaspettate e interagire con gli utenti tramite il linguaggio naturale, creando così sfide di sicurezza che i sistemi tradizionali non incontrano. Un singolo prompt potrebbe estrarre informazioni proprietarie o dati personali identificabili, a meno che non siano in atto forti misure di protezione dei dati.

Essi introducono anche sfide in termini di conformità. Se il modello accede a dati regolamentati (come PHI o campi protetti da PCI-DSS), tale interazione deve essere tracciata, mascherata e sottoposta ad audit secondo framework come le linee guida per la conformità HIPAA o il framework GDPR. Per una visione più ampia sulle pratiche di AI responsabile, consulta la guida di Microsoft all’AI Responsabile.

Audit in Tempo Reale dei Prompt e degli Output di GenAI

Le capacità di audit in tempo reale sono essenziali per garantire che i sistemi GenAI non operino come scatole nere. Ogni prompt e ogni risposta generata dovrebbe essere catturata con metadati contestuali quali ruolo dell’utente, timestamp, IP e modello utilizzato. Questi log devono essere conservati in modo sicuro e resi interrogevoli per ispezioni di conformità e analisi forensi delle minacce.

Ecco un semplice esempio in stile SQL di come potrebbe essere strutturato un audit degli output di GenAI:

Per saperne di più, consulta questo riferimento sui log di DataSunrise.

Mascheramento Dinamico negli Output di AI

I modelli generativi possono esporre dati sensibili inavvertitamente tramite completamenti o risposte potenziate dal recupero. Per mitigare questo rischio, il mascheramento dinamico dei dati dovrebbe essere applicato a due livelli:

- Mascheramento pre-inferenza, in cui l’input al LLM viene mascherato dinamicamente se contiene campi sensibili.

- Mascheramento post-inferenza, in cui gli output del modello vengono scansionati e redatti prima di essere consegnati all’utente finale.

Il mascheramento dinamico può anche fare affidamento sul controllo degli accessi basato sui ruoli, garantendo che solo i ruoli autorizzati possano vedere i valori grezzi. Ad esempio, se un modello sta recuperando le ultime quattro cifre del SSN di un cliente:

Un concetto complementare è l’applicazione del modello zero trust, spiegato in questa panoramica dell’Architettura Zero Trust del NIST.

Scoperta dei Dati Prima dell’Addestramento del Modello

Prima di addestrare o perfezionare un LLM su dataset interni, le aziende devono classificare e mappare tutti i campi dati che potrebbero contenere contenuti sensibili. L’integrazione di strumenti automatizzati di scoperta dei dati garantisce visibilità su fonti strutturate e semi-strutturate.

Ad esempio, etichettare i campi come:

- PII (ad es., nome, email, telefono)

- PHI (ad es., storia medica)

- PCI (ad es., numero della carta)

…può attivare automaticamente politiche di mascheramento e audit.

Quando combinato con il monitoraggio delle attività, ciò garantisce che il modello non acquisisca mai campi non tracciati o ad alto rischio.

Puoi trovare ulteriori best practice sulla classificazione dei dati nella guida sulla governance dei dati di Google Cloud.

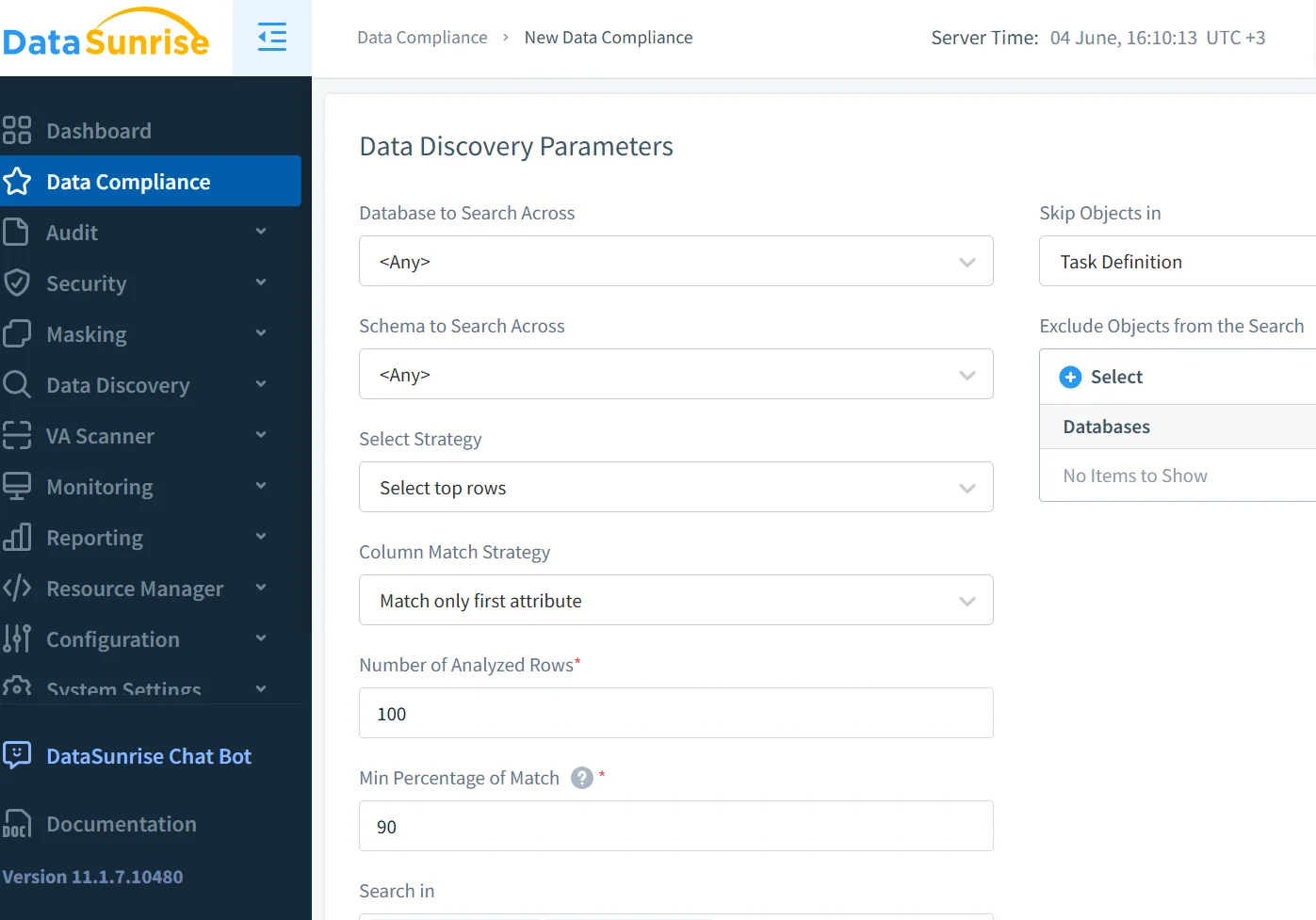

Applicazione delle Politiche di Sicurezza e Conformità per GenAI

Per allineare le implementazioni di GenAI con le politiche aziendali, integrale in una piattaforma di sicurezza dei dati in grado di:

| Capacità di Sicurezza | Descrizione |

|---|---|

| Monitoraggio degli Accessi al Modello | Registrazione in tempo reale di chi accede a cosa e quando |

| Prevenzione dell’Iniezione di Prompt e Abusi | Filtri e barriere per rilevare o bloccare input sospetti |

| Reportistica per Audit e Conformità | Genera report strutturati pronti per la conformità |

| Classificazione dei Campi e Tokenizzazione | Identifica e protegge automaticamente i campi sensibili |

Strumenti come il DataSunrise Compliance Manager automatizzano gran parte di questo lavoro.

Puoi anche fare riferimento al documento di IBM sui Principi di Governance dell’AI per una guida operativa più ampia.

Esempio: Bloccare l’Accesso dell’AI ai Campi Finanziari

Supponiamo che il tuo modello generativo interroghi un database PostgreSQL per record finanziari. Puoi impedire che i prompt dell’AI accedano mai a colonne come salary o card_number utilizzando una politica di mascheramento:

Tali controlli sono essenziali per mantenere i requisiti interni di conformità dei dati.

Minacce Moderne nella Sicurezza di GenAI

I sistemi AI affrontano nuove categorie di minacce:

- Iniezione di prompt: gli utenti inducono il modello a rivelare dati

- Fuga durante l’addestramento: dati sensibili vengono memorizzati durante il fine-tuning

- Accesso fantasma: query non autorizzate eseguite tramite wrapper AI

Prevenire queste minacce richiede analisi comportamentali, limitazione del tasso e modelli di rilevamento specificamente tarati per contesti GenAI. Tecniche come l’analisi del comportamento degli utenti aiutano a identificare anomalie nelle sessioni degli utenti.

Per approfondire, consulta l’OWASP’s LLM Top 10 e le note di OpenAI sulle best practice per la sicurezza.

Considerazioni Finali

Una valutazione moderna della sicurezza per i modelli di AI generativa deve andare oltre i controlli statici. Richiede una protezione dinamica, capacità di osservazione in tempo reale e applicazione contestuale delle politiche. Con gli strumenti giusti —dalla scoperta dei dati al mascheramento e ai trail di audit— le organizzazioni possono scalare l’uso di GenAI in sicurezza, senza compromettere la fiducia o la conformità.

Scopri come le funzionalità di sicurezza GenAI di DataSunrise supportano un’adozione dell’AI sicura e conforme su larga scala.