Gestione della Postura di Sicurezza in Ambienti AI e LLM

Nell’era della Generative AI (GenAI) e dei Large Language Models (LLM), i dati non sono solo una risorsa, bensì un partecipante attivo in ogni interazione. Questi modelli analizzano, memorizzano e rispondono alle richieste con una fluidità sorprendente, ma in questo processo diventano profondamente intrecciati con informazioni sensibili, regolamentate o proprietarie. La tradizionale lista di controllo per la sicurezza non è più sufficiente. Invece, è necessaria una strategia dinamica e adattiva — e tutto inizia con un focus sulla Gestione della Postura di Sicurezza in Ambienti AI e LLM.

Cosa rende la sicurezza in ambito AI e LLM diversa?

A differenza dei sistemi software statici, i LLM operano basandosi su risultati probabilistici derivati da enormi set di dati. Questo introduce nuove sfide. I dati di addestramento possono contenere Informazioni di Identità Personale (PII) o segreti commerciali. Gli output delle inferenze potrebbero accidentalmente rivelare tali informazioni. Prompt maligni possono addirittura innescare comportamenti imprevisti o dannosi. Questi rischi impongono che la gestione della postura di sicurezza si estenda all’intero ciclo di vita dell’AI — dall’ingestione e addestramento fino alla distribuzione e interazione con l’utente.

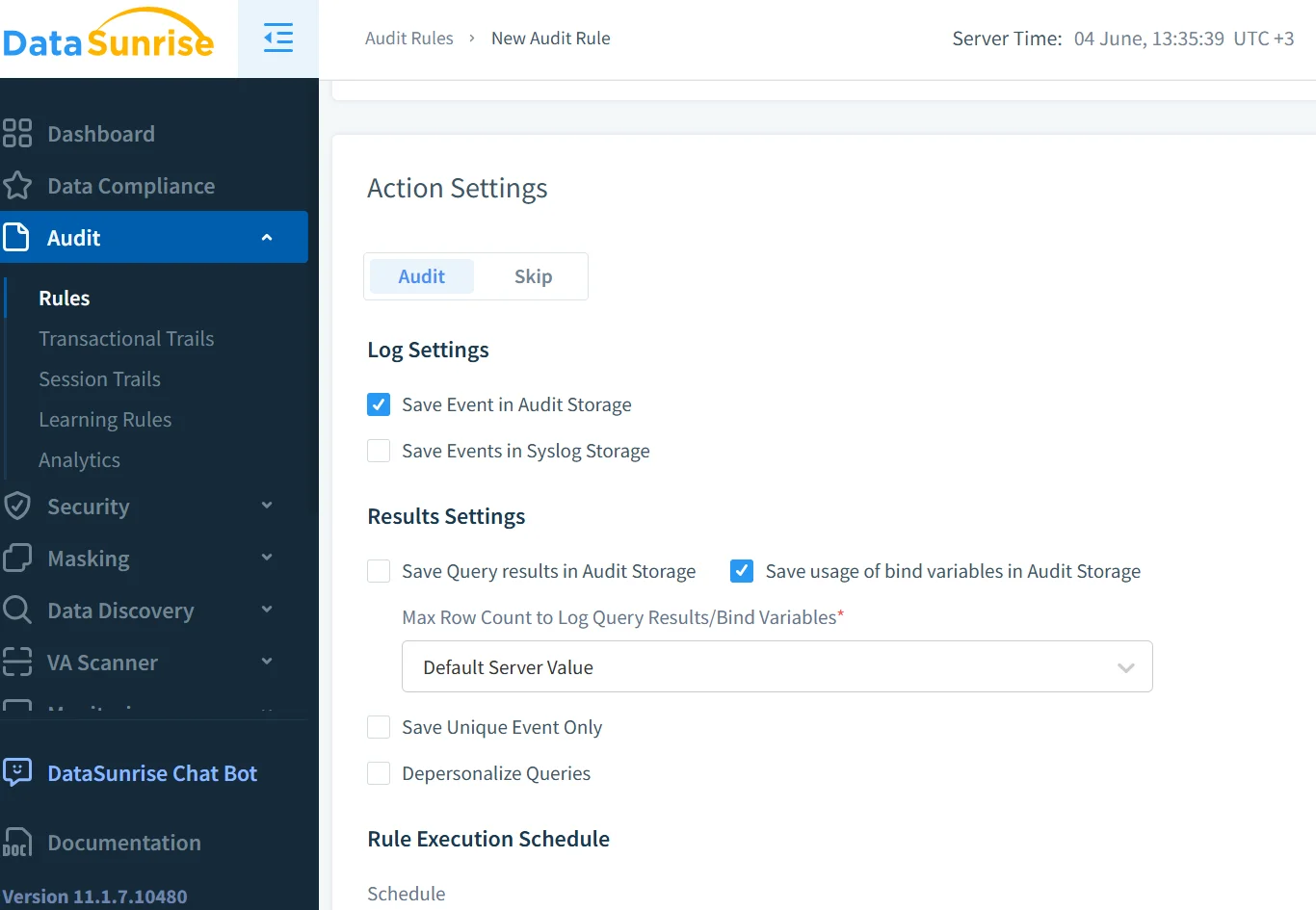

Audit in tempo reale per le interazioni LLM

I log di audit sono la spina dorsale di qualsiasi efficace struttura di gestione della postura. Ma nell’ambito della GenAI, abbiamo bisogno di capacità di audit in tempo reale che vadano oltre le operazioni di base. Ad esempio, considera questo modello di query in stile SQL per registrare l’accesso ai prompt dell’AI:

INSERT INTO audit_logs (user_id, prompt, timestamp, model_version)

SELECT CURRENT_USER, :prompt_text, NOW(), :model_id;

Associare questo a uno strumento di monitoraggio in tempo reale garantisce che le sottomissioni dei prompt, le completazioni e persino gli embedding vengano catturati, segnalati e gestiti. Con il monitoraggio dell’attività del database, i team di sicurezza possono essere allertati quando un prompt interagisce con dataset sensibili o genera output ad alto rischio.

Scoprire dati sensibili prima che raggiungano il tuo modello

I LLM hanno grandissima fame di dati, ma non tutti i dati dovrebbero essere alimentati in un modello. È qui che entra in gioco il data discovery. Esso consente alle organizzazioni di identificare, classificare e etichettare il contenuto sensibile prima ancora che entri nel flusso di addestramento. Uno scanner basato sul comportamento può segnalare credenziali in chiaro o frasi legate alla salute, assicurando che i dati problematici vengano messi in quarantena.

Gli strumenti di data discovery integrati nei pipeline aiutano a far rispettare i controlli degli accessi basati sui ruoli in modo che solo utenti autorizzati possano approvare i dataset. Piattaforme esterne come AWS Macie offrono anche una ispezione avanzata del contenuto per rilevare PII in grandi data lake.

Mascheramento dinamico per la protezione a livello di prompt

Un prompt come “Raccontami del mio account” può sembrare sicuro finché non recupera effettivi dettagli del cliente. Il mascheramento dinamico intercetta questo processo, rimuovendo o sostituendo in tempo reale i valori sensibili. Ciò impedisce che informazioni confidenziali fuoriescano durante i cicli di richiesta-risposta.

# Esempio: mascheramento del numero di account nel prompt prima di inviarlo al modello

if "account_number" in prompt:

prompt = prompt.replace(user_account_number, "***-****-1234")

Nei sistemi di generazione aumentata dal recupero (RAG), il mascheramento dinamico garantisce che i risultati dei documenti vettorializzati non reintroducano contenuti oscurati. LangChain supporta anche livelli di applicazione delle politiche per gestire input/output mascherati.

Costruire una strategia di sicurezza conforme e adattiva

La conformità alla sicurezza sta diventando centrale per il dispiegamento dei LLM. Regolamenti come il GDPR, l’HIPAA e le proposte normative per la governance dell’AI richiedono una chiara responsabilità.

Una solida postura di sicurezza include tracciamenti di audit, allarmi in tempo reale, mascheramento legato alle regole di conformità e report automatici. Il compliance manager di DataSunrise semplifica il monitoraggio delle violazioni. Allo stesso modo, il Secure AI Framework (SAIF) di Google fornisce principi per mettere in sicurezza gli ecosistemi AI.

Esempio: Mettere in sicurezza un assistente interno basato su RAG

Considera un assistente LLM aziendale che utilizza il RAG per rispondere a domande relative alle risorse umane. Un prompt come “Mostrami la suddivisione degli stipendi per i dirigenti” potrebbe far emergere informazioni riservate.

Per mitigare ciò:

- I log in tempo reale tracciano le query e rilevano le parole chiave.

- Il mascheramento rimuove i valori numerici nelle risposte.

- Il data discovery segnala file sensibili come i fogli di calcolo degli stipendi.

- Le regole di sicurezza restringono l’accesso in base al ruolo dell’utente.

Il sistema diventa consapevole del contesto e conforme, mantenendo sia funzionalità che sicurezza.

Il futuro della postura di sicurezza nella GenAI

La gestione della postura di sicurezza nei LLM deve evolversi insieme ai modelli stessi. Non si tratta solo di proteggere l’accesso con firewall; si tratta di progettare sistemi AI con una resilienza integrata. Ciò significa combinare tecniche classiche come la protezione dei dati con il rilevamento in tempo reale delle minacce e l’analisi del comportamento degli utenti.

Stanno emergendo ulteriori strumenti per colmare queste lacune, dai filtri per contenuti Azure AI di Microsoft all’AI costituzionale di Anthropic, che impone vincoli etici a livello di modello.

Le organizzazioni devono trattare la GenAI non come una scatola nera, ma come un sistema vivente. Il monitoraggio, l’audit, il mascheramento e la conformità devono far parte del processo di progettazione dell’AI.

Per ulteriori approfondimenti, consulta come DataSunrise supporta oltre 40 piattaforme database con strumenti di gestione della postura di sicurezza sia per i sistemi tradizionali che per quelli GenAI.