Come proteggere le pipeline dell’AI generativa

L’Intelligenza Artificiale Generativa (GenAI) ha rivoluzionato le industrie permettendo la creazione di testi, immagini e codice simili a quelli umani. Ma dietro l’innovazione si cela una pipeline di dati sensibili, modelli di ML e carichi di lavoro dinamici che sono sempre più vulnerabili a usi impropri. Proteggere queste pipeline è fondamentale per mantenere la privacy, garantire la fiducia e raggiungere la conformità.

Questo articolo esplora come proteggere le pipeline dell’AI generativa utilizzando audit in tempo reale, mascheramento dinamico dei dati e scoperta automatizzata dei dati. Include inoltre un esempio di base e link a ulteriori risorse.

Cosa rende vulnerabili le pipeline dell’AI generativa

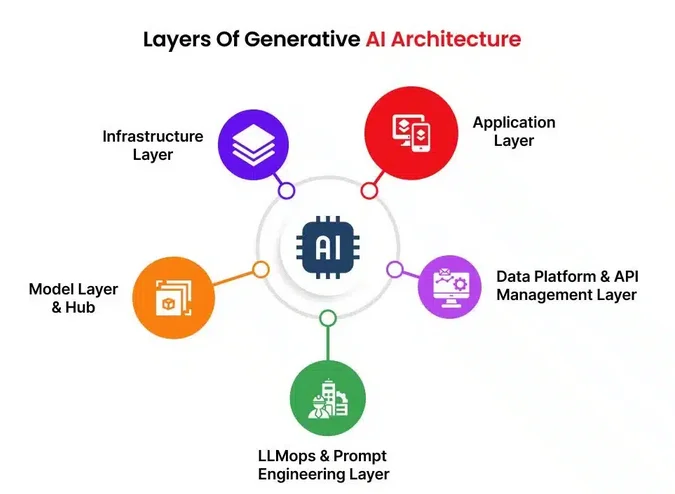

I workflow di GenAI generalmente prevedono l’addestramento e l’inferenza dei modelli utilizzando enormi dataset. Queste pipeline includono l’ingestione dei dati, la pre-elaborazione, l’hosting dei modelli, i prompt e gli output generati. In ogni fase possono essere esposti dati sensibili come informazioni personali identificabili (PII), proprietà intellettuale proprietaria o documenti finanziari.

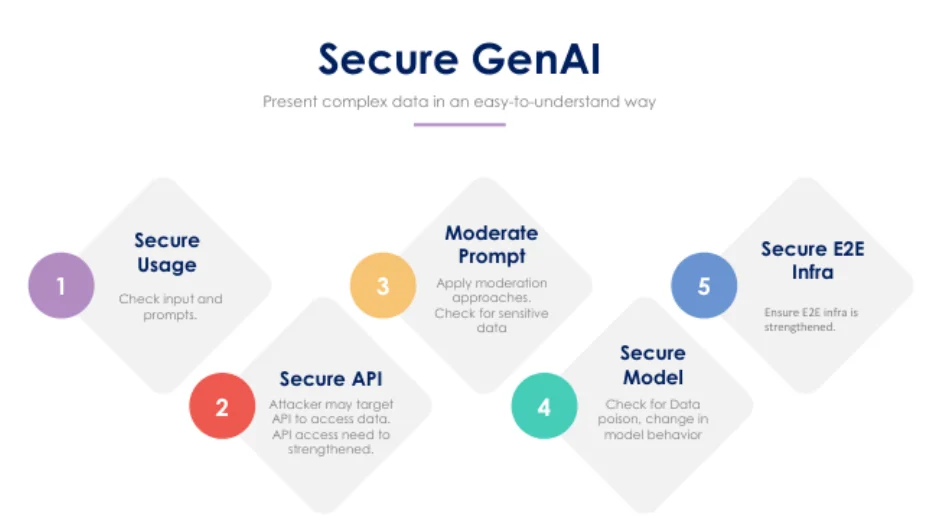

Tra le vulnerabilità tipiche vi sono le iniezioni di prompt, gli attacchi di jailbreak e l’esposizione di dati sensibili di addestramento o inferenza. Le pipeline spesso mancano di un controllo in tempo reale e soffrono di pratiche di controllo degli accessi insufficienti. Anche modelli LLM ben ottimizzati possono restituire frammenti di dati non intenzionali dalla memoria o generare output che violano i limiti di conformità.

Audit in tempo reale: la prima linea di difesa

L’audit in tempo reale consente alle organizzazioni di monitorare ogni accesso e azione che coinvolge dati, prompt o l’utilizzo dei modelli. Registrando query e interazioni degli utenti, si crea una traccia di responsabilità che supporta le indagini e rileva anomalie man mano che si verificano.

Un esempio base con PostgreSQL:

CREATE EVENT TRIGGER audit_prompt_access

ON sql_drop

EXECUTE FUNCTION log_prompt_usage();

Con uno strumento come DataSunrise Database Activity Monitoring, puoi espandere questo controllo per coprire l’analisi del comportamento, monitorare chi ha interrogato quale modello e ricevere avvisi su modelli di input rischiosi.

Mascheramento dinamico dei dati per gli input e gli output dei prompt

Il mascheramento a livello di prompt è cruciale quando si lavora con dati regolamentati. Ad esempio, un modello GenAI a cui viene richiesto di generare un rapporto non dovrebbe mai vedere i nomi reali dei pazienti. Il mascheramento dinamico nasconde o redatta i campi al momento della query, senza alterare i dati originali. Questo protegge le query di inferenza, previene perdite di output sensibili e riduce il raggio d’azione in caso di fuga di prompt o vulnerabilità della memoria.

Esempio:

SELECT name, diagnosis, treatment

FROM patients

WHERE region = 'EU'

MASKED WITH (name = 'XXXX', treatment = '***');

Strumenti come DataSunrise applicano regole dinamiche basate sui ruoli e sul contesto della query.

Scoperta automatizzata dei dati: sapere cosa è in gioco

Prima di proteggere GenAI, devi sapere ciò che stai proteggendo. Gli strumenti di scoperta dei dati esaminano automaticamente database e pipeline per rilevare informazioni personali identificabili (PII), informazioni sanitarie protette (PHI), dati PCI e qualsiasi contenuto non strutturato condiviso con LLM. Questi strumenti possono anche ispezionare lo storage blob o i database vettoriali per contenuti sensibili.

Sfruttando i motori di scoperta dei dati integrati con strumenti di sicurezza, le organizzazioni possono classificare gli asset e applicare automaticamente politiche di mascheramento o di logging appropriate.

Allinearsi alle normative sulla conformità dei dati

Che tu sia nel settore sanitario, finanziario o dell’ecommerce, l’utilizzo dell’AI generativa deve essere conforme alle leggi sulla protezione dei dati come il GDPR, l’HIPAA o il PCI DSS.

Per rimanere compliant, è importante applicare controlli di accesso basati sui ruoli, classificare i dati in base ai livelli di sensibilità e utilizzare trail di audit e tecniche di mascheramento per soddisfare le aspettative legali. I controlli di conformità in tempo reale fungono da salvaguardia, prevenendo potenziali violazioni prima che possano accadere.

Best practice per la sicurezza dell’AI generativa

L’utilizzo di reverse proxy o API gateway con filtraggio aiuta a controllare il traffico da e verso i modelli GenAI. Registrare ogni interazione con il modello e i dati a cui accede garantisce responsabilità. È altrettanto importante stabilire regole di alerting basate sul comportamento degli utenti e sugli input a rischio. I prompt e le risposte dovrebbero essere esaminati per rilevare PII e, ove possibile, i dati sintetici dovrebbero sostituire i dati reali nelle attività di addestramento del modello.

Considerazioni finali

Man mano che l’AI generativa diventa sempre più integrata nelle operazioni aziendali, la sua sicurezza deve essere trattata con lo stesso rigore dei sistemi IT tradizionali. Combinare audit in tempo reale, mascheramento, scoperta e applicazione della conformità crea una difesa robusta contro le violazioni dei dati e le sanzioni normative.

Per approfondire questi argomenti, esplora:

- Strumenti LLM e ML per la sicurezza dei database

- Guida all’audit

- Politiche di sicurezza per i database

Vedi anche questo articolo di OpenAI sull’allineamento per la sicurezza degli LLM e il Secure AI Framework (SAIF) di Google per concetti di sicurezza più ampi.