Come l’IA Generativa Sta Impattando sulle Pratiche di Sicurezza

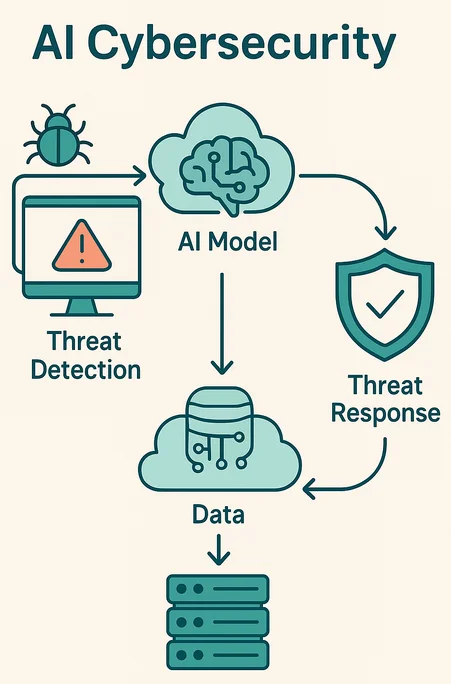

L’IA generativa (GenAI) sta trasformando il modo in cui le organizzazioni sviluppano software, gestiscono i dati e servono gli utenti. Ma con questa innovazione arrivano anche dei rischi. Poiché gli strumenti di GenAI generano testo, codice, immagini e decisioni, creano anche delle nuove superfici d’attacco. Comprendere come l’IA generativa sta impattando le pratiche di sicurezza è fondamentale per ogni organizzazione che gestisce dati sensibili o soggetti a normativa.

Un Nuovo Vettore di Attacco: Il Linguaggio come Superficie di Minaccia

La sicurezza tradizionale presume input prevedibili. La GenAI rompe questo schema. Elaborando i prompt umani, i modelli linguistici (LLM) aprono la porta ad iniezioni di prompt, esfiltrazione di dati e fughe accidentali. Un modello addestrato su dati proprietari potrebbe, se opportunamente stimolato, rigenerarli ed esporli.

A differenza delle query convenzionali, i prompt della GenAI possono attivare operazioni non intenzionali. Gli aggressori possono manipolare i prompt per aumentare i privilegi o recuperare contenuti sensibili usati nell’addestramento. Queste sfide richiedono un cambiamento nel modo in cui vengono applicate le politiche di sicurezza, soprattutto per i sistemi integrati con API di LLM.

Un’analisi approfondita degli attacchi tramite injection di prompt è stata esposta in questo articolo di OWASP, che evidenzia la difficoltà nel controllare il comportamento del modello quando gli input sono imprevedibili.

Audit in Tempo Reale per i Sistemi AI

I vecchi log di audit non catturano la sottigliezza dei prompt di GenAI. Non basta più registrare “query eseguita”: è necessario registrare il prompt completo, l’output e le azioni successive.

Strumenti moderni come i sistemi di audit in tempo reale per ambienti integrati con GenAI registrano ogni richiesta, inclusi prompt di input, contesto e risposte. Ciò migliora la visibilità, supporta le indagini forensi e aiuta a rilevare abusi sottili come attacchi di prompt engineering.

Piattaforme come DataSunrise Audit Logs si evolvono per gestire questi carichi di lavoro unici, consentendo ai team di monitorare l’attività guidata dall’IA con pieno contesto.

Mascheramento Dinamico al Momento della Generazione

Quando i LLM generano output, potrebbero includere informazioni personali o sensibili, specialmente se il modello è stato perfezionato su dataset interni. Qui entra in gioco il mascheramento dinamico.

Invece di mascherare solo i dati in input, la GenAI richiede il mascheramento a livello di output. Esso redige il contenuto al momento della risposta, filtrando dinamicamente i dati personali (PII) o i termini regolamentati. A differenza dei metodi statici, il mascheramento dinamico si adatta agli output imprevedibili e applica le politiche su tutti i contesti utente.

SELECT genai_response

FROM model_output

WHERE user_id = CURRENT_USER()

AND mask_sensitive(genai_response) = TRUE;

Una prospettiva più ampia su questo argomento è fornita nel rapporto di Google DeepMind sulla sicurezza dei LLM, che discute come la sicurezza delle risposte dipenda dal filtraggio in tempo reale del contenuto.

Scoprire i Rischi Nascosti nei Dati

Molti sistemi GenAI sono addestrati su dataset non classificati o scarsamente etichettati. Ciò porta all’esposizione accidentale di dati sensibili tramite query apparentemente innocue.

Strumenti per la scoperta dei dati aiutano a classificare i contenuti all’interno dei dati di addestramento, dei vettori e delle cronologie dei prompt. Essi identificano dati personali nelle embedding, individuano segreti commerciali memorizzati nella memoria contestuale e mettono in luce dataset non conformi che alimentano i flussi di lavoro della GenAI.

Questo livello di scoperta aiuta a far rispettare le normative sulla conformità dei dati come GDPR, HIPAA e PCI-DSS, specialmente quando il modello si riaddestra su dati in tempo reale. Per una guida pratica, il Framework di Gestione del Rischio dell’IA del NIST illustra le migliori pratiche per la classificazione e l’inventario dei dati.

La Sicurezza Reinventata per Flussi di Lavoro Guidati dai Prompt

I controlli di sicurezza devono tener conto del comportamento della GenAI. Invece dei ruoli e permessi statici, l’applicazione ora include il monitoraggio dei prompt, il filtraggio degli output e il controllo degli accessi basato sui ruoli (RBAC) per gli input AI.

Il rilevamento delle iniezioni SQL basato su pattern gioca anch’esso un ruolo

Il rilevamento delle minacce in tempo reale può individuare comportamenti insoliti nei prompt, come tentativi ripetuti di estrarre un nome o ricostruire record strutturati.

La Conformità alla Velocità della Generazione

In passato la conformità era reattiva: analizzare i log, eseguire audit, inviare report. La GenAI costringe i team di conformità ad agire in tempo reale. Con i LLM che generano risposte in millisecondi, l’applicazione delle politiche deve avvenire altrettanto rapidamente.

Le soluzioni automatizzate di gestione della conformità confrontano i prompt con le politiche, bloccano l’output quando necessario e attivano allarmi in tempo reale tramite strumenti come MS Teams o Slack.

Non si tratta solo di evitare sanzioni. Si tratta di fiducia. Quando un modello AI rivela informazioni su pazienti o storie finanziarie, il danno è immediato e irreversibile. La soluzione consiste nel prevenire le violazioni prima che l’output esca dal sistema.

Esempio: Blocco dei Prompt con l’Applicazione delle Politiche

Ecco un esempio semplificato di un filtro per prompt in pseudocodice:

if contains_sensitive_terms(prompt) or violates_compliance(prompt):

reject(prompt)

alert("Regola di conformità attivata")

else:

forward(prompt)

Tali regole possono integrarsi con le politiche di sicurezza per bloccare la generazione a livello di modello o middleware.

Uno Sguardo al Futuro: Modelli di Sicurezza nativi per l’IA

Le future piattaforme di sicurezza tratteranno la GenAI come un modello di minaccia di prim’ordine. Introdurranno nuovi controlli come firewall per i prompt, DLP semanticamente consapevoli e integrazione SIEM nativa per l’IA. Alcune piattaforme utilizzeranno politiche di mascheramento continuo guidate da apprendimento per rinforzo.

Per mantenersi all’avanguardia, i team di sicurezza devono considerare i sistemi GenAI come agenti probabilistici, e non come strumenti di fiducia. Ciò significa monitorare, far rispettare e porre limiti ad ogni interazione.

Integrando audit in tempo reale, mascheramento dinamico, scoperta e conformità consapevole dell’IA, le aziende possono sfruttare la GenAI senza compromettere l’integrità dei dati. Perché come l’IA generativa sta impattando le pratiche di sicurezza non è una tendenza: è il nuovo standard per la difesa digitale.