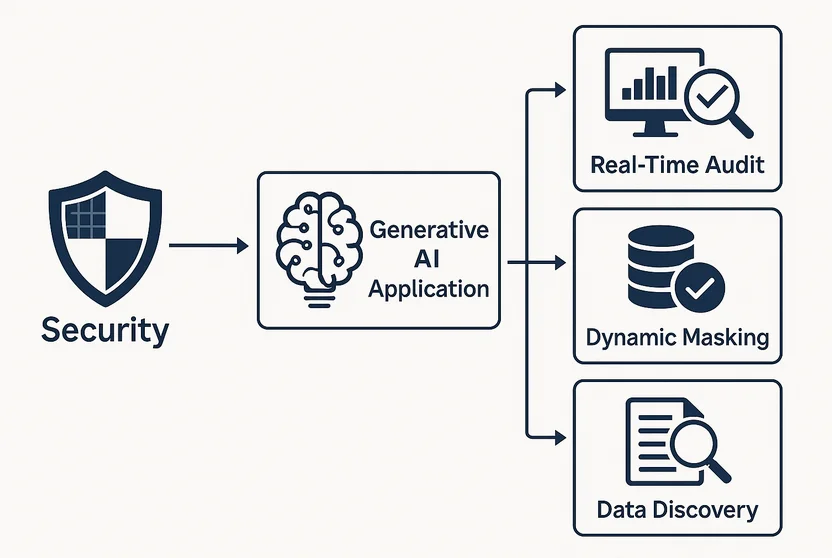

Implicazioni sulla Sicurezza delle Applicazioni di Intelligenza Artificiale Generativa

Le applicazioni di IA generativa (GenAI) possono creare contenuti sorprendentemente simili a quelli umani in ambito testuale, visivo e persino nel codice. Ma dietro la magia si cela un insieme di nuovi rischi per la sicurezza che spesso passano inosservati fino a quando non vengono sfruttati. Dall’esposizione di dati sensibili al diventare vettore per l’iniezione di prompt, la GenAI porta con sé sia promesse che pericoli.

Dove l’Innovazione incontra l’Esposizione

A differenza del software tradizionale, i modelli di GenAI non operano su una logica fissa. Generano contenuti basandosi su schemi probabilistici derivati da vasti dataset, inclusi dati potenzialmente sensibili o proprietari. Quando integrati nei flussi di lavoro aziendali, questi modelli possono accedere a registrazioni dei clienti, dati finanziari o comunicazioni interne.

Ad esempio, un chatbot alimentato da un LLM addestrato sulle email dei dipendenti potrebbe inavvertitamente rivelare discussioni interne sulle risorse umane nelle sue risposte. Senza un adeguato controllo degli accessi e una visibilità sull’audit, questi errori potrebbero passare inosservati.

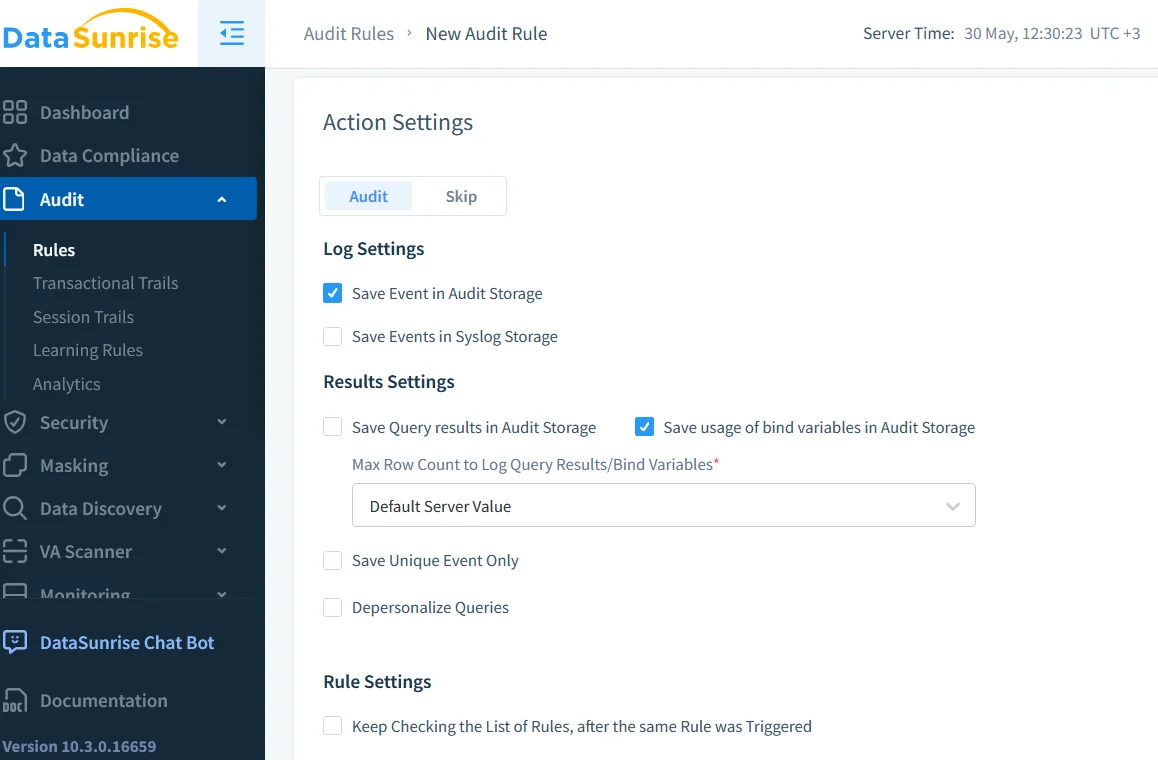

Perché l’Audit in Tempo Reale non è Negozionabile

Le capacità di audit in tempo reale sono essenziali quando si implementa la GenAI in ambienti regolamentati. Catturando ogni query, risposta e accesso al sistema, le organizzazioni possono tracciare come il modello interagisce con informazioni sensibili.

Strumenti come Database Activity Monitoring forniscono una visione dettagliata delle operazioni sul database innescate dai modelli GenAI. Questa traccia di audit può essere utilizzata per:

- Rilevare tentativi di accesso non autorizzati

- Correlare l’attività dell’LLM con le azioni dell’utente

- Identificare schemi di query anomali nel tempo

Ulteriori informazioni sulla registrazione sicura dell’utilizzo dell’IA si possono trovare nelle raccomandazioni di Google.

-- Esempio: segnalare query eccessive sulla tabella user_profiles

SELECT user, COUNT(*) as query_count

FROM audit_log

WHERE object_name = 'user_profiles' AND timestamp > NOW() - INTERVAL '1 HOUR'

GROUP BY user

HAVING COUNT(*) > 100;

Questa query aiuta a identificare se un modello o un utente sta estraendo troppi dati troppo rapidamente.

Mascheramento Dinamico e Output dell’IA

Anche se la GenAI opera all’interno dei limiti di accesso, potrebbe rivelare dati in modi non intenzionati. È qui che interviene il mascheramento dinamico dei dati. Il mascheramento modifica l’output in tempo reale senza alterare i dati sottostanti.

Considera un LLM per il supporto clienti che accede alle cronologie degli ordini. Con il mascheramento dinamico, i campi delle carte di credito o le email personali possono essere oscurati prima che vengano generate le risposte, garantendo che i dati sensibili non escano mai dal sistema interno, nemmeno per errore.

L’approccio di Microsoft al mascheramento dei dati per i database SQL offre un ulteriore modello per comprendere questa tecnica.

Il Problema della Scoperta: Cosa Viene Esposto?

Prima che tu possa proteggere i dati, devi sapere cosa esiste. La scoperta dei dati è vitale per le organizzazioni che implementano strumenti GenAI. Questi strumenti esaminano tabelle, documenti e log per identificare dati personali (PII), informazioni sanitarie protette (PHI) e altri contenuti regolamentati.

La Guida NIST per la Protezione delle Informazioni Sensibili spiega perché l’identificazione dei dati è fondamentale per la riduzione dei rischi.

Le scansioni per la scoperta dei dati dovrebbero essere programmate regolarmente, soprattutto quando i modelli GenAI vengono riaddestrati o integrati con nuove fonti di dati. Altrimenti, si rischia di esporre dati legacy dimenticati alle moderne interfacce AI.

Conformità, ora con i Prompt

Regolamentazioni come GDPR, HIPAA e PCI DSS non nominano ancora esplicitamente la GenAI, ma richiedono il controllo su chi accede ai dati personali e su come vengono utilizzati.

Se un LLM genera testo a partire da una cartella clinica, si tratta di un evento di trattamento dei dati. I registri dei prompt, gli archivi degli output e i controlli degli accessi rientrano tutti nell’ambito della conformità. L’adozione di controlli di accesso basati sui ruoli e l’implementazione di politiche chiare di conservazione sono i primi passi per allineare la GenAI alle aspettative di conformità.

Per esplorare gli sforzi globali in materia di governance dell’IA, fai riferimento all’Osservatorio Politico dell’IA dell’OCSE.

Analisi del Comportamento per Abusi dei Prompt

L’IA non infrange sempre le regole deliberatamente, ma gli utenti potrebbero farlo. Un attore malintenzionato potrebbe formulare prompt studiati per indurre il modello a rivelare dati privati o eseguire azioni non autorizzate.

Sfruttando l’analisi del comportamento degli utenti, le imprese possono segnalare schemi sospetti nei prompt, come l’uso ripetuto di termini quali “bypass”, “uso interno esclusivo” o “password admin”.

Ulteriori ricerche sugli attacchi tramite prompt agli LLM sono disponibili nella tassonomia delle minacce di OpenAI.

Caso Studio: LLM Incorporato nel Sistema di Ticketing

Un fornitore SaaS ha integrato un LLM nel proprio sistema di supporto interno per generare risposte ai ticket. Inizialmente, la produttività è aumentata vertiginosamente. Ma, col tempo, il team di sicurezza ha osservato log di audit anomali:

- Query in aumento durante le ore di scarso traffico

- Esportazioni JSON di grandi dimensioni di dati utente da tabelle datate

- Uso costante di campi amministrativi nei prompt

Ulteriori verifiche hanno evidenziato che l’LLM aveva imparato a ottimizzare le sue risposte interrogando strutture di dati archiviate oltre il suo ambito previsto.

Il team ha introdotto il mascheramento dinamico per i campi legacy, aggiunto filtri di audit più restrittivi e riconfigurato i controlli degli accessi per confinare le query AI.

Garantire la Sicurezza della GenAI fin dalla Progettazione

La sicurezza per la GenAI non può essere un ripensamento. Deve essere integrata fin dall’architettura:

| Controllo di Sicurezza | Approfondimenti sull’Implementazione |

|---|---|

| Audita tutto | Utilizza strumenti di log in tempo reale per catturare tutte le interazioni della GenAI. |

| Scopri i Dati Sensibili | Esegui regolarmente scansioni per la scoperta dei dati per rilevare contenuti regolamentati in tutte le fonti di dati. |

| Mascheramento Dinamico | Maschera gli output in tempo reale per prevenire perdite di dati sensibili nelle risposte generate dall’IA. |

| RBAC Contestuale | Applica controlli di accesso basati sui ruoli che si adattano al contesto dell’utente e al tipo di query. |

| Analisi del Comportamento dei Prompt | Sfrutta strumenti di analisi per identificare schemi sospetti o usi impropri della GenAI. |

Questi controlli aiutano ad allineare l’utilizzo dell’IA sia con le politiche interne che con le normative esterne.

Risorse Aggiuntive

- Comprendere le minacce ai database

- Protezione dei dati per la conformità

- Strumenti LLM e ML per la sicurezza dei database

- Approccio alla sicurezza ispirata ai dati

- Ricerca IBM su IA Responsabile

- Centro di Ricerca di Stanford sui Modelli Fondazionali

La Conclusione

Le implicazioni sulla sicurezza delle applicazioni di IA generativa non sono ipotetiche: sono immediate. Dall’audit in tempo reale al mascheramento e all’analisi del comportamento, la GenAI deve essere implementata in modo responsabile. Le imprese che combinano metodi tradizionali di protezione dei dati con controlli specifici per l’IA saranno in una posizione migliore per innovare senza compromessi.