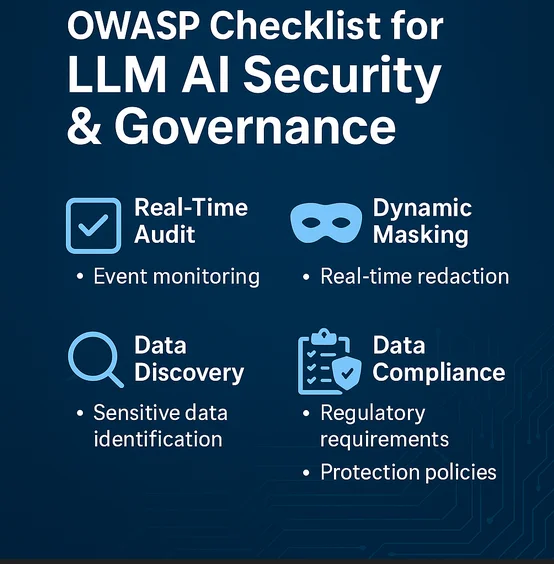

Checklist OWASP per la Sicurezza e la Governance dell’IA LLM

Con l’espansione dell’uso dei modelli linguistici di grandi dimensioni (LLM) nei framework aziendali per la sicurezza e la governance, la Fondazione OWASP ha iniziato a evidenziare le aree di criticità. Questo articolo esplora l’applicazione pratica della Checklist OWASP per la Sicurezza e la Governance dell’IA LLM, concentrandosi in particolare sulla verifica in tempo reale, la mascheratura dinamica dei dati, la scoperta dei dati, la sicurezza generale dei dati e la conformità alle normative.

Perché la Checklist OWASP è Importante per i Sistemi GenAI

Modelli LLM come GPT-4 e Claude vengono integrati in strumenti che analizzano i log, classificano le minacce o automatizzano la risposta agli incidenti. Tuttavia, questi modelli introducono nuovi rischi, tra cui attacchi di inversione del modello, iniezione di prompt, fuga di dati sensibili e uso improprio dei repository di dati interni. Il Top 10 OWASP per le applicazioni dei modelli LLM fornisce un framework per identificare e mitigare questi rischi. Integrare ciò con la governance aziendale assicura che la GenAI rimanga un vantaggio, e non un onere.

Verifica in Tempo Reale per l’Attività dell’IA e le Catene Decisionali

I modelli LLM operano spesso come scatole nere. Registrare i prompt degli utenti, le completazioni generate, le decisioni del modello e le ricerche di dati sul backend è fondamentale per l’audit. Sistemi di audit in tempo reale come DataSunrise Audit possono intercettare e registrare:

SELECT *

FROM vector_logs

WHERE embedding_model = 'GPT-4' AND confidence_score < 0.5;

Questa query di esempio può evidenziare output incerti o con bassa confidenza per una revisione. Sistemi come il Database Activity Monitoring consentono di etichettare e generare avvisi basati su pattern d’uso insoliti o su accessi a store vettoriali sensibili.

Mascheratura Dinamica nelle Query Generate dagli LLM

Quando un LLM genera dinamicamente query SQL, esiste il rischio concreto di esporre dati sensibili. L’uso della mascheratura dinamica garantisce che, anche se un prompt innesca un’operazione di recupero dati, informazioni personali identificabili (PII) come email o numeri di previdenza sociale rimangano offuscate.

Ad esempio:

SELECT name, MASK(email), MASK(phone_number)

FROM customers

WHERE interaction_type = 'chatbot';

Questo permette ai sistemi basati su GenAI di operare in sicurezza nelle applicazioni rivolte ai clienti senza violare gli obblighi di privacy.

Scoperta dei Dati e Filtraggio degli Input negli LLM

Una scoperta efficace dei dati aiuta a identificare quali parti del data warehouse o dello store vettoriale contengono record sensibili. Combinata con pipeline LLM, questa strategia garantisce che i prompt di input non recuperino o iniettino contesti non autorizzati.

OWASP raccomanda la classificazione e il filtraggio dei dati di addestramento e degli input a runtime per mitigare le fughe di dati. Strumenti come Amazon Macie, il motore di scoperta di DataSunrise e la scansione dei metadati vettoriali giocano un ruolo fondamentale.

Allineamento con le Politiche di Sicurezza e i Modelli di Minaccia

Secondo le linee guida di OWASP, la superficie di attacco degli LLM include API esposte, plug-in di terze parti, configurazioni insicure del modello e accessi al database troppo permissivi. La governance dovrebbe includere:

Limitare il contesto dell’output del modello tramite prompt di sistema.

Applicare controlli di accesso basati sui ruoli (RBAC).

Bloccare query pericolose utilizzando un Firewall per database.

OWASP raccomanda inoltre l’uso di analisi del comportamento per rilevare inondazioni o abusi di prompt.

Garantire la Conformità dei Dati nell’Uso dell’IA Generativa

La conformità rimane centrale quando la GenAI interagisce con dati protetti (GDPR, HIPAA, PCI DSS). Un compliance manager per le pipeline GenAI aiuta a mappare:

Quali tipi di dati vengono elaborati dal modello.

Se gli output vengono memorizzati o registrati.

Se le informazioni dedotte possono portare a re-identificare gli utenti.

In pratica, ciò comporta la configurazione di report automatizzati per la conformità e la combinazione degli approfondimenti ottenuti dall’audit trail con regole di mascheratura e filtraggio.

Punti di Riferimento Esterni

Diversi riferimenti esterni affrontano anche l’intersezione tra GenAI e la governance dei dati:

Il Framework NIST per la Gestione del Rischio dell’IA per una governance strutturata.

Lo Standard AI Responsabile di Microsoft per il dispiegamento di modelli di grandi dimensioni.

Le linee guida di AWS sul monitoraggio di Athena e la mascheratura per dataset accessibili all’IA.

Questi strumenti possono integrare i principi OWASP e contribuire a stabilire una sicurezza end-to-end per l’intero ciclo di vita dell’IA.

Conclusione

La Checklist OWASP per la Sicurezza e la Governance dell’IA LLM è più di un semplice documento di policy. Essa rappresenta un modello per ridurre i rischi, man mano che l’IA generativa si integra nelle operazioni di sicurezza, nel monitoraggio della conformità e nel processo decisionale. Con strumenti come DataSunrise Audit, la mascheratura dinamica e i motori di scoperta dei dati, le organizzazioni possono imporre dei confini al comportamento dell’IA pur continuando a beneficiare della sua potenza.

La governance dei dati deve evolversi insieme all’IA. Combinare il focus di OWASP con strumenti concreti rende tale evoluzione non solo possibile, ma anche pratica.