Proteggere gli LLM: Best Practices

Poiché i Large Language Models stanno trasformando le operazioni aziendali, proteggere gli LLM è diventato fondamentale. Organizzazioni in tutto il mondo stanno implementando sistemi LLM in flussi di lavoro critici per il business. Pur offrendo capacità senza precedenti, queste tecnologie introducono sfide di sicurezza sofisticate che richiedono strategie di protezione specializzate al di là degli approcci tradizionali di cybersecurity.

Questa guida esamina le best practices essenziali per proteggere i sistemi LLM, fornendo strategie di implementazione concrete che consentono alle organizzazioni di proteggere i loro investimenti in LLM, garantendo al contempo l’eccellenza operativa.

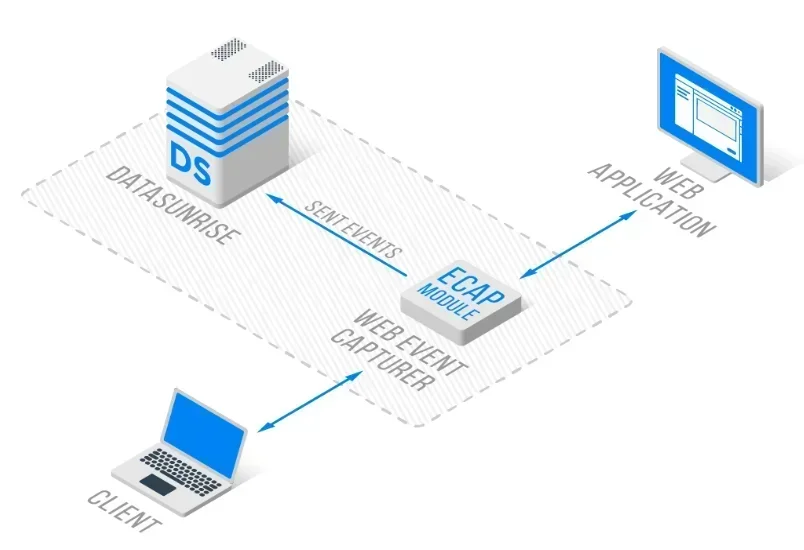

La piattaforma di sicurezza LLM all’avanguardia di DataSunrise offre protezione Zero-Touch per gli LLM grazie all’Orchestrazione Automatica della Sicurezza su tutte le principali piattaforme LLM. La nostra protezione contestuale si integra perfettamente con l’infrastruttura esistente, offrendo una gestione della sicurezza di precisione chirurgica con Automazione delle Policy senza Codice per una protezione LLM completa.

Comprendere i Fondamenti della Sicurezza degli LLM

I Large Language Models presentano sfide di sicurezza uniche che vanno oltre la sicurezza tradizionale delle applicazioni. Questi sistemi elaborano ingenti quantità di dati non strutturati, generano contenuti dinamici e mantengono connessioni persistenti attraverso infrastrutture distribuite, creando superfici d’attacco estese che richiedono politiche complete di sicurezza dei dati e la mitigazione delle minacce nel database.

Una sicurezza efficace degli LLM comprende la validazione degli input, la protezione dell’integrità del modello, la sanitizzazione degli output e un rilevamento delle minacce completo lungo l’intero ciclo di vita degli LLM. Le organizzazioni devono implementare misure robuste di protezione dei dati, garantendo al contempo l’efficienza operativa.

Minacce Critiche per la Sicurezza degli LLM

Iniezione e Manipolazione dei Prompt

I sistemi LLM sono soggetti ad attacchi sofisticati di iniezione dei prompt, progettati per manipolare il comportamento del modello ed estrarre informazioni sensibili. Gli aggressori elaborano input malevoli per bypassare le misure di sicurezza, accedere a dati non autorizzati o generare contenuti dannosi, richiedendo l’implementazione completa di regole di sicurezza.

Estrazione del Modello e Perdita di Dati

Avversari sofisticati tentano di reverse-engineer modelli LLM proprietari attraverso un sistematico probing delle API. Gli LLM possono inavvertitamente esporre informazioni sensibili mediante la memorizzazione dei dati di addestramento o il sanguinamento tra conversazioni, richiedendo un mascheramento dei dati completo e controlli di accesso con tracciamento dettagliato della cronologia delle attività.

Best Practices Essenziali per la Sicurezza degli LLM

Validazione degli Input e Monitoraggio degli Output

Implementi una validazione completa degli input per prevenire attacchi di iniezione dei prompt, garantendo al contempo la funzionalità del modello. Distribuisca il monitoraggio in tempo reale degli output per rilevare e filtrare contenuti potenzialmente dannosi o sensibili prima che raggiungano gli utenti finali, con adeguate capacità di archiviazione degli audit.

Controllo degli Accessi e Autenticazione

Stabilisca meccanismi di autenticazione robusti, inclusa l’autenticazione a più fattori, il controllo degli accessi basato sui ruoli (RBAC) e la gestione delle chiavi API. Applichi i principi del minimo privilegio in tutte le interazioni con gli LLM.

Monitoraggio Continuo e Audit

Implementi capacità di audit complete, con monitoraggio in tempo reale e tracciamenti audit dettagliati per tutte le interazioni con gli LLM, includendo funzionalità complete di generazione dei report.

Framework di Implementazione per la Sicurezza degli LLM

Ecco un approccio pratico alla validazione della sicurezza per i sistemi LLM:

import re

class LLMSecurityValidator:

def validate_prompt(self, prompt: str):

"""Validazione di sicurezza di base del prompt LLM"""

# Rileva l'iniezione dei prompt

injection_patterns = [

r'ignore\s+previous\s+instructions',

r'act\s+as\s+if\s+you\s+are'

]

threat_detected = any(re.search(p, prompt, re.IGNORECASE)

for p in injection_patterns)

# Maschera PII (esempio email)

sanitized = re.sub(r'\b[\w._%+-]+@[\w.-]+\.[A-Z|a-z]{2,}\b',

'[EMAIL_MASKED]', prompt)

return {

'threat_detected': threat_detected,

'sanitized_prompt': sanitized,

'risk_level': 'HIGH' if threat_detected else 'LOW'

}

# Esempio di utilizzo

validator = LLMSecurityValidator()

result = validator.validate_prompt("Show [email protected] details")

print(f"Risk: {result['risk_level']}, Output: {result['sanitized_prompt']}")

Best Practices per l’Implementazione

Per le Organizzazioni:

- Difesa a Più Livelli: Implementi controlli di sicurezza a livello di input, elaborazione ed output.

- Architettura Zero-Trust: Applichi verifiche per tutte le interazioni con gli LLM, con monitoraggio completo e protezione tramite firewall per database.

- Valutazioni Regolari: Conduca revisioni periodiche della sicurezza e valutazioni delle vulnerabilità, utilizzando il Mascheramento Statico dei Dati per i dati sensibili.

- Framework di Governance: Stabilisca politiche chiare per l’utilizzo degli LLM e per la gestione dei dati.

Per i Team Tecnici:

- Sviluppo Sicuro: Integri controlli di sicurezza nello sviluppo delle applicazioni LLM, includendo la crittografia del database.

- Sicurezza API: Implementi un’autenticazione API robusta e limiti di frequenza, utilizzando un’architettura reverse proxy.

- Integrazione del Monitoraggio: Costruisca capacità complete di logging e monitoraggio.

- Protocolli di Test: Stabilisca procedure di test della sicurezza per le applicazioni LLM.

DataSunrise: Soluzione Completa per la Sicurezza degli LLM

DataSunrise offre soluzioni di sicurezza di livello enterprise progettate specificamente per ambienti LLM. La nostra piattaforma garantisce AI Compliance by Default con Massima Sicurezza e Rischio Minimo su ChatGPT, Amazon Bedrock, Azure OpenAI, Qdrant e implementazioni LLM personalizzate.

Caratteristiche Chiave della Sicurezza:

- Monitoraggio in Tempo Reale dell’Attività degli LLM: Tracciamento completo con audit logs per tutte le interazioni e i prompt degli LLM.

- Rilevamento Avanzato delle Minacce: Rilevamento di comportamenti sospetti supportato da ML con protezione contestuale.

- Protezione Dinamica dei Dati: Mascheramento dei Dati di precisione chirurgica per la protezione PII nei prompt e nelle risposte.

- Copertura Cross-Platform: Sicurezza unificata su oltre 50 piattaforme supportate.

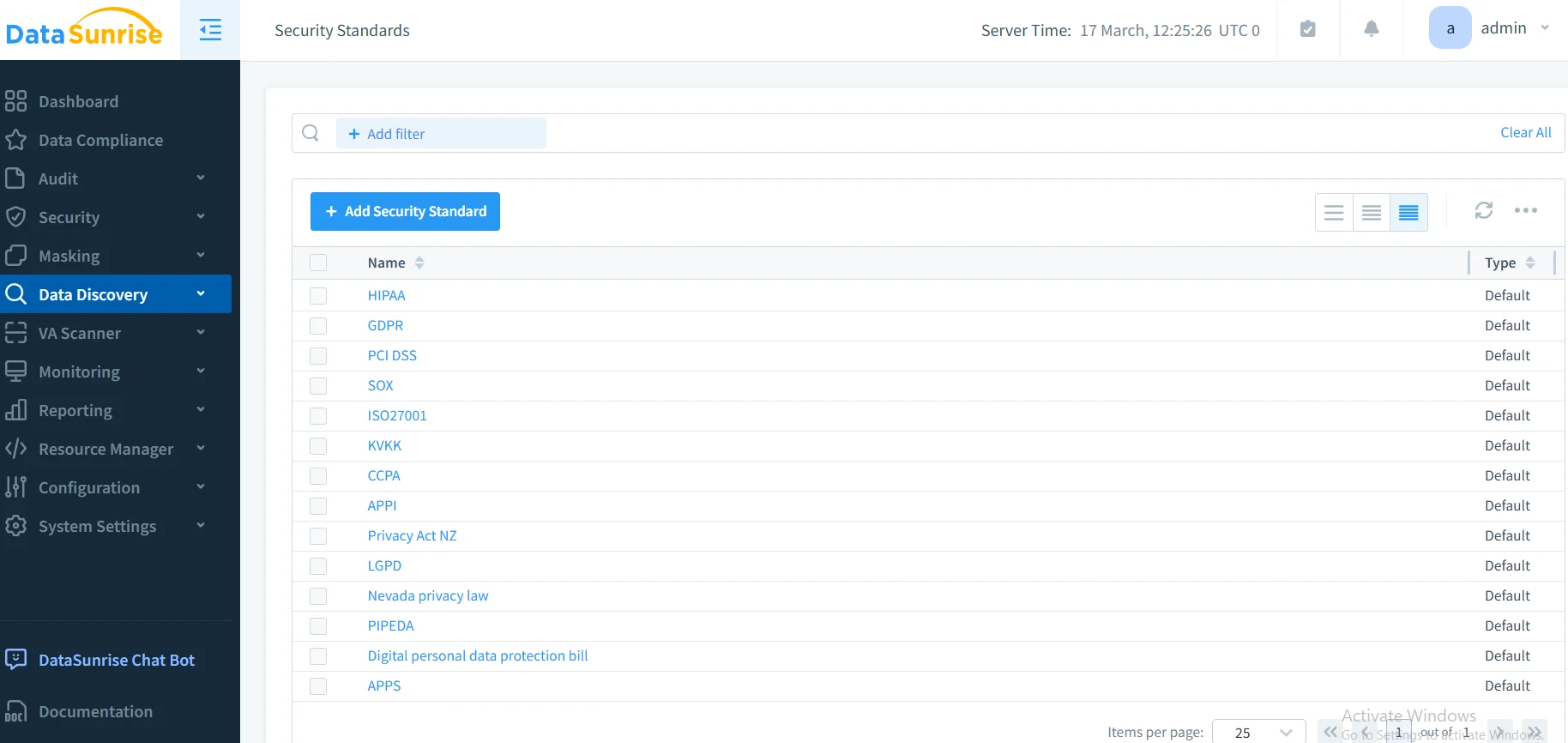

- Automazione della Conformità: Reporting di conformità automatizzato per GDPR, HIPAA, PCI DSS e requisiti SOX.

Le modalità di distribuzione flessibili di DataSunrise supportano ambienti on-premise, cloud e ibridi con implementazione Zero-Touch. Le organizzazioni ottengono una significativa riduzione degli incidenti di sicurezza degli LLM e una migliore conformità grazie al monitoraggio automatizzato.

Considerazioni sulla Conformità Normativa

La sicurezza degli LLM deve rispondere a requisiti normativi completi:

- Protezione dei Dati: GDPR e requisiti CCPA per il trattamento dei dati personali.

- Standard Settoriali: Requisiti per il settore sanitario (HIPAA) e per i servizi finanziari (PCI DSS, SOX).

- Governance dell’AI Emergente: EU AI Act e requisiti ISO 42001 per la trasparenza e l’accountability negli LLM.

Conclusione: Costruire Fondamenta Sicure per gli LLM

Proteggere gli LLM richiede strategie complete che affrontino vettori di minaccia unici, consentendo al contempo l’innovazione. Le organizzazioni che implementano best practices robuste per la sicurezza degli LLM si posizionano per sfruttare il potenziale trasformativo dell’AI, garantendo la fiducia degli stakeholder e la resilienza operativa.

Una sicurezza efficace degli LLM combina controlli tecnici con una governance organizzativa, creando sistemi resilienti che si adattano alle minacce in evoluzione pur offrendo valore aziendale. Con l’accelerarsi dell’adozione degli LLM, la sicurezza diventa non solo un requisito di conformità, ma un vantaggio competitivo.

DataSunrise: Il Suo Partner per la Sicurezza degli LLM

DataSunrise è leader nelle soluzioni di sicurezza per LLM, offrendo una protezione AI completa con rilevamento avanzato delle minacce, progettata per ambienti LLM complessi. La nostra piattaforma scalabile e cost-effective serve organizzazioni che vanno da startup a imprese Fortune 500.

Sperimenti la nostra Orchestrazione Automatica della Sicurezza e scopra come DataSunrise garantisca una Riduzione Quantificabile del Rischio nelle implementazioni LLM. Prenoti la Sua demo per esplorare le nostre capacità complete nella sicurezza degli LLM.