Misure di Sicurezza per Sistemi di IA Generativa

Man mano che l’IA generativa continua a plasmare settori che vanno dalla finanza all’assistenza sanitaria, le sue implicazioni in termini di sicurezza crescono altrettanto rapidamente. Questi sistemi elaborano enormi quantità di informazioni sensibili e, se lasciati non protetti, possono diventare una porta d’accesso a violazioni dei dati, attacchi di iniezione di prompt o esposizione non autorizzata delle informazioni. In questo articolo, esploriamo le misure di sicurezza essenziali per i sistemi di IA generativa, concentrandoci sull’audit in tempo reale, il mascheramento dinamico, la scoperta dei dati e l’applicazione della conformità, per garantire che questi potenti modelli operino in sicurezza.

Perché l’IA Generativa Richiede una Sicurezza Specializzata

A differenza delle applicazioni tradizionali, i sistemi di IA generativa apprendono da set di dati storici e interagiscono attraverso prompt aperti. Potrebbero accedere a input confidenziali degli utenti o a dati aziendali sensibili per produrre risposte. Questo modello di interazione introduce due rischi principali: la fuoriuscita non intenzionale di dati negli output del modello e l’accesso in ombra a database sensibili.

Per affrontare questi rischi, i controlli di sicurezza devono integrarsi direttamente con le pipeline dei dati dell’IA. Ciò include non solo il monitoraggio superficiale, ma anche tecniche contestualmente consapevoli come l’analisi comportamentale, il mascheramento dinamico dei dati e una gestione approfondita dei trail di audit.

Audit in Tempo Reale delle Interazioni IA

I log di audit in tempo reale costituiscono la base della sicurezza di qualsiasi sistema di IA. Ogni interazione—prompt inviato, modello utilizzato e fonte dei dati interrogata—dovrebbe essere tracciata con chiarezza. Questo permette ai team di sicurezza di ricostruire le attività e rintracciare comportamenti non autorizzati fino a specifici utenti o schemi di prompt.

Strumenti come il monitoraggio dell’attività dei database di DataSunrise consentono un tracciamento continuo e possono essere integrati con piattaforme SIEM per inviare allarmi in caso di anomalie. Tali anomalie possono includere numerosi tentativi di invio del prompt, tassi di query insoliti o accessi inattesi a colonne protette.

Esempio (cattura del log in stile PostgreSQL tramite trigger):

CREATE OR REPLACE FUNCTION log_prompt_event()

RETURNS TRIGGER AS $$

BEGIN

INSERT INTO ai_audit_log(user_id, prompt_text, access_time)

VALUES (current_user, NEW.prompt, NOW());

RETURN NEW;

END;

$$ LANGUAGE plpgsql;

Mascheramento Dinamico dei Dati nelle Pipeline IA

I modelli di IA generativa che lavorano con database in tempo reale possono involontariamente esporre informazioni private nelle loro risposte. Il mascheramento dinamico dei dati aiuta a prevenire ciò alterando la visualizzazione dei dati in base al contesto. Ad esempio, un modello che accede a un database finanziario potrebbe restituire valori mascherati come ****-****-****-1234 quando si fa riferimento a numeri di carta di credito, garantendo che il contenuto originale rimanga protetto.

Il mascheramento dinamico dei dati può essere applicato durante l’esecuzione delle query o nel livello di risposta del sistema IA. La documentazione di Microsoft sul DDM fornisce ulteriori indicazioni sull’implementazione.

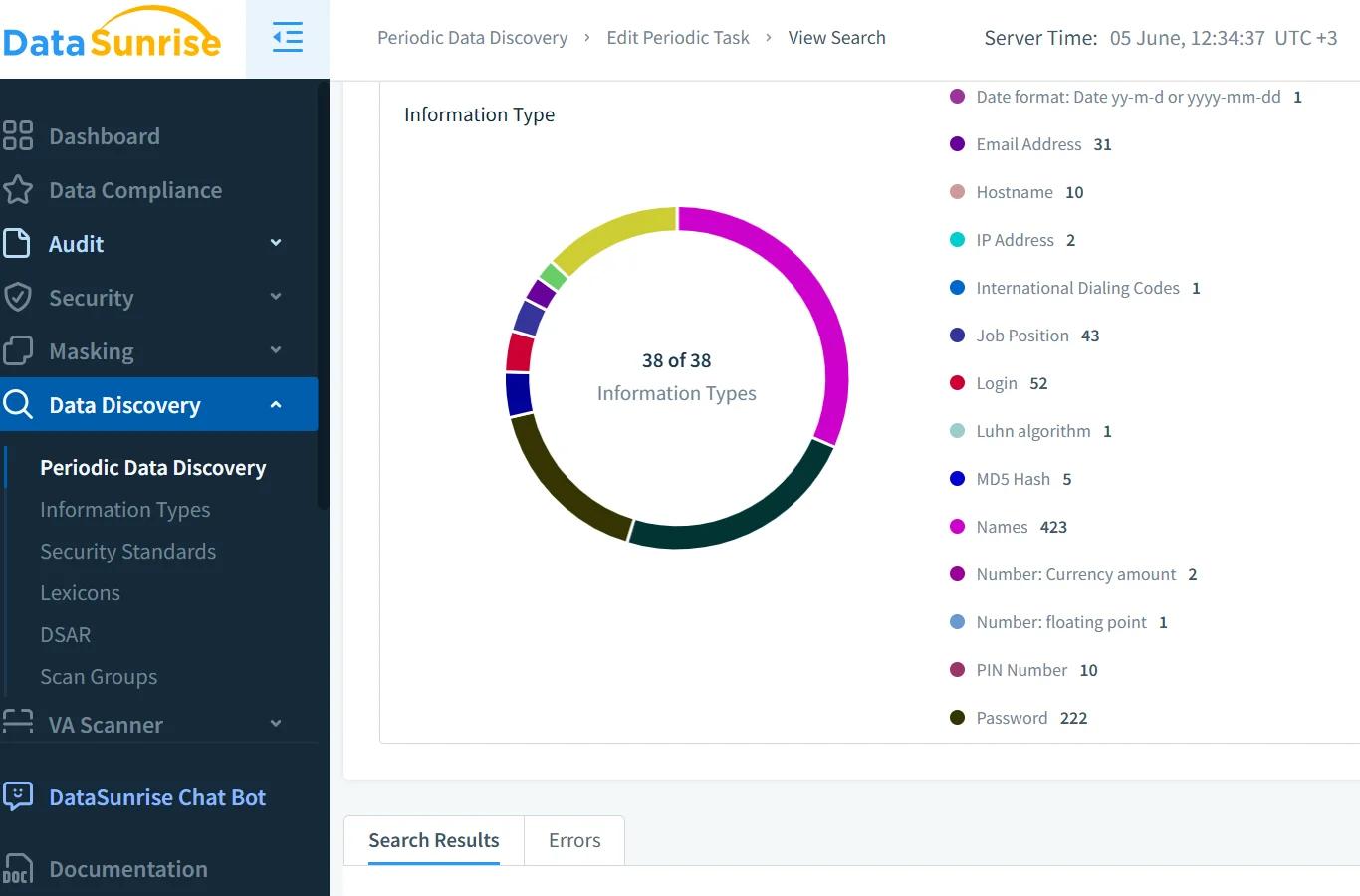

Scoperta e Classificazione dei Dati Prima dell’Accesso al Modello

Prima che i modelli generativi abbiano accesso a dati strutturati, è essenziale classificare il contenuto sensibile. Le informazioni di identificazione personale (PII), le informazioni sanitarie protette (PHI) e gli identificatori finanziari devono essere individuati in anticipo. Questo si ottiene tramite strumenti automatici di scoperta dei dati che ispezionano tabelle, colonne e contenuti dei file.

Con l’aiuto del motore di scoperta di DataSunrise e piattaforme native nel cloud come Google Cloud DLP, le organizzazioni possono etichettare sistematicamente i dati e assegnare politiche di gestione appropriate.

Applicazione della Conformità dei Dati nei Workflow LLM

L’IA generativa deve operare entro i limiti dei quadri normativi, come il GDPR, l’HIPAA e il PCI DSS. Queste norme dettano come i dati devono essere accessibili, mascherati, tracciati con audit e segnalati.

Il DataSunrise Compliance Manager semplifica l’applicazione della conformità mappando i privilegi di accesso ai requisiti specifici della normativa. Può anche generare report su misura per gli audit e segnalare le violazioni in tempo reale. Approcci complementari, come le linee guida etiche sull’IA di IBM, rafforzano il quadro per operazioni di IA trasparenti e responsabili.

Regole di Sicurezza e Governance degli Accessi

Gli ambienti di IA generativa traggono beneficio da politiche di sicurezza granulari. Oltre al tradizionale controllo degli accessi basato sui ruoli (RBAC), la sicurezza deve includere il riconoscimento delle intenzioni e il profilo comportamentale. Un utente che cerca di estrarre record privati tramite prompt ambigui, invece che tramite query esplicite, potrebbe bypassare i controlli superficiali.

Per questo motivo, sono fondamentali regole di mitigazione per attacchi di SQL injection potenziate e una sicurezza adattiva. Queste permettono ai sistemi di rilevare usi impropri analizzando gli schemi dei prompt, i tempi di accesso e le deviazioni dal comportamento di base.

Uno Sguardo al Futuro: IA più Intelligente, Sicurezza più Intelligente

Il futuro della sicurezza IA risiede nella consapevolezza contestuale. Database vettoriali, plugin di terze parti e interfacce di dati in streaming aprono nuove superfici di rischio. Per mitigarle, le organizzazioni stanno adottando il rilevamento di anomalie comportamentali, allarmi in tempo reale e filtri stratificati per gli output.

Risorse come il Dashboard per un’IA Responsabile di Microsoft e la metodologia delle system card di OpenAI aiutano i team a mappare gli schemi di accesso ai modelli. Piattaforme come DataSunrise supportano l’applicazione delle politiche e l’auditing all’interno di uno stack di sicurezza più ampio.

Conclusione

L’ascesa degli LLM ha ridefinito l’infrastruttura necessaria per garantire la sicurezza. Trail di audit solidi, mascheramento dinamico, scoperta dei dati sensibili e conformità in tempo reale sono ora elementi essenziali e non più opzionali.

Implementando queste misure di sicurezza per i sistemi di IA generativa, si pone le basi per un’IA responsabile e si riduce il rischio di conseguenze reputazionali o legali.

Esplora il knowledge center di DataSunrise e integra la tua strategia di sicurezza con framework quali NIST AI RMF, ISO/IEC 23894 o i Principi sull’IA dell’OCSE.