Mitigazione dei Rischi di Sicurezza dell’IA

Man mano che i modelli di intelligenza artificiale generativa (GenAI) diventano parte integrante dell’infrastruttura moderna, portano con sé nuovi vettori di esposizione alla sicurezza. Da query SQL hallucinate e perdite di dati non intenzionali a iniezioni di prompt dannose, la GenAI sta rimodellando il panorama dei rischi. I controlli di sicurezza tradizionali spesso non riescono a fornire una copertura sufficiente in ambienti in tempo reale in cui i modelli prendono decisioni autonome. Questo articolo esplora strategie pratiche per mitigare i rischi di sicurezza dell’IA attraverso difese stratificate come l’auditing in tempo reale, il masking dinamico, la scoperta dei dati e un rigoroso rispetto delle normative.

Perché la GenAI Presenta Sfide di Sicurezza Uniche

I sistemi GenAI operano su logiche probabilistiche, il che significa che possono generare output imprevedibili in base a prompt strutturati in modo approssimativo. Questi output possono includere dati sensibili dei clienti, informazioni personali identificabili (PII) o credenziali di accesso apprese durante il training o acquisite durante la concatenazione dei prompt. Peggio ancora, gli utenti che interagiscono con i sistemi GenAI potrebbero estrarre informazioni non autorizzate se non vengono applicate adeguate barriere di protezione.

Considera un caso in cui un agente GenAI genera query SQL per analizzare i dati degli acquisti dei clienti. Un prompt malevolo potrebbe indurlo ad eseguire la seguente query:

SELECT * FROM customers WHERE ssn IS NOT NULL;

Se questa query bypassa le regole di sicurezza, potrebbe far trapelare record sensibili. Ecco perché l’analisi contestuale e i controlli dinamici sono fondamentali per prevenire abusi.

Un altro esempio potrebbe riguardare tentativi di enumerare lo schema del database:

SELECT table_name FROM information_schema.tables WHERE table_schema = 'public';

Questo potrebbe esporre le strutture delle tabelle utili per attacchi successivi.

Auditing in Tempo Reale per i Sistemi IA

L’auditing in tempo reale è la prima linea di difesa per le implementazioni di GenAI. Esso cattura e registra interazioni, query e azioni conseguenti per identificare usi impropri o violazioni delle politiche. I log di audit giocano anche un ruolo cruciale nell’analisi forense e nella risposta regolamentare.

Strumenti come il motore di Audit Rule di DataSunrise permettono alle organizzazioni di definire trigger specifici per le query avviate tramite agenti GenAI. In combinazione con il monitoraggio dell’attività del database, questi log forniscono visibilità su come i modelli interagiscono con fonti di dati strutturate e non strutturate.

Ecco un esempio di pattern di regola di logging:

WHEN query_text LIKE '%ssn%' THEN log_event;

Masking Dinamico come Barriera di Sicurezza per l’IA

Uno dei modi più efficaci per prevenire l’esposizione di dati sensibili è mascherare dinamicamente l’output in tempo reale. A differenza del masking statico, che modifica i dati a riposo, il masking dinamico opera al volo. Ciò significa che campi sensibili come numeri di carte di credito, ID nazionali o indirizzi vengono sostituiti da valori segnaposto quando vengono accessi tramite interfacce basate su IA.

DataSunrise supporta politiche di masking dinamico che possono essere limitate in base a ruoli, contesto della query o origine dell’applicazione. In combinazione con interfacce LLM, queste politiche garantiscono che, anche se un prompt tenta di accedere a campi riservati, il modello visualizzi solo dati mascherati.

Esempio di regola di masking dinamico:

MASK COLUMN customers.credit_card USING 'XXXX-XXXX-XXXX-####';

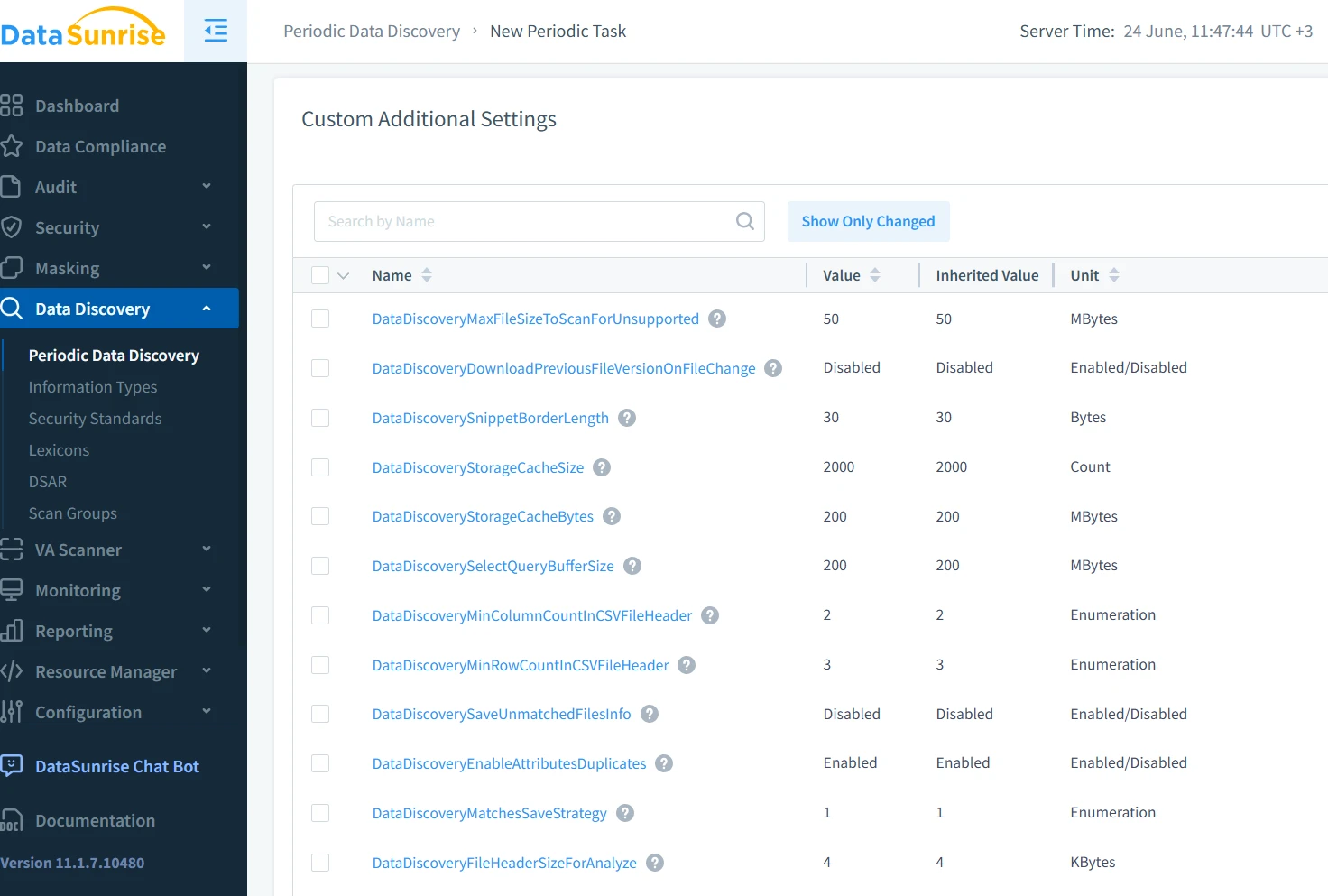

Scoperta dei Dati per la Mappatura dell’Accesso Sensibile IA

Prima di poter proteggere i dati da utilizzi impropri della GenAI, è necessario sapere dove essi risiedono. Gli strumenti di scoperta dei dati identificano e classificano i record sensibili in database, data lake e file system. Questo include sia campi strutturati (come nome e email) sia pattern semi-strutturati (come log e trascrizioni di chat).

L’automated data discovery aiuta a creare mappe di sensibilità contestuale che informano le politiche di accesso e guidano i limiti di interazione del modello. Questo approccio proattivo garantisce che sviluppatori e auditor comprendano quali dati il sistema IA potrebbe accedere durante il runtime.

Per esempio, una semplice scansione potrebbe identificare email tramite regex:

[A-Za-z0-9._%+-]+@[A-Za-z0-9.-]+\.[A-Za-z]{2,}

Applicazione della Sicurezza e della Conformità

La sicurezza dell’IA non riguarda solo la prevenzione delle perdite di dati; si tratta anche di rispettare gli standard legali e normativi. Framework come GDPR, HIPAA e PCI-DSS ora richiedono una protezione continua dei dati, controllo degli accessi basato sui ruoli e log verificabili—requisiti che si applicano altrettanto ai sistemi gestiti dall’IA.

L’integrazione di una piattaforma di automazione della conformità garantisce il monitoraggio e l’applicazione in tempo reale di questi standard in tutte le interazioni con gli utenti, comprese le sessioni GenAI. Questo consente alle organizzazioni di implementare politiche come l’accesso con il minimo privilegio, limitare l’ambito dei dati sensibili e assicurare la tracciabilità a valle.

Esempio di restrizione per ruoli:

GRANT SELECT ON orders TO analyst_role;

REVOKE SELECT ON customers FROM analyst_role;

Utilizzando il compliance reporting automatizzato, i team di sicurezza possono generare log pronti per l’audit che dettagliano ogni interazione dell’IA con dati regolamentati, riducendo gli sforzi manuali e gli errori umani negli audit di sicurezza.

Combinare le Misure per una Difesa Stratificata

Ciascuno di questi meccanismi—auditing in tempo reale, masking, scoperta dei dati e conformità—offre una protezione parziale. Ma se combinati, formano una difesa stratificata molto più resiliente. Questo è particolarmente importante nei contesti GenAI dove nessun singolo controllo può prevedere o prevenire completamente comportamenti a rischio.

Immagina questo flusso: un LLM genera un prompt per una query SQL; il sistema audita la richiesta, applica il masking sui campi contenenti PII, filtra i dati e registra l’interazione. Nel frattempo, i motori di conformità controllano eventuali violazioni delle politiche. Questo approccio olistico mitiga i rischi senza ostacolare l’innovazione.

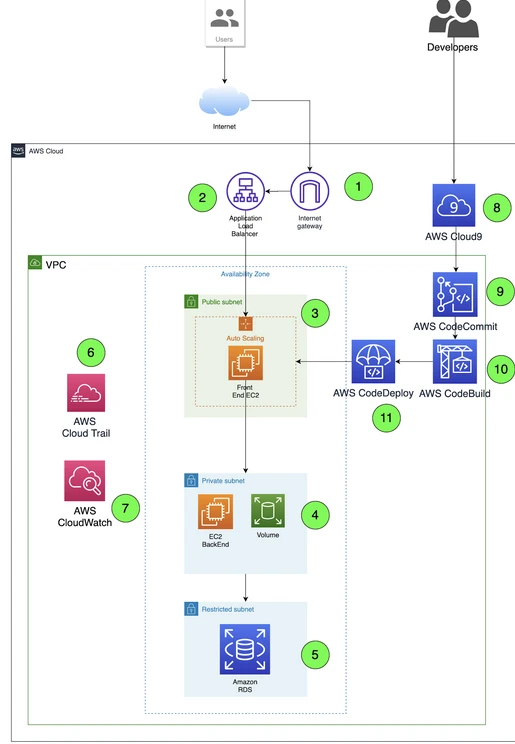

Pratiche Esterne e Prospettive Future

Oltre alle protezioni in-platform, le migliori pratiche fornite da vendor cloud come AWS Macie e SecurityHub stanno evolvendo per affrontare le problematiche della GenAI. Questi servizi si integrano con strumenti come Lake Formation o CloudTrail per monitorare l’uso dei dati sensibili e il comportamento degli utenti nei workflow IA.

Man mano che la sicurezza dell’IA evolve, anche gli strumenti che utilizziamo devono evolversi. La sfida non è solo tecnica, ma anche filosofica. Come possiamo mettere in sicurezza sistemi che ragionano e si adattano autonomamente? Tutto inizia con la consapevolezza, gli strumenti adeguati e una progettazione proattiva delle politiche.

Conclusione

La GenAI sta trasformando le industrie, ma sta anche rimodellando il panorama delle minacce. Mitigare i rischi di sicurezza dell’IA richiede più dei tradizionali firewall o dei ruoli utente—richiede una strategia contestualmente consapevole e multilivello. Auditing in tempo reale, masking dinamico, scoperta dei dati e strumenti di conformità automatizzati come quelli di DataSunrise sono essenziali per mettere in sicurezza le infrastrutture potenziate dall’IA, senza soffocare il loro potenziale.