Rischi e Mitigazioni degli LLM secondo OWASP

La crescente attenzione verso i modelli linguistici di grandi dimensioni (LLM) ha rivoluzionato il modo in cui le organizzazioni interagiscono con i dati, automatizzano le decisioni ed estraggono informazioni. Tuttavia, questa capacità trasformativa porta con sé un nuovo insieme di rischi in materia di sicurezza e conformità. La Top 10 di OWASP per le applicazioni LLM evidenzia queste vulnerabilità e offre strategie di mitigazione fondamentali per qualsiasi organizzazione che utilizzi l’intelligenza artificiale generativa.

Questo articolo esamina tali rischi con un focus pratico sull’audit in tempo reale, il mascheramento dinamico, la scoperta dei dati e su come mantenere la conformità dei dati negli ambienti alimentati da GenAI.

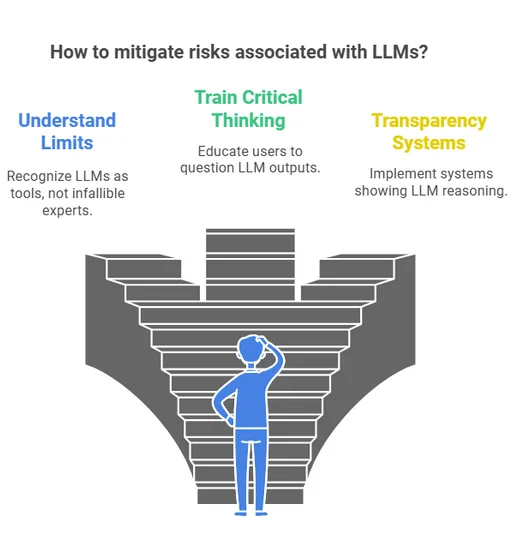

Comprendere il panorama: Categorie di rischi degli LLM

OWASP categorizza i rischi specifici degli LLM in ambiti quali l’iniezione di prompt, la fuoriuscita dei dati, l’uso improprio del modello, i plugin non sicuri e l’avvelenamento dei dati di addestramento. Queste minacce sfruttano proprio i punti di forza della GenAI—la sua adattabilità e il suo apprendimento contestuale—e potrebbero indurre il modello a bypassare le salvaguardie interne e a far trapelare output sensibili.

Audit in tempo reale: Osserva tutto, rispondi immediatamente

Mitigare i rischi negli ambienti LLM dinamici inizia dalla visibilità. Le capacità di audit in tempo reale consentono alle organizzazioni di monitorare query, risposte e schemi di accesso ai dati non appena si verificano. Strumenti come DataSunrise Audit Logs possono segnalare immediatamente tentativi non autorizzati di accesso ai dati o pattern di prompt sospetti.

Ad esempio, una regola di sicurezza potrebbe rilevare tentativi ripetuti di enumerare campi sensibili dello schema e attivare allarmi tramite Slack o MS Teams:

{

"event_type": "tentativo_di_query",

"query": "SELECT * FROM information_schema.columns WHERE ...",

"action": "allerta_e_blocca"

}

Con il supporto per notifiche in tempo reale e regole di audit basate sull’apprendimento, i team possono adattare la logica di audit alle minacce in evoluzione degli LLM.

Mascheramento dinamico: Non limitarti a bloccare, oscura

Il mascheramento dinamico dei dati protegge le informazioni personali identificabili (PII) e i campi sensibili durante le interazioni con gli LLM senza compromettere la funzionalità dell’applicazione. Invece di rimuovere completamente l’accesso, sostituisce i valori reali con segnaposti mascherati.

Ad esempio, la risposta a una query vettoriale:

SELECT name, credit_card_number FROM customers LIMIT 1;

potrebbe restituire:

John Doe | XXXX-XXXX-XXXX-1234

Questa capacità è fondamentale per casi d’uso che coinvolgono l’augmentazione dei prompt o RAG (Retrieval-Augmented Generation), dove l’LLM deve recuperare e sintetizzare i dati aziendali senza violare le norme sulla privacy. Il mascheramento dinamico in DataSunrise consente politiche personalizzate a seconda del ruolo o del comportamento del modello.

Scoperta dei dati: Conosci ciò che hai prima che lo facciano gli LLM

Prima di implementare le misure di sicurezza per gli LLM, è essenziale comprendere dove risiedono i dati sensibili. È qui che entrano in gioco gli strumenti di scoperta dei dati automatizzata.

Mappare le risorse dati in fonti non strutturate, database relazionali e indici vettoriali può aiutare a dare priorità ai controlli e a ridurre l’esposizione. L’integrazione con le pipeline degli LLM assicura che solo i dati conformi e classificati siano idonei per l’augmentazione o l’inferenza.

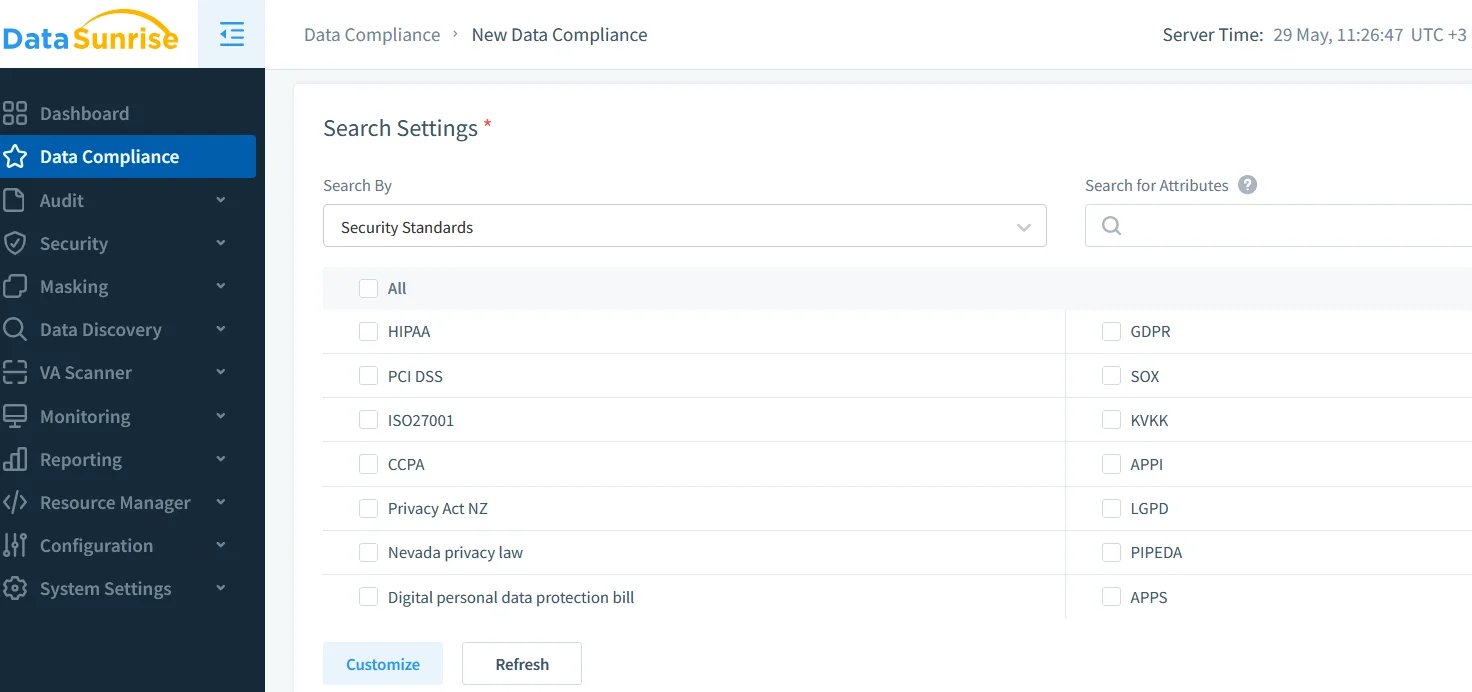

Conformità dei dati: Allineare l’uso degli LLM agli standard globali

GDPR, HIPAA, PCI DSS e altre normative si applicano indipendentemente dal fatto che i dati siano trattati da esseri umani o da macchine. Per questo motivo, integrare gli LLM nei flussi di lavoro dei dati richiede tracciabilità, controllo degli accessi e percorsi di audit chiari.

Soluzioni come il DataSunrise Compliance Manager offrono un cruscotto centralizzato per gestire artefatti di conformità, politiche di mascheramento e output di audit. Questo aiuta le organizzazioni a superare gli audit e a dimostrare un uso responsabile degli LLM.

Inoltre, il supporto per il GDPR e per l’HIPAA è integrato nei livelli di audit e di mascheramento, garantendo che gli output degli LLM non trapelino informazioni sanitarie o personali protette.

Interfacce di prompt sicure e controlli basati sui ruoli

Applicare il controllo degli accessi basato sui ruoli (RBAC) garantisce che i prompt provenienti da diversi tipi di utenti (amministratore, analista, API esterna) siano gestiti da politiche differenti. Combinato con tecniche di sicurezza ispirate ai dati, questo aiuta ad allineare l’uso degli LLM agli standard di livello enterprise.

Sistemi di plugin sicuri, ambienti di esecuzione in sandbox e regole di sicurezza contro l’iniezione SQL giocano anch’essi un ruolo fondamentale nella protezione contro gli exploit comuni degli LLM.

Conclusione: Un futuro equilibrato, auditato e mascherato per la GenAI

L’integrazione della GenAI negli ambienti aziendali è inevitabile, ma deve essere realizzata in modo responsabile. Adottando il framework di rischio per gli LLM di OWASP, implementando audit in tempo reale, applicando il mascheramento dinamico, abilitando una scoperta completa dei dati e rispettando le norme di conformità, le organizzazioni possono sbloccare in sicurezza tutto il potenziale dell’intelligenza artificiale generativa.

Per saperne di più su come costruire sistemi GenAI sicuri con audit e mascheramento, esplora le nostre risorse su Database Activity Monitoring e Data Security.