Principali Aziende di Sicurezza LLM

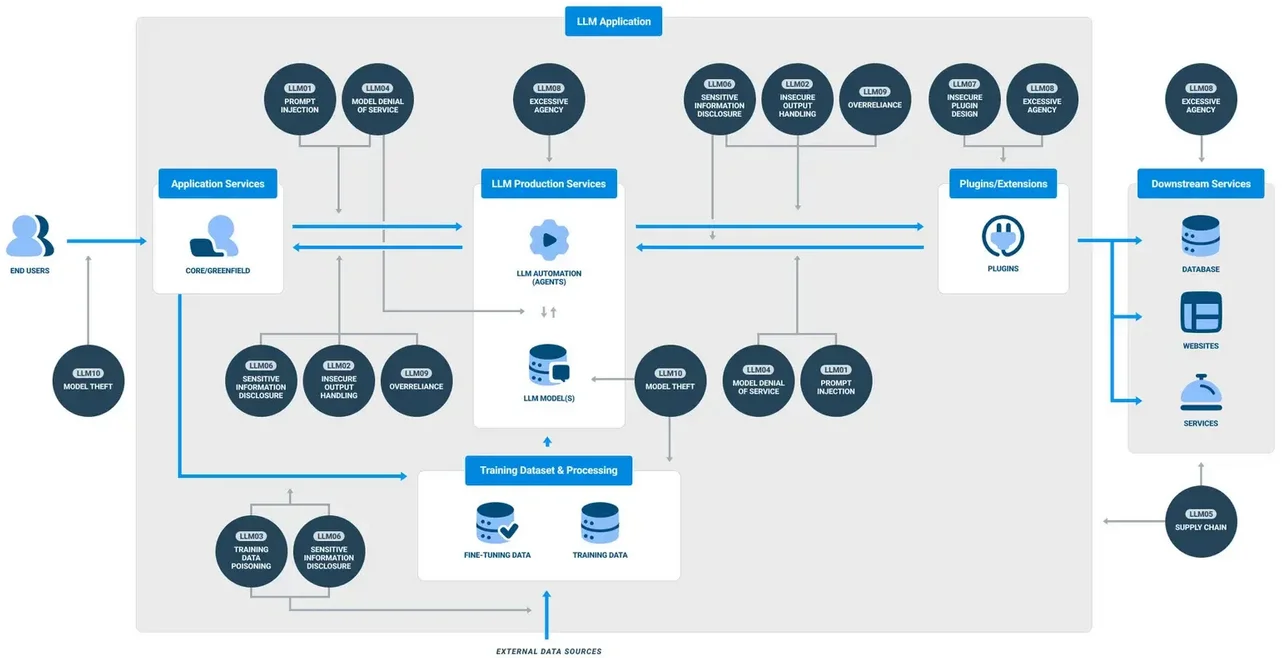

Man mano che i sistemi di intelligenza artificiale generativa (GenAI) diventano fondamentali nei flussi di lavoro aziendali, cresce la necessità di una sicurezza robusta e in tempo reale. Questi grandi modelli linguistici (LLM) elaborano enormi quantità di informazioni sensibili, dai dati dei clienti agli algoritmi proprietari. Con minacce che vanno dall’iniezione di prompt alla fuga di dati, le organizzazioni si stanno rivolgendo a piattaforme avanzate specializzate nell’osservabilità degli LLM, nell’audit, nel mascheramento e nella conformità. In questo scenario, diversi fornitori si distinguono. Questo articolo esplora le Aziende di Sicurezza LLM Leader e come esse consentano un’adozione sicura della GenAI grazie a capacità fondamentali come l’audit in tempo reale, il mascheramento dinamico e l’applicazione automatizzata della conformità.

Proteggere la GenAI: Le Basi Tecniche

La sicurezza degli LLM va oltre la crittografia dello storage o l’abilitazione di log di base. Una pipeline GenAI sicura richiede una visibilità completa, dall’input del prompt fino alla risposta finale dell’LLM, insieme all’applicazione in linea delle politiche e alla classificazione dei dati. Ciò include:

- Audit in tempo reale delle interazioni degli utenti e delle decisioni dell’LLM

- Mascheramento dinamico dei dati personali identificabili (PII/PHI) durante l’inferenza

- Scoperta e classificazione dei dati prima dell’ingestione del modello

- Politiche di accesso che si evolvono con i modelli di utilizzo

- Workflow di conformità allineati a standard come il GDPR o l’HIPAA

Secondo il MIT Sloan, una pratica fondamentale consiste nel considerare gli LLM sia come superfici di rischio che come endpoint intelligenti.

Vediamo come i principali fornitori di sicurezza in questo settore soddisfino queste esigenze.

DataSunrise: Politiche Granulari per Pipeline LLM e Database

Inizialmente focalizzata sulla sicurezza dei database, DataSunrise ha esteso le proprie capacità per supportare la sicurezza della GenAI. Il suo motore di audit in tempo reale consente alle organizzazioni di tracciare le query LLM inviate tramite SQL incorporato o API connesse ai prompt. Il mascheramento viene applicato dinamicamente in base al ruolo dell’utente e al contesto delle regole, utilizzando flessibili regole di mascheramento dinamico. Queste politiche si adattano in base all’analisi comportamentale e al contesto di accesso.

La scoperta dei dati è anche un punto di forza. La piattaforma scansiona automaticamente gli archivi di dati strutturati e semi-strutturati per identificare dati personali o campi sensibili prima che raggiungano le fasi di addestramento o inferenza del modello. Combinata con politiche di sicurezza e tecniche di ottimizzazione dello storage degli audit, DataSunrise garantisce che le implementazioni GenAI rimangano verificabili, mascherate e conformi negli ambienti di produzione.

-- Esempio: Applicare il mascheramento dinamico su una colonna accessibile da un LLM

CREATE MASKING RULE mask_llm_sensitive_data

ON schema.customer_data (ssn, email)

WHEN ROLE IN ('llm_user', 'analyst')

USING 'XXXX-XX-####', '***@example.com';

Securiti.ai: Intelligenza dei Dati Autonoma per GenAI

Securiti offre una piattaforma cloud per il controllo dei dati basata sull’IA che automatizza la scoperta, la classificazione e la governance degli accessi in ambienti ibridi. Le sue soluzioni sono sempre più impiegate nelle pipeline GenAI, dove gli sviluppatori perfezionano i modelli sui dati aziendali o collegano gli LLM ai flussi di lavoro analitici.

Avvisi di conformità in tempo reale, mascheramento supportato dalla classificazione e politiche di accesso governate dall’IA sono tra gli aspetti fondamentali. L’integrazione di Securiti con strumenti nativi del cloud come Snowflake, Azure SQL e Cosmos DB garantisce l’applicazione senza interruzioni degli standard di GDPR e HIPAA, dalla fase di inferenza a quella di archiviazione.

La piattaforma è stata recentemente riconosciuta nel Forrester Wave per il Software di Gestione della Privacy per la sua leadership nell’applicazione automatizzata delle politiche.

Duality Technologies: Collaborazione GenAI a Salvaguardia della Privacy

Duality si concentra sulla collaborazione sicura dei dati e sull’addestramento dell’IA tramite crittografia omomorfica e calcolo multiparte sicuro. Pur non essendo uno strumento completo di protezione degli LLM, Duality consente casi d’uso in cui la GenAI viene addestrata su dataset condivisi senza esporre informazioni grezze. Questo è cruciale per i settori dei servizi finanziari o della sanità, dove la conformità con il PCI-DSS o le leggi sulla localizzazione dei dati è particolarmente rigida.

IDC segnala che l’apprendimento federato e il calcolo a protezione della privacy stanno guadagnando terreno nelle iniziative di governance dell’IA, con Duality tra i fornitori di punta.

HiddenLayer: Rilevamento delle Minacce Specifiche per il ML

HiddenLayer offre una piattaforma di sicurezza su misura per i sistemi di machine learning. Per le organizzazioni che implementano LLM, essa offre protezione contro prompt avversari, estrazione del modello e attacchi di evasione. Lo strato di monitoraggio in tempo reale della piattaforma è in grado di rilevare anomalie negli output della GenAI o nel comportamento di accesso, attivando difese automatizzate.

Sebbene HiddenLayer non esegua nativamente la scoperta dei dati o il mascheramento, il suo focus di nicchia sulla sicurezza dei modelli di IA durante e dopo l’addestramento lo rende un candidato forte per ambienti ad alto rischio. Il suo motore di rilevamento è allineato con il NIST AI Risk Management Framework, migliorando così le pratiche di garanzia del modello.

Proteggere il Futuro: Best Practice Oltre gli Strumenti

La scelta della piattaforma giusta è fondamentale, ma garantire la sicurezza della GenAI richiede anche pratiche operative ben definite. Alcuni spunti:

- Scansionare e classificare sempre i dati di input prima dell’addestramento (approfondisci)

- Abilitare l’audit ad ogni punto di invocazione del prompt (guida all’audit)

- Utilizzare un approccio alla sicurezza ispirato ai dati per definire mascheramenti adattivi (approfondisci)

- Allineare i log degli LLM con le politiche di conformità e le tempistiche di conservazione (approfondisci)

Ulteriori approfondimenti da Google DeepMind illustrano perché il perfezionamento, le protezioni di sicurezza e i loop di audit continui siano essenziali per garantire la sicurezza degli LLM in contesti ad alto rischio.

I team di sicurezza devono considerare gli LLM come consumatori e generatori dinamici di dati, richiedendo non solo difese perimetrali, ma anche una profonda osservabilità e un’applicazione granulare degli accessi.

Conclusione

Con l’accelerazione dell’adozione degli LLM, le imprese devono adattare la propria infrastruttura di sicurezza ai nuovi rischi e alle pressioni normative. Le Aziende di Sicurezza LLM Leader presentate qui – DataSunrise, Securiti.ai, Duality e HiddenLayer – offrono diversi punti di forza. Che si tratti di audit, mascheramento, collaborazione crittografata o rilevamento delle minacce, ciascuna fornisce salvaguardie essenziali su misura per i carichi di lavoro della GenAI. Un approccio stratificato che combini queste capacità rappresenta il metodo più efficace per proteggere l’intelligenza artificiale generativa negli ambienti aziendali.

Proteggi i tuoi dati con DataSunrise

Metti in sicurezza i tuoi dati su ogni livello con DataSunrise. Rileva le minacce in tempo reale con il Monitoraggio delle Attività, il Mascheramento dei Dati e il Firewall per Database. Applica la conformità dei dati, individua le informazioni sensibili e proteggi i carichi di lavoro attraverso oltre 50 integrazioni supportate per fonti dati cloud, on-premises e sistemi AI.

Inizia a proteggere oggi i tuoi dati critici

Richiedi una demo Scarica ora