Privacy dei Dati AI Spiegata

Introduzione

I sistemi di AI generativa come ChatGPT, Azure OpenAI e Qdrant stanno trasformando le industrie – dall’automazione del servizio clienti all’accelerazione dei flussi di lavoro creativi. Ma con un grande potere viene una grande responsabilità: come possono le aziende assicurarsi che i dati sensibili non vengano divulgati attraverso questi sistemi? In questa guida analizziamo i rischi, le soluzioni e gli strumenti per proteggere i Suoi dati nell’era dell’AI.

I Rischi Nascosti dell’AI Generativa

I modelli di AI generativa elaborano enormi quantità di dati, inclusi dati sensibili. Ecco dove possono verificarsi problemi:

1. Perdite Casuali di Dati

I modelli di AI possono inavvertitamente “ricordare” e ripetere dati sensibili dai loro set di addestramento. Ad esempio:

- Un chatbot sanitario potrebbe rivelare i record dei pazienti.

- Un assistente di programmazione potrebbe esporre algoritmi proprietari.

Questo rischio si intensifica quando i modelli vengono ottimizzati su set di dati interni. Senza adeguate misure di sicurezza, anche query apparentemente innocue potrebbero innescare divulgazioni involontarie.

2. Abuso del Modello e Prompt Injection

Gli aggressori possono manipolare i sistemi di AI per far rivelare segreti:

- Attacchi “DAN” (Do Anything Now): Superamento delle barriere etiche per estrarre dati riservati.

- Violazione del Copyright: Generazione di codice proprietario o di testi protetti da copyright.

- Estrazione dei Dati: Indurre i modelli a divulgare frammenti dei dati di addestramento.

3. Output Dannosi da una Scarsa Ottimizzazione

I modelli ottimizzati senza controlli di sicurezza possono produrre output parziali, non etici o non conformi. Ad esempio:

- Generare raccomandazioni di assunzione discriminatorie.

- Divulgare Informazioni Personali Identificabili (PII).

Come i Database Si Intersecano con i Rischi per la Privacy nell’AI

L’AI generativa non opera in isolamento: si basa sui database per i dati di addestramento, le query in tempo reale e l’archiviazione degli output. Le vulnerabilità comuni includono:

| Rischio per il Database | Impatto sull’AI |

|---|---|

| PII non mascherati nei dati di addestramento | I modelli di AI apprendono e replicano informazioni sensibili |

| Controlli di accesso insufficienti | Utenti non autorizzati sfruttano le API dell’AI |

| Transazioni non tracciate | Nessuna visibilità sui contenuti generati dall’AI |

Ad esempio, se un’AI per il servizio clienti preleva dati da un database SQL con sicurezza debole, gli aggressori potrebbero usarlo come via d’accesso per estrarre record sensibili.

Mitigare i Rischi per la Privacy nell’AI: Un Quadro in 3 Passi

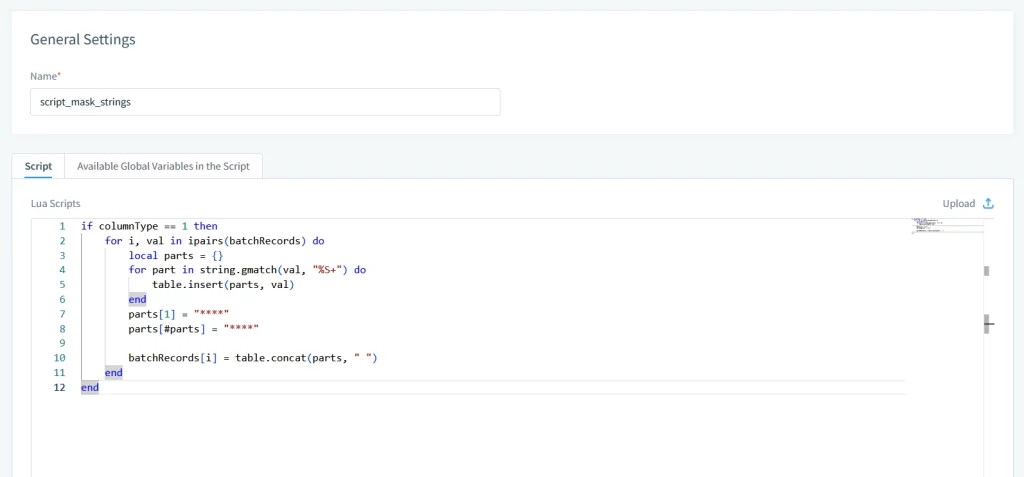

1. Sanitizzazione degli Input e Mascheramento dei Dati

Prima che i dati raggiungano i modelli di AI, sanitizzi gli input utilizzando:

- Mascheramento Statico dei Dati e Mascheramento Dinamico dei Dati: Sostituire i valori sensibili con dati realistici ma fittizi.

- Controlli di Accesso Basati sui Ruoli (RBAC): Limitare quali campi dati i sistemi di AI possono accedere.

2. Validazione degli Output e Tracce di Audit

Monitora e registra ogni interazione con l’AI:

- Filtri Regex: Bloccare gli output che contengono numeri di carte di credito o email.

- Log di Audit: Tracciare chi ha utilizzato l’AI, cosa ha richiesto e cosa è stato generato.

3. Ottimizzazione Fine-Tuning con Barriere di Sicurezza

Durante la personalizzazione dei modelli, includa controlli di sicurezza:

- Rilevamento dei Bias: Segnalare linguaggio discriminatorio.

- Allineamento alla Conformità: Assicurarsi che gli output rispettino il GDPR o l’HIPAA.

DataSunrise: Proteggere l’AI Generativa a Ogni Livello

La nostra piattaforma fornisce una sicurezza unificata sia per i database tradizionali che per i sistemi di AI moderni. Ecco come proteggiamo i Suoi dati:

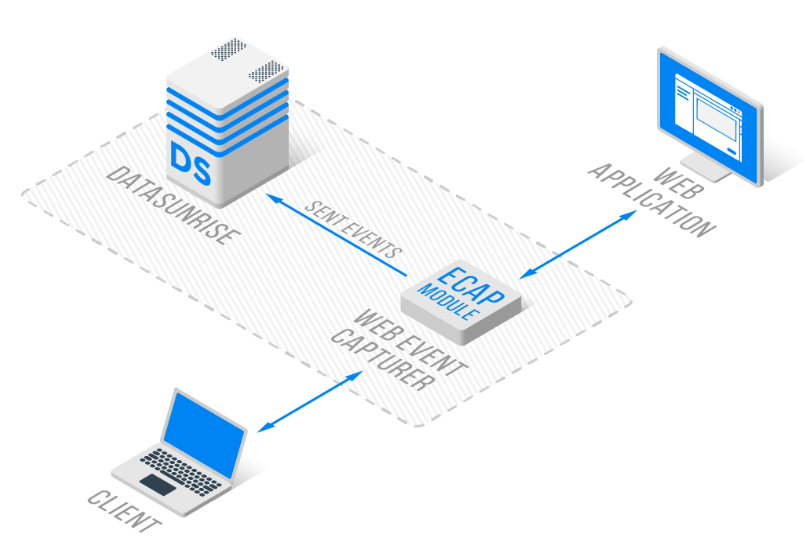

1. Audit Specifici per l’AI e Monitoraggio

- Tracce Transazionali: Catturare ogni interazione con ChatGPT o Azure OpenAI in log standardizzati.

- Avvisi in tempo reale: Ricevere notifiche per prompt sospetti o perdite di PII utilizzando Database Activity Monitoring.

2. Mascheramento dei Dati per l’Addestramento dell’AI

- Mascheramento in loco: Anonimizzare i set di dati di addestramento senza spostarli.

- Redazione Dinamica: Rimuovere dati sensibili dalle query in tempo reale dell’AI.

3. Automazione della Conformità

4. Supporto Cross-Piattaforma

- Database: MySQL, PostgreSQL, Neo4j, Cassandra e altri 40+.

- AI Generativa: ChatGPT, Qdrant e Azure OpenAI

Perché gli Strumenti di Sicurezza Tradizionali Non Sono Sufficenti

Gli strumenti per database legacy mancano di funzionalità specifiche per l’AI:

| Capacità | Strumenti Tradizionali | DataSunrise |

|---|---|---|

| Audit dei prompt per l’AI | ❌ No | ✅ Sì |

| Mascheramento Dinamico dei Dati | Base | Avanzato (regex + NLP) |

| Copertura cross-piattaforma | Limitata | 40+ database + sistemi AI |

Iniziare con la Privacy dei Dati nell’AI

- Condurre una Valutazione del Rischio

Identifichi dove l’AI interagisce con dati sensibili utilizzando Data Discovery. - Implementare Barriere di Sicurezza

Applichi le Security Rules per le API dell’AI e i database. - Formare il Suo Team

Educhi i dipendenti sulle Security Policies per l’utilizzo dell’AI.

Parola Finale: Equilibrare Innovazione e Sicurezza

L’AI generativa sblocca un valore immenso, ma solo se le aziende danno la priorità alla privacy dei dati. Integrando pratiche di sicurezza robuste e strumenti come DataSunrise, le organizzazioni possono mitigare i rischi promuovendo al contempo l’innovazione.

Scopra come la nostra piattaforma protegge i Suoi flussi di lavoro AI: