Proteggere gli ingressi e le uscite dei modelli AI

I sistemi GenAI non solo trasformano il modo in cui i dati vengono elaborati, ma mettono in discussione come viene garantita la sicurezza. A differenza delle applicazioni statiche, i modelli AI si adattano in tempo reale agli input, generando output che spesso bypassano la revisione di sicurezza tradizionale. Se stai integrando LLM nei flussi di lavoro, trascurare la sicurezza degli ingressi e delle uscite non è più un’opzione. Ecco come le organizzazioni possono mitigare i rischi mantenendo i sistemi GenAI funzionali e conformi.

Perché è importante il percorso di input e output

Gli LLM non si limitano a rispondere alle domande: interpretano, ricostruiscono e talvolta allucinano dettagli sensibili. Un input filtrato in modo inadeguato può estrarre informazioni private, mentre un output non monitorato potrebbe divulgare dati regolati dalle norme di conformità.

Considera questo input apparentemente innocuo:

"Dammi una ripartizione di tutti i reclami dei clienti dell'UE."

Senza misure di protezione, questo potrebbe innescare una divulgazione non autorizzata dei dati. Ciò che sembra un output utile potrebbe contenere informazioni personali identificabili (PII) o dati sanitari. In tali ambienti, la sicurezza deve coprire sia il canale di input che quello di output.

Catturare il contesto con audit in tempo reale

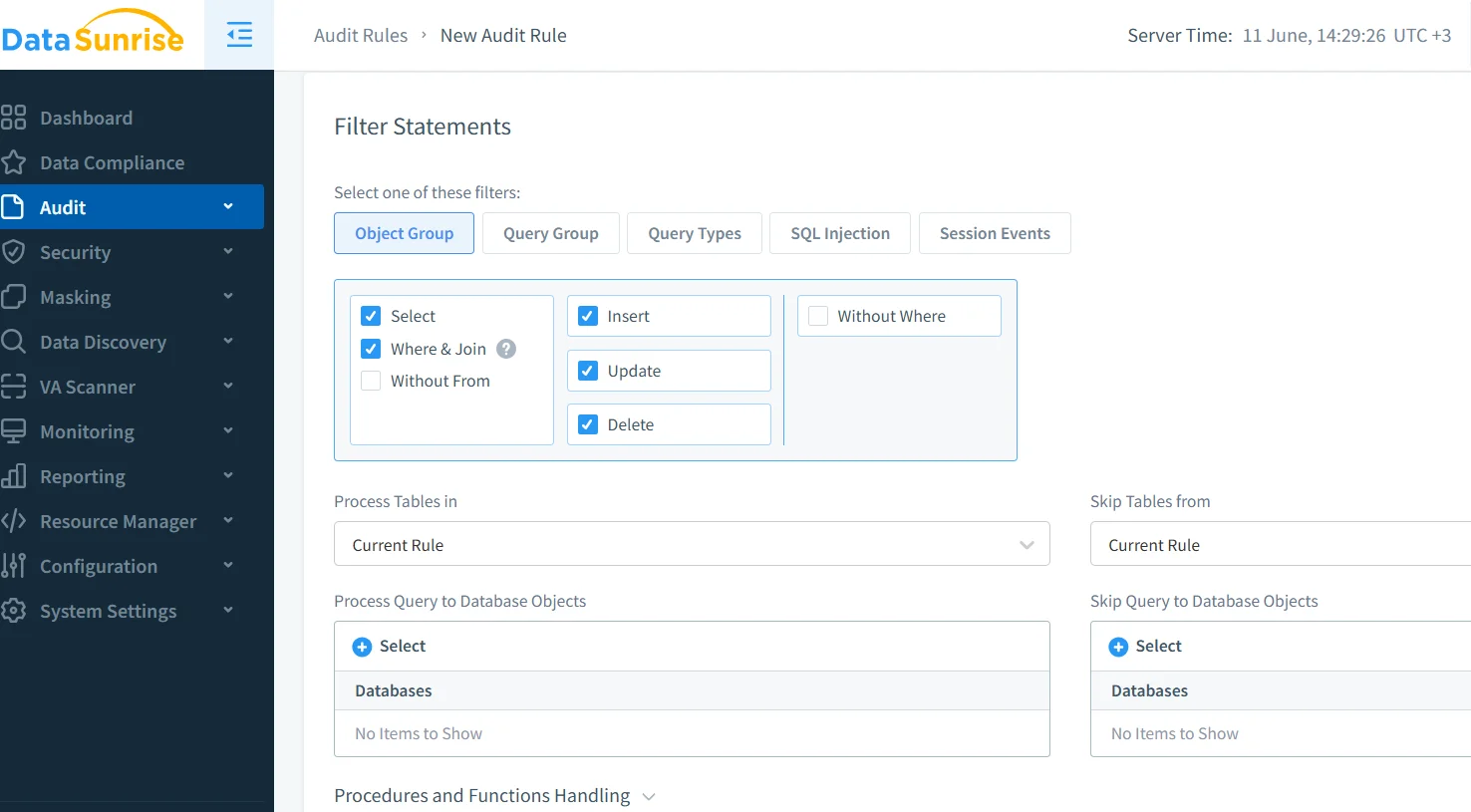

Non puoi sistemare ciò che non puoi vedere. Gli strumenti di audit in tempo reale tengono traccia di ogni richiesta, risultato e metadato associato, fornendo una base per gli avvisi e le indagini post-incidente. Questi strumenti aiutano anche a far rispettare la responsabilità tra utenti e team.

Con i meccanismi di registrazione di DataSunrise, i team di sicurezza possono ispezionare le query in corso, segnalando qualsiasi cosa corrisponda a modelli di rischio noti. Questo è particolarmente utile negli scenari in cui i modelli GenAI interagiscono con dati sensibili di back-end.

Per ulteriori pratiche, consulta le linee guida di Microsoft sull’ingegneria sicura dei prompt per LLM.

Offuscare gli output con mascheramento dinamico

Anche se gli input sono sicuri, gli output potrebbero richiedere una cura extra. Il mascheramento dinamico interviene proprio prima che la risposta venga consegnata, nascondendo o anonimizzando i campi sensibili nel set di risultati. Ad esempio, anche se un modello accede a dati reali, il destinatario vede:

{"user": "Maria G.", "email": "[nascosto]", "passport": "***-**-9123"}

Questo garantisce che tu non esponga mai informazioni personali identificabili (PII), nemmeno quando i modelli LLM sono integrati con sistemi live. Scopri di più sul mascheramento dinamico per applicare la redazione a livello di risposta.

Conoscere ciò che proteggi con la scoperta dei dati

La sicurezza senza visibilità è una supposizione. Prima di proteggere qualcosa, devi mapparlo. Il motore di scoperta di DataSunrise esamina i repository per rilevare gli asset sensibili, inclusi nomi, identificativi e etichette regolamentari.

Una volta classificati i tuoi dati, puoi configurare i sistemi GenAI per evitare di toccare o esporre determinati elementi. Questo è fondamentale quando i modelli estraggono contesto da tabelle live o da basi di conoscenza indicizzate.

Per completare i tuoi sforzi di scoperta, consulta il whitepaper IBM AI Governance per l’allineamento delle politiche su larga scala.

Controllo degli input: sanitizzazione prima dell’elaborazione

Gli input degli utenti sono imprevedibili e talvolta dannosi. La sanitizzazione dei prompt garantisce che il modello non venga indotto a eseguire logiche non sicure o a restituire contesti sensibili. Le tecniche includono il filtraggio con regex, la classificazione dei prompt e l’applicazione di regole strutturali per gli input.

Questo rispecchia i principi della sicurezza web tradizionale. Pensalo come una difesa contro l’iniezione SQL, ma ora applicata ai prompt AI. Le politiche di sicurezza di DataSunrise possono intercettare prompt non sicuri prima che raggiungano il tuo modello.

Se stai sviluppando in Python, considera gli Esempi di mitigazione delle iniezioni di prompt di OpenAI.

Pressione normativa sui flussi di lavoro AI

La conformità non è solo per gli auditor, è un principio di progettazione. Se il tuo sistema GenAI interagisce con dati regolamentati da PCI, HIPAA o GDPR, devi dimostrare il controllo sull’accesso e sulla cronologia degli audit.

Il motore di conformità di DataSunrise associa le query GenAI ai requisiti normativi. Puoi dimostrare chi ha avuto accesso a cosa, quando e in base a quale politica, automaticamente.

Per comprendere come la conformità interagisce con l’equità e la spiegabilità dell’AI, consulta i Principi AI dell’OCSE.

Applicazione nel mondo reale: controllo di una query live

Supponiamo che un utente invii:

SELECT name, email, ssn FROM patients WHERE clinic = 'Berlin';

La tua interfaccia AI cattura il prompt, lo registra con l’ID utente e lo instrada attraverso un motore di mascheramento. L’output finale consegnato all’utente:

{"name": "E. Krause", "email": "[redatto]", "ssn": "***-**-2210"}

Parallelamente, viene attivato un avviso e viene creato un record di conformità con tutti i metadati. Questo crea una catena continua dall’input all’output al log.

Considerazioni finali

Proteggere gli ingressi e le uscite dei modelli AI significa prendere sul serio l’intera interazione, dal momento in cui un utente parla fino al secondo in cui il modello risponde. Combinando il monitoraggio in tempo reale, il mascheramento intelligente, la scoperta automatizzata e la mappatura della conformità, puoi mantenere i tuoi sistemi GenAI potenti senza renderli pericolosi.

Per approfondire, consulta il Framework per la Gestione dei Rischi AI del NIST, una risorsa essenziale per allineare l’architettura di sicurezza con un design etico dell’AI.