Sfide della Sicurezza dei Dati nei Sistemi AI

I sistemi di AI generativa stanno trasformando il modo in cui le organizzazioni utilizzano e condividono i dati. Snelliscono i processi lavorativi, automatizzano il processo decisionale e supportano modelli di apprendimento adattivo. Tuttavia, questa evoluzione porta con sé minacce nuove e complesse alla sicurezza dei dati. I modelli assimilano informazioni sensibili, producono output imprevedibili e richiedono accesso a vasti insiemi di dati, rendendo insufficienti i controlli di sicurezza tradizionali.

Comprendere le sfide della sicurezza dei dati nei sistemi AI significa guardare oltre i tradizionali firewall di rete o la protezione degli endpoint. Si tratta di mettere in sicurezza gli input, il comportamento del modello e i flussi di dati — tutto in tempo reale e in ambienti diversi. I sistemi AI sono intrinsecamente assetati di dati, e la loro dipendenza dai dati in tempo reale aumenta l’esposizione a perdite, attacchi di inferenza e violazioni di conformità.

Audit in Tempo Reale come Meccanismo di Difesa

I log di audit non sono una novità — ma il loro ruolo nella sicurezza dell’AI è ora centrale. Registrare i prompt degli utenti, le risposte del modello, le interazioni API e le query SQL verso vector store o database relazionali offre una traccia di responsabilità. Un sistema di audit in tempo reale consente di rilevare immediatamente anomalie quali l’iniezione di prompt, l’accesso non autorizzato a righe sensibili o la fuoriuscita di informazioni personali identificabili (PII).

-- Esempio: registrazione della query utente in PostgreSQL con prompt in formato JSON

INSERT INTO prompt_audit_log (user_id, prompt_body, timestamp)

VALUES (current_user, to_jsonb($$Riassumi i dati finanziari per settore cliente$$), now());

Abbinato a DataSunrise, le regole di audit possono classificare e taggare automaticamente i prompt che interagiscono con campi riservati, offrendo un ulteriore livello di monitoraggio trasparente per le applicazioni AI basate sulle architetture GenAI.

Masking Dinamico per Output Sensibili

Le risposte dell’AI che espongono email, numeri di telefono o credenziali non sono solo una fuga di dati — rappresentano una violazione della conformità. È qui che il masking dinamico diventa essenziale. A differenza della redazione statica, il masking dinamico si adatta in tempo reale, proteggendo gli output senza interrompere la logica del sistema.

Ad esempio, quando un prompt accede a un database di assistenza clienti, il masking dinamico può nascondere tutti i campi relativi alle carte di credito sia dai dati di training che dall’output generato. In DataSunrise, questo viene configurato con regole di masking legate all’accesso basato sui ruoli e ai modelli di contenuto.

-- Esempio: regola di masking per la colonna credit_card

CREATE MASKING RULE hide_credit_cards

ON customers.credit_card

USING FULL MASKING

WHEN current_user_role != 'auditor';

Questo garantisce che strumenti AI come le pipeline di retrieval-augmented generation (RAG) non rivelino mai i campi sensibili in chiaro, anche quando sono connessi a vector store affidabili.

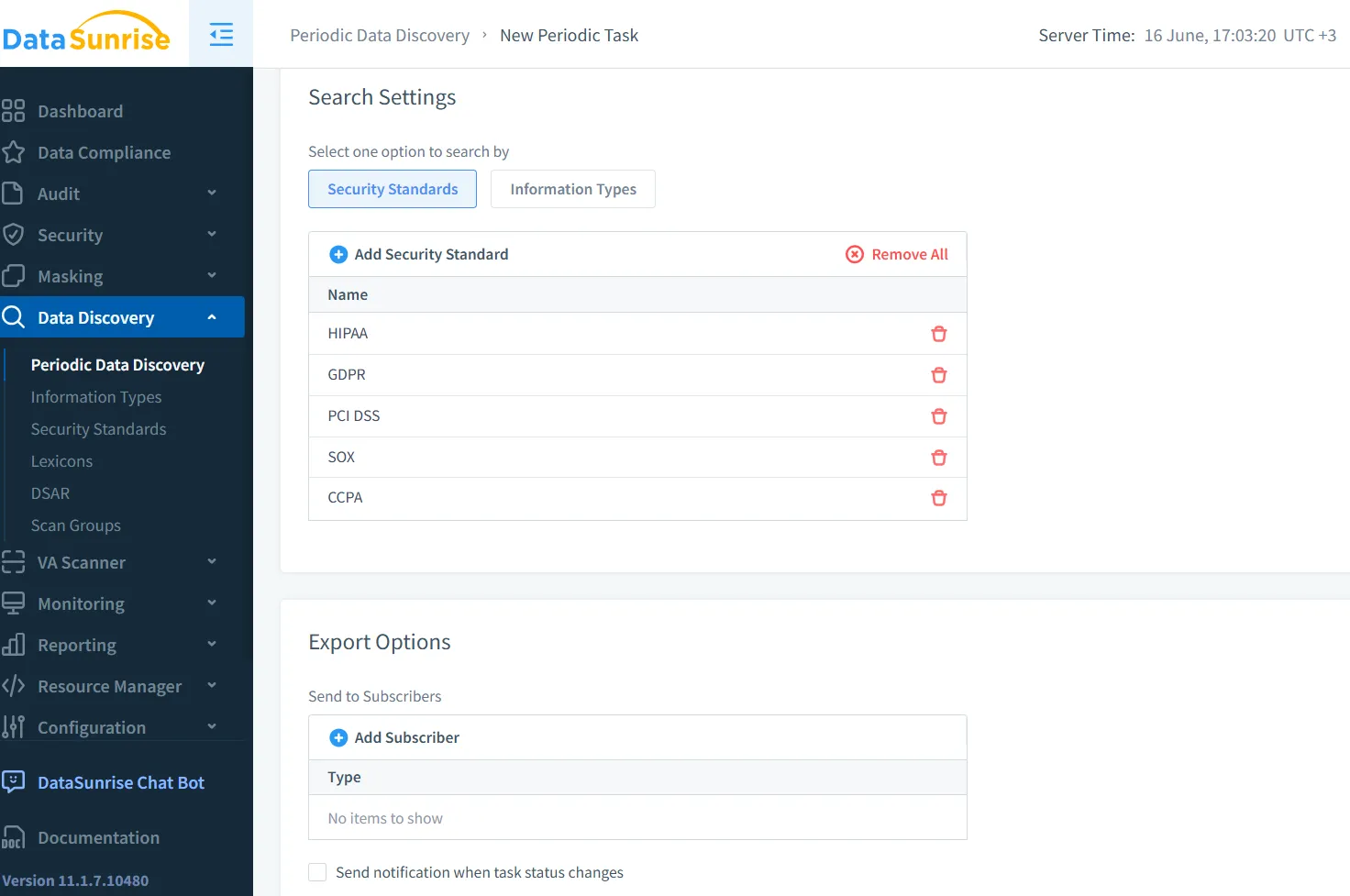

Scoperta Prima di Mettere in Sicurezza

Prima di poter proteggere i dati, è necessario sapere dove risiedono — e l’AI complica ulteriormente questa sfida. I modelli ottimizzati utilizzano spesso fonti di dati ibride, che spaziano da database strutturati a log non strutturati e documenti semi-strutturati. Scansionare tutte le fonti alla ricerca di attributi sensibili diventa un punto di partenza fondamentale.

Gli strumenti di data discovery individuano, classificano ed etichettano automaticamente gli elementi sensibili su diversi back-end. Per l’AI, questo include l’individuazione di set di dati che contengono PHI, identificativi dei clienti o conoscenze proprietarie che non dovrebbero essere esposte.

La scoperta non avviene solo prima del training; è un processo continuo. Quando i dataset evolvono — ad esempio, con l’indicizzazione di nuovi documenti in vector store — la discovery dovrebbe attivare la riclassificazione e la rivalutazione delle politiche. Questo la rende essenziale per la governance dell’AI e l’applicazione automatizzata della sicurezza.

Architettura di Sicurezza Adattata all’AI

La sicurezza GenAI non riguarda l’avvolgere firewall esistenti attorno a un nuovo strumento. Si tratta di progettare per la visibilità, la tracciabilità e controlli adattivi. Un approccio di sicurezza a strati risulta il più adatto:

Firewall per prompt per intercettare input malevoli prima che raggiungano il modello

Classificazione dei dati basata su token all’interno delle pipeline di output dei LLM

Rilevamento di anomalie basato sulle sessioni utilizzando il contesto dell’utente e del prompt

Masking dinamico a livello di vettore e di risposta SQL

Logging di audit consapevole delle politiche che rifletta l’appetito per il rischio dell’organizzazione

Questi componenti lavorano insieme. Un utente che inserisce una query sospetta in un’interfaccia chatbot potrebbe attivare un firewall per prompt, registrare la richiesta in una tabella di audit e restituire una risposta mascherata — il tutto senza interrompere il servizio.

Rimanere Conformi nell’Era dell’AI

L’AI non esenta dalla conformità. Anzi, la sua imprevedibilità aggiunge rischio ai framework esistenti come GDPR, HIPAA e PCI-DSS. È necessario continuare a tracciare dove vengono accessibili i dati personali, dimostrare che sono protetti e rispondere alle richieste di cancellazione o accesso.

DataSunrise connette AI e obblighi normativi fornendo controlli di livello di conformità sul movimento dei dati, sulla visibilità degli accessi e sulla protezione. La suite di Data Compliance assicura che le applicazioni AI rispettino gli stessi limiti degli operatori umani. L’integrazione con strumenti come Data Discovery e Dynamic Masking consente di definire regole applicabili — non solo report passivi.

Per una guida pratica all’integrazione di questi strumenti, il knowledge center sulla conformità normativa offre le best practice sulla sicurezza dei database, il masking e il logging di audit per carichi di lavoro guidati dall’AI.

Uno Sguardo al Futuro: L’AI come Minaccia e Alleato

È facile considerare l’AI come un rischio per la sicurezza — ma può anche fungere da esecutore. Le architetture future probabilmente includeranno agenti di sicurezza dei dati alimentati da LLM che analizzeranno i modelli di accesso, raccomanderanno nuove politiche di masking e bloccheranno in tempo reale catene di prompt sospetti.

Coniugando audit in tempo reale, masking dinamico, discovery continuo e applicazione basata su politiche, le organizzazioni possono far sì che l’AI operi a favore della sicurezza anziché contro di essa. Strumenti come DataSunrise aiutano a navigare questo cambiamento — passando da una difesa reattiva a una protezione proattiva, allineata con l’AI.

Prospettive esterne supportano inoltre questa evoluzione. L’documento arXiv sui rischi di cybersecurity dei LLM esplora come i modelli possano divulgare o dedurre segreti, mentre la Cloud Security Alliance sottolinea che la sicurezza dei dati in ambito AI, con un focus centrale sui dati, è una priorità assoluta.

Mettere in sicurezza l’AI generativa non riguarda il timore — si tratta di progettare. E la progettazione inizia con la visibilità, l’adattabilità e il controllo sul ciclo di vita dei dati a ogni livello.