Sicurezza dei Dati Cloud nelle Implementazioni di AI e LLM

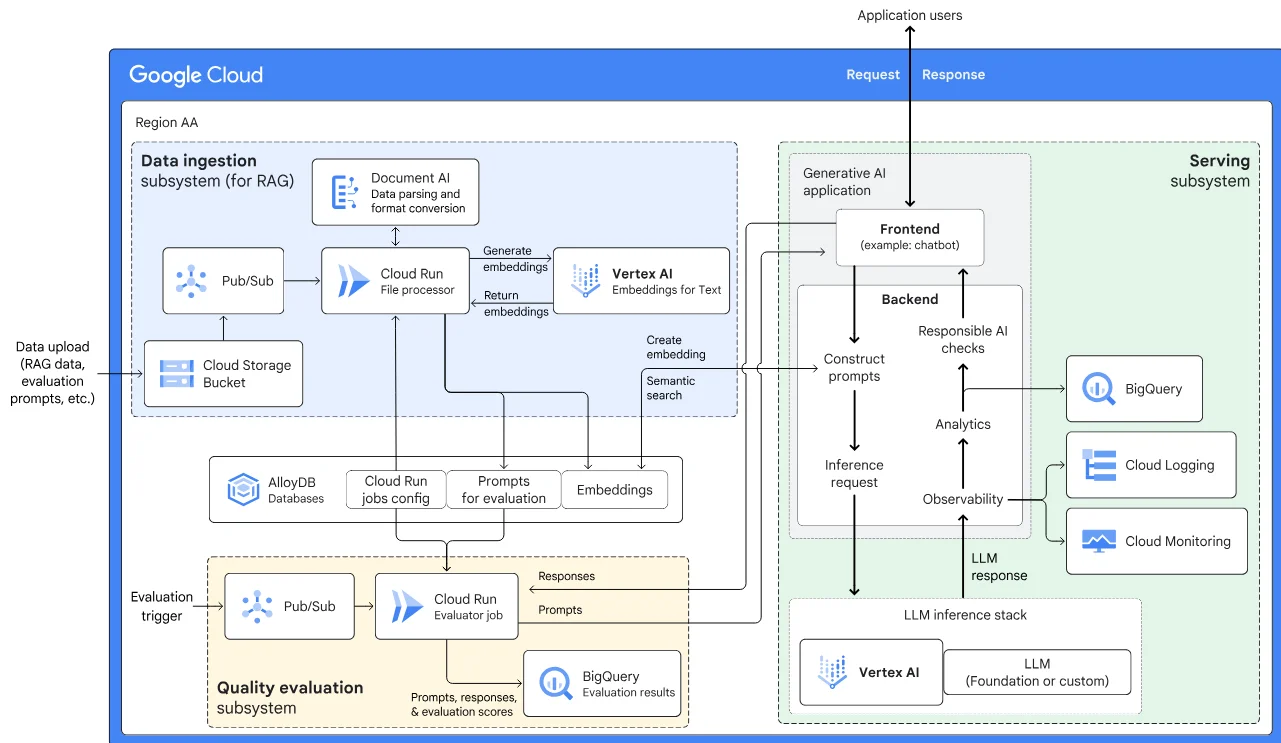

I modelli di AI generativa (GenAI) e i grandi modelli linguistici (LLM) hanno trasformato il modo in cui le applicazioni cloud-native elaborano e generano dati. Questi strumenti migliorano l’automazione, il processo decisionale e la personalizzazione, ma introducono anche sfide significative per la sicurezza dei dati. Poiché i modelli interagiscono con informazioni sensibili o regolate, garantire una gestione sicura e conforme diventa fondamentale. In questo articolo, esploriamo i componenti chiave della sicurezza dei dati nel cloud nelle implementazioni di AI e LLM, concentrandoci su audit in tempo reale, mascheramento dinamico, scoperta dei dati e strategie di conformità.

Rischi Specifici del Cloud per AI e LLM

Gli LLM implementati in ambienti cloud possono acquisire, elaborare e generare risposte basate su dati sensibili dell’azienda. Queste risposte potrebbero involontariamente divulgare identificatori personali, segreti commerciali o contenuti regolamentati, come informazioni sulla salute o sui pagamenti. Poiché le piattaforme cloud scalano e distribuiscono dinamicamente i carichi di lavoro, la visibilità sull’accesso e sull’elaborazione dei dati diventa più complessa. Questa mancanza di visibilità e controllo crea il rischio di un’esposizione non autorizzata dei dati, soprattutto se gli output di GenAI vengono registrati o memorizzati nella cache in modo improprio.

Proteggere i Carichi di Lavoro AI con Audit in Tempo Reale

Uno degli elementi fondamentali per proteggere i flussi di lavoro di AI e LLM è l’implementazione di audit in tempo reale. Gli audit in tempo reale catturano tutte le interazioni tra utenti, servizi e l’infrastruttura dati sottostante. Analizzando queste interazioni mentre avvengono, le organizzazioni possono rilevare violazioni delle politiche, attività sospette e schemi di utilizzo non autorizzato della AI.

Ad esempio, quando un utente interroga un modello AI per generare un riepilogo del profilo cliente, il percorso di audit dovrebbe catturare:

SELECT * FROM customer_profiles WHERE customer_id = '12345';

Questa traccia può quindi essere collegata all’output del modello e archiviata in un registro a prova di manomissione, consentendo ai team di investigare il comportamento dei prompt o diagnosticare eventuali problemi di conformità. Piattaforme come DataSunrise offrono un registro dettagliato degli audit che si integra con i SIEM, abilitando allarmi automatici e visualizzazioni delle interazioni rischiose con la AI.

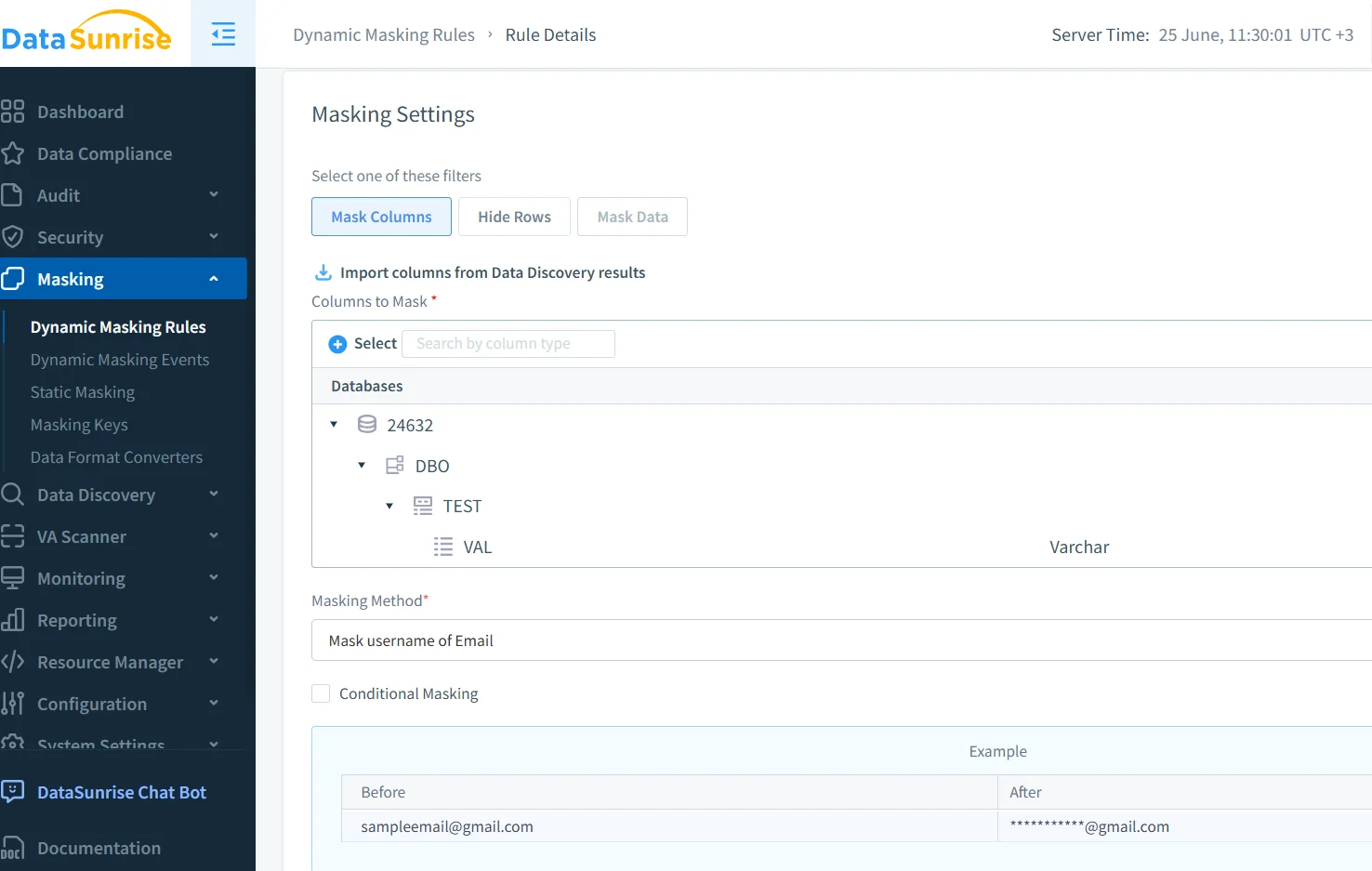

Applicare il Mascheramento Dinamico agli Output AI

Il mascheramento dinamico gioca un ruolo cruciale nel prevenire la perdita di dati durante l’inferenza GenAI. A differenza del mascheramento statico, che altera i dati a riposo, il mascheramento dinamico avviene in tempo reale, proprio prima che l’output raggiunga l’utente o il modello. Ciò garantisce che campi sensibili, come numeri di previdenza sociale, codici medici o record finanziari, siano sempre mascherati durante le interazioni con la AI.

Immagina un LLM utilizzato per assistere gli operatori del servizio clienti. Quando un operatore chiede al modello di riepilogare un ordine contenente informazioni personali (PII), le regole di mascheramento devono garantire che campi come questi:

{"customer": "John Smith", "card_number": "4111-XXXX-XXXX-1234"}

vengono forniti con valori mascherati sia all’operatore che ai registri archiviati. DataSunrise supporta il mascheramento dinamico che funziona su database cloud e si integra con pipeline basate su LLM.

Scoprire i Dati Sensibili Prima che Fuoriescano

I modelli AI addestrati o stimolati su fonti di dati sconosciute sono soggetti a fughe di informazioni. Gli strumenti di scoperta dei dati aiutano a prevenire ciò scansionando data lake, magazzini e flussi per attributi sensibili, come cartelle cliniche, token di accesso o identificatori finanziari. Integrare i risultati della scoperta nelle pipeline GenAI garantisce che i modelli accedano solo a set di dati conformi.

Il modulo di scoperta dei dati di DataSunrise classifica automaticamente le informazioni su piattaforme di archiviazione cloud, aiutando i team di conformità a impedire che dati regolati entrino nelle fasi di addestramento o inferenza. Questo passo proattivo è fondamentale per abilitare un’automazione guidata dall’AI sicura.

Rafforzare la Conformità nelle Architetture Basate su AI

Poiché i sistemi AI basati su cloud interagiscono con contenuti regolati, quadri di conformità come GDPR, HIPAA e PCI-DSS diventano fondamentali. Queste normative richiedono la possibilità di audit, la minimizzazione dei dati e il controllo degli accessi basato sui ruoli. Applicare questi controlli ai modelli AI e ai loro input/output dei dati non è più facoltativo.

Soluzioni come Compliance Manager di DataSunrise consentono agli amministratori della sicurezza AI di costruire politiche su misura, allineate agli standard del settore. Le regole possono imporre il mascheramento su colonne specifiche, limitare l’accesso al modello in base ai ruoli o garantire che qualsiasi utilizzo di LLM con dati personali sia completamente auditabile.

Costruire una Sicurezza a Più Livelli per l’AI nel Cloud

La sicurezza negli stack GenAI basati su cloud non riguarda un singolo controllo. Richiede un modello di difesa a strati:

- Audit: Catturare e analizzare le interazioni in tempo reale.

- Mascheramento: Prevenire l’esposizione di contenuti sensibili.

- Scoperta: Mappare e classificare gli asset di dati sensibili.

- Controlli di accesso: Implementare RBAC contestuale e il principio del minimo privilegio.

- Conformità: Allineare l’architettura a standard come GDPR o HIPAA.

Strumenti come il firewall per database di DataSunrise e i modelli di politiche di sicurezza aiutano i team di sicurezza a applicare questi controlli negli ambienti focalizzati sull’AI.

Risorse esterne come il Secure AI Framework (SAIF) di Google e il Framework di Gestione del Rischio AI del NIST forniscono ulteriori indicazioni per le organizzazioni che costruiscono sistemi AI resilienti.

Conclusione

La sicurezza dei dati cloud nelle implementazioni di AI e LLM riguarda più della semplice protezione del perimetro. Man mano che i sistemi AI evolvono, anche le strategie di sicurezza che li circondano devono evolvere. I percorsi di audit in tempo reale, il mascheramento dinamico, la scoperta intelligente dei dati e i meccanismi di conformità automatizzati formano le basi di una GenAI affidabile. Con piattaforme come DataSunrise, le organizzazioni possono muoversi rapidamente senza sacrificare il controllo, abilitando un’innovazione AI sicura, scalabile e conforme.