Sicurezza dei Prompt nelle Interazioni AI e LLM

Man mano che i modelli linguistici diventano centrali nelle operazioni aziendali, le loro interazioni con i prompt introducono nuovi livelli di rischio. Questi rischi vanno oltre il comportamento del modello e riguardano il modo in cui i prompt vengono strutturati, processati e registrati. “Sicurezza dei prompt nelle interazioni AI e LLM” è emersa come una disciplina cruciale per proteggere i dati sensibili, mantenere la conformità alle normative ed evitare la manipolazione degli output dell’IA.

Perché la sicurezza dei prompt ora è importante

A differenza delle applicazioni tradizionali, modelli LLM come ChatGPT o Claude rispondono a input che possono contenere contenuti privati, regolamentati o avversari. Ciò crea una superficie di attacco in cui una domanda apparentemente innocua potrebbe innescare l’esposizione di dati riservati, violazioni di politiche o la manipolazione degli output tramite tecniche di iniezione del prompt.

Quando integrati in servizi che si collegano a database interni o a flussi di dati dei clienti, le implicazioni di sicurezza si moltiplicano. È per questo che audit in tempo reale, mascheramento dinamico e scoperta dei dati devono diventare strumenti standard nelle implementazioni dell’IA.

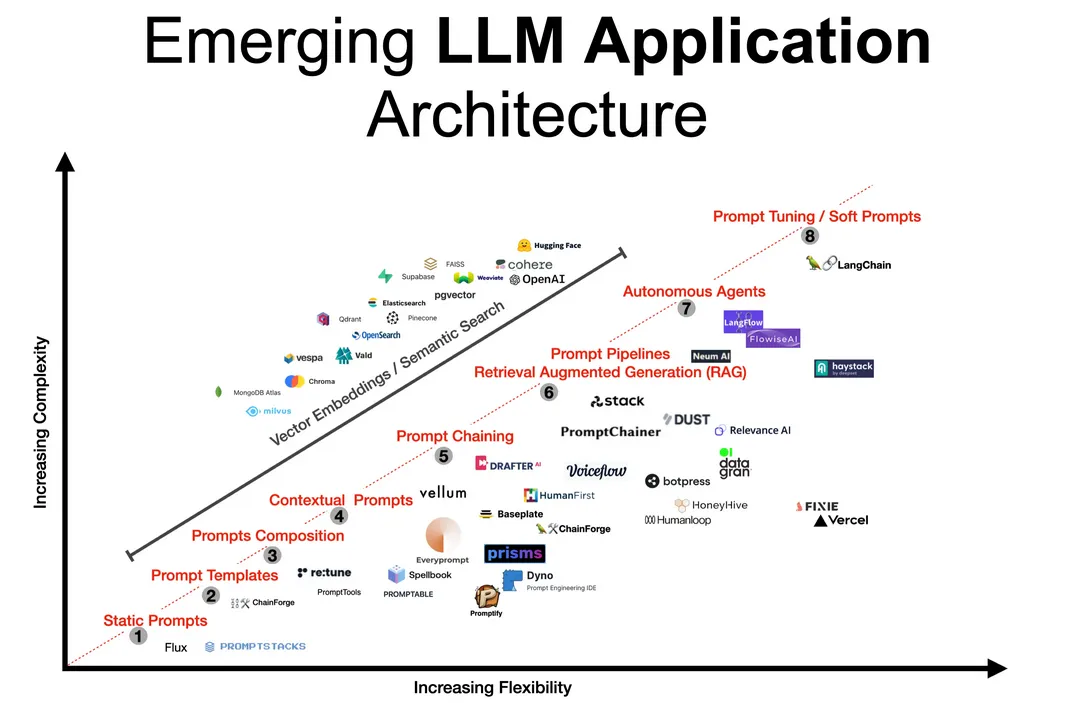

Comprendere la pipeline dei prompt

I prompt attraversano diversi sistemi: partono dalle interfacce utente, passano eventualmente attraverso filtri di pre-elaborazione, proseguono con il modello stesso e, infine, transitano attraverso eventuali API a valle come generatori SQL.

Questo percorso deve essere trattato come una transazione sensibile. Registrare ciò che entra e ciò che esce, rilevare anomalie e applicare politiche di mascheramento in tempo reale garantisce la sicurezza in ogni passaggio.

Per ulteriori approfondimenti tecnici, la base di conoscenza MITRE ATLAS esplora le tattiche avversarie contro il machine learning, compresi i vettori basati sui prompt.

Audit in tempo reale: Tracciare l’invisibile

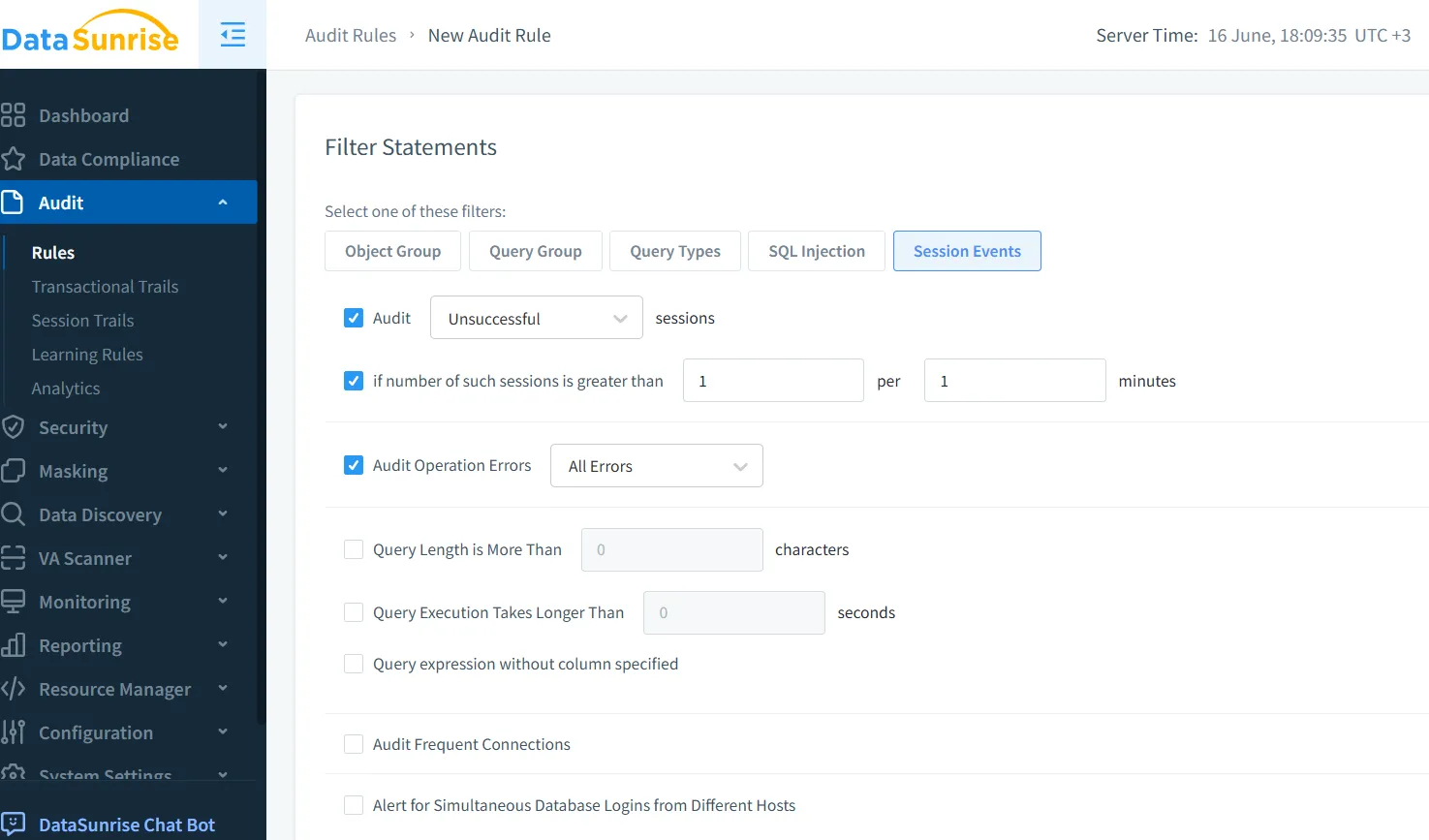

Le interazioni con i prompt spesso non lasciano traccia se non configurate esplicitamente. Gli strumenti di audit in tempo reale, come quelli offerti dal motore Audit Trail di DataSunrise, possono monitorare ogni richiesta, query e trasformazione applicata sia agli input che agli output.

Questo è particolarmente utile quando l’IA è collegata ad strumenti a valle:

-- Esempio generato dal prompt:

SELECT name, ssn FROM employees WHERE clearance_level = 'high';

Un audit in tempo reale può rilevare immediatamente query che accedono a campi sensibili e segnalare un uso non autorizzato prima che vengano restituiti i risultati. Maggiori informazioni sulla configurazione delle regole di audit per i prompt AI sono disponibili in questa guida all’audit.

Mascheramento dinamico: Proteggere durante la risposta

Se l’output del modello include dati sensibili, questi devono essere mascherati in tempo reale. Il mascheramento dinamico garantisce che, anche se il prompt tenta di estrarre campi privati, ciò che viene restituito risulti oscurato.

Ad esempio:

Prompt: Mostrami le transazioni recenti dei clienti VIP.

LLM Output: Nome: John D*****, Importo: $45,000

Le regole di mascheramento possono variare in base ai ruoli degli utenti, al contesto della sessione o al livello di minaccia. DataSunrise consente ciò attraverso politiche flessibili senza modificare i dati sottostanti.

Scoperta dei dati: Comprendere l’importanza del rischio

Prima di applicare il mascheramento, è necessario identificare quali dati siano sensibili. I LLM spesso operano su schemi e repository differenti, rendendo la classificazione manuale non scalabile.

Gli strumenti automatizzati di scoperta dei dati eseguono la scansione di PII, PHI, credenziali e altri campi riservati. I risultati guidano politiche automatizzate che bloccano la generazione di output contenenti tali dati, applicano regole di mascheramento e notificano immediatamente i team di conformità.

Per comprendere i rischi più ampi legati ai dati non strutturati, l’AI Risk Management Framework di NIST offre linee guida strutturate per la governance lungo l’intero ciclo di vita dell’IA.

Sicurezza del ciclo di vita del prompt

La sicurezza nelle interazioni con i LLM va oltre il semplice filtraggio dei prompt. Include la gestione dell’accesso ai log del modello, la conservazione della cronologia dei prompt e la prevenzione dell’esfiltrazione dei dati tramite query strutturate in modo intelligente.

Utilizza un reverse proxy per intercettare e ispezionare i prompt prima che raggiungano il modello. Conserva in modo sicuro le tracce di audit di prompt e risposte per supportare la conformità a SOX e PCI-DSS. Applica analisi del comportamento degli utenti per identificare deviazioni nei modelli di utilizzo o strutture sospette nei prompt.

Un buon riferimento open-source per i modelli di prevenzione dell’iniezione di prompt è mantenuto da Prompt Injection, che cataloga esempi di attacchi reali e relative mitigazioni.

Conformità dei dati e sicurezza dei prompt

I sistemi AI che gestiscono i dati dei clienti devono rimanere in linea con regolamenti come il GDPR e l’HIPAA. La sicurezza dei prompt supporta questo obiettivo tramite l’audit degli accessi ai dati guidati dall’IA, il mascheramento degli attributi protetti e la registrazione delle attività per consentire verifiche successive.

Piattaforme come il Compliance Manager di DataSunrise automatizzano questi processi e allineano le interazioni AI con le crescenti obbligazioni legali.

Riflessioni finali: Fiducia tra umano e macchina

Man mano che la GenAI diventa sempre più integrata nei processi decisionali e operativi, la sicurezza dei prompt si configura come un elemento fondamentale per la fiducia. L’osservabilità in tempo reale, i controlli sulle risposte e l’allineamento alle normative garantiscono che l’innovazione non superi la sicurezza.

Questo approccio non solo rafforza i sistemi, ma consolida la fiducia nello sviluppo responsabile dell’IA.

Per ulteriori approfondimenti, scopri come strumenti LLM e ML si integrano con i workflow di conformità moderni.

E se sei pronto per testare o implementare, puoi scaricare DataSunrise o richiedere una demo.