Sondaggi e Approfondimenti sulla Sicurezza degli LLM

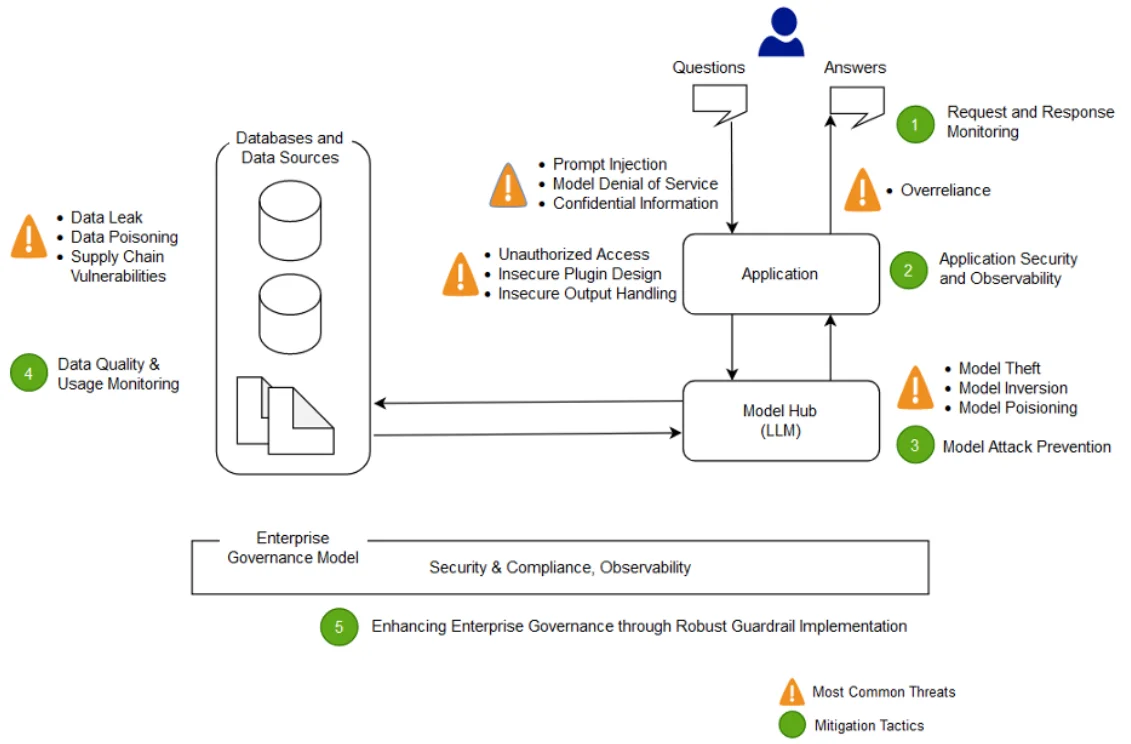

Dato che le organizzazioni integrano modelli di linguaggio di grandi dimensioni (LLM) nelle operazioni quotidiane, l’attenzione alla sicurezza degli LLM è cresciuta rapidamente. Questi modelli gestiscono dati sensibili e devono rispettare standard rigorosi per il controllo, il mascheramento e la conformità. Questo articolo esplora i sondaggi e approfondimenti sulla sicurezza degli LLM con tecniche applicate nel mondo reale per rafforzare le implementazioni di GenAI e allinearsi a normative come il GDPR e l’HIPAA.

LLM in Casi d’Uso Orientati alla Sicurezza

Gli LLM ora supportano compiti quali il rilevamento di phishing, la sintesi dei log e la generazione di regole. Tuttavia, l’accesso a codice, log o dati degli utenti comporta il rischio di perdite accidentali. Per questo motivo, l’uso di strumenti per il monitoraggio della conformità in tempo reale e il mascheramento dinamico è fondamentale quando gli LLM vengono eseguiti in ambienti di produzione.

Modelli di minaccia più dettagliati sono disponibili in questo post del blog MITRE ATLAS, che illustra tattiche avversarie specifiche per gli LLM.

Audit in Tempo Reale per Inferenza e Addestramento

L’accesso ai dati degli LLM deve essere monitorato proprio come le query del database. Gli audit in tempo reale registrano i dettagli dei prompt, il contesto recuperato e le ricerche vettoriali. Ad esempio, se il tuo LLM utilizza PostgreSQL con pgvector, puoi registrare queste query utilizzando il modulo di Monitoraggio dell’Attività del Database.

SELECT content FROM documents

WHERE embedding <#> '[0.134, -0.256, 0.789, ...]' < 0.75

LIMIT 5;

Questa query può essere esaminata istantaneamente per la classificazione della fonte dei dati o per verificare eventuali violazioni della conformità. Puoi anche esplorare i metodi di audit nel blog tecnico di Pinecone, che evidenzia le sfide relative ai vettori.

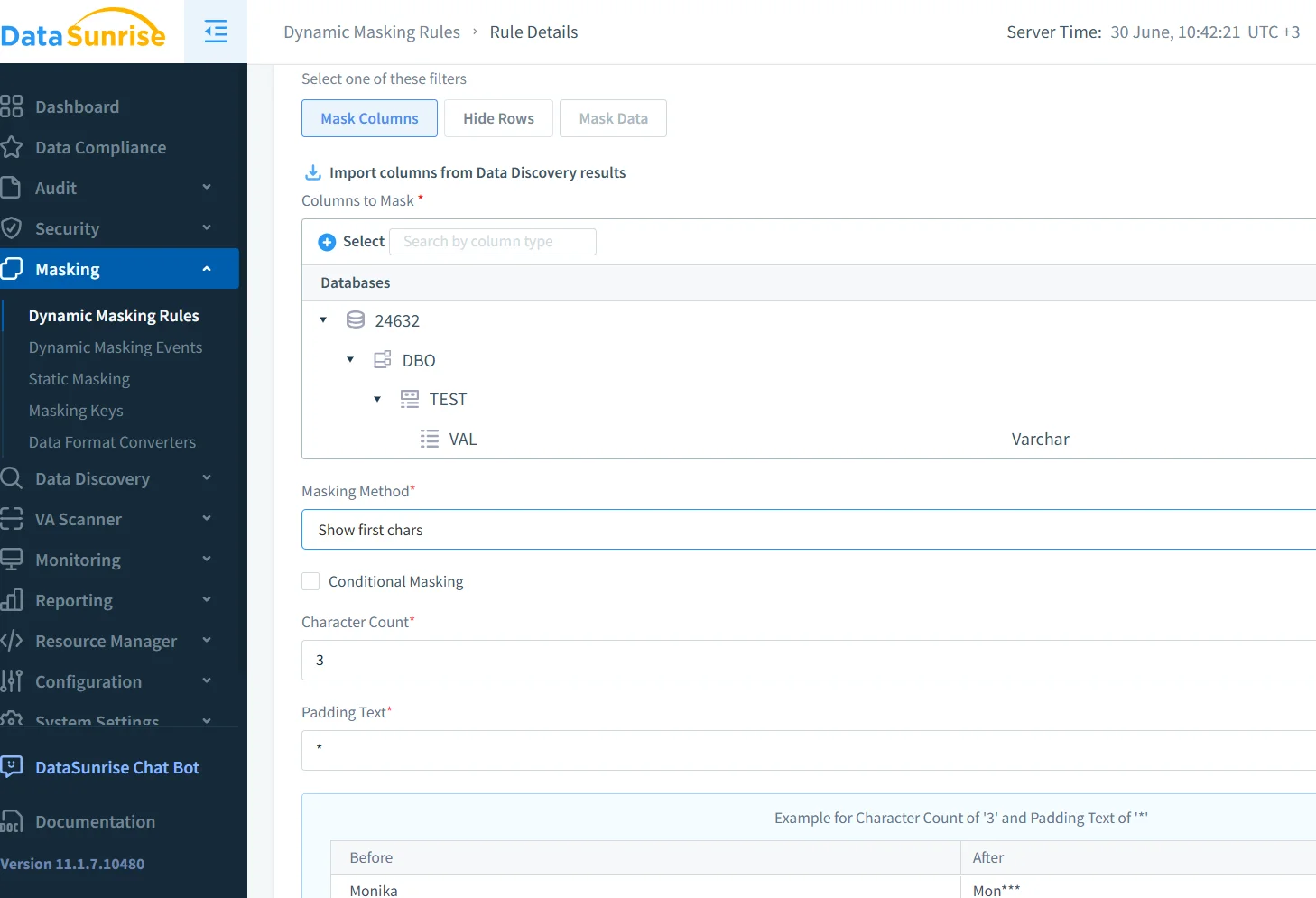

Mascheramento Dinamico per la Sicurezza dei Prompt

Il mascheramento dinamico nasconde elementi sensibili come email o ID prima che raggiungano il modello. Si applica contestualmente e può variare in base al ruolo o al modello. In DataSunrise, il mascheramento dei dati funziona su tutti i prompt utilizzando template basati su regole.

{"user_id": "u-4982", "email": "[email protected]", "error": "access denied"}Diventa:

{"user_id": "u-4982", "email": "*****@company.com", "error": "access denied"}L'articolo di OpenAI su imparare a rifiutare esplora strategie di mascheramento correlate.

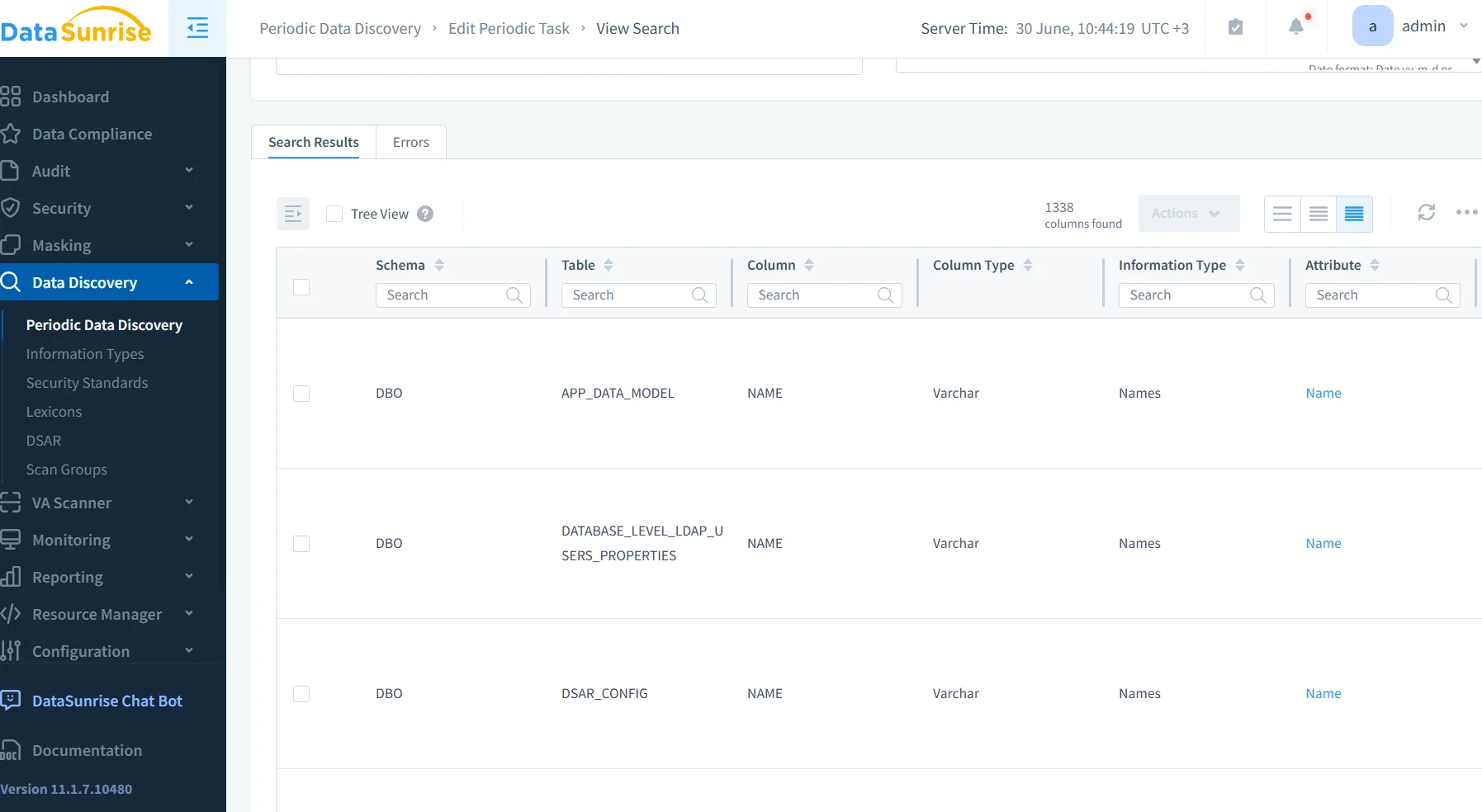

Scoperta dei Dati nelle Pipeline di Embedding

In molti sistemi la vettorizzazione inizia prima che il contenuto venga analizzato. Questo approccio è rischioso. Invece, utilizza strumenti di scoperta dei dati per ispezionare i record prima di indicizzarli.

I record contenenti PII o PHI possono essere contrassegnati e reindirizzati. DataSunrise si integra con workflow come Airflow o dbt per applicare automaticamente queste scansioni.

La guida di Cohere sulla privacy degli LLM mostra come applicare pratiche ottimali simili.

Approfondimenti sulla Sicurezza dalle Implementazioni di LLM

I sondaggi condotti dai team di sicurezza evidenziano problemi ricorrenti. L'iniezione di prompt rimane una preoccupazione. L'assenza di regole di mascheramento permette la memorizzazione di contenuti sensibili. Le lacune nelle tracce degli audit vettoriali rallentano le indagini e le modifiche al modello non vengono segnalate.

Per affrontare questi problemi, molti team incorporano tag di audit, limitano i prompt e utilizzano gateway per il traffico di inferenza. Puoi esplorare ulteriori soluzioni in LLMGuard, che esamina sia i controlli proxy che i metodi di filtraggio dei token.

Operazioni LLM Pronte per la Conformità

Per conformarsi a GDPR, HIPAA o PCI-DSS, il tuo sistema deve registrare l'accesso ai dati, classificare le fonti e applicare il mascheramento quando necessario. Anche l'isolamento tra gli LLM e i dati in tempo reale è fondamentale.

DataSunrise Compliance Manager supporta tutti questi controlli e si integra facilmente con piattaforme SIEM esterne. Puoi anche consultare il Framework di Rischio AI del NIST per una guida più ampia.

Uno Sguardo al Futuro: Firewall dei Dati Consapevoli degli LLM

La prossima generazione di firewall non si limiterà a ispezionare il SQL, ma analizzerà prompt, embedding e completamenti. Questi strumenti rileveranno usi impropri, prevendranno la condivisione eccessiva e bloccheranno flussi pericolosi. Proprio come un firewall del database, ma consapevole degli LLM.

Progetti come Guardrails AI e LLM-Defender stanno sviluppando questa visione. Abbinati a politiche di sicurezza basate su regole fornite da DataSunrise, il risultato è una protezione forte e adattiva. Questo concetto si rispecchia nel Constitutional AI di Anthropic, che propone LLM in grado di applicare per design controlli interni delle politiche.

Considerazioni Finali

Gli LLM di oggi hanno bisogno di più della sola performance: hanno bisogno di protezione. Audit in tempo reale, mascheramento dinamico e flussi di lavoro per la scoperta dei dati costituiscono il nucleo dei moderni sondaggi e approfondimenti sulla sicurezza degli LLM. Con piattaforme come DataSunrise, queste salvaguardie diventano parte integrante della tua architettura LLM, e non un ripensamento.

Proteggi i tuoi dati con DataSunrise

Metti in sicurezza i tuoi dati su ogni livello con DataSunrise. Rileva le minacce in tempo reale con il Monitoraggio delle Attività, il Mascheramento dei Dati e il Firewall per Database. Applica la conformità dei dati, individua le informazioni sensibili e proteggi i carichi di lavoro attraverso oltre 50 integrazioni supportate per fonti dati cloud, on-premises e sistemi AI.

Inizia a proteggere oggi i tuoi dati critici

Richiedi una demo Scarica ora