Migliorare la Gestione dei Dati e le Prestazioni con il Sottocampionamento dei Dati

Introduzione

L’esplosione delle tecnologie digitali, dei dispositivi dell’Internet of Things (IoT) e delle interazioni online ha generato enormi quantità di dati che possono essere raccolti e analizzati. Nel mondo odierno guidato dai dati, gestire in modo efficiente grandi set di dati è cruciale sia per le aziende che per i ricercatori. Una tecnica potente che ha guadagnato importanza negli ultimi anni è il sottocampionamento dei dati. Questo articolo approfondirà il mondo del sottocampionamento dei dati, esplorandone i fondamenti, i benefici e le applicazioni pratiche. Esamineremo anche alcuni strumenti open-source e forniremo esempi per aiutarti a iniziare con questa essenziale tecnica di gestione dei dati.

Che cos’è il Sottocampionamento dei Dati?

Il sottocampionamento dei dati è il processo di creare una porzione più piccola e gestibile di un set di dati più grande, mantenendo le sue caratteristiche chiave e le relazioni. Questa tecnica consente agli utenti di lavorare con un campione rappresentativo di dati, rendendo più semplice la gestione, l’analisi e il test senza comprometterne l’integrità del set originale.

Perché Dovresti Interessarti al Sottocampionamento?

Il sottocampionamento dei dati sta diventando sempre più cruciale nella nostra era del big data. Ecco perché dovresti prestare attenzione a questa tecnica:

- Gestione di Set di Dati Enormi: I set di dati moderni possono essere immensi. Ad esempio, una piattaforma di social media potrebbe generare petabyte di dati ogni giorno. Lavorare con quantità così vaste di dati può essere poco pratico o addirittura impossibile senza il sottocampionamento.

- Ottimizzazione delle Risorse: Elaborare set di dati completi spesso richiede significative risorse computazionali. Il sottocampionamento ti permette di lavorare con una frazione dei dati, risparmiando tempo e riducendo i requisiti hardware.

- Riduzione dei Costi: I costi di cloud computing e storage sono direttamente legati al volume dei dati. Lavorando con sottoinsiemi, puoi ridurre significativamente queste spese.

- Cicli di Sviluppo Più Veloci (test del software): Nel campo dello sviluppo software, utilizzare set di dati di produzione completi per i test può rallentare il processo di sviluppo. I sottoinsiemi permettono iterazioni più rapide e una più veloce individuazione degli errori.

- Conformità alla Privacy dei Dati: Con regolamenti come il GDPR e il CCPA, utilizzare set di dati completi con informazioni sensibili per test o analisi può essere rischioso. Il sottocampionamento aiuta a creare set di dati anonimizzati e conformi.

- Miglioramento della Qualità dei Dati: I set di dati più piccoli sono più facilmente pulibili e validabili, portando potenzialmente a dati di qualità superiore per le tue analisi o modelli.

Quanto Possono Essere Grandi i Set di Dati? Un Esempio Reale

Per comprendere la scala dei set di dati moderni, consideriamo alcuni esempi:

- Data Warehouse di Walmart: A partire dal 2019, si stima che il data warehouse di Walmart contenesse oltre 2,5 petabyte di dati. Questo equivale a 167 volte tutti i libri presenti nella Biblioteca del Congresso degli Stati Uniti.

- Dati degli Utenti di Facebook: Facebook elabora oltre 500 terabyte di dati ogni giorno. Questo include post degli utenti, foto, video e dati sulle interazioni.

- Large Hadron Collider del CERN: L’LHC genera enormi quantità di dati equivalenti a oltre 20.000 anni di registrazioni video HD 24/7.

- Dati Genomici: Il genoma umano è composto da circa 3 miliardi di paia di basi. Il sequenziamento e l’archiviazione di questi dati per milioni di individui creano set di dati nella gamma dei petabyte.

- Scienza del Clima: Il Center for Climate Simulation (NCCS) della NASA gestisce oltre 32 petabyte di dati provenienti da varie missioni scientifiche sulla Terra.

Per fare un paragone, 1 petabyte equivale a 20 milioni di armadi a quattro cassetti pieni di documenti. Immagina ora di dover analizzare o elaborare questa quantità di dati nella sua interezza – è qui che il sottocampionamento dei dati diventa inestimabile.

Ad esempio, se fossi un data scientist a Walmart e volessi analizzare il comportamento dei clienti, lavorare con i 2,5 petabyte completi sarebbe poco pratico. Invece, potresti creare un sottoinsieme di dati per un determinato periodo, regione o categoria di prodotti, riducendo magari il tuo set di lavoro a 50 gigabyte più gestibili.

Applicazioni Pratiche del Sottocampionamento

Esploriamo alcuni scenari reali in cui il sottocampionamento dei dati si rivela inestimabile:

1. Sviluppo Software e Testing

Gli sviluppatori spesso hanno bisogno di lavorare con dati realistici per testare le applicazioni. Tuttavia, utilizzare set di dati di produzione completi può essere poco pratico e rischioso. Il sottocampionamento permette di creare set di dati di test più piccoli e rappresentativi che mantengono la complessità dei dati reali senza esporre informazioni sensibili.

2. Analisi ed Esplorazione dei Dati

Quando si ha a che fare con set di dati immensi, l’analisi esplorativa iniziale può richiedere molto tempo. Creando un sottoinsieme, gli analisti possono ottenere rapidamente intuizioni e testare ipotesi prima di passare all’analisi del set di dati completo.

3. Sviluppo di Modelli di Machine Learning

Durante le fasi iniziali dello sviluppo del modello, i data scientist possono utilizzare sottoinsiemi per iterare rapidamente su diversi algoritmi e iperparametri prima di addestrare il modello sul set di dati completo.

4. Ottimizzazione del Database

Gli amministratori di database possono utilizzare il sottocampionamento per creare versioni più piccole dei database di produzione da utilizzare in ambienti di sviluppo e testing, assicurando prestazioni ottimali senza l’onere di gestire repliche a grande scala.

Panoramica sulla Conformità dei Dati | Quadri Normativi

Sottocampionamento e Mascheramento Automatizzati, Guidati da Politiche

Gli estratti SQL creati manualmente si interrompono non appena gli schemi cambiano. I team moderni, invece, si affidano a scoperta automatizzata, motori di regole e mascheramento dinamico per generare sottoinsiemi conformi su richiesta. DataSunrise scansiona i sistemi sorgente, identifica le colonne sensibili tramite impronte digitali e poi costruisce fette referenzialmente intatte, complete di mascheramento in tempo reale per PII o PHI, in modo che i team di QA e analisi non debbano mai toccare i dati di produzione grezzi.

Ogni esportazione viene versionata, registrata e resa riproducibile tramite API REST, fornendo agli auditor una traccia chiara mentre i DevOps possono attivare copie ridotte e aggiornate nei pipeline CI/CD. Il risultato: cicli di sviluppo più rapidi, costi cloud inferiori e una conformità a prova di bomba senza dover riscrivere neanche una query.

Strumenti e Tecniche per il Sottocampionamento dei Dati

Ora che comprendiamo l’importanza del sottocampionamento dei dati, esaminiamo alcuni strumenti e tecniche popolari per implementarlo in modo efficace.

SQL per il Sottocampionamento dei Dati

SQL è un linguaggio potente per la manipolazione dei dati ed è eccellente per il sottocampionamento dei database relazionali. Ecco un esempio di come creare un sottoinsieme di dati utilizzando SQL:

-- Crea un sottoinsieme di dati dei clienti per l'anno 2023 CREATE TABLE customer_subset_2023 AS SELECT * FROM customers WHERE EXTRACT(YEAR FROM order_date) = 2023 LIMIT 10000;

Questa query crea una nuova tabella customer_subset_2023 contenente fino a 10.000 record di clienti relativi all’anno 2023. Il risultato è un set di dati più piccolo e gestibile per scopi di analisi o testing.

Python per il Sottocampionamento dei Dati

Grazie al suo ricco ecosistema di librerie per la manipolazione dei dati, Python offre strumenti potenti per il sottocampionamento.

Dispone di un tipo di dato incorporato chiamato “set”, utile per memorizzare elementi unici ed eseguire operazioni matematiche sugli insiemi. Tuttavia, sebbene i set siano efficienti per alcuni compiti, non sono tipicamente usati per operazioni su big data. Per gestire grandi set di dati in Python, librerie specializzate come pandas, NumPy o PySpark sono spesso impiegate grazie alle loro prestazioni ottimizzate e alle avanzate capacità di manipolazione dei dati.

Vediamo un esempio utilizzando pandas:

import pandas as pd

import numpy as np

# Carica il set di dati completo

full_dataset = pd.read_csv('large_dataset.csv')

# Crea un sottoinsieme basato su una condizione e un campionamento casuale

subset = full_dataset[full_dataset['category'] == 'electronics'].sample(n=1000, random_state=42)

# Salva il sottoinsieme in un nuovo file CSV

subset.to_csv('electronics_subset.csv', index=False)Questo script carica un grande set di dati, lo filtra per includere solo gli elementi della categoria elettronica, quindi estrae casualmente 1.000 righe per creare un sottoinsieme. Il risultato viene salvato come nuovo file CSV.

In Pandas è anche possibile filtrare i dati con istruzioni come le seguenti:

filtered_df_loc = df.loc[df['age'] > 25, ['name', 'city']]

oppure

filtered_df = df[df['age'] > 25]

Filtraggio dei Dati Basato su Condizioni in R

R è un altro linguaggio potente per la manipolazione e l’analisi dei dati, ampiamente utilizzato nel calcolo statistico e nella data science. Mentre Python è spesso preferito per il deep learning, R possiede forti capacità nell’apprendimento statistico e nel machine learning tradizionale. Questo può essere vantaggioso quando il sottocampionamento dei dati coinvolge approcci basati su modelli o quando è necessario analizzare le proprietà statistiche dei sottoinsiemi.

Puoi eseguire questo codice nella versione Posit Cloud di RStudio con account gratuito.

# Carica la libreria necessaria

library(dplyr)

# Supponiamo di avere un grande set di dati chiamato 'full_dataset'

# Per questo esempio, creeremo un set di dati di esempio

set.seed(123) # per riproducibilità

full_dataset <- data.frame(

id = 1:1000,

category = sample(c("A", "B", "C"), 1000, replace = TRUE),

value = rnorm(1000)

)

# Crea un sottoinsieme basato su una condizione e un campionamento casuale

subset_data <- full_dataset %>%

filter(category == "A") %>%

sample_n(100)

# Visualizza le prime righe del sottoinsieme

head(subset_data)

# Salva il sottoinsieme in un file CSV

write.csv(subset_data, "category_A_subset.csv", row.names = FALSE)

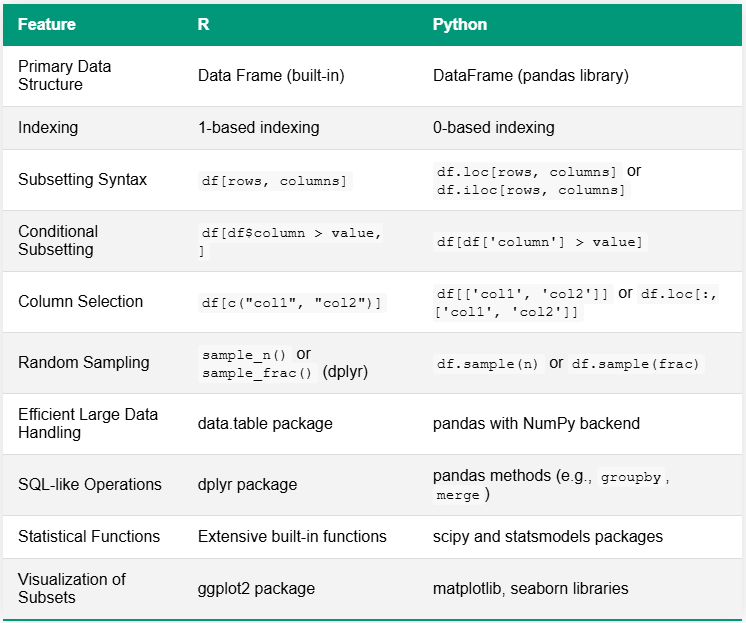

La tabella sottostante confronta R e Python per i compiti di sottocampionamento dei dati, evidenziando le principali differenze nella sintassi e nelle funzionalità. Una distinzione notevole risiede nei loro ecosistemi: R spesso dispone di funzioni incorporate o si affida a pochi pacchetti completi, mentre Python utilizza tipicamente una varietà di librerie specializzate per capacità simili.

Strumenti Open-Source per il Sottocampionamento dei Dati

Esistono diversi strumenti open-source disponibili per esigenze più avanzate:

- Jailer: Uno strumento per il sottocampionamento dei database che preserva l’integrità referenziale.

- Benerator CE: Un framework open-source per generare e sottocampionare dati di test.

- Subsetter: Una libreria Python per il sottocampionamento dei database relazionali mantenendo l’integrità referenziale.

Questi strumenti offrono funzionalità più sofisticate, come il mantenimento di relazioni complesse tra le tabelle e la generazione di dati sintetici per integrare i sottoinsiemi.

Migliori Pratiche per un Sottocampionamento Efficace

Per sfruttare al meglio il sottocampionamento dei dati, considera queste migliori pratiche:

- Mantenere l’Integrità dei Dati: Assicurati che il tuo sottoinsieme preservi le relazioni e i vincoli del set di dati originale.

- Utilizzare Campioni Rappresentativi: Sforzati di creare sottoinsiemi che rappresentino accuratamente le caratteristiche del set di dati completo.

- Considerare la Sensibilità dei Dati: Quando sottocampioni per scopi di testing o sviluppo, presta attenzione alle informazioni sensibili e applica le appropriate tecniche di anonimizzazione.

- Documentare il Tuo Processo: Tieni registri chiari su come sono stati creati i sottoinsiemi per garantirne la riproducibilità.

- Validare i Tuoi Sottoinsiemi: Verifica regolarmente che i sottoinsiemi rappresentino ancora in modo accurato il set di dati completo man mano che questo evolve nel tempo.

Conclusione

Il sottocampionamento dei dati è una tecnica potente che può migliorare significativamente le tue pratiche di gestione dei dati. Creando set di dati più piccoli e gestibili, puoi migliorare le prestazioni, ridurre i costi e semplificare i processi di sviluppo e testing. Che tu stia utilizzando SQL, Python o strumenti specializzati, padroneggiare il sottocampionamento dei dati è una competenza essenziale per ogni professionista dei dati.

Nel intraprendere il tuo percorso nel sottocampionamento dei dati, ricorda che la chiave del successo risiede nel mantenere l’integrità dei dati, garantire la rappresentatività e scegliere gli strumenti più adatti alle tue esigenze specifiche.