Strategie di Controllo degli Accessi nei Sistemi GenAI & LLM

Poiché l’Intelligenza Artificiale Generativa e i modelli di linguaggio di grandi dimensioni (LLM) stanno diventando parte integrante delle operazioni aziendali, garantire la sicurezza dell’accesso ai dati sottostanti non è più opzionale. Questi sistemi ingeriscono, elaborano e generano intuizioni basate su dataset di alto valore, che spesso includono informazioni personali, proprietarie o soggette a regolamentazioni. Senza un controllo degli accessi efficace, le organizzazioni rischiano perdite di dati, violazioni della conformità e contaminazioni dei modelli a valle.

Le Sfide del Controllo degli Accessi in GenAI

A differenza dei database tradizionali, i sistemi GenAI operano su dati non strutturati e semi-strutturati, rendendo insufficienti i controlli basati sul perimetro. Un singolo prompt potrebbe attivare più livelli di ricerche vettoriali, generazione aumentata dal recupero (RAG) e sintesi. L’accesso deve essere regolato ad ogni fase: dall’ingestione del prompt, alla query sul vector store, all’elaborazione del modello e fino all’output del risultato. Questa complessità richiede strategie di sicurezza granulari e adattive.

La necessità di controlli a più livelli nei carichi di lavoro di intelligenza artificiale è ribadita in risorse quali Google’s Secure AI Framework (SAIF) e NIST’s AI Risk Management Framework, che raccomandano trasparenza, governance e tracciabilità come principi fondamentali.

Controlli di Accesso Dinamici con Audit in Tempo Reale

I sistemi di intelligenza artificiale moderni beneficiano del monitoraggio in tempo reale delle attività del database, che consente alle organizzazioni di rilevare e bloccare query non autorizzate nel momento stesso in cui si verificano. L’audit in tempo reale non solo registra ogni interazione, ma abilita anche l’allerta basata sul comportamento e l’applicazione delle policy. Ad esempio, se un utente esegue inaspettatamente query su record ad alta sensibilità o utilizza una struttura di input insolita, il sistema può sospendere l’esecuzione o mascherare automaticamente gli output.

-- Esempio di regola di audit guidata da policy in PostgreSQL con pgAudit

ALTER SYSTEM SET pgaudit.log = 'all';

-- In combinazione con il logging del vector store:

INSERT INTO audit_logs (timestamp, user_id, action, query)

VALUES (NOW(), current_user, 'embedding_lookup', 'SELECT * FROM vector_index WHERE ...');

I registri di audit possono essere inoltrati a sistemi SIEM o integrati con soluzioni come le funzionalità di apprendimento e allerta di DataSunrise per una difesa proattiva. Per le applicazioni LLM native nel cloud, piattaforme come Azure Monitor e Amazon CloudWatch supportano anche l’ispezione e la rimedio in tempo reale.

Mascheramento Dinamico dei Dati per la Protezione di Prompt e Output

Un metodo efficace per proteggere contenuti sensibili sia negli input che negli output è il mascheramento dinamico dei dati. Ad esempio, quando un prompt include identificatori personali o dati finanziari, il mascheramento garantisce che i LLM possano eseguire compiti rilevanti (come classificazione o sintesi) senza esporre i dati grezzi agli utenti o persino al modello in forma in chiaro.

-- Regola pseudo per mascherare il numero di carta di credito prima di inviarlo al modello

IF query CONTAINS 'credit_card_number' THEN

MASK 'credit_card_number' USING 'XXXX-XXXX-XXXX-####';

END IF;

Questo approccio consente ai LLM di mantenere la funzionalità minimizzando l’esposizione, particolarmente utile in flussi di lavoro per il servizio clienti, le risorse umane e i documenti legali. Progetti open-source come Presidio di Microsoft dimostrano come il mascheramento e l’anonimizzazione possano essere integrati nelle pipeline di NLP.

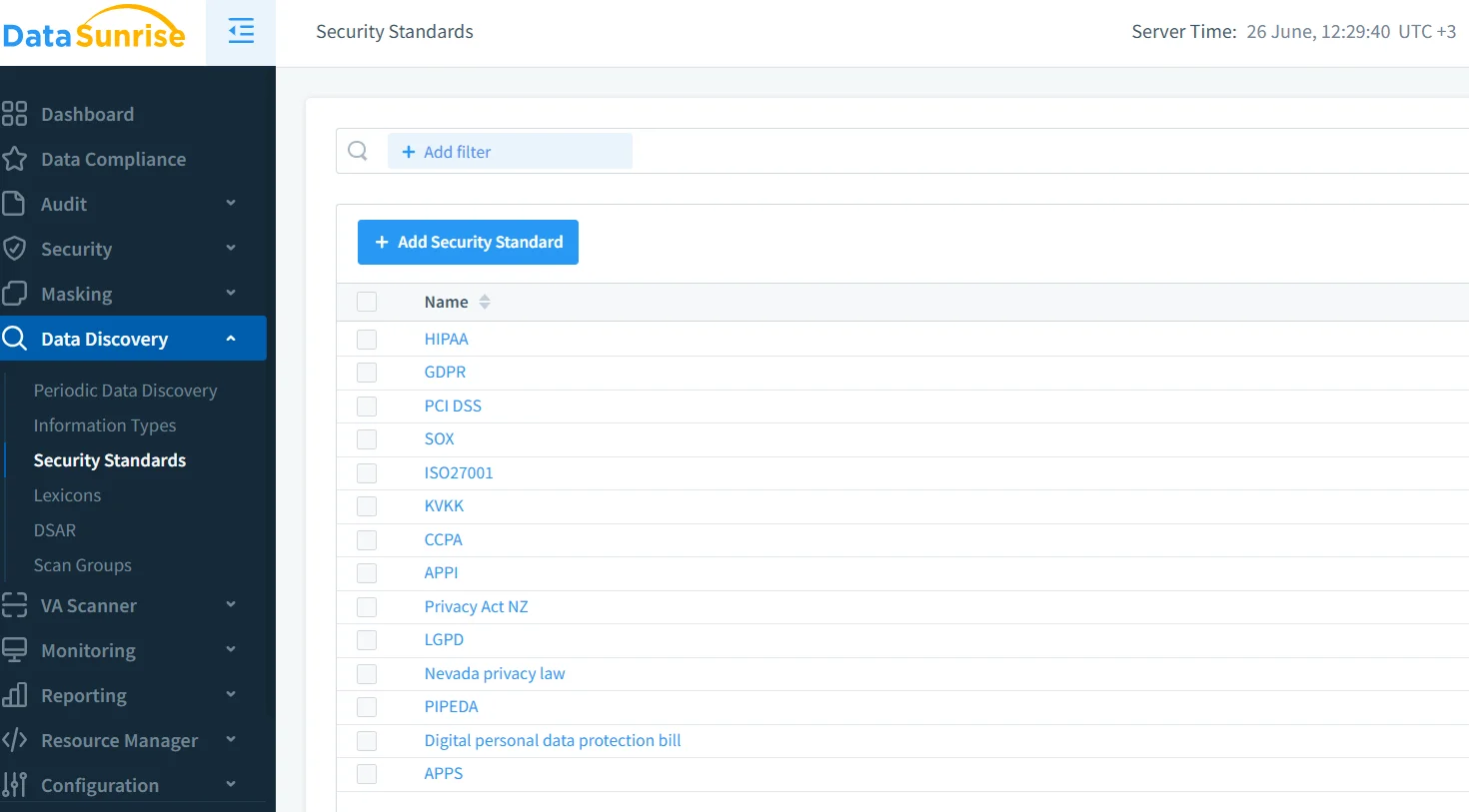

Data Discovery per Classificare e Governare le Fonti di Input

Il controllo degli accessi inizia con la visibilità. Gli strumenti di data discovery possono scansionare automaticamente database, object store e repository di documenti per classificare i campi sensibili prima che raggiungano il modello. Ciò include PII, PHI, dati finanziari, codice sorgente o proprietà intellettuale.

In combinazione con le pipeline di AI, gli asset scoperti possono essere etichettati, segmentati o instradati attraverso diversi flussi di lavoro in base alla loro classificazione. Questo garantisce che i documenti non sensibili siano trattati con maggiore libertà, mentre i contenuti ad alto rischio innescano politiche più rigorose. Principi simili sono delineati nel Playbook per la Governance dell’AI di IBM per la gestione di dati strutturati e non strutturati in settori regolamentati.

Allineamento alla Conformità e Applicazione delle Politiche

Normative come GDPR, HIPAA e PCI DSS impongono regole specifiche riguardo all’accesso, alla conservazione e alla gestione dei dati. Per i sistemi di intelligenza artificiale, questi requisiti si estendono ai dataset di addestramento, alle inferenze dei modelli e ai registri. I responsabili della conformità devono integrare tali requisiti direttamente nella logica di controllo degli accessi.

Ad esempio, una piattaforma LLM allineata al GDPR potrebbe:

- Offuscare gli identificatori utente dai prompt a meno che non sia stato concesso un consenso esplicito

- Eliminare i registri delle inferenze dopo 30 giorni

- Limitare l’uso del modello per regione o ambito giuridico

Utilizzando strumenti di conformità automatizzati, le organizzazioni possono far rispettare queste politiche su larga scala senza introdurre costi operativi aggiuntivi. Ulteriori indicazioni sono disponibili anche dalle raccomandazioni di conformità AI dell’EDPB e dalle linee guida dell’ICO su AI e protezione dei dati.

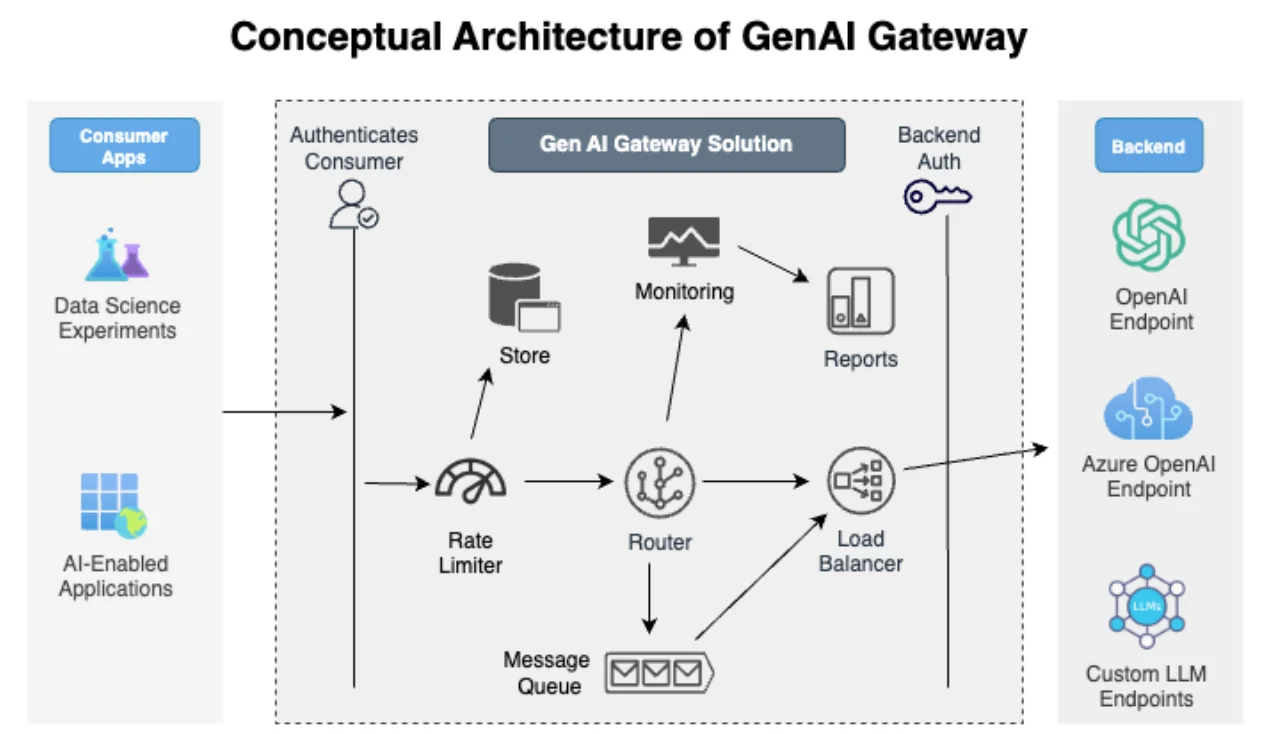

Architettura GenAI con Priorità alla Sicurezza

Le strategie efficaci di controllo degli accessi non vengono implementate a posteriori, ma sono integrate nell’architettura del sistema. Questo include:

- Firewall basati su proxy che ispezionano i payload dei prompt

- Controllo degli Accessi Basato sui Ruoli (RBAC) che limita chi può interrogare determinati modelli e dataset

- Progettazione con il principio del privilegio minimo applicato alle chiavi API, agli scope di accesso dei modelli e all’utilizzo dei dataset

Ad esempio, gli sviluppatori che lavorano su un modello chatbot potrebbero avere accesso solo a campioni di dati sintetici o mascherati, mentre i responsabili della conformità possono visualizzare i registri completi dell’audit senza però accedere al testo grezzo del prompt. Questo approccio si allinea alle pratiche descritte nel MITRE’s AI Security Framework per proteggere i sistemi di apprendimento da injection di prompt e uso improprio dei modelli.

Conclusione

Implementare robuste Strategie di Controllo degli Accessi nei Sistemi GenAI & LLM richiede una combinazione di scoperta, applicazione, monitoraggio e governance. I registri di audit in tempo reale, il mascheramento dinamico dei dati e le politiche basate sulla classificazione devono lavorare in armonia per proteggere i dati sia in transito che a riposo.

Soluzioni come il motore di audit e masking di DataSunrise offrono la flessibilità e l’intelligenza necessarie per proteggere gli ecosistemi GenAI senza compromettere le prestazioni o la conformità. Man mano che sempre più aziende integrano i LLM nei loro flussi di lavoro, la capacità di adattare dinamicamente i controlli degli accessi sarà fondamentale sia per l’innovazione che per la responsabilità.

Ulteriori approfondimenti sono disponibili nella guida di riferimento sulla sicurezza degli LLM, nei principi fondamentali della sicurezza dei dati e in framework quali la mappa della conoscenza sulle minacce AI di OpenCRE.

Proteggi i tuoi dati con DataSunrise

Metti in sicurezza i tuoi dati su ogni livello con DataSunrise. Rileva le minacce in tempo reale con il Monitoraggio delle Attività, il Mascheramento dei Dati e il Firewall per Database. Applica la conformità dei dati, individua le informazioni sensibili e proteggi i carichi di lavoro attraverso oltre 50 integrazioni supportate per fonti dati cloud, on-premises e sistemi AI.

Inizia a proteggere oggi i tuoi dati critici

Richiedi una demo Scarica ora