Strategie di Protezione dei Dati per Architetture genAI

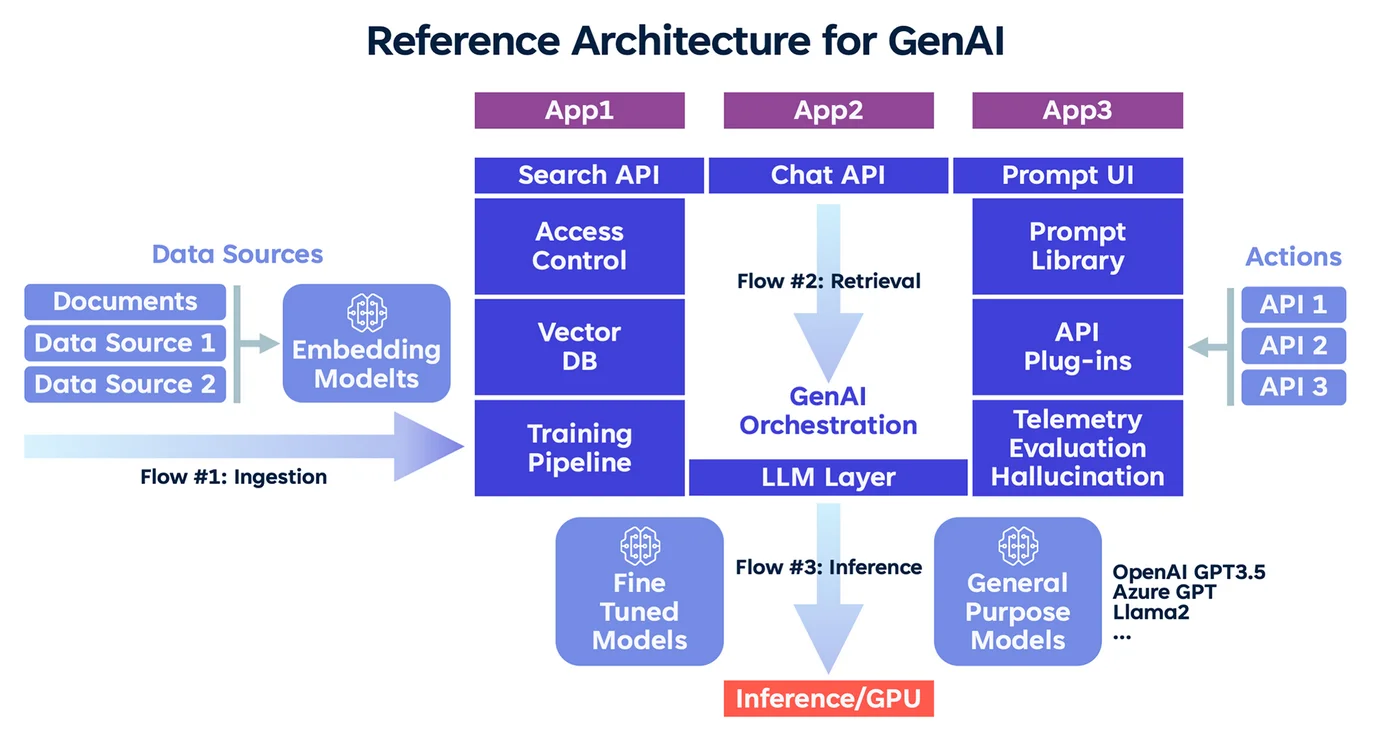

La generative AI sta trasformando il modo in cui le organizzazioni interagiscono con i dati. Ma, man mano che le sue capacità evolvono, anche i rischi aumentano — in particolare quando i modelli linguistici di grandi dimensioni elaborano informazioni personali, finanziarie o proprietarie. Progettare sistemi genAI sicuri richiede un focus deliberato su privacy, controllo e visibilità.

Questo articolo esplora le strategie di protezione dei dati per le architetture genAI essenziali, inclusi audit in tempo reale, masking dinamico, data discovery e gestione della conformità. Insieme, questi approcci assicurano che l’innovazione non comprometta l’integrità delle informazioni.

Perché la genAI Richiede Protezioni Più Rigorose

I modelli genAI sono progettati per generare output basati sui pattern appresi. Sebbene questo li renda utili per la generazione di contenuti, il riassunto o il completamento del codice, introduce anche rischi. I modelli possono memorizzare dati sensibili, rivelare artefatti di addestramento o produrre contenuti allucinati contenenti informazioni regolamentate.

Questi rischi si amplificano quando prompt, dati utenti e rappresentazioni intermedie non sono adeguatamente controllati. Un robusto framework di protezione deve monitorare, oscurare e far rispettare le policy in tempo reale.

Audit in Tempo Reale come Livello di Controllo

I log di audit non sono più opzionali per i sistemi AI — sono una necessità per la conformità e la sicurezza. Registrare ogni query, interazione utente e output del modello consente ai team di ricostruire sequenze rischiose, rilevare tentativi di prompt injection e generare report di conformità per regolamenti come GDPR o HIPAA.

Strumenti come DataSunrise Audit forniscono logging in tempo reale su database e applicazioni, acquisendo attività sia strutturate che non strutturate. In combinazione con le analisi del comportamento, le organizzazioni possono segnalare anomalie nell’accesso o nell’uso improprio della genAI.

-- Esempio: tabella di audit per prompt e risposte

CREATE TABLE genai_audit (

id SERIAL PRIMARY KEY,

user_id TEXT,

prompt TEXT,

response TEXT,

timestamp TIMESTAMPTZ DEFAULT now()

);

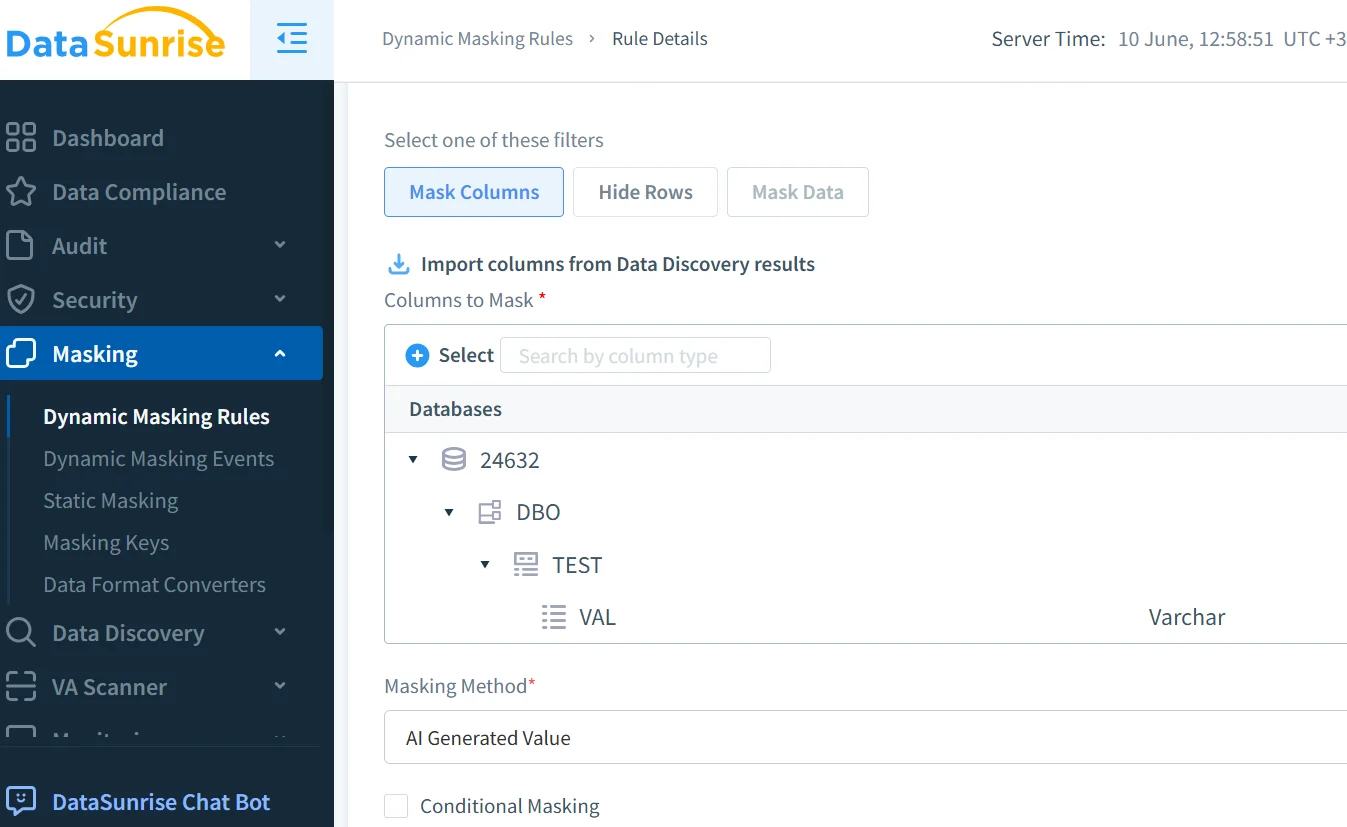

Masking Dinamico per Prevenire Perdite di Dati

Una delle protezioni più efficaci è il masking dinamico, che oscura i contenuti sensibili durante l’elaborazione o la generazione delle risposte da parte dell’AI. A differenza del masking statico, si adatta in tempo reale — essenziale per compiti generativi.

Ad esempio, se un prompt include un Numero di Previdenza Sociale, i motori di masking possono intercettarlo e oscurarlo prima che il modello elabori l’input.

Il masking dinamico di DataSunrise si integra con i sistemi NLP, applicando regole granulari che si adattano al contesto e ai ruoli. Questo previene l’esposizione di informazioni personali identificabili (PII) e si allinea ai controlli di accesso basati sui ruoli.

Data Discovery per Pipeline di Input dell’AI

Non puoi proteggere ciò che non sai esista. Gli strumenti di data discovery analizzano data lake, vector store e input del modello. Aiutano a individuare PII, PHI e dati PCI, a scoprire contenuti di addestramento sensibili e a rivelare database nascosti spesso trascurati dalle revisioni manuali.

Utilizzando le capacità di data discovery di DataSunrise, i team possono automatizzare la classificazione prima che i dataset entrino nel flusso di lavoro di addestramento o inferenza. Questo aiuta a far rispettare i limiti di conservazione, l’uso basato sul consenso e l’oscuramento dei dati.

Allineamento con i Framework di Conformità dei Dati

La protezione dei dati nella genAI non riguarda solo le buone pratiche — è un requisito di conformità. A seconda del settore e della geografia, le organizzazioni potrebbero dover rispettare il GDPR in Europa, l’HIPAA nel settore sanitario o il PCI DSS in quello finanziario.

Strumenti di conformità come il DataSunrise Compliance Manager supportano la reportistica automatizzata e le policy sulla sicurezza dei dati. Questi possono essere collegati ai punti finali AI, garantendo che prompt e output vengano elaborati secondo standard legali ed etici.

Sicurezza End-to-End nei Flussi di Lavoro Guidati dall’AI

Oltre al masking e all’audit, la sicurezza della genAI deve affrontare rischi a livello di infrastruttura. Ciò include l’uso di controlli reverse proxy per ispezionare il traffico dei LLM, l’applicazione di rilevamenti per SQL injection su query integrate e l’imposizione di policy di accesso con privilegi minimi sia a livello di modello che di database.

Quando i modelli interrogano database o arricchiscono contenuti utilizzando la retrieval-augmented generation (RAG), questi controlli impediscono movimenti laterali e l’eccessiva esposizione dei dati.

Costruire una GenAI Che Rispetti i Confini

L’obiettivo reale della protezione dei dati nella genAI non è limitare ma abilitare un uso fidato. Combinando la visibilità dell’audit, il masking contestuale e la data discovery orientata alla sicurezza, le organizzazioni possono mantenere il controllo sui dati sensibili, favorire l’adozione scalabile dell’AI e ridurre il rischio di non conformità in tutti i reparti.

In definitiva, le strategie di protezione dei dati per le architetture genAI fungono da base per un’integrazione dell’AI etica, sicura e scalabile. Per una comprensione più ampia delle sfide relative alla privacy in ambito AI, vedi il AI Risk Management Framework del NIST. Per esplorare pratiche di sicurezza open-source per LLM, la base di conoscenza MITRE ATLAS è un’altra preziosa risorsa esterna. La sfida non è solo rendere l’AI potente, ma renderla responsabile.