Tecniche di Mitigazione del Rischio per GenAI

L’Intelligenza Artificiale Generativa (GenAI) ha cambiato il modo in cui le aziende interagiscono con i dati. Questi modelli scrivono contenuti, generano codice, riassumono documenti e automatizzano decisioni. Ma sollevano anche preoccupazioni riguardo alla privacy dei dati, alla sicurezza e alla conformità. Il rischio aumenta quando i sistemi GenAI elaborano dati sensibili o regolamentati senza adeguati controlli.

Questo articolo esplora le essenziali Tecniche di Mitigazione del Rischio per GenAI, tra cui l’audit in tempo reale, il masking dinamico, la scoperta dei dati e altre protezioni fondamentali. Ogni tecnica gioca un ruolo specifico nel ridurre l’esposizione alle minacce, consentendo al contempo l’innovazione.

Perché GenAI Introduce Rischi di Sicurezza Unici

A differenza dei sistemi basati su regole, GenAI apprende da grandi set di dati e utilizza il ragionamento probabilistico. Può dedurre relazioni, ricostruire dati privati e produrre output che violano le politiche interne. Questi problemi sorgono spesso a causa di controlli deboli sui prompt, formazione su set di dati non filtrati e limitata trasparenza sul comportamento del modello. Senza un’adeguata registrazione o applicazione, ciò diventa un importante vettore di minaccia in ambienti regolamentati.

Per ulteriori approfondimenti, vedi l’Indice AI della Stanford, che evidenzia le sfide nell’allineamento dei modelli e nella trasparenza dei dati.

Audit in Tempo Reale per la Visibilità su Prompt e Dati

Il monitoraggio in tempo reale dell’attività del database aiuta le organizzazioni a tenere traccia delle query GenAI per garantire la conformità. Registra ogni prompt che interagisce con il layer dei dati, catturando query SQL, ruoli degli utenti, indirizzi IP e dati di sessione.

Questo è essenziale quando si lavora con strumenti come LangChain o il function calling di OpenAI, in cui le query al database vengono generate dinamicamente. Per esempio:

SELECT full_name, email FROM customers WHERE preferences LIKE '%personal%';Questa query, quando attivata da un LLM, può essere registrata e revisionata utilizzando le migliori pratiche di log degli audit per rilevare accessi a dati sensibili. Garantisce la responsabilità e supporta la risposta agli incidenti di sicurezza.

Masking Dinamico dei Dati per Controllare l’Output

Il masking dinamico protegge i dati sensibili anche quando vengono accessi. Opera in tempo reale, applicando politiche contestuali che nascondono numeri di carte di credito, identificatori personali e altro ancora.

Esempio:

SELECT name, credit_card_number FROM payments;

-- risultato mascherato: SELECT name, '****-****-****-1234'Il masking è cruciale quando si integra GenAI con database relazionali o vector store. Secondo le linee guida NIST sulla sicurezza AI, i controlli dinamici aiutano a garantire che i LLM non possano trapelare dati privati anche se viene concesso l’accesso. Vedi anche le indicazioni di IBM sulla privacy AI.

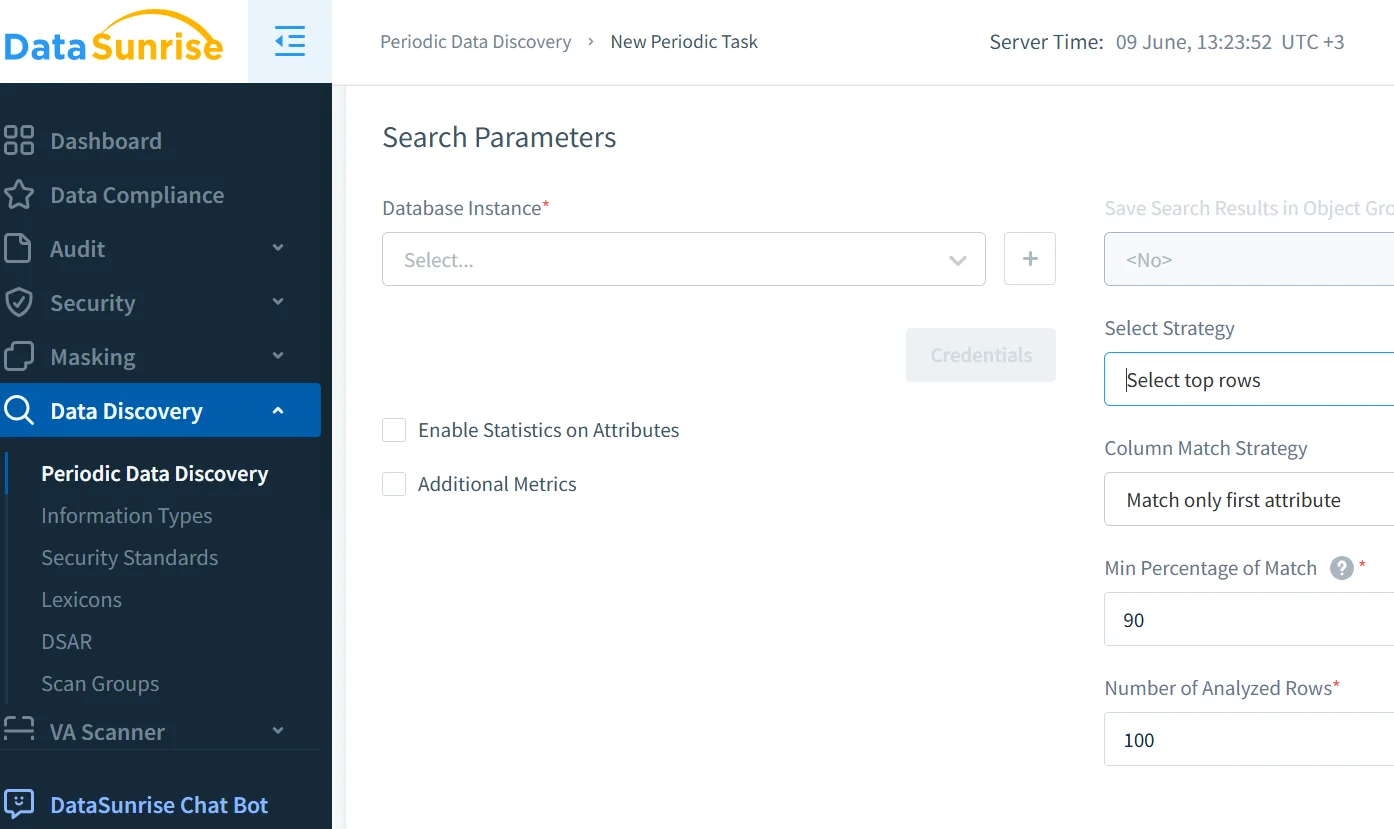

Scoperta e Classificazione dei Dati Prima del Fine-Tuning

Prima di utilizzare i dati nelle pipeline RAG o nel training di GenAI, la scoperta dei dati è fondamentale. Essa identifica ed etichetta contenuti regolamentati come PII, PHI e credenziali, prevenendo l’esposizione accidentale.

In combinazione con la generazione di dati sintetici e le tecniche delineate da Google Cloud, ciò consente operazioni di training, fine-tuning e recupero dei dati più sicure.

Una corretta classificazione aiuta a far rispettare le politiche di sicurezza, attivare le regole di masking e dimostrare la conformità con il GDPR, HIPAA e PCI DSS. Il Future of Privacy Forum fornisce inoltre solide linee guida sull’uso responsabile dei dati AI.

Conformità e Governance per le Pipeline AI

La conformità per GenAI va oltre la registrazione: deve integrare valutazioni continue del rischio, controlli di accesso, masking e applicazioni automatizzate.

Il DataSunrise Compliance Manager supporta reportistica automatizzata, applicazione coerente delle politiche e allerta in tempo reale. Si integra con strumenti esterni per una più ampia osservabilità del rischio e riduce gli sforzi di preparazione degli audit. Ulteriori framework sono dettagliati nei Principi AI dell’OCSE.

Strati di Sicurezza Personalizzati per le Pipeline GenAI

Le difese standard come i firewall non sono sufficienti. I sistemi GenAI necessitano di controlli di accesso basati sui ruoli (RBAC), protezione contro le iniezioni SQL e filtri basati sul comportamento per iniezioni di prompt.

Si consiglia di allineare le difese con la Top 10 OWASP per applicazioni basate su LLM, che raccomanda di mascherare gli output, validare gli input e sandboxare i servizi AI. Esplora inoltre il Panorama delle Minacce AI di ENISA per una visione completa dei rischi.

Per ambienti cloud-native, proxy consapevoli dell’AI e firewall per database aiutano a proteggere i punti di ingresso. Il firewall per database di DataSunrise offre questa funzionalità con supporto per oltre 40 piattaforme di dati.

Esempio di Caso d’Uso: Chatbot per il Supporto Clienti con RAG

Un chatbot per il supporto utilizza il Retrieval-Augmented Generation per estrarre dati da conoscenze interne e registrazioni dei clienti basate su PostgreSQL. Se non controllato, potrebbe rivelare informazioni personali sensibili.

Abilitando il masking a livello SQL, registrando ogni query del chatbot, scansionando i dati di training per PII e classificando i prompt in base al rischio, l’azienda mantiene il chatbot sia reattivo che conforme.

Ciò si allinea con lo Standard di AI Responsabile di Microsoft e aiuta a far rispettare il principio della privacy by design.

Conclusione: Tecniche di Mitigazione del Rischio per GenAI in Pratica

I moderni sistemi AI necessitano di molto più che fiducia. Hanno bisogno di controllo. Combinando audit, masking, scoperta e governance basata su politiche, le organizzazioni riducono il rischio di perdite di dati indotte dall’AI e di fallimenti in materia di conformità.

Efficaci Tecniche di Mitigazione del Rischio per GenAI si integrano in tutto lo stack — dal filtraggio dei prompt all’applicazione delle politiche sul database — offrendo tracciabilità e difesa in tempo reale.

Per approfondire le applicazioni pratiche, visita:

- Analisi del Comportamento

- Framework NIST per la Gestione del Rischio AI

- Strumenti di Sicurezza e Monitoraggio per LLM

- Google Secure AI Framework (SAIF)

- Pratiche di Protezione dei Dati

- Partnership on AI

- Database degli Incidenti AI

Con le giuste pratiche, GenAI può guidare l’innovazione in modo sicuro e responsabile.