Valutazione della Postura di Sicurezza nei Contesti AI & LLM

L’Intelligenza Artificiale Generativa (GenAI) e i modelli linguistici di grandi dimensioni (LLM) hanno aperto nuove modalità per le organizzazioni di automatizzare, analizzare e accelerare il processo decisionale. Tuttavia, il loro design intrinseco—gestendo dati dinamici, spesso non strutturati e sensibili—solleva seri problemi di sicurezza. Valutare la postura di sicurezza nei contesti di AI & LLM richiede nuove strategie su misura per il modo in cui questi modelli elaborano ed espongono i dati.

Dal Modello di Sicurezza Tradizionale a Quello Adattivo

In sistemi tradizionali, la sicurezza dei dati si basava spesso sui perimetri. Con la GenAI, la sicurezza deve diventare contestuale. Questi modelli elaborano grandi dataset, conservano pattern e possono rigenerare informazioni sensibili se non configurati correttamente. Un prompt potrebbe inavvertitamente estrarre credenziali, segreti aziendali o informazioni personali identificabili (PII).

Pertanto, proteggere le pipeline di AI non riguarda solamente firewall e ruoli. Richiede sicurezza dei dati adattiva, logging attento alla privacy e controlli in tempo reale integrati nel ciclo di vita dell’AI. Come evidenziato dalle pratiche di AI sicura di Google, i controlli specifici per AI devono allinearsi sia all’infrastruttura che al comportamento del modello.

Audit in Tempo Reale e Monitoraggio del Comportamento

I carichi di lavoro AI necessitano di meccanismi di audit in tempo reale per catturare ogni interazione tra utenti e modelli. Poiché i sistemi GenAI possono generare output innovativi ad ogni prompt, il logging deve coprire input, output, identità della sessione e query a valle.

Considera questo scenario: un analista dei dati interagisce con un sistema GenAI interno tramite linguaggio naturale.

Prompt: "Elenca tutti i clienti dalla Germania che hanno effettuato acquisti superiori a $10,000 nell'ultimo trimestre."

Il LLM genera la query SQL:

SELECT customer_id, name, email, country, total_purchase

FROM sales.customers

WHERE country = 'Germany' AND total_purchase > 10000 AND purchase_date BETWEEN '2024-10-01' AND '2024-12-31';

Questa richiesta coinvolge identificatori dei clienti, informazioni di contatto e dati finanziari. Un audit trail ben progettato catturerà sia il prompt che la query SQL generata, collegandoli alla sessione dell’utente e al contesto temporale. Strumenti come il behavior learning audit aiutano a identificare se tale accesso è abituale o potenzialmente abusivo. Questo approccio è in linea con il Framework di Gestione del Rischio AI del NIST, che sottolinea il monitoraggio continuo.

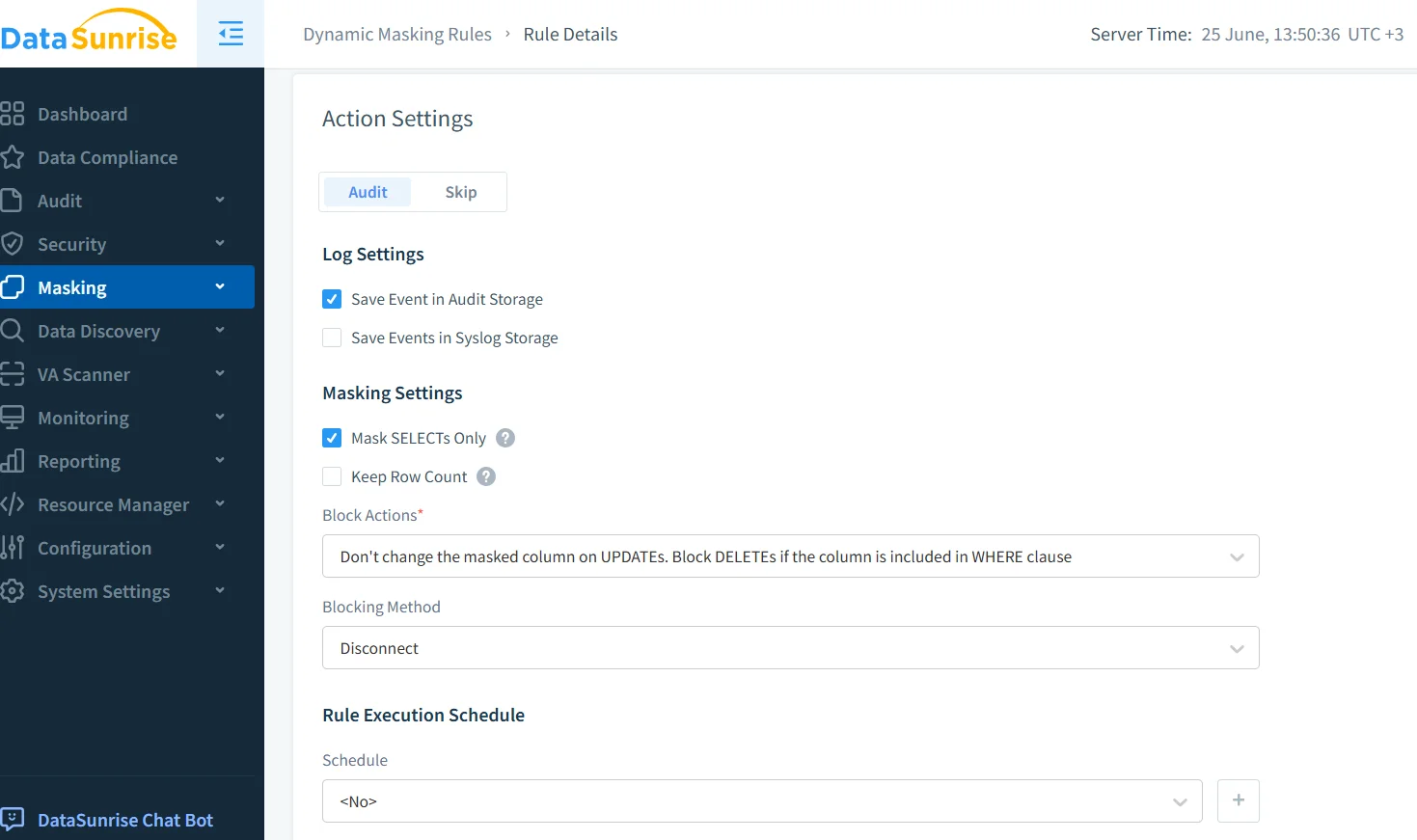

Mascheramento Dinamico per le Risposte dei Modelli

Poiché gli output della GenAI sono generati dinamicamente, il mascheramento dinamico dei dati assicura che le informazioni sensibili siano oscurate prima della visualizzazione. Questo approccio equilibra usabilità e conformità.

Supponiamo che un bot di supporto sia collegato a un database di assistenza clienti. Quando viene richiesto:

"Mostrami il profilo del cliente per John Doe."

Il backend potrebbe produrre:

{

"name": "John Doe",

"email": "[email protected]",

"ssn": "123-45-6789",

"credit_card": "4111 1111 1111 1111"

}

Con il mascheramento abilitato per i campi sensibili:

{

"name": "John Doe",

"email": "j*****[email protected]",

"ssn": "***-**-6789",

"credit_card": "**** **** **** 1111"

}

Il mascheramento è contestuale e dipende dal ruolo dell’utente, dalla fonte e dalle regole di classificazione. Microsoft raccomanda anche di proteggere gli output dei dati nei sistemi AI attraverso tecniche di applicazione stratificate.

Scoperta dei Dati Prima dell’Esposizione all’AI

Prima di alimentare i dati nei LLM, le organizzazioni devono utilizzare strumenti di data discovery per rilevare informazioni personali identificabili, identificatori finanziari e valori sensibili per l’azienda. Ciò consente ai team di sicurezza di etichettare gli asset ad alto rischio ed escluderli dai set di addestramento o dall’accesso in tempo reale.

Invece di affidarsi esclusivamente alla configurazione manuale, la scoperta automatizzata può classificare i campi sensibili e integrarsi con il mascheramento, la crittografia o le regole di accesso. La guida alla governance dei dati di IBM offre pratiche preziose per configurare efficacemente questi flussi di lavoro. L’integrazione con motori di policy automatizzati garantisce un’applicazione coerente in tutti gli ambienti AI.

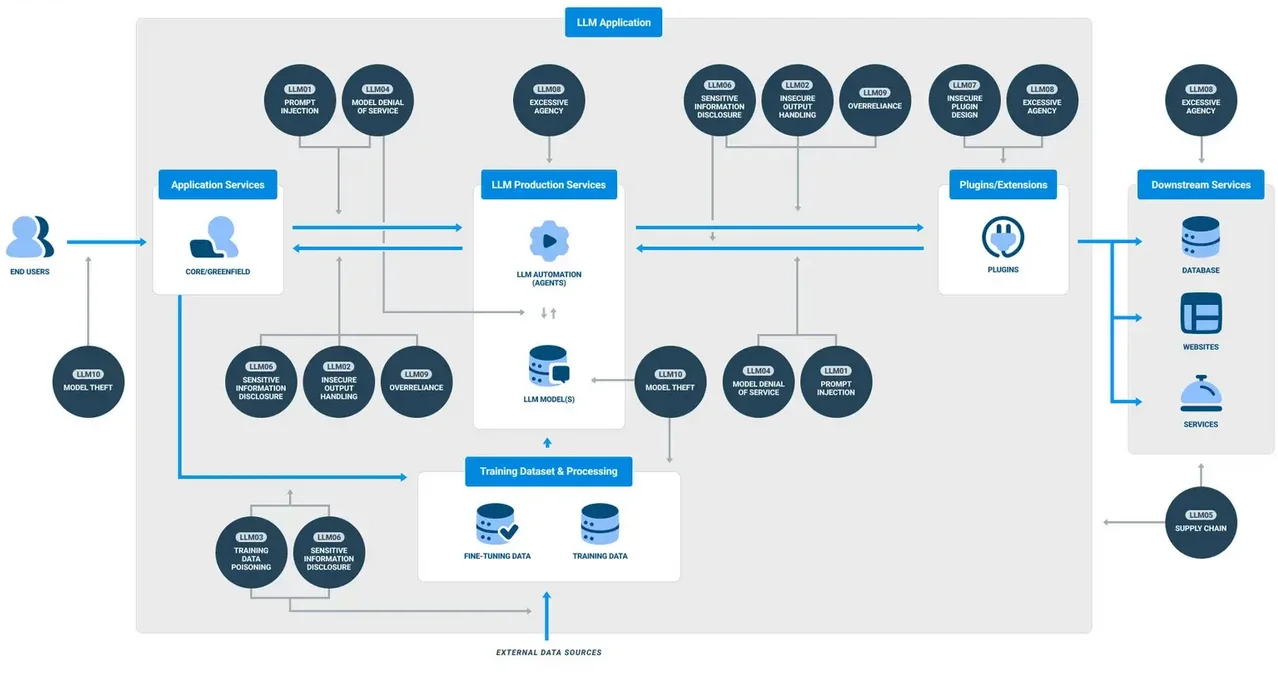

Policy di Sicurezza Su Misura per l’AI

Le regole statiche di allow/deny non sono sufficienti nel contesto della GenAI. Le policy devono adattarsi in base al comportamento dell’utente, all’intento del prompt e alla sensibilità dell’output. Ad esempio, l’analisi dei pattern può rilevare tentativi maligni di iniezione di prompt, mentre limiti basati sul tempo possono restringere l’accesso a certi dati durante le ore non lavorative.

Sistemi come la protezione contro le iniezioni SQL devono evolversi per analizzare non solo SQL, ma anche i prompt in linguaggio naturale che generano attività sui database. Ricerche condotte da Stanford evidenziano come sottili variazioni nei prompt possano bypassare i filtri tradizionali ed estrarre dati privilegiati.

Allineare la GenAI agli Standard di Conformità dei Dati

I sistemi basati su LLM devono comunque rispettare il GDPR, l’HIPAA e il PCI DSS. Ciò include garantire l’auditabilità, onorare i diritti degli utenti alla cancellazione dei dati e prevenire l’esposizione non autorizzata dei dati oltre confine.

La conformità negli ambienti GenAI significa implementare politiche di conservazione dei dati che limitino l’archiviazione della cronologia dei prompt, far rispettare le restrizioni di accesso attraverso un controllo basato sui ruoli e applicare il mascheramento ai log degli audit. I compliance manager semplificano la supervisione generando report automatizzati e applicando policy standardizzate. A titolo di riferimento, le indicazioni della CNIL su AI e GDPR forniscono framework utili adattati all’uso dell’AI.

Conclusione: Un Framework di Sicurezza Vivente

Valutare la postura di sicurezza nei contesti AI & LLM non è una checklist una tantum. Si tratta di un ciclo continuo di monitoraggio, mascheramento, audit e allineamento con la conformità. Gli strumenti devono essere interoperabili, in tempo reale e consapevoli dell’AI. La sicurezza deve estendersi oltre l’infrastruttura e includere i prompt dei modelli, gli output e il comportamento degli utenti stessi.

Le organizzazioni che adottano la GenAI devono costruire un framework di sicurezza vivente, che si adatti man mano che il modello evolve, apprende e interagisce con un ambiente sempre più dinamico.