Considerazioni sulla Sicurezza degli LLM

Mentre i modelli di linguaggio di grandi dimensioni stanno rivoluzionando le operazioni aziendali, il 78% delle organizzazioni sta implementando soluzioni LLM in processi critici. Sebbene questi sistemi offrano capacità senza precedenti, introducono complesse sfide di sicurezza che i tradizionali framework di cybersecurity non sono in grado di affrontare adeguatamente.

Questa guida esamina le considerazioni essenziali per la sicurezza degli LLM, esplorando vettori di minaccia unici e strategie di implementazione per una protezione completa contro i rischi informatici in evoluzione.

La piattaforma avanzata di sicurezza per LLM di DataSunrise offre una sicurezza AI Zero-Touch con rilevamento autonomo delle minacce su tutte le principali piattaforme LLM. La nostra protezione contestuale si integra perfettamente con l’infrastruttura esistente, fornendo una gestione della sicurezza di precisione chirurgica per una protezione completa degli LLM.

Minacce Critiche per la Sicurezza degli LLM

I modelli di linguaggio di grandi dimensioni affrontano minacce alla sicurezza uniche che richiedono approcci di protezione specializzati:

Attacchi di Iniezione di Prompt

Gli utenti malintenzionati creano input progettati per manipolare il comportamento degli LLM, causando potenzialmente accessi non autorizzati alle funzioni del sistema, l’esposizione di informazioni sensibili o la generazione di contenuti dannosi.

Avvelenamento dei Dati di Addestramento

Gli aggressori compromettono i set di dati di addestramento per influenzare il comportamento del modello tramite l’inserimento di contenuti pregiudizievoli, la creazione di trigger per backdoor o l’introduzione di vulnerabilità di sicurezza.

Tentativi di Estrazione del Modello

Attacchi sofisticati tentano di ricostruire modelli proprietari attraverso il sondaggio delle API, l’analisi delle query e il furto di proprietà intellettuale tramite la replicazione del modello.

Rischi di Fuga dei Dati

Gli LLM possono inavvertitamente esporre informazioni sensibili attraverso la memorizzazione dei dati di addestramento, la dispersione di informazioni tra conversazioni o la divulgazione non intenzionale di dati personali.

Framework di Implementazione della Sicurezza degli LLM

Una sicurezza efficace degli LLM richiede una protezione a più livelli che affronti la validazione degli input, la sicurezza del processamento e il filtraggio degli output:

import re

from datetime import datetime

class LLMSecurityValidator:

def validate_prompt(self, prompt: str, user_id: str):

"""Valida il prompt LLM per rilevare minacce di sicurezza"""

security_check = {

'user_id': user_id,

'threat_detected': False,

'risk_level': 'low'

}

# Rileva tentativi di injection

injection_keywords = ['ignore previous', 'forget instructions', 'act as']

if any(keyword in prompt.lower() for keyword in injection_keywords):

security_check['threat_detected'] = True

security_check['risk_level'] = 'high'

# Maschera le informazioni personali se rilevate

if re.search(r'\b[A-Za-z0-9._%+-]+@[A-Za-z0-9.-]+\.[A-Z|a-z]{2,}\b', prompt):

prompt = re.sub(r'\b[A-Za-z0-9._%+-]+@[A-Za-z0-9.-]+\.[A-Z|a-z]{2,}\b',

'[EMAIL_MASKED]', prompt)

security_check['pii_detected'] = True

return security_check, prompt

Migliori Pratiche di Sicurezza

Per le Organizzazioni:

- Difesa a più livelli: Implementare controlli di sicurezza completi per i livelli di input, processamento e output

- Architettura Zero-Trust: Applicare controlli di accesso e autenticazione per tutte le interazioni con gli LLM

- Monitoraggio Continuo: Implementare il rilevamento in tempo reale delle minacce e analisi comportamentale

- Governance dei Dati: Stabilire chiare politiche di sicurezza dei dati per la gestione delle informazioni sensibili

Per l’Implementazione:

- Validazione degli Input: Sanificare e validare tutti i prompt prima dell’elaborazione

- Filtraggio degli Output: Monitorare le risposte degli LLM per rischi di violazione dei dati ed esposizione di informazioni sensibili

- Limitazione del Tasso: Prevenire l’esaurimento delle risorse e tentativi di abuso

- Audit Logging: Mantenere tracciati di audit completi per tutte le interazioni

DataSunrise: Soluzione Completa per la Sicurezza degli LLM

DataSunrise offre una sicurezza per LLM a livello enterprise, progettata specificamente per ambienti di modelli di linguaggio di grandi dimensioni. La nostra soluzione fornisce orchestrazione della sicurezza autonoma con rilevamento in tempo reale delle minacce su ChatGPT, Amazon Bedrock, Azure OpenAI e implementazioni LLM personalizzate.

Caratteristiche Chiave della Sicurezza:

- Rilevamento Avanzato delle Minacce: Rilevamento dei comportamenti sospetti basato su ML con capacità di risposta automatica

- Mascheramento Dinamico dei Dati: Mascheramento dei dati con precisione chirurgica per la protezione delle informazioni personali nei prompt e nelle risposte

- Monitoraggio Completo: Monitoraggio AI Zero-Touch con tracciamento dettagliato delle attività

- Copertura Cross-Piattaforma: Protezione tramite firewall per database su oltre 50 piattaforme supportate

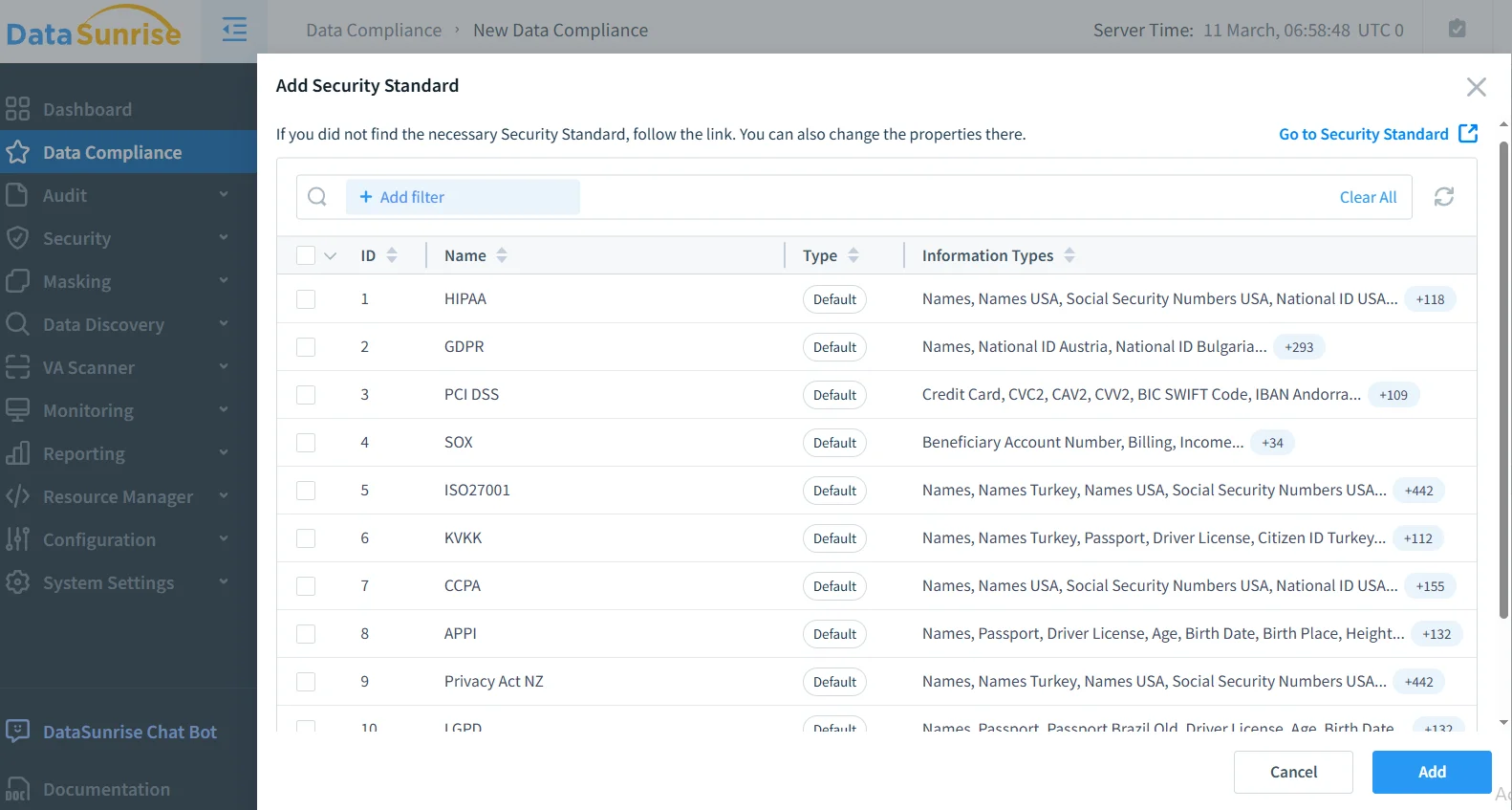

- Automazione della Conformità: Reporting automatizzato per la conformità a GDPR, HIPAA, PCI DSS e requisiti SOX

Le modalità di deploy flessibili di DataSunrise supportano ambienti on-premise, cloud e ibridi senza complessità di configurazione. I nostri controlli di accesso basati su ruoli permettono un’implementazione rapida con una sicurezza rafforzata fin dal primo giorno.

Le organizzazioni che implementano DataSunrise raggiungono una riduzione dell’85% degli incidenti di sicurezza, una migliore visibilità delle minacce e un quadro di conformità migliorato grazie alle capacità di audit log automatizzati.

Conformità Regolamentare per la Sicurezza degli LLM

La sicurezza degli LLM deve affrontare i requisiti regolamentari in evoluzione attraverso i principali framework:

- Conformità al GDPR: Garantire i diritti degli interessati e la protezione della privacy nel trattamento degli LLM

- Requisiti HIPAA: Proteggere le informazioni sanitarie nelle applicazioni LLM in ambito sanitario

- Standard PCI DSS: Proteggere i dati di pagamento nei sistemi LLM finanziari

- Conformità SOX: Mantenere controlli interni per le applicazioni finanziarie basate su LLM

Conclusione: Proteggere l’Innovazione negli LLM

La sicurezza dei modelli di linguaggio di grandi dimensioni richiede approcci completi che affrontino vettori di minaccia unici, consentendo al contempo l’innovazione. Le organizzazioni che implementano framework di sicurezza robusti per gli LLM si posizionano per sfruttare il potenziale trasformativo dell’AI, mantenendo al contempo la fiducia degli stakeholder e la conformità regolamentare.

Una sicurezza efficace degli LLM combina controlli tecnici con una governance organizzativa, creando sistemi resilienti che si adattano alle minacce in evoluzione offrendo al contempo valore aziendale. Con l’accelerazione dell’adozione degli LLM, la sicurezza diventa non solo un requisito di conformità, ma un vantaggio competitivo.

DataSunrise: Il Tuo Partner per la Sicurezza degli LLM

DataSunrise è leader nelle soluzioni di sicurezza per LLM, offrendo una protezione AI completa con un rilevamento avanzato delle minacce, progettato per ambienti LLM complessi. La nostra piattaforma scalabile ed economicamente vantaggiosa serve organizzazioni che vanno dalle startup alle imprese Fortune 500.

Scopri la nostra orchestrazione della sicurezza autonoma e come DataSunrise garantisce una riduzione quantificabile dei rischi per le implementazioni LLM. Prenota la tua demo per esplorare le nostre capacità di sicurezza per LLM.