Checklist di Sicurezza e Governance per LLM GenAI

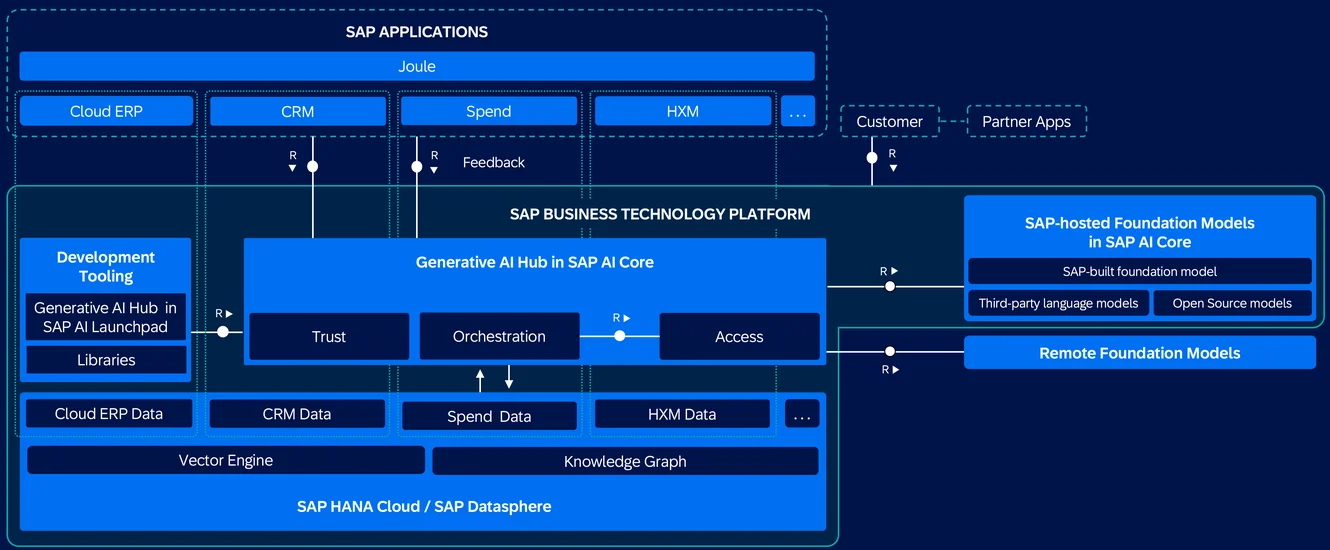

L’intelligenza artificiale generativa (GenAI), in particolare i modelli alimentati da modelli linguistici di grandi dimensioni (LLMs), introduce una nuova frontiera di innovazione—e rischio. Questi modelli raccolgono, generano ed elaborano dati su larga scala, attingendo spesso a fonti diverse e sensibili. Con un grande potere deriva l’urgenza di una sicurezza e una governance solide.

Questa checklist illustra come mettere in sicurezza i pipeline GenAI attraverso controlli a più livelli: visibilità, protezione, responsabilità e automazione.

Monitoraggio in Tempo Reale per i Carichi di Lavoro LLM

I LLM potrebbero non assomigliare ai database tradizionali, ma il loro comportamento deve essere registrato con la stessa accuratezza. Catturare ogni interazione—dai prompt alle risposte generate—permette di monitorare l’esposizione di dati sensibili, rilevare abusi e soddisfare gli auditor di conformità. Strumenti come Monitoraggio dell’Attività del Database forniscono questa visibilità in tempo reale.

SELECT * FROM pg_stat_activity WHERE datname = 'llm_logs';

Questo esempio PostgreSQL mostra come correlare le sessioni del database con i metadati di utilizzo degli LLM.

Vedi anche: Regole di Apprendimento e Audit per l’ottimizzazione delle politiche di audit.

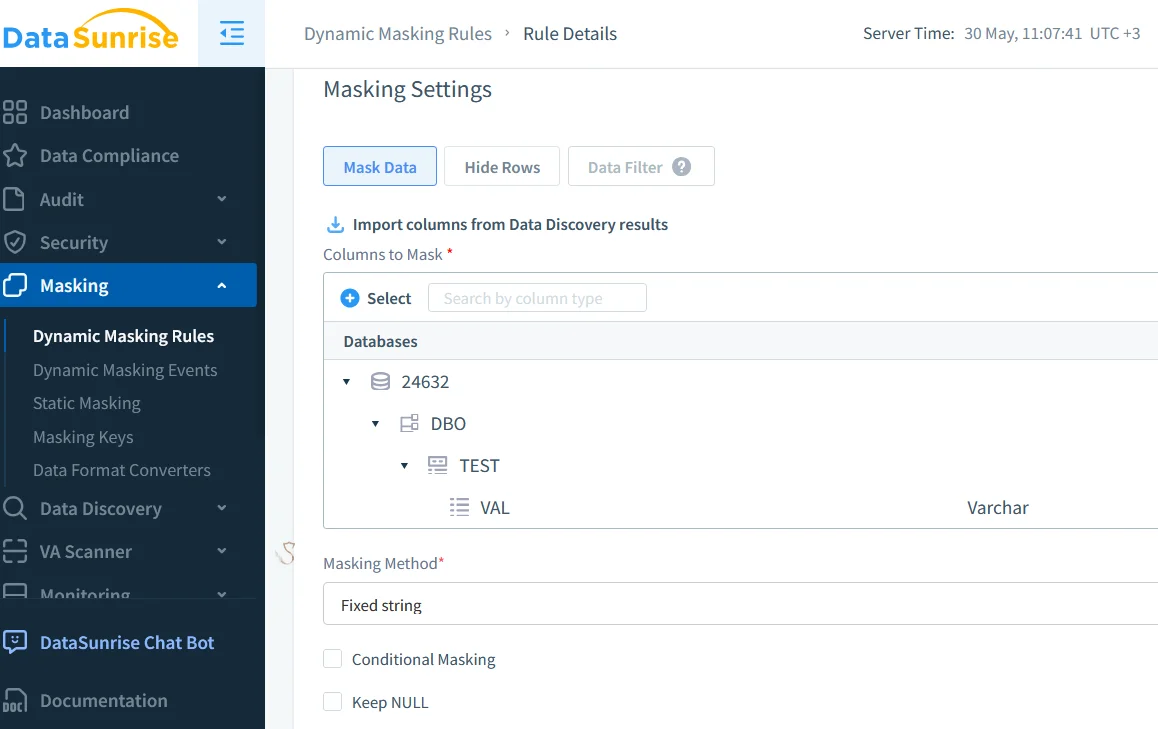

Mascheramento dei Dati in Tempo Reale nei Pipeline GenAI

Dati sensibili come email dei clienti, token o cartelle cliniche non devono trapelare nei prompt, nelle risposte o nei log. Il mascheramento dinamico dei dati agisce in tempo reale, adattandosi in base al ruolo dell’utente o al livello di accesso.

È particolarmente utile in ambienti come strumenti di ingegneria dei prompt, sistemi basati su RAG e API di inferenza condivisa, dove le interazioni degli utenti sono frequenti e i rischi sui dati sono elevati.

Per una visione più approfondita sulla protezione dei campi sensibili, visita l’articolo su Mascheramento in-Place.

Scoperta Automatizzata di Dati Sensibili

Non puoi governare ciò che non riesci a trovare. Le scansioni automatizzate di scoperta dati sono fondamentali per individuare i campi sensibili, specialmente in archivi vettoriali o pipeline multi-modali.

Queste scansioni classificano i prompt di input e i dati degli utenti, etichettano le uscite per l’applicazione delle politiche e supportano esigenze normative come GDPR o HIPAA. Aiutano i team a mantenere il controllo su ciò che il modello apprende e produce.

Consulta Trattare i Dati come un Bene Prezioso per rafforzare la tua strategia di scoperta.

Controllo degli Accessi e Restrizioni a Livello di Prompt

I LLM sono suscettibili ad abusi tramite l’iniezione di prompt o l’escalation dei plugin. Per ridurre questi rischi, implementa il controllo degli accessi basato sui ruoli (RBAC) e il filtraggio degli input. Queste misure prevenire perdite da parte di utenti a bassa fiducia, limitano gli abusi dei prompt rivolti ad azioni amministrative e aiutano a gestire l’accesso tra team e dipartimenti.

Potresti anche voler esplorare Controlli degli Accessi e il Principio del Minimo Privilegio per rafforzare le implementazioni degli LLM.

Gestione della Conformità Semplificata

Le revisioni manuali non possono scalare. Strumenti come Compliance Manager aiutano a definire i mapping normativi, far rispettare le regole di accesso e conservazione e generare report su richiesta.

Per esempio:

CREATE MASKING RULE mask_email

ON llm_prompt_logs(email)

USING FULL;

Questa regola garantisce che i dati email siano mascherati prima di essere analizzati o esportati.

Puoi approfondire l’importanza di questo passaggio in Generazione dei Report.

Risorse da Esplorare

Esplora queste risorse per un ulteriore approfondimento sulla sicurezza dei pipeline LLM:

- NIST – Framework per la Gestione del Rischio AI

- Microsoft – AI Responsabile

- OWASP Top 10 per LLM

- Google – Framework di AI Sicura (SAIF)

- Il Documento su Constitutional AI di Anthropic

Costruisci per Visibilità e Fiducia

Mettere in sicurezza GenAI significa stratificare controlli intelligenti, non bloccare l’innovazione. Il tuo stack di governance dovrebbe includere l’auditabilità in tempo reale, il mascheramento consapevole del ruolo, la scoperta continua e controlli automatici di conformità.

Per approfondire, leggi su Audit Trail, Sicurezza dei Dati, Strumenti LLM e ML per la Sicurezza dei Database e Generazione di Dati Sintetici come alternativa per testare o addestrare in sicurezza i sistemi GenAI.

Successivo