Panoramica delle Minacce della Cybersecurity AI

L’IA generativa (GenAI) sta rivoluzionando la cybersecurity. Questi modelli non si limitano ad analizzare i dati, li creano. Scrivono testi, generano codice e automatizzano decisioni. Ma man mano che acquisiscono nuove capacità, aprono anche nuove superfici di attacco. Dal rischio di divulgare dati sensibili tramite l’output dei modelli, all’essere sfruttati attraverso iniezioni di prompt, GenAI introduce minacce che gli strumenti di sicurezza tradizionali non coprono completamente.

Questo articolo fornisce una panoramica delle minacce della cybersecurity AI e spiega come l’audit in tempo reale, il mascheramento dinamico, la scoperta dei dati e gli strumenti di conformità possano mitigare i rischi associati ai sistemi GenAI.

I Rischi di GenAI Vanno Oltre le Classiche Vulnerabilità di Sicurezza

A differenza delle applicazioni tradizionali, GenAI utilizza il linguaggio naturale e la similarità basata su vettori per restituire contenuti rilevanti. Ciò significa che un modello potrebbe inavvertitamente rivelare informazioni riservate se esposte durante l’addestramento, oppure se un attaccante crea il prompt giusto.

Ad esempio, una query di ricerca interna utilizzando PostgreSQL con pgvector potrebbe essere la seguente:

SELECT * FROM documents

WHERE embedding <#> '[0.1, 0.5, 0.9, ...]'

ORDER BY similarity

LIMIT 1;

Se il vettore rappresenta un concetto sensibile, il risultato potrebbe essere un promemoria interno privato. Senza regole di mascheramento o audit in atto, questo accesso potrebbe passare inosservato.

Un altro esempio: se un chatbot interno utilizza un LLM per generare risposte basate su dati SQL, un prompt studiato potrebbe estrarre più del previsto.

PROMPT: List recent customer transactions above $10,000

-- SQL generated by LLM --

SELECT customer_name, amount, transaction_date

FROM transactions

WHERE amount > 10000;

Se l’accesso non viene limitato o mascherato, questo potrebbe rivelare informazioni finanziarie sensibili (PII).

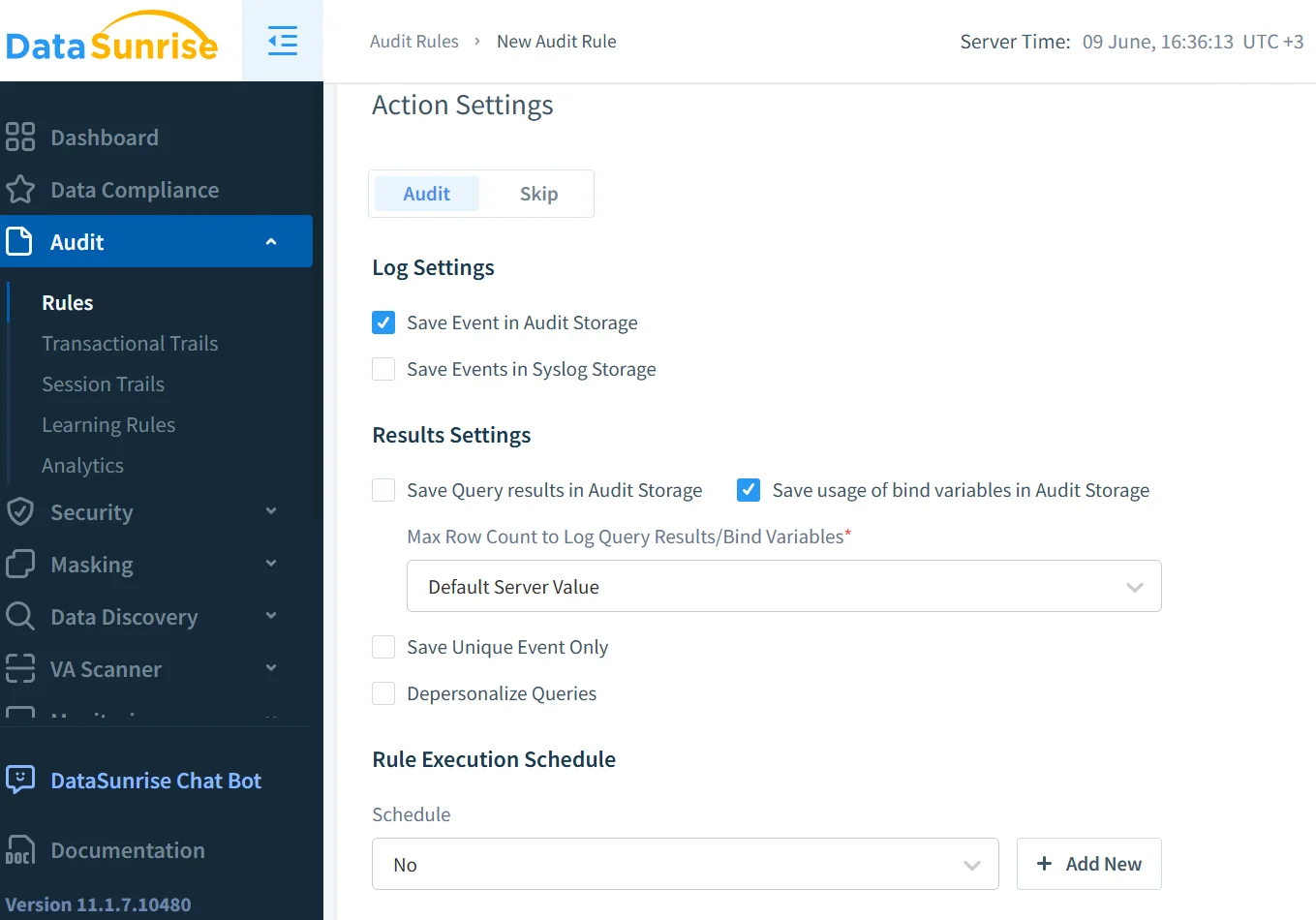

L’Audit in Tempo Reale Aiuta a Rilevare le Minacce Immediatamente

L’analisi in tempo reale è essenziale negli ambienti GenAI. Registra l’accesso e avverte i team di sicurezza quando viene rilevato un comportamento sospetto. Ad esempio, un attaccante potrebbe sondare un modello inviando ripetutamente prompt modificati. Una soluzione di audit in tempo reale come quella descritta nei log di audit di DataSunrise consente ai team di rispondere a tali minacce sul momento.

I dati comportamentali raccolti dall’audit possono anche aiutare a tracciare come e quando le informazioni sensibili sono state accessibili, aggiungendo profondità alle analisi forensi degli incidenti e alla rendicontazione di conformità. Scopri come la Cronologia delle Attività sui Dati offre maggiore visibilità.

Il Mascheramento Garantisce che i Modelli Non Rivelino Ciò che Non Dovrebbero

Anche il miglior log di audit non può impedire l’esposizione, può solo documentarla. Per evitare la divulgazione accidentale, è necessario impedire che contenuti sensibili compaiano nelle risposte del modello. Qui entra in gioco il mascheramento dinamico dei dati.

Il mascheramento dinamico intercetta e redige i campi sensibili al momento della query. Ad esempio, se un utente chiede “Mostrami la cartella clinica di John” e il modello tenta di restituire informazioni personali sulla salute, il mascheramento dinamico garantisce che nomi, ID o campi diagnostici vengano sostituiti o nascosti nella risposta. Questo funziona particolarmente bene quando GenAI è integrato in sistemi di ricerca aziendali o chatbot.

Una configurazione di mascheramento in SQL potrebbe essere la seguente:

CREATE MASKING POLICY mask_sensitive_fields

AS (val STRING)

RETURN CASE

WHEN CURRENT_ROLE IN ('admin') THEN val

ELSE '***MASKED***'

END;

La Scoperta dei Dati Ti Mantiene un Passo Avanti Rispetto ai Rischi Sconosciuti

È difficile proteggere ciò di cui non sei consapevole. I sistemi GenAI possono attingere da dataset ombra, fogli di calcolo obsoleti o condivisioni cloud piene di PII. La scoperta dei dati aiuta a identificare e classificare tali fonti di dati.

Una volta che la scoperta mappa i campi sensibili, le aziende possono assegnare regole di mascheramento, audit e accesso a quei campi. Questo crea un ciclo completo: i dati scoperti diventano dati governati. Inoltre, previene che i modelli GenAI accedano accidentalmente a fonti legacy con controlli deboli.

L’Iniezione di Prompt e l’Abuso Richiedono Nuove Regole di Sicurezza

L’iniezione di prompt è il nuovo SQL injection. Invece di forzare l’accesso a un database, gli attaccanti cercano di influenzare il comportamento del modello alterandone l’input. GenAI può essere manipolato per ignorare le istruzioni, divulgare segreti o eseguire azioni non autorizzate.

Per mitigare questo rischio, implementa regole di sicurezza che monitorano il comportamento degli input e degli output. Limitare la frequenza delle ricerche vettoriali, abbinare modelli di frasi note per abusi, e bloccare l’accesso a tabelle o documenti specifici sono metodi efficaci. Se combinato con controlli di accesso basati sui ruoli, GenAI diventa molto meno sfruttabile.

Un tipico sanitizzatore di risposte potrebbe essere applicato come segue:

if 'SSN' in response:

response = response.replace(user_ssn, '***')

La Conformità non è Facoltativa—È un Requisito di Sistema

GenAI deve operare entro limiti legali ed etici. Che la tua azienda sia soggetta al GDPR, all’HIPAA o allo PCI DSS, le regole di conformità stabiliscono come i dati sensibili debbano essere utilizzati, archiviati e registrati.

Il Compliance Manager automatizza la mappatura tra regolamenti e controlli tecnici. È possibile associare regole di mascheramento ai campi PCI, far rispettare le politiche di audit per i record coperti da HIPAA e generare documentazione che dimostri l’aderenza continua.

La conformità non riguarda solo l’evitare multe; si tratta di costruire fiducia in sistemi AI che agiscono responsabilmente con i dati a loro disposizione.

La Visibilità su Tutto lo Stack è Fondamentale

Per una discussione più ampia su come la sicurezza nei modelli linguistici (LLM) impatti l’infrastruttura, consulta il punto di vista del MIT su Prompt Injection and Foundation Model Risks. I rischi si estendono oltre i casi d’uso aziendali, influenzando modelli open-source, dataset accademici e pratiche di web scraping pubbliche.

Inoltre, l’articolo dello Stanford HAI su Red Teaming Language Models mostra come i ricercatori testino i sistemi AI per fallimenti etici e di sicurezza, offrendo una prospettiva utile per definire le politiche aziendali su GenAI.

Il futuro della cybersecurity AI risiede nella correlazione. L’audit in tempo reale mostra chi ha fatto cosa. Il mascheramento rivela cosa è stato visto. La scoperta dei dati identifica dove essi risiedono. Le regole di sicurezza impediscono abusi. La conformità lega tutto insieme.

Un sistema GenAI diventa sicuro solo quando questi strumenti condividono il contesto. È per questo che la sicurezza ispirata ai dati — in cui le decisioni di sicurezza riflettono la classificazione dei dati, il ruolo aziendale e i modelli di utilizzo — è il futuro.

Con questo modello, innovazione e conformità possono coesistere, permettendo a GenAI di operare senza compromettere l’integrità dei dati con cui interagisce.