Rischi di Sicurezza nei Carichi di Lavoro di AI Generativa

I carichi di lavoro dell’AI generativa (GenAI) hanno ridefinito il modo in cui le imprese interagiscono con i dati. Dalla creazione di contenuti al processo decisionale automatizzato, questi modelli generano un enorme valore, ma introducono anche rischi di sicurezza unici. Con l’adozione crescente della GenAI in diversi settori, comprendere come proteggere questi carichi di lavoro diventa essenziale. Per una panoramica sulle minacce emergenti nella GenAI, consulta il Generative AI Security Framework di MITRE.

Perché i Carichi di Lavoro GenAI Sono Ad Alto Rischio per Natura

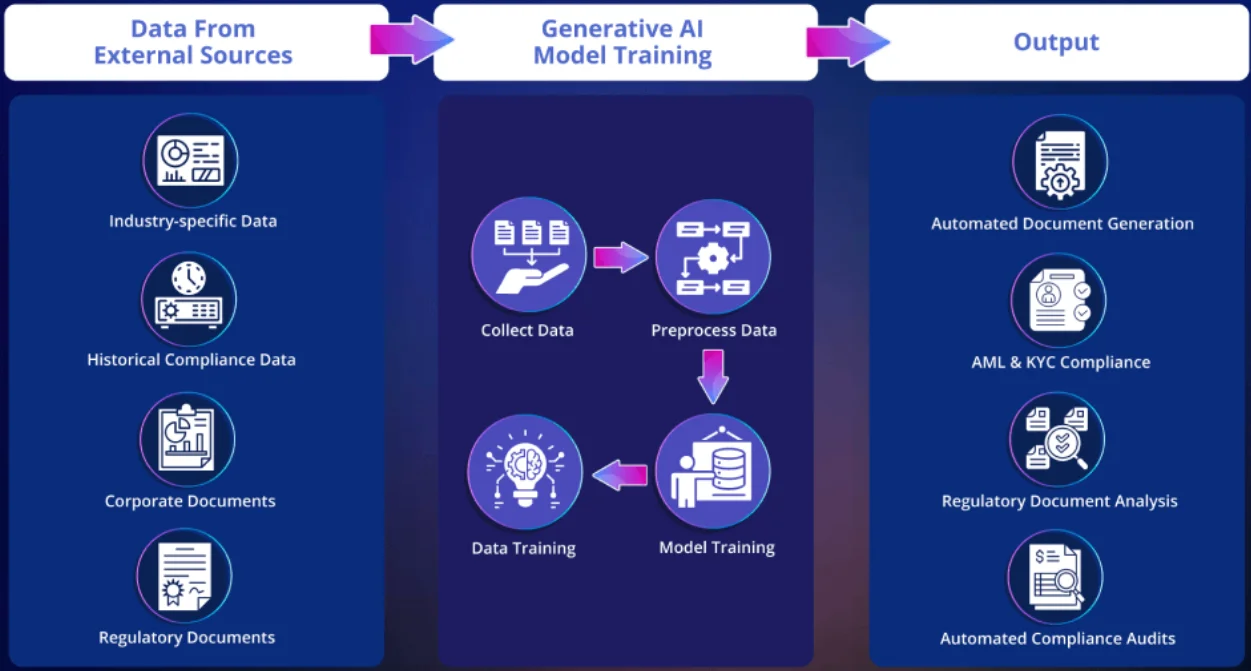

A differenza dei modelli AI tradizionali che operano su input statici, i modelli GenAI interagiscono con dati dinamici, spesso sensibili. Questi modelli possono memorizzare i dati di addestramento, rispondere a prompt in linguaggio naturale e generare output sintetici che potrebbero inavvertitamente esporre informazioni regolamentate o proprietarie.

Gli rischi intrinseci includono:

| Categoria di Rischio | Descrizione |

|---|---|

| Fuga di Dati Sensibili | I modelli GenAI possono memorizzare e riprodurre dati di addestramento riservati. |

| Esposizione di Informazioni Personali Identificabili | Le informazioni personali identificabili potrebbero emergere negli output del modello. |

| Iniezione di Prompt | Utenti malintenzionati potrebbero creare prompt per aggirare le istruzioni di sicurezza del modello. |

| Sfruttamento tramite l’Output del Modello | Gli aggressori possono ingannare il modello inducendolo a rivelare dati interni o protetti. |

Questi vettori richiedono misure di sicurezza avanzate che vadano oltre la protezione standard delle API. La complessità aumenta ulteriormente quando grandi modelli linguistici (LLM) vengono implementati su interfacce rivolte ai clienti o collegati a sistemi interni con accesso ai dati in tempo reale.

Audit in Tempo Reale per le Interazioni con il Modello

Per rilevare usi impropri o anomalie nelle interazioni con la GenAI, è fondamentale eseguire un audit in tempo reale. I registri tradizionali possono catturare il “cosa”, ma i sistemi di audit in tempo reale catturano il “perché” e il “come” dietro la richiesta. Vedi anche le linee guida di Google Cloud su come proteggere i carichi di lavoro di AI con il log di audit.

Esempio: Supponiamo che un utente invii un prompt come:

SELECT user_id, endpoint, timestamp

FROM api_logs

WHERE endpoint LIKE '%admin%' AND response_code = 200;

In un assistente alimentato da GenAI collegato al tuo database, questo potrebbe esporre comportamenti operativi a meno che non siano in atto sistemi di log e regole di allarme.

Piattaforme come DataSunrise Audit Logs offrono notifiche in tempo reale e approfondimenti dettagliati sul comportamento degli utenti che consentono ai team di sicurezza di tracciare i pattern di accesso e rilevare anomalie prima che si verifichino danni.

Mascheramento Dinamico: Barriere di Sicurezza nelle Interazioni in Tempo Reale

Il mascheramento dinamico è fondamentale quando gli strumenti GenAI generano risposte basate su dati in tempo reale. Intercettando query e risposte, è possibile redigere o oscurare i campi sensibili prima che raggiungano il modello o l’utente finale.

-- Valore originale: 1234-5678-9012-3456

-- Output mascherato: XXXX-XXXX-XXXX-3456

Questo non solo soddisfa i requisiti di privacy, ma impedisce anche all’AI di “imparare” pattern legati a identità sensibili.

Scopri di più sul mascheramento dinamico dei dati e sul suo ruolo nella protezione dei dati per i carichi di lavoro di GenAI.

Scoperta dei Dati Prima della Distribuzione

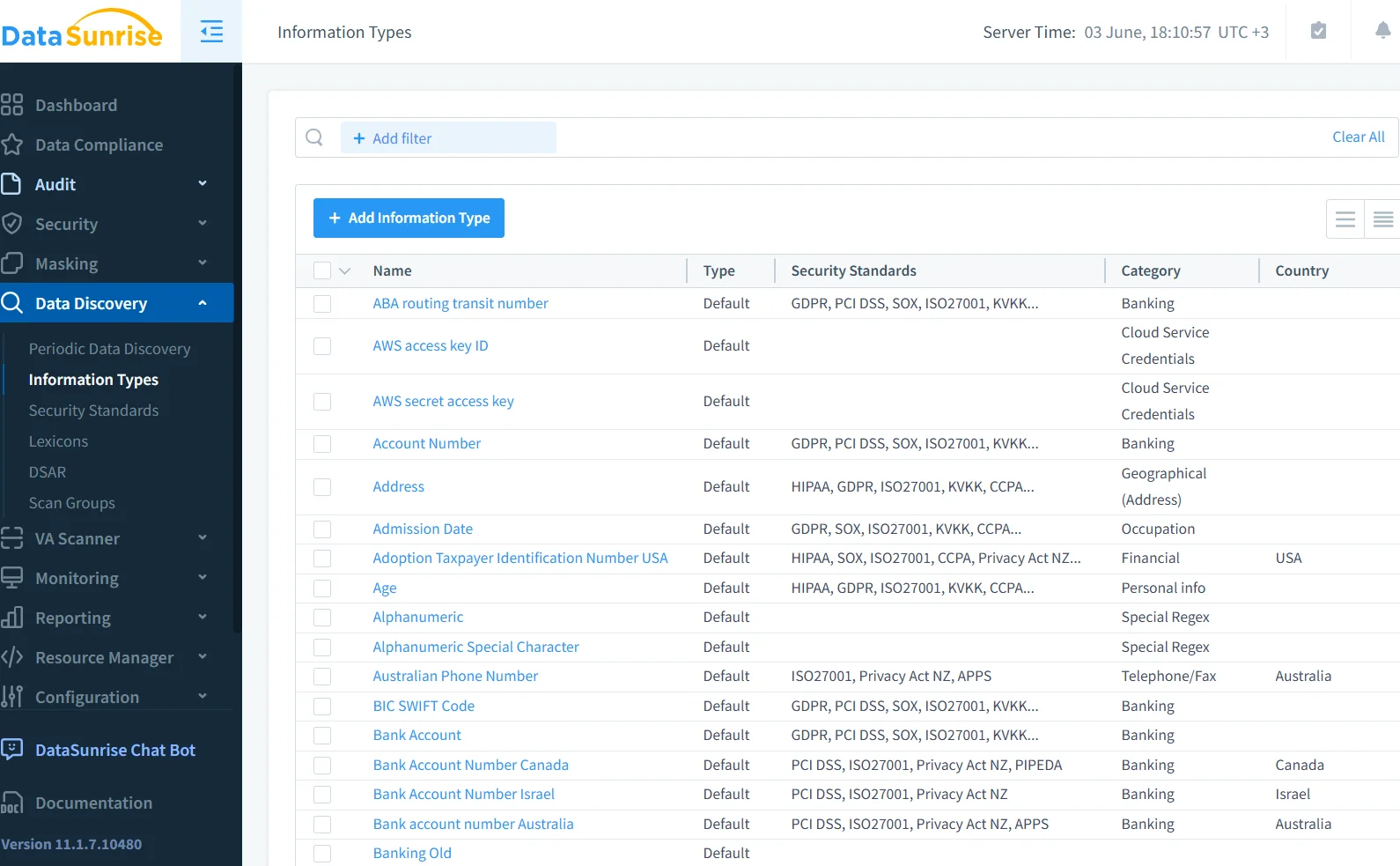

I modelli GenAI vengono spesso addestrati su grandi dataset federati. Senza conoscere il loro contenuto, si naviga alla cieca. Utilizzando strumenti di scoperta dati, i team di sicurezza possono analizzare database, data lake e sistemi di archiviazione per classificare i dati regolamentati prima che vengano esposti agli LLM. Ciò è cruciale quando si addestrano modelli GenAI personalizzati su documenti aziendali o storici dei clienti. Per un contesto, IBM offre una guida su classificazione e scoperta dati automatizzata per l’AI.

-- Regola di esempio nel motore di scoperta

IF column_name LIKE '%ssn%' OR column_name LIKE '%dob%' THEN classify AS 'PII'

Questi metadati permettono l’applicazione di mascheramento basato su policy e allarmi in tempo reale quando le interazioni con la GenAI accedono a tipi di dati segnalati.

Conformità e Governance: Dove l’AI Incontra la Regolamentazione

La sicurezza per la GenAI non riguarda solo la prevenzione di exploit tecnici, ma anche il mantenimento della conformità con framework come GDPR, HIPAA e PCI DSS. Questi framework richiedono:

- Minimizzazione dei dati

- Registrazione degli accessi

- Consenso dell’utente per il trattamento

La mancata implementazione dei controlli può comportare responsabilità legali, soprattutto quando gli output generati dall’AI riproducono dati protetti.

I controlli di accesso basati sui ruoli (RBAC) e i trail di audit aiutano a documentare gli sforzi di conformità e a dimostrare l’intento in caso di indagini.

Iniezione di Codice e Manipolazione dei Prompt

L’iniezione di prompt è un vettore di minaccia in crescita nei sistemi GenAI. Gli aggressori potrebbero inserire istruzioni dannose all’interno di prompt apparentemente benigni, inducendo il modello a divulgare dati sensibili o a superare le salvaguardie predefinite. La OWASP Foundation ha pubblicato una lista Top 10 per i rischi nelle applicazioni LLM che include vettori di iniezione di prompt.

Combinare insiemi di regole di audit con pipeline di sanificazione dei prompt è un modo efficace per mitigare questi attacchi.

Un Esempio Pratico: Utilizzo di Audit SQL e Mascheramento in Sistemi Alimentati da LLM

Se questo passa attraverso un modulo di generazione SQL, il backend potrebbe generare una query come:

-- Audita i saldi in ritardo

SELECT customer_name, balance_due FROM billing WHERE status = 'overdue';

Senza mascheramento, i campi finanziari potrebbero essere mostrati in chiaro. Con le politiche di mascheramento, gli importi sensibili vengono parzialmente oscurati.

Per tracciare chi ha avuto accesso a cosa e quando, il Database Activity Monitoring registra l’interazione, collegandola a una sessione utente o a una API key.

Spostare a Sinistra: Progettare la GenAI in Sicurezza

Molte lacune di sicurezza nei carichi di lavoro della GenAI emergono perché i team si concentrano sulle prestazioni del modello, non sul design del sistema. Spostare a sinistra — applicare i controlli di sicurezza fin dalle prime fasi del ciclo di vita — può aiutare a integrare la governance in ogni componente:

- Acquisizione dei dati: scansiona ed etichetta gli input sensibili

- Ottimizzazione del modello: limita l’esposizione a corpora sensibili

- Stack di erogazione: applica mascheramento inline e controlli di accesso

- Livello di output: sanifica e audita le risposte del modello

Questo approccio è in linea con le moderne pratiche DevSecOps e con le pratiche di sicurezza ispirata dai dati, migliorando sia la trasparenza che la protezione.

Conclusione: Un Nuovo Paradigma di Sicurezza per l’AI

L’ascesa della GenAI introduce una categoria completamente nuova di rischi che i modelli di sicurezza tradizionali non sono stati progettati per gestire. Ma combinando audit in tempo reale, mascheramento dinamico, scoperta dei dati e governance basata su policy, è possibile costruire sistemi GenAI sicuri e conformi senza sacrificare l’innovazione. Scopri come il NIST affronta la gestione del rischio AI nel loro AI RMF 1.0.

Per un’approfondita analisi su come strumenti come DataSunrise possano aiutare in questa trasformazione, esplora le loro guide sull’audit, il data masking e le capacità di firewall per database.