Linee guida sulla sicurezza OWASP LLM

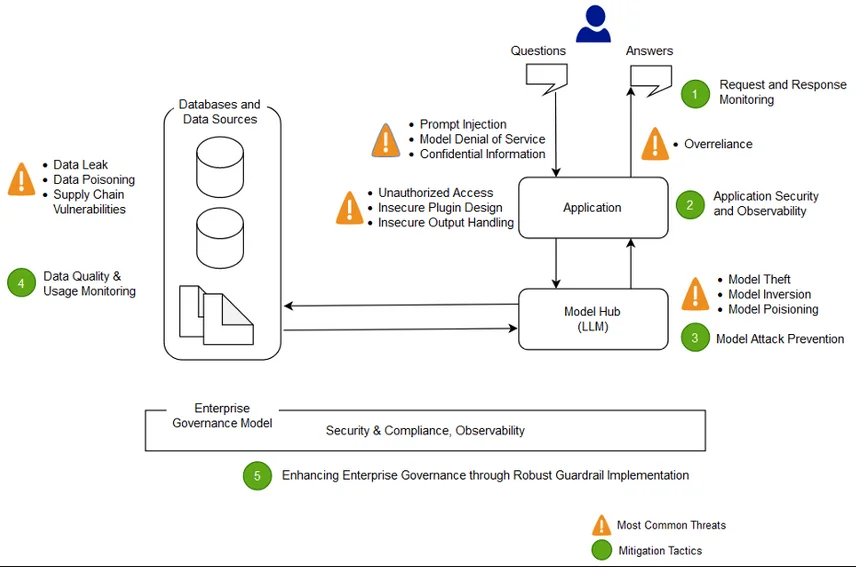

I modelli di linguaggio di grandi dimensioni (LLM) sono sempre più integrati nelle applicazioni e nei flussi di lavoro moderni, alimentando tutto, dai bot per il supporto clienti all’interpretazione dei dati in tempo reale. Ma con grande potere si presentano nuove superfici di attacco. La Top 10 OWASP LLM ha scatenato discussioni globali su come affrontare i rischi di GenAI, e ora i team di sicurezza devono ampliare i loro manuali.

Questo articolo esplora come utilizzare le linee guida sulla sicurezza OWASP LLM per proteggere i sistemi integrati con LLM, ottenendo audit in tempo reale, mascheramento dinamico, scoperta dei dati e conformità normativa.

Comprendere il panorama OWASP LLM

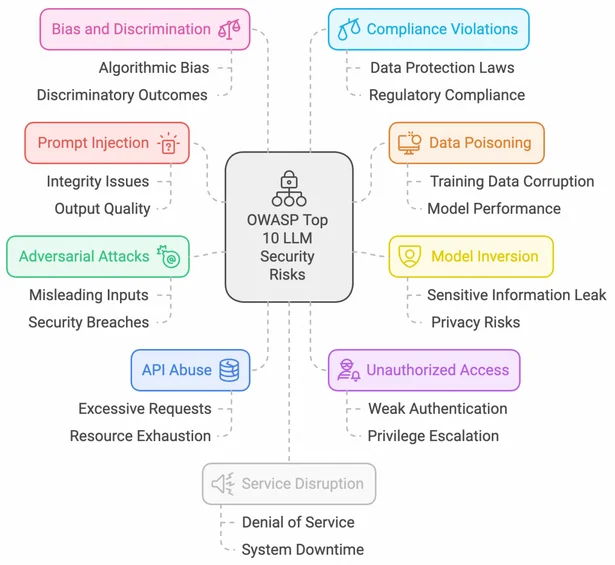

L’iniziativa di OWASP sugli LLM offre un approccio strutturato per identificare e mitigare le vulnerabilità specifiche dei sistemi GenAI. Alcune minacce chiave includono l’iniezione di prompt, il denial-of-service del modello, la fuga di dati sensibili e l’uso insicuro dei plugin.

I team di sicurezza possono fare riferimento alla OWASP Top 10 per le applicazioni LLM per allineare l’adozione di GenAI a un processo di modellazione delle minacce su misura per i flussi di lavoro degli LLM.

Audit in tempo reale: Monitorare il comportamento dell’IA e l’accesso ai dati

Per proteggere i sistemi alimentati da LLM, è fondamentale implementare meccanismi di audit che acquisiscano sia le interazioni degli utenti che i prompt interni emessi dal sistema.

Soluzioni come le regole di audit di DataSunrise e il monitoraggio dell’attività sui database possono offrire un tracciamento continuo delle interazioni degli LLM con fonti di dati strutturati.

Ecco un frammento di codice PostgreSQL per acquisire i modelli di accesso da parte degli agenti LLM:

SELECT datname, usename, query, backend_start, state_change

FROM pg_stat_activity

WHERE application_name LIKE '%llm_agent%';

I log di audit arricchiti con il contesto utente, l’input/output del modello e i metadati dei timestamp aiutano le organizzazioni a prepararsi forensicamente e a rilevare comportamenti anomali.

Mascheramento dinamico dei dati per la sicurezza dei prompt

Quando gli LLM accedono ai dati di produzione, campi sensibili non mascherati possono essere inavvertitamente esposti nell’output. Integrare il mascheramento dinamico direttamente nella pipeline dei dati è fondamentale.

Utilizzando la funzionalità di mascheramento dinamico di DataSunrise, è possibile oscurare o tokenizzare le informazioni personali (PII) prima che vengano inserite nei prompt.

Una regola di mascheramento potrebbe sostituire indirizzi email reali con valori segnaposto come:

REPLACE(email, SUBSTRING(email, 1, POSITION('@' IN email)-1), 'user')

Questo garantisce la conformità al GDPR e all’HIPAA quando si costruiscono soluzioni IA con dati reali.

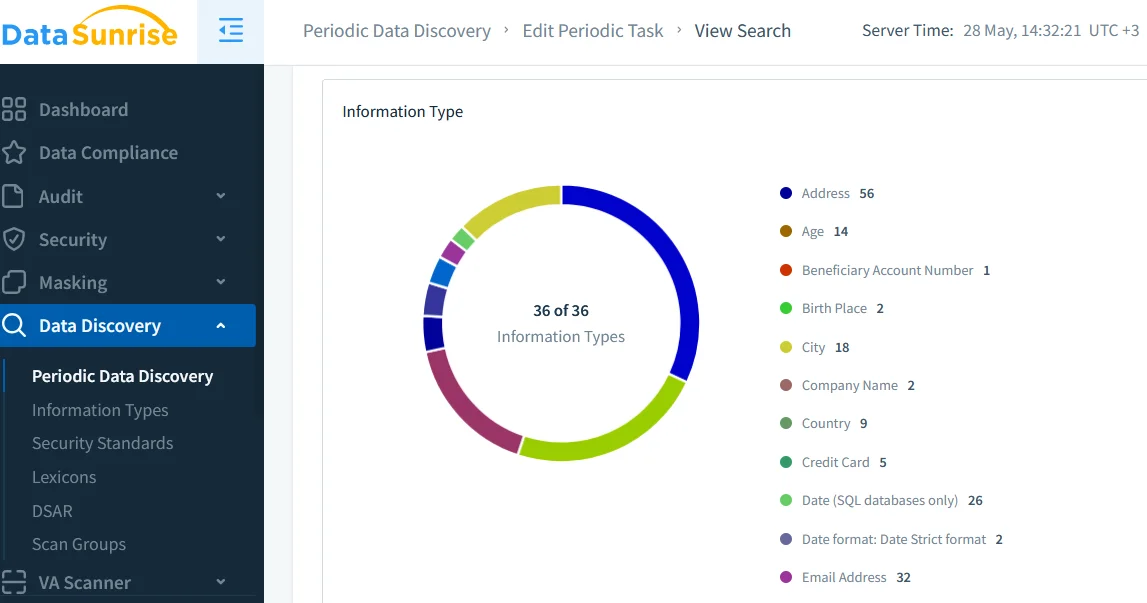

Scoperta dei dati: Costruire fiducia nel tuo corpus di input

Gli LLM possono amplificare i rischi se addestrati o perfezionati su dataset sconosciuti o non classificati. Gli strumenti di scoperta dei dati consentono alle organizzazioni di scansionare, etichettare e catalogare automaticamente i dati sensibili prima che raggiungano uno strato di embedding o retrieval.

Un processo di scoperta robusto aiuta a ridurre le pipeline ombra di IA e si allinea a politiche di sicurezza come i controlli di accesso basati sui ruoli (RBAC).

Soluzioni esterne di governance dei dati, come Open Policy Agent, possono integrarsi con questi risultati per applicare condizioni di accesso dinamiche agli agenti che costruiscono i prompt.

Politiche di sicurezza: Allineare i flussi di lavoro IA con i controlli

Gli LLM non possono essere monitorati come le applicazioni tradizionali — i loro comportamenti sono probabilistici, sensibili al contesto e spesso non deterministici. Pertanto, le organizzazioni devono applicare politiche di sicurezza stratificate che includano:

- Validazione degli input e filtraggio degli output

- Limitazione del rate e monitoraggio dell’uso delle API

- Sandboxing dei plugin o flussi di lavoro di revisione

Consulta la guida alla sicurezza di DataSunrise per costruire un modello di difesa in profondità su misura per le operazioni GenAI.

Per ridurre la deriva della sicurezza indotta dagli LLM, alcuni team dispongono di un firewall leggero o proxy che analizza il contenuto dei prompt e oscura eventuali dati non conformi prima di inviarli al modello. Le regole di sicurezza contro l’iniezione SQL possono essere adattate per prevenire exploit di iniezione di prompt.

Protezioni ispirate a OWASP in sintesi

| Categoria | Controlli Raccomandati | Scopo |

|---|---|---|

| Gestione degli input | Validazione, controlli di lunghezza, filtraggio dei token | Prevenire l’iniezione di prompt e l’abuso |

| Accesso ai dati | Controllo degli accessi basato sui ruoli, audit in tempo reale, mascheramento | Garantire il minor privilegio e la conformità |

| Filtraggio degli output | Filtri Regex, controllo della tossicità, redazione | Limitare l’esposizione di dati dannosi o privati |

| Uso di plugin e strumenti | Lista bianca dei plugin, sandboxing, limitazione del rate | Ridurre la compromissione del modello tramite integrazioni |

| Registrazione per la conformità | Tracce di audit, regole di allerta, classificazione dei dati | Supportare i requisiti di GDPR, HIPAA, PCI DSS |

Conformità: Quando l’IA incontra la regolamentazione

Adottare gli LLM non esonera un’organizzazione dall’obbligo di conformarsi agli standard. Al contrario, regolamenti come SOX, PCI DSS e HIPAA si applicano in modo ancora più stringente quando agenti automatizzati accedono o agiscono su dati sensibili.

Utilizzare un’infrastruttura IA consapevole della conformità che combini log di audit, mascheramento e strumenti per la generazione di report consente alle aziende di documentare le prove per le verifiche e dimostrare l’applicazione delle politiche.

Diverse iniziative open source stanno inoltre emergendo per standardizzare le tracce di audit dell’IA, come PyRIT di Microsoft e gli sforzi dell’UE in merito all’AI Act.

Conclusione: Costruire sistemi LLM sicuri e conformi

Seguire le linee guida sulla sicurezza OWASP LLM non significa limitare l’innovazione — significa garantire fiducia, responsabilità e allineamento con standard di sicurezza di livello enterprise. Combinando audit in tempo reale, mascheramento dinamico e scoperta dei dati, le organizzazioni possono domare la complessità di GenAI e sbloccare il suo pieno potenziale senza esporsi a rischi eccessivi.

Per approfondire, esplora il compliance manager di DataSunrise e le sue approfondite analisi sulla sicurezza per LLM/ML per proteggere database ibridi e alimentati da IA.