pgvector: Proteggere i Dati dall’Esposizione tramite Vector Embeddings

Il Rischio Nascosto dei Vector Embeddings

I vector embeddings alimentano le applicazioni GenAI, consentendo la ricerca semantica, sistemi di raccomandazione e approfondimenti basati su AI. In PostgreSQL, l’estensione pgvector rende possibile memorizzare e interrogare embeddings ad alta dimensione in modo efficiente, migliorando le applicazioni AI con una ricerca di similarità rapida. Ma, nonostante siano semplici numeri post-embedding, possono comunque trapelare dati sensibili.

Possono i Vector Embeddings Effettivamente Esporre Informazioni Sensibili?

I vector embeddings funzionano come coordinate in uno spazio ad alta dimensione — non contengono dati sensibili direttamente, ma possono comunque essere sfruttati per ricostruire schemi. Proteggere le informazioni sensibili significa controllare cosa viene inserito negli embeddings e monitorare come vengono interrogati.

Se gli embeddings vengono generati da testo grezzo contenente informazioni personali identificabili (PII) come nomi, SSN o indirizzi, il modello potrebbe codificare schemi che rivelano indirettamente tali informazioni. Gli aggressori possono sfruttare nearest-neighbor searches per ricostruire dati sensibili, portando a violazioni della conformità e a minacce alla sicurezza.

Quindi, i vector embeddings possono effettivamente esporre informazioni sensibili? Sì — i dati sensibili possono essere esposti tramite gli embeddings in determinate circostanze. E, sebbene gli embeddings non memorizzino dati grezzi, il modo in cui codificano le relazioni tra i punti dati significa che le informazioni sensibili potrebbero essere dedotte se interrogate in modo ingegnoso. A seconda di come vengono generati gli embeddings e quali informazioni vengono utilizzate per crearli, ecco come può accadere:

🔍 Come i Dati Sensibili Possono Essere esposti in Embeddings

1. Codifica Diretta

- Se gli embeddings sono creati da testo grezzo contenente informazioni sensibili (ad es. SSN, nomi o indirizzi), il modello potrebbe codificare schemi che li rivelano indirettamente.

➡️Esempio: Se SSN: 123-45-6789 fa parte del profilo di un dipendente utilizzato per la generazione degli embeddings, il modello potrebbe generare embeddings che, se interrogati in modi specifici, potrebbero restituire vettori che somigliano o correlano a schemi di dati sensibili.

2. Correlazione Implicita dei Dati

- Se gli embeddings sono addestrati su dati strutturati (ad es. ruoli, salari e reparti dei dipendenti), gli schemi in tali dati potrebbero correlarsi con il PII.

➡️Esempio: Se l’SSN di un dipendente viene utilizzato nell’addestramento dei vettori insieme al salario e al reparto, un sistema AI potrebbe rivelare dettagli sul salario durante la ricerca di embeddings simili.

3. Memorizzazione da parte dei Modelli AI

- Se un modello AI addestrato su dati sensibili genera embeddings, potrebbe memorizzare e ripetere dettagli specifici quando sollecitato in modo ingegnoso.

➡️Esempio: Se gli embeddings memorizzano nomi e ruoli dei dipendenti, un modello potrebbe restituire vettori simili contenenti informazioni personali quando viene chiesto, ad esempio, degli “impiegati nel settore finanziario che guadagnano oltre $100K”.

4. Rischi di Ricostruzione

- In alcuni casi, gli embeddings possono essere decomposti mediante attacchi adversarial, ricostruendo parti dei dati originali.

➡️Esempio: Se un aggressore interroga il sistema con schemi di input specifici, potrebbe estrarre dati significativi dagli embeddings.

🔓 Come i Dati Sensibili Possono Essere esposti da Embeddings

Gli aggressori o interrogazioni involontarie possono esporre PII tramite:

- Nearest-Neighbor Searches – Trovare gli embeddings più vicini a schemi di dati sensibili.

- Vector Clustering – Raggruppare embeddings simili per dedurre dettagli personali correlati.

- Prompt Injection – Indurre il sistema a rivelare contenuti sensibili memorizzati.

- Adversarial Attacks – Sfruttare le debolezze del modello per ricostruire l’input originale.

Sintesi

Sì, i dati sensibili possono trapelare negli embeddings se generati senza adeguate salvaguardie. Pur non memorizzando dati grezzi, il modo in cui gli embeddings codificano le relazioni tra i dati significa che, se interrogati in modo ingegnoso, potrebbero restituire informazioni simili.

Buona prassi: Non incorporare mai campi sensibili grezzi e sanitizzare sempre i dati prima della vectorizzazione.

Tecniche per Prevenire la Perdita di PII dagli Vector Embeddings

1. Sanitizzazione dei Dati Prima della Generazione degli Embeddings

Prima di convertire i dati in vector embeddings, rimuova o trasformi le informazioni sensibili in modo che non entrino mai nello spazio vettoriale.

Rimuovere i Campi PII – Eviti di incorporare dati grezzi come SSN, nomi e indirizzi.

Generalizzare i Dati – Al posto di memorizzare salari esatti, li classifichi in fasce.

Tokenizzazione – Sostituisca i dati sensibili con identificatori non reversibili.

Esempio: Invece di incorporare:

“John Doe, SSN: 123-45-6789, guadagna $120,000”

Memorizzare: “Employee X, guadagna $100K-$150K”

Questo assicura che il PII non entri mai nel vector store in primo luogo.

2. Mascheramento dei Dati Sensibili nelle Interrogazioni e Risposte

Anche se il PII grezzo è stato incorporato o se gli embeddings codificano schemi correlati al PII, è possibile mascherare o offuscare i dati sensibili durante il recupero.

Mascheramento Dinamico dei Dati – Rediga o trasformi l’output sensibile prima che raggiunga gli utenti.

Real-time Query Filtering – Blocchi le ricerche di similarità non autorizzate sugli embeddings.

Access Control & Role-Based Restrictions – Limiti l’accesso alla ricerca dei vettori a utenti fidati.

Esempio: Se un utente interroga gli embeddings e recupera un frammento di dati contenente PII:

Output originale: “Il salario di John Doe è $120,000”

Output mascherato: “Il salario di Employee X è $1XX,000”

Questo previene l’esposizione involontaria di informazioni sensibili.

Approcci Proattivi vs. Reattivi alla Sicurezza dei Dati per Vector Embeddings

1️⃣ Sicurezza Proattiva – Applicare la Protezione PII Prima dell’Embedding

Questo approccio garantisce che i dati sensibili non entrino mai negli embeddings fin dall’inizio.

Come?

Sanitizzi i dati strutturati prima della vectorizzazione. ✅

Mascheri le informazioni sensibili prima dell’embedding. ✅

Utilizzi la tokenizzazione per sostituire i valori identificabili. ✅

Applichi tecniche di differential privacy per introdurre rumore. ✅

Vantaggio: Questo approccio elimina i rischi alla fonte, rendendo impossibile che le interrogazioni sugli embeddings rivelino PII.

2️⃣ Sicurezza Reattiva – Audit e Mascheramento Post-Embedding

Questo approccio presuppone che gli embeddings contengano già riferimenti a informazioni sensibili e si concentra su rilevare e mascherare PII durante il recupero.

Come?

Individui le informazioni sensibili utilizzate nella creazione degli embeddings. ✅

Applichi il mascheramento in tempo reale prima di visualizzare i dati recuperati. ✅

Limiti le interrogazioni non autorizzate all’accesso degli embeddings sensibili. ✅

Monitori le ricerche di similarità dei vettori per rilevare schemi di accesso anomali. ✅

Vantaggio: Anche se le informazioni sensibili esistono già negli embeddings, questo metodo garantisce che non vengano mai esposte durante il recupero.

🎯 La Migliore Strategia di Sicurezza? – Usare ENTRAMBI

La sicurezza più solida deriva dalla combinazione di entrambi i metodi:

- La sanitizzazione proattiva previene l’incorporamento di dati sensibili.

- Il monitoraggio reattivo garantisce che gli embeddings esistenti non trapelino PII.

Come DataSunrise Protegge i Dati Dietro gli Vector Embedding

DataSunrise offre una soluzione di sicurezza completa per proteggere i dati referenziati dagli embeddings di pgvector prima e dopo che vengano creati.

🛡️ Protezione Proattiva: Proteggere i Dati di Origine Prima dell’Embedding

Per le organizzazioni che gestiscono grandi quantità di dati strutturati e non strutturati, DataSunrise aiuta tramite:

- Rilevamento del PII prima che diventi parte di un embedding.

- Mascheramento dei dati sensibili prima della vectorizzazione.

- Utilizzo di tecniche di anonimizzazione dei dati per eliminare dettagli personali specifici.

Esempio: Prima di incorporare i profili dei clienti, DataSunrise può scansionare l’archiviazione dei dati alla ricerca di dati sensibili, rimuovere gli SSN, anonimizzare gli indirizzi e generalizzare i dati finanziari, assicurando che la rappresentazione vettoriale non contenga dettagli privati.

🛡️ Protezione Reattiva: Proteggere i Dati di Origine con Embeddings Esistenti e Applicazioni AI

Se un’applicazione AI è già in esecuzione con embeddings contenenti riferimenti a dati sensibili, DataSunrise offre:

- Scoperta dei dati sensibili per i dati utilizzati nella creazione degli embeddings.

- Mascheramento dinamico dei risultati delle interrogazioni sensibili.

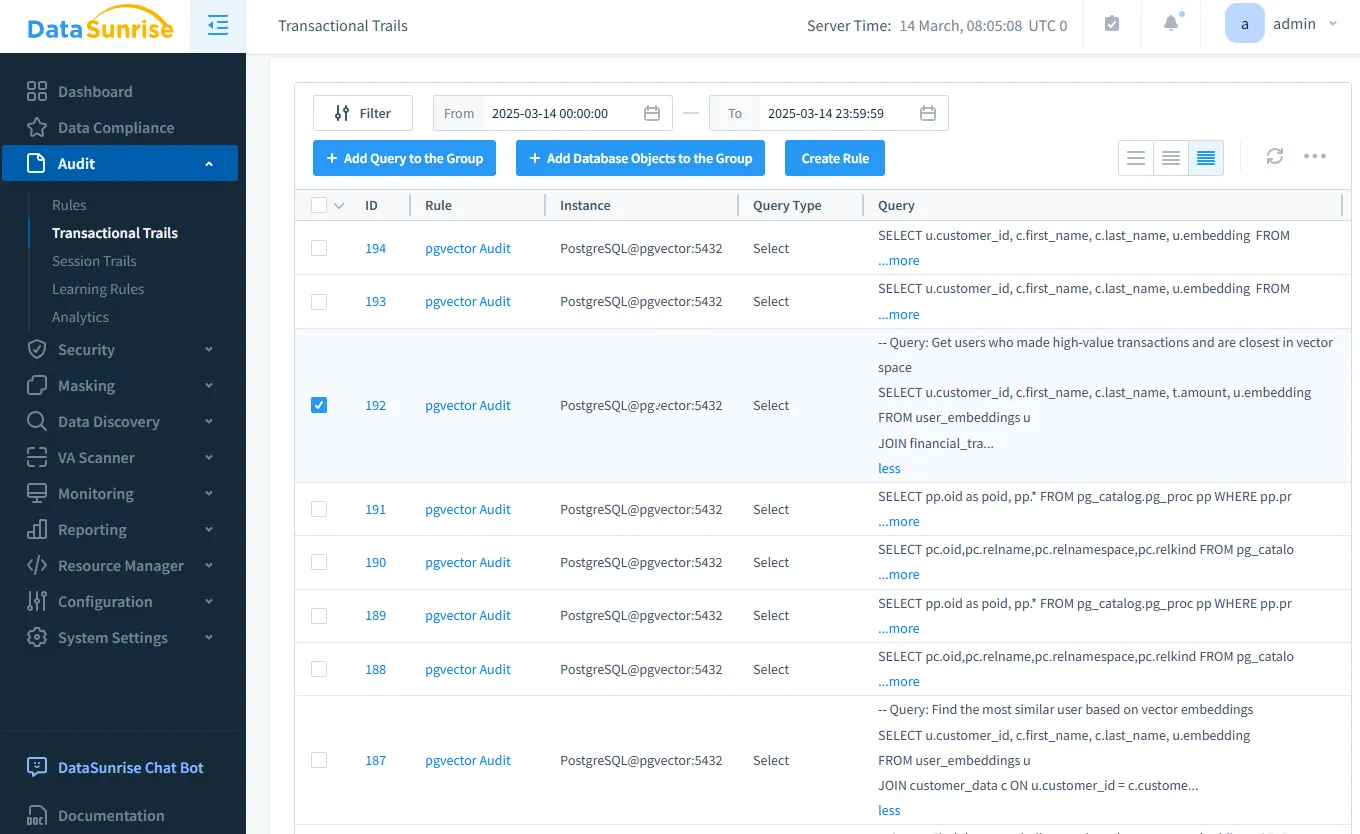

- Audit in tempo reale per rilevare ricerche di similarità dei vettori non autorizzate.

Esempio: Se un aggressore tenta di interrogare gli embeddings per dati che potrebbero contenere PII, DataSunrise traccia e monitora tali tentativi e maschera le informazioni sensibili prima che vengano esposte.

La tabella sottostante illustra l’approccio completo di DataSunrise per proteggere gli embeddings dei vettori, affrontando sia la prevenzione che la rilevazione della fuoriuscita di dati sensibili:

| Caratteristica | Protezione Proattiva | Protezione Reattiva |

|---|---|---|

| Data Discovery | Identifica i dati sensibili prima dell’embedding | Analizza le sorgenti degli embeddings per rilevare una potenziale esposizione di PII |

| Data Audit | Registra la generazione degli embeddings | Rileva interrogazioni sospette |

| Data Security | Previene la presenza di PII negli embeddings | Blocca ricerche di vettori non autorizzate |

| Data Masking | Nasconde i dati sensibili prima dell’embedding | Maschera le informazioni sensibili durante il recupero |

Conclusione: Un Approccio a Doppio Livello per la Sicurezza

I vector embeddings in pgvector sono potenti, ma possono esporre dati sensibili se non gestiti correttamente. L’approccio migliore è combinare tecniche di sicurezza proattive e reattive per minimizzare i rischi.

🔹 Prima che vengano creati gli embeddings – Sanitizzare, mascherare e controllare l’accesso ai dati.

🔹 Dopo la creazione degli embeddings – Audit, monitorare e mascherare il PII nelle risposte GenAI.

Per proteggere gli embeddings in PostgreSQL con pgvector, le organizzazioni dovrebbero:

- ✅ Utilizzare misure proattive per impedire che il PII venga incorporato negli embeddings.

- ✅ Implementare la sicurezza reattiva per monitorare e mascherare le informazioni recuperate.

- 🛡️ Sfruttare DataSunrise per rilevare, proteggere e prevenire l’esposizione di dati sensibili in ogni fase.

DataSunrise abilita entrambe le strategie, assicurando che le applicazioni basate su AI rimangano sicure e conformi. Che si stia creando un nuovo sistema AI o proteggendo uno esistente, DataSunrise fornisce protezione end-to-end per i dati vettorializzati sensibili.

Integrando le Funzionalità di Sicurezza di DataSunrise, le aziende possono utilizzare i loro dati per vector embeddings senza rischiare violazioni della privacy dei dati.

Ha bisogno di proteggere i dati dei Suoi vector embeddings? Prenoti oggi una Demo di DataSunrise per salvaguardare le Sue applicazioni GenAI!